Ti è mai capitato di trovarti davanti a una pagina web piena di dati interessanti e pensare: “Se solo potessi trasferire tutto su un foglio Excel senza impazzire a copiare e incollare”? Tranquillo, non sei l’unico. Nel 2025, l’estrazione dati dal web è diventata una vera e propria marcia in più per chi lavora con i dati. Dai team commerciali che vogliono creare liste di potenziali clienti, ai responsabili e-commerce che tengono d’occhio i prezzi dei concorrenti, tutti hanno bisogno di dati dal web, e li vogliono subito. La bella notizia? Con Python, l’estrazione dati dal web è alla portata di tutti—anche se l’ultima volta che hai programmato era per personalizzare il tuo profilo MySpace.

In questa guida ti porto passo dopo passo nel mondo dell’estrazione dati dal web con Python. Partiremo dalle basi, vedremo come affrontare sia siti statici che dinamici, e ti mostrerò come puoi dare una marcia in più al tuo workflow combinando Python con , il nostro Estrattore Web AI. Che tu sia alle prime armi o voglia solo affinare le tue skill, qui troverai consigli pratici, esempi di codice reali e qualche dritta imparata sul campo dopo anni nel SaaS e nell’automazione.

Cos’è il Web Scraping e Perché Usare Python?

Partiamo dalle basi. Web scraping vuol dire automatizzare l’estrazione di informazioni dai siti web. In pratica, insegni al tuo computer a “leggere” una pagina e a prendere solo quello che ti serve—che siano prezzi, titoli di notizie o contatti—senza doverlo fare a mano (). Le aziende usano il web scraping per tutto: monitorare i concorrenti in tempo reale, fare ricerche di mercato, generare lead o addestrare modelli AI ().

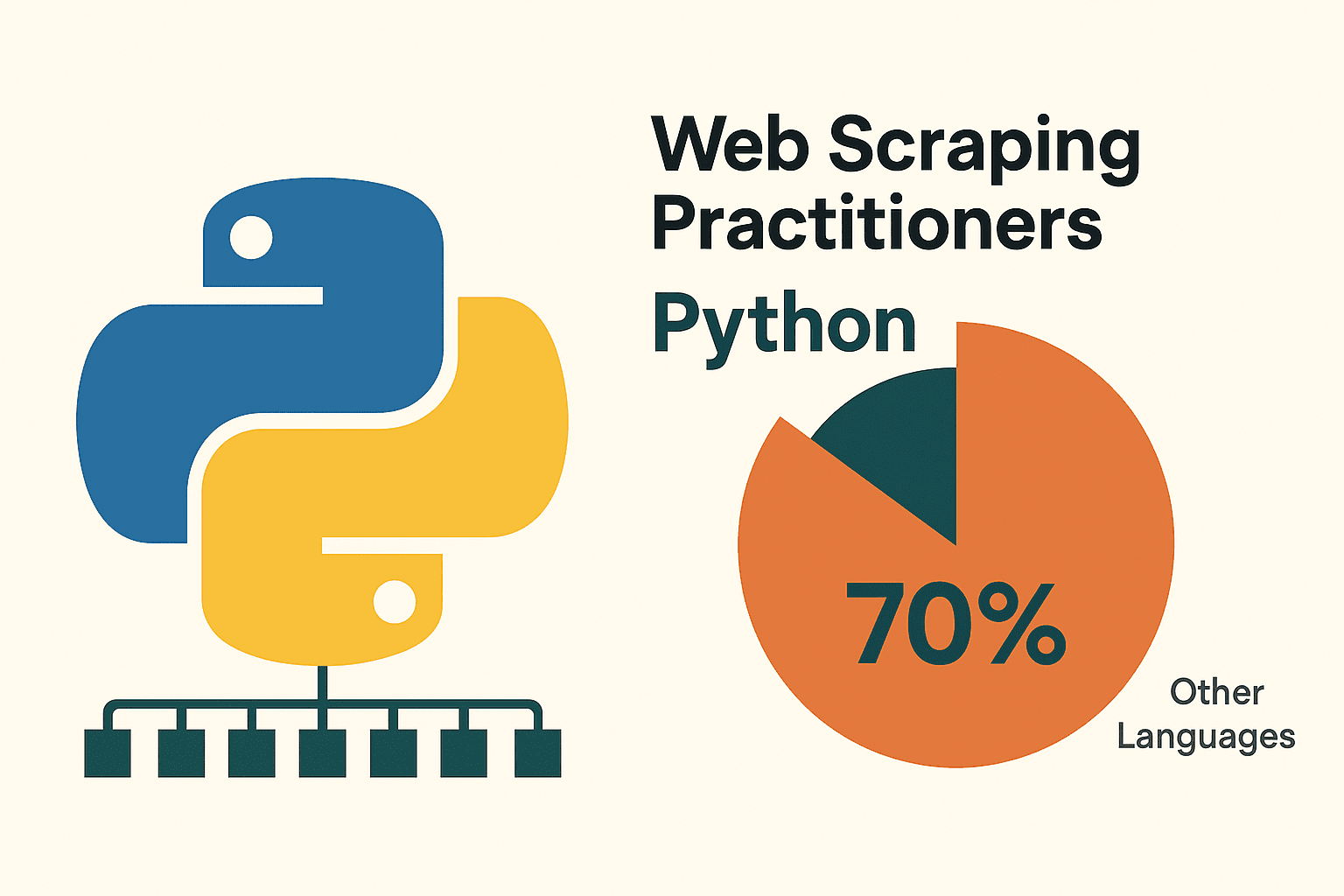

Ma perché proprio Python? Semplice: è facile da imparare—la sintassi sembra quasi inglese, perfetta se sei alle prime armi. Ma il vero punto di forza è l’ecosistema: librerie come requests, BeautifulSoup, Scrapy, Selenium e pandas ti permettono di fare tutto, dal recupero delle pagine web all’analisi dell’HTML e all’esportazione dei dati puliti. Non a caso, circa il , lasciando indietro gli altri linguaggi.

Perché Scegliere Python per il Web Scraping?

Negli anni ho provato diversi linguaggi, ma Python resta il top per l’estrazione dati dal web—soprattutto se sei all’inizio. Ecco perché:

- Semplice e leggibile: La sintassi di Python è pulita, quindi scrivere e correggere gli script è molto più facile ().

- Librerie a volontà: Requests (per le richieste HTTP), BeautifulSoup (per analizzare l’HTML), Scrapy (per scraping su larga scala), Selenium (per automatizzare il browser) e pandas (per l’analisi dei dati) coprono ogni fase ().

- Community enorme: Se hai un problema, qualcuno l’ha già risolto e ha condiviso la soluzione online.

Come si confronta Python con le altre opzioni? Ecco una panoramica:

| Approccio | Vantaggi | Svantaggi |

|---|---|---|

| Python | Facile da imparare, vasto ecosistema di librerie, ottimo per l’analisi dati, versatile | Richiede un po’ di codice, servono strumenti extra per siti molto dinamici in JavaScript |

| JavaScript/Node | Gestisce nativamente i contenuti dinamici, asincrono, stesso linguaggio del front-end | Curva di apprendimento più ripida, meno librerie specifiche per scraping, più verboso per i principianti |

| R (rvest) | Utile per estrazioni rapide in ambito ricerca, integrato con l’analisi dati di R | Ecosistema scraping più piccolo, meno adatto a siti dinamici |

| Strumenti No-Code | Nessuna programmazione, configurazione rapida, AI/aiuti visuali (come Thunderbit) | Flessibilità limitata per logiche personalizzate, limiti d’uso, meno controllo |

(, )

Per la maggior parte di chi lavora con i dati o per chi vuole imparare, Python è la scelta giusta: potente, flessibile e non spaventa.

Come Preparare l’Ambiente Python per l’Estrazione Dati

Prima di partire, serve preparare l’ambiente Python. Niente panico—è più facile che montare un mobile IKEA, e senza viti avanzate.

1. Installa Python:

Scarica l’ultima versione di Python 3 da . Su Windows, spunta “Add Python to PATH” durante l’installazione. Su Mac puoi usare Homebrew (brew install python3). Su Linux probabilmente ce l’hai già, ma apt install python3 python3-pip va benissimo ().

2. (Consigliato) Crea un ambiente virtuale:

Così le librerie del progetto restano separate. Nella cartella del progetto:

1python -m venv venv

2# Attiva l’ambiente:

3# Windows:

4venv\Scripts\activate

5# Mac/Linux:

6source venv/bin/activate3. Installa le librerie essenziali:

Apri il terminale e digita:

1pip install requests beautifulsoup4 pandas selenium lxmlrequests: Per le richieste HTTPbeautifulsoup4: Per analizzare l’HTMLpandas: Per manipolare/esportare i datiselenium: Per siti dinamici (opzionale)lxml: Analisi HTML/XML veloce

4. Scegli un editor di codice:

- (con estensione Python): leggero, popolare, perfetto per iniziare.

- : completo, specifico per Python.

- : interattivo, ottimo per sperimentare e analizzare dati ().

5. (Per Selenium) Installa un WebDriver:

Selenium ha bisogno di un driver per il browser (es. ChromeDriver). Il modo più semplice è usare webdriver_manager:

1pip install webdriver-managerPoi nel tuo script:

1from selenium import webdriver

2from selenium.webdriver.chrome.service import Service

3from webdriver_manager.chrome import ChromeDriverManager

4driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))Consiglio: se pip non viene riconosciuto, assicurati che Python sia nel PATH e che l’ambiente virtuale sia attivo.

Estrazione Dati da Siti Statici con Python: Guida Passo Passo

I siti statici sono il punto di partenza perfetto. Se vedi i dati nel “Visualizza sorgente” del browser, puoi recuperarli con Python.

Facciamo un esempio pratico con , un sito ideale per fare pratica.

Passo 1: Recupera la pagina

1import requests

2url = "http://quotes.toscrape.com/page/1/"

3response = requests.get(url)

4html = response.text

5print(response.status_code) # 200 significa OKPasso 2: Analizza l’HTML

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, 'html.parser')

3quotes = soup.find_all("div", class_="quote")Passo 3: Estrai i dati

1for q in quotes:

2 text = q.find("span", class_="text").get_text()

3 author = q.find("small", class_="author").get_text()

4 print(f"{text} --- {author}")Passo 4: Gestisci la paginazione

1import pandas as pd

2all_data = []

3page = 1

4while True:

5 url = f"http://quotes.toscrape.com/page/{page}/"

6 resp = requests.get(url)

7 if resp.status_code != 200:

8 break

9 soup = BeautifulSoup(resp.text, 'html.parser')

10 quotes = soup.find_all("div", class_="quote")

11 if not quotes:

12 break

13 for q in quotes:

14 text = q.find("span", class_="text").get_text()

15 author = q.find("small", class_="author").get_text()

16 all_data.append({"quote": text, "author": author})

17 page += 1

18df = pd.DataFrame(all_data)

19df.to_csv("quotes.csv", index=False)E così, con poche righe di codice, hai estratto dati da più pagine e li hai salvati in un CSV. Niente male, vero? ()

Consiglio: Dai sempre un’occhiata al file robots.txt e ai termini d’uso del sito prima di estrarre dati. E non esagerare—non inviare troppe richieste in poco tempo. Una breve time.sleep(1) tra le richieste è sempre una buona abitudine.

Estrazione Dati da Siti Dinamici: Usare Selenium con Python

Alcuni siti sono più “furbi”. Se i dati compaiono solo dopo che la pagina ha eseguito JavaScript (scroll infinito, pop-up, dashboard dinamiche), serve uno strumento che simuli un vero browser. Qui entra in gioco Selenium.

Passo 1: Avvia il browser

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

6driver.get("https://example.com/dynamic-products")Passo 2: Attendi il caricamento dei contenuti

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.ID, "product-list"))

5)Passo 3: Scrolla o clicca per caricare altri dati

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightPasso 4: Estrai i dati

1products = driver.find_elements(By.CLASS_NAME, "product-item")

2data = []

3for prod in products:

4 name = prod.find_element(By.CSS_SELECTOR, "h2.product-name").text

5 price = prod.find_element(By.CSS_SELECTOR, "span.price").text

6 data.append({"name": name, "price": price})Passo 5: Salva e chiudi

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4driver.quit()Tips:

- Usa i “wait” espliciti (

WebDriverWait) per evitare errori se gli elementi non sono ancora caricati (). - Per la modalità headless (senza interfaccia grafica), aggiungi

options.headless = Truealle opzioni di Chrome. - Se trovi un endpoint API JSON nel traffico di rete del sito, puoi spesso evitare Selenium e usare

requests—molto più veloce!

Unire Thunderbit e Python per Flussi di Lavoro Potenti

Ed è qui che le cose si fanno davvero interessanti. A volte, anche con tutte le librerie Python, estrarre dati da siti complessi può sembrare una battaglia. Qui entra in gioco .

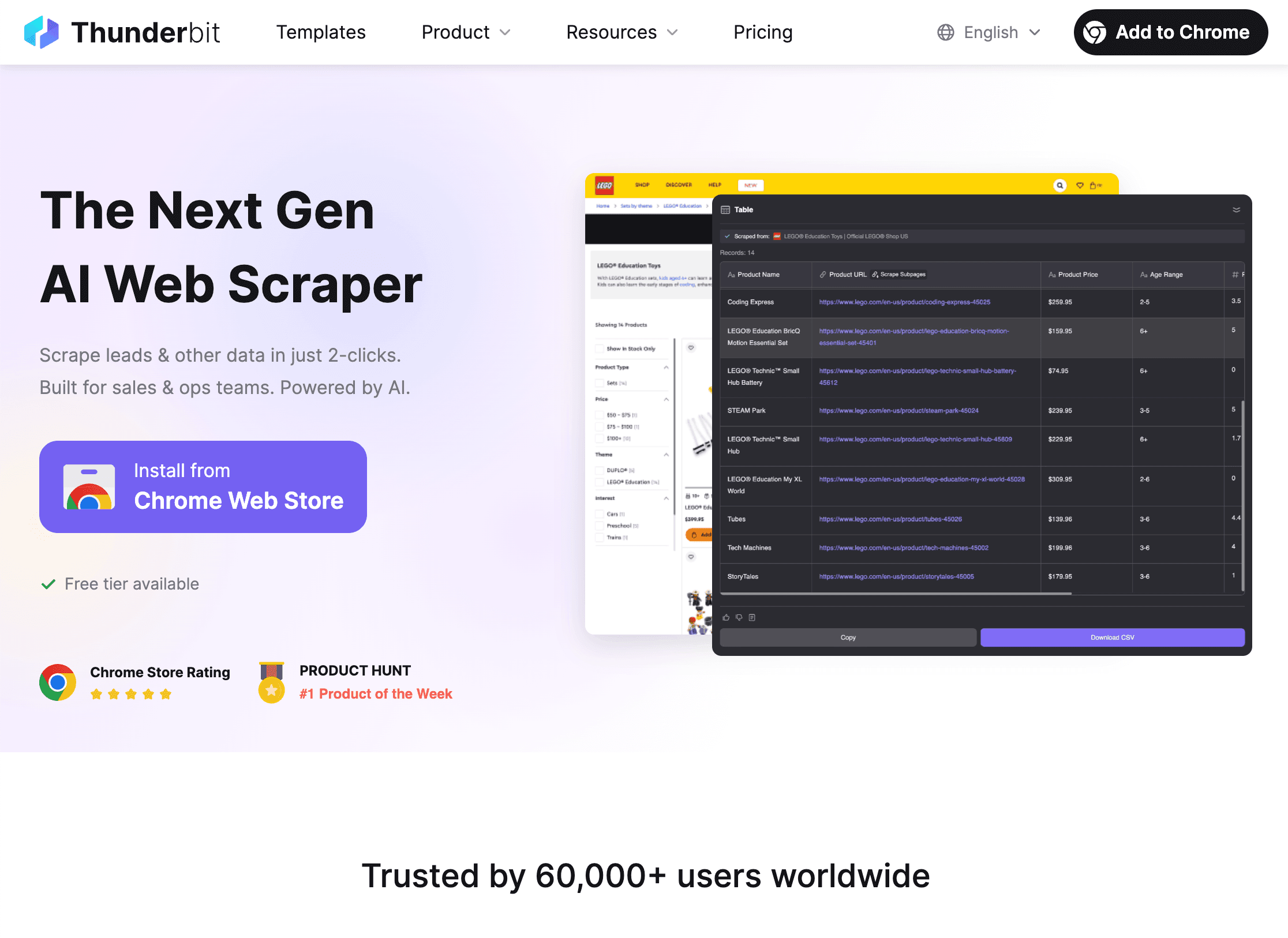

Thunderbit è un Estrattore Web AI per Chrome che ti permette di selezionare e scaricare dati da qualsiasi sito—senza scrivere una riga di codice. È perfetto per chi ha bisogno di dati subito, ma si integra anche con Python per flussi di lavoro avanzati.

Come Thunderbit + Python ti semplificano la vita:

Come Thunderbit + Python ti semplificano la vita:

-

Usa Thunderbit per estrarre i dati:

- Apri l’.

- Clicca su “AI Suggerisci Campi” e lascia che l’AI di Thunderbit ti proponga cosa estrarre.

- Gestisci paginazione, sottopagine, immagini o PDF con un click.

- Esporta i dati direttamente in CSV, Excel, Google Sheets, Notion o Airtable.

-

Analizza e pulisci i dati in Python:

- Carica il file esportato in Python con pandas:

1import pandas as pd 2df = pd.read_csv("thunderbit_output.csv") - Ora puoi filtrare, pulire, unire, visualizzare o fare analisi avanzate—come preferisci.

- Carica il file esportato in Python con pandas:

-

Automatizza il processo:

- Thunderbit supporta l’estrazione programmata, così puoi ricevere dati aggiornati ogni giorno.

- Combina con script Python per report automatici, alert o ulteriori elaborazioni.

Perché usarli insieme? Thunderbit ti fa risparmiare ore di codice e debug, soprattutto su siti complessi o per progetti una tantum. Python ti dà la potenza per analizzare, pulire e integrare quei dati nei tuoi processi aziendali. È come pane e Nutella: buoni da soli, ma insieme sono imbattibili ().

Come Affrontare le Difficoltà Più Comuni nello Scraping con Python

L’estrazione dati dal web non è sempre una passeggiata. Ecco i problemi più frequenti—e come risolverli:

1. Blocchi (errori 403/429, CAPTCHA):

- Cambia lo User-Agent per sembrare un browser vero.

- Usa proxy per ruotare gli indirizzi IP ().

- Inserisci pause tra le richieste (

time.sleep()). - Rispetta robots.txt e le regole di crawl-delay.

- Per i CAPTCHA, valuta Selenium per la risoluzione manuale o servizi dedicati.

2. Contenuti dinamici che non si caricano:

- Usa Selenium per pagine pesanti in JavaScript.

- Cerca chiamate API interne nel pannello di rete del browser—spesso puoi recuperare i dati direttamente in JSON.

3. Problemi di login o sessione:

- Usa

requests.Session()per mantenere i cookie. - Automatizza il login con Selenium se serve.

4. Cambiamenti nella struttura del sito:

- Scrivi selettori robusti (meglio ID che classi).

- Monitora i cambiamenti e aggiorna lo script quando serve.

- L’AI di Thunderbit si adatta automaticamente ai cambi di layout, risparmiandoti manutenzione.

5. Grandi volumi di dati:

- Usa la concorrenza (

concurrent.futuresoasyncio) per velocizzare lo scraping. - Scrivi i dati su disco o su database man mano per evitare problemi di memoria.

(, )

Risoluzione dei Problemi: Debug e Ottimizzazione degli Script di Scraping

Quando qualcosa non va (e succederà), ecco una checklist rapida:

- HTTP 404/403/429: Controlla URL, header e frequenza delle richieste.

- Timeout/Errori di connessione: Implementa retry con backoff esponenziale.

- AttributeError/NoneType: Verifica sempre prima di accedere agli elementi; controlla l’HTML effettivamente ricevuto.

- Problemi di codifica: Imposta

response.encoding = 'utf-8'o specifica la codifica quando salvi i file. - Elemento Selenium non trovato: Usa i wait espliciti; ricontrolla i selettori.

- Errori di memoria: Scrivi i dati a blocchi, usa generatori o passa a un database per dataset molto grandi.

- Debug: Usa print, logging o salva l’HTML su file per ispezionarlo.

Per le performance, valuta richieste asincrone (aiohttp), threading o framework come Scrapy per progetti grandi. Ma non complicarti la vita per lavori piccoli—meglio la chiarezza che l’ottimizzazione estrema quando impari.

Buone Pratiche per uno Scraping Etico e Legale

Con grandi poteri di scraping arrivano grandi responsabilità. Ecco come restare dalla parte giusta della legge (e della coscienza):

- Rispetta robots.txt e i Termini di Servizio: Se un sito vieta lo scraping, non farlo.

- Evita dati personali o sensibili: Concentrati su informazioni pubbliche; non raccogliere dati che non vorresti fossero raccolti su di te.

- Sii educato: Limita la frequenza delle richieste, evita le ore di punta e non sovraccaricare i server.

- Identificati: Usa uno User-Agent personalizzato con un contatto se opportuno.

- Verifica la normativa: Negli USA, estrarre dati pubblici è generalmente legale, ma violare i ToS o raccogliere dati privati può essere rischioso ().

- Usa le API quando disponibili: Se un sito offre un’API, preferiscila—è più sicura e stabile.

(, )

Conclusioni & Punti Chiave

Estrarre dati dal web con Python è una delle skill più utili nell’era dei dati. Ecco il succo:

- Python è la scelta numero uno per il web scraping grazie a semplicità, librerie e community ().

- Inizia dai siti statici con requests e BeautifulSoup; passa a Selenium per contenuti dinamici.

- Thunderbit ti fa risparmiare ore su siti complessi o lavori una tantum—poi puoi usare Python per analisi e automazione.

- Affronta le difficoltà ruotando header, proxy, inserendo pause e gestendo bene gli errori.

- Fai scraping in modo etico: Rispetta i siti, evita dati sensibili e resta nella legalità.

Il mio consiglio? Parti in piccolo—scegli un sito semplice, scrivi il tuo primo script e scopri cosa riesci a estrarre. Quando ti sentirai più sicuro, prova a combinare Thunderbit e Python per workflow ancora più potenti. E ricorda: ogni errore è solo un enigma da risolvere (magari con una mano da Stack Overflow).

Vuoi vedere Thunderbit in azione o saperne di più sullo scraping? Dai un’occhiata al o iscriviti al nostro per tutorial e consigli.

Buon scraping—che i tuoi dati siano sempre puliti, i tuoi script senza bug e il tuo IP mai bloccato.

Domande Frequenti

1. Cos’è il web scraping e la sua legalità?

Il web scraping è l’estrazione automatica di dati dai siti web. Estrarre dati pubblici è generalmente legale negli USA e in molti altri paesi, ma bisogna rispettare i termini del sito, evitare dati sensibili e seguire le leggi sulla privacy ().

2. Perché la maggior parte delle persone usa Python per il web scraping?

Python è facile da imparare, ha librerie potenti per ogni fase dello scraping (requests, BeautifulSoup, Selenium, pandas) e una community enorme per il supporto ().

3. Quando usare Selenium invece di requests/BeautifulSoup?

Usa Selenium quando i dati vengono caricati dinamicamente da JavaScript e non sono presenti nell’HTML iniziale della pagina. Selenium automatizza un vero browser, quindi “vede” ciò che vede l’utente.

4. Come funziona Thunderbit insieme a Python?

Thunderbit ti permette di estrarre dati complessi o non strutturati con l’AI in pochi click, poi esportarli in CSV/Excel/Sheets. Puoi quindi caricare quei dati in Python per pulizia, analisi o automazione—risparmiando ore di codice.

5. Quali sono i consigli principali per evitare blocchi durante lo scraping?

Cambia User-Agent, usa proxy, inserisci pause, rispetta robots.txt ed evita dati sensibili o privati. Per scraping intensivo, valuta strumenti o servizi anti-bot.

Vuoi provare tu stesso? Scarica l’ e scopri quanto è semplice unire AI e Python per il tuo prossimo progetto dati. E se incontri difficoltà, ricorda: ogni grande scraper ha iniziato con una sola riga di codice.

Scopri di più