Ricordo ancora la prima volta che ho provato a fare web scraping su un sito. Ero davanti al computer, tazzina di caffè accanto, deciso a liberarmi da quell’attività monotona di copiare e incollare prezzi di prodotti per ore. Ho aperto Python, installato BeautifulSoup e mi sono lanciato… solo per ritrovarmi perso tra tag HTML e una valanga di errori. Se ti sei mai cimentato con il web scraping python, sai bene di cosa parlo: entusiasmo alle stelle, confusione totale e, a volte, la voglia di lanciare il portatile dalla finestra.

La verità è che oggi i dati web sono una miniera d’oro. Le aziende vogliono informazioni fresche in tempo reale—che si tratti di monitorare i prezzi dei concorrenti, costruire liste di potenziali clienti o analizzare le tendenze di mercato. Python web scraping è stato per anni la scelta numero uno, ma con siti sempre più intricati e difese anti-scraping sempre più toste, il vecchio metodo a colpi di codice inizia a mostrare la corda. Ecco perché oggi ti porto a scoprire entrambi i mondi: la classica cassetta degli attrezzi Python e la nuova generazione di estrattore AI come che stanno rivoluzionando il lavoro di chi si occupa di sales, e-commerce e operations.

Cos’è il Web Scraping con Python?

Partiamo dalle basi: web scraping vuol dire raccogliere dati dai siti in modo automatico. Invece di copiare e incollare a mano, scrivi uno script che fa tutto per te. Python è la scelta preferita da chi inizia perché è facile da leggere, ha una community enorme e offre librerie che rendono lo scraping accessibile anche a chi non è uno sviluppatore di professione.

Perché Python?

- Facile da imparare: La sintassi di Python è famosa per essere chiara e immediata.

- Librerie potenti: Requests, BeautifulSoup, Selenium e Scrapy coprono tutto, dai siti statici a quelli pieni di JavaScript.

- Community enorme: Se ti blocchi, qualcuno ha già avuto il tuo stesso problema (e probabilmente l’ha risolto su Stack Overflow).

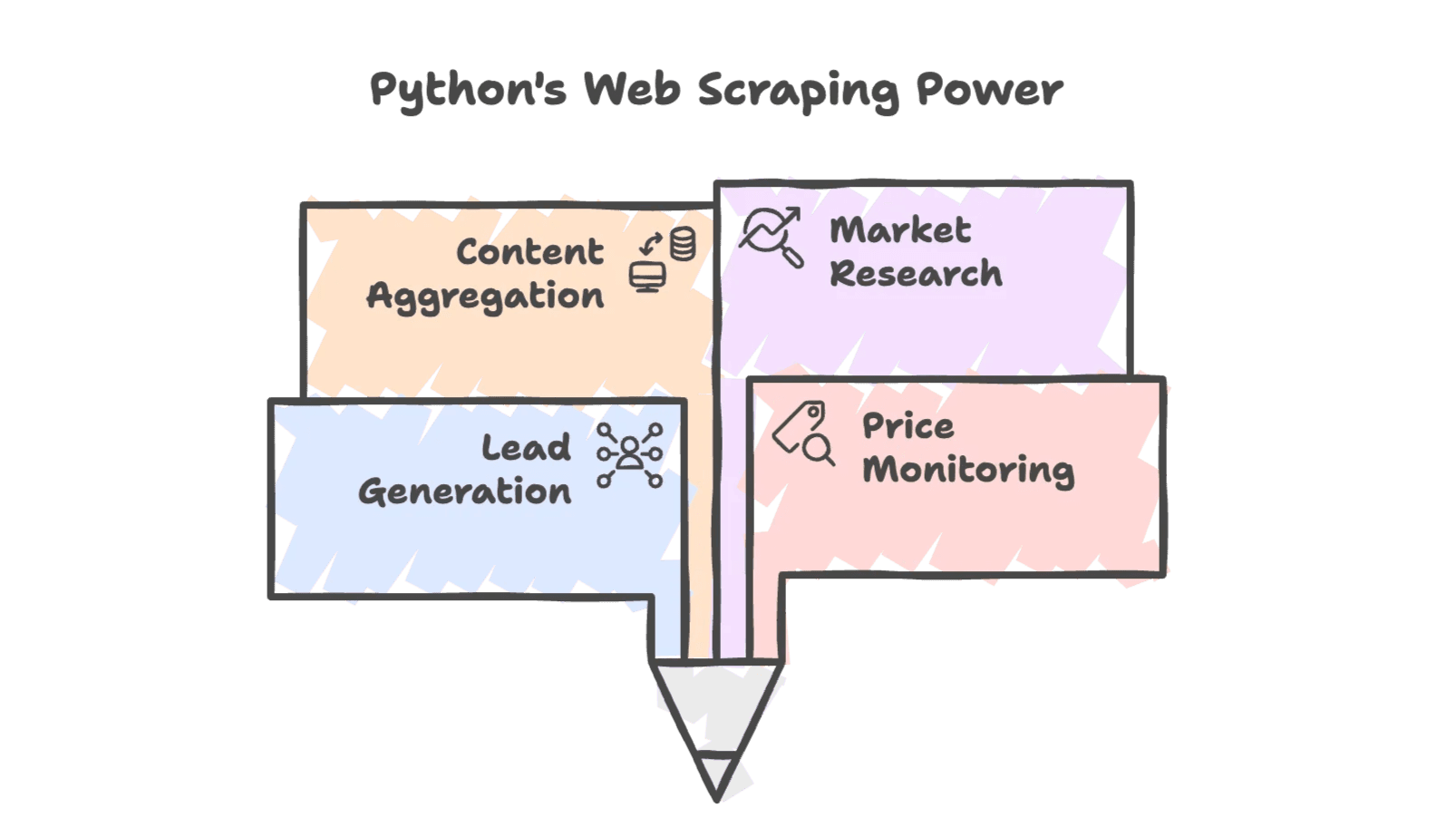

Casi d’Uso Tipici

Il python web scraping è ovunque nel business:

- Lead generation: Recuperare contatti da directory o social.

- Monitoraggio prezzi: Tenere d’occhio i prezzi dei concorrenti per strategie di pricing dinamico.

- Aggregazione contenuti: Raccogliere news, recensioni o cataloghi prodotti.

- Ricerche di mercato: Analizzare trend da forum, social o risultati di ricerca.

E non è solo roba da smanettoni—team sales, e-commerce e persino agenzie immobiliari usano dati estratti per restare competitivi. Oggi, utilizza il web scraping per creare dataset personalizzati per analisi e lead scoring.

Perché le Aziende Scelgono Python per il Web Scraping?

La flessibilità di Python e le sue librerie lo rendono perfetto per l’estrazione dati. Ecco qualche esempio concreto:

| Scenario | Come Aiuta il Web Scraping con Python | Vantaggio (ROI) |

|---|---|---|

| Lead Generation | Estrae nomi, email, numeri da directory | Crea una lista di 500 contatti in una notte, contro 50 manualmente |

| Monitoraggio Prezzi | Recupera regolarmente i prezzi dei concorrenti | Abilita pricing dinamico—un retailer ha aumentato le vendite del 4% grazie ai dati estratti |

| Monitoraggio Inventario | Controlla la disponibilità dei prodotti dei concorrenti | Intercetta clienti quando i rivali sono out-of-stock, risparmiando ore di controlli manuali |

| Analisi Competitor | Analizza dettagli prodotto e recensioni | Studia oltre 1.000 recensioni dei concorrenti per marketing e sviluppo prodotto |

| Ricerche di Mercato | Aggrega dati da forum, social, ricerche | Guida le campagne con trend aggiornati, allineando la strategia agli interessi reali |

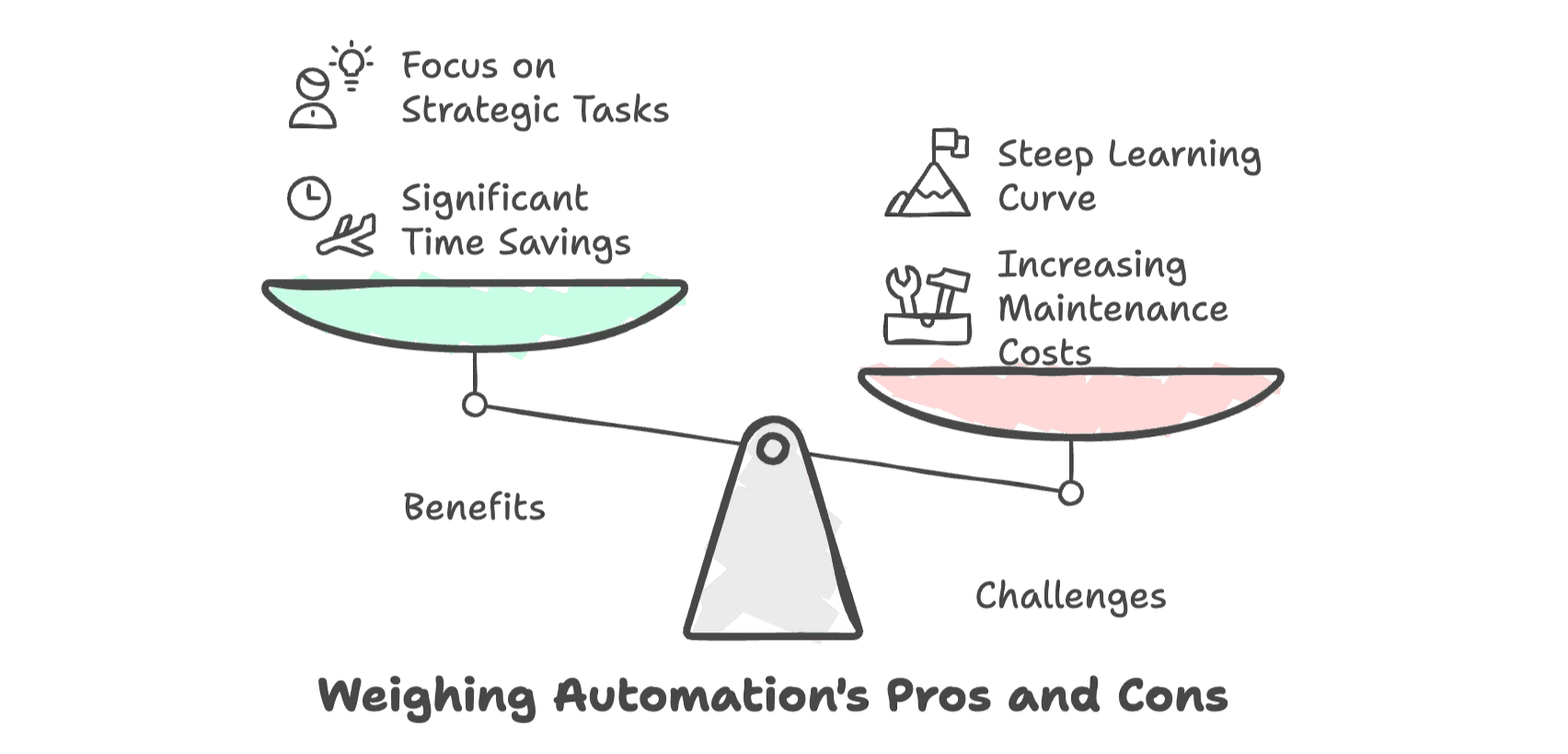

Il ritorno sull’investimento è chiaro: automatizzare la raccolta dati con Python può portare a un risparmio di tempo dell’80% rispetto ai metodi manuali (). Così il tuo team può concentrarsi su analisi e chiusura contratti, invece che su lavori ripetitivi.

Ma—e qui viene il bello—con siti sempre più complessi, il costo (in tempo, fatica e manutenzione) per tenere in piedi questi script continua a salire. Per chi non è tecnico, la curva di apprendimento può essere tosta e la frustrazione dietro l’angolo.

Strumenti Essenziali per il Web Scraping con Python

Se sei alle prime armi, l’ecosistema Python offre alcuni strumenti chiave. Ecco una panoramica:

| Strumento | Ideale per | Gestisce JavaScript? | Difficoltà | Velocità & Scala |

|---|---|---|---|---|

| Requests + BeautifulSoup | Siti semplici e statici | No | Bassa | Veloce per poche pagine |

| Selenium | Siti dinamici, interazione JS | Sì | Media | Più lento per pagina |

| Scrapy | Crawling su larga scala | Parziale (con plugin) | Alta | Alte prestazioni, scalabile |

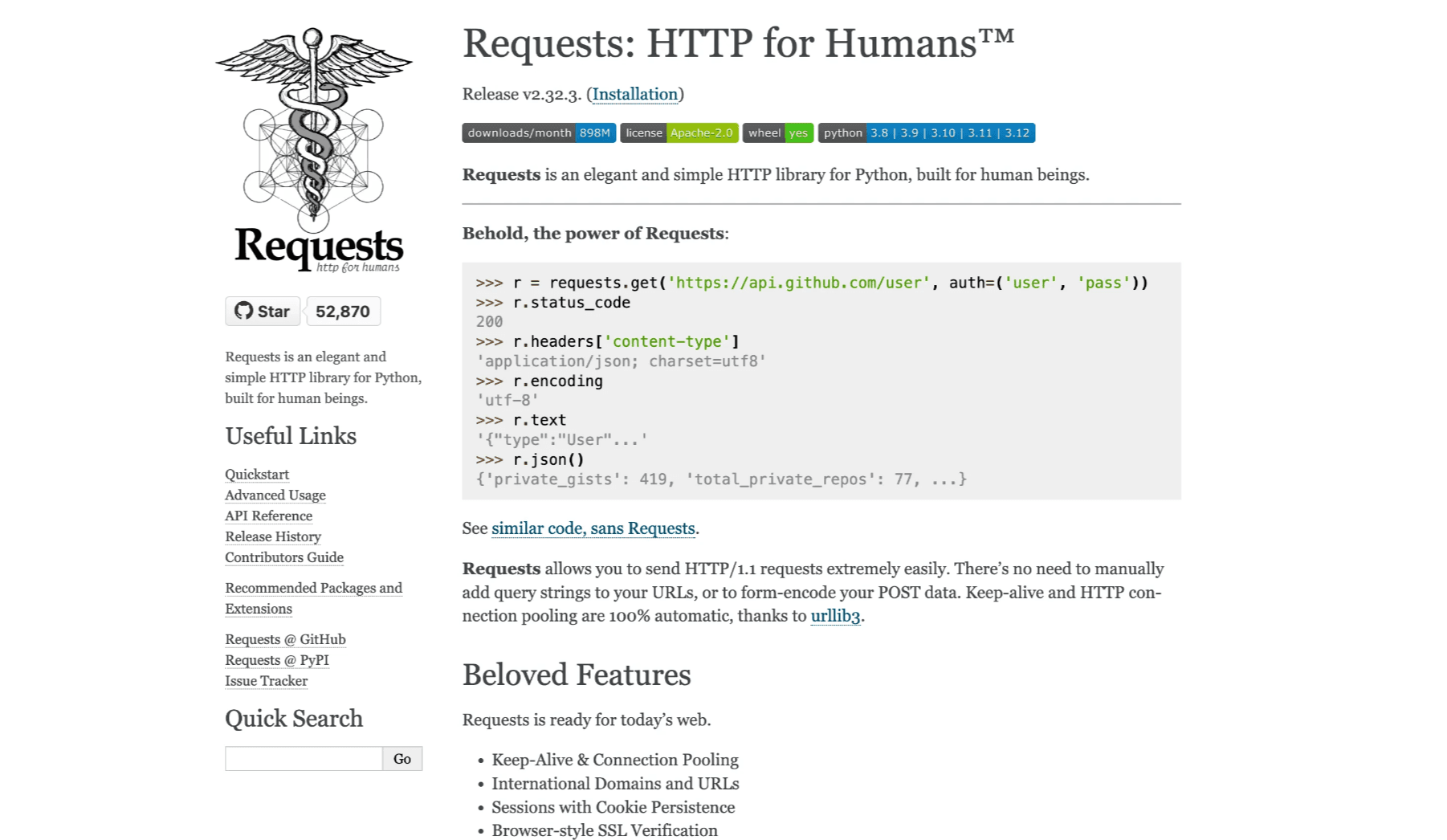

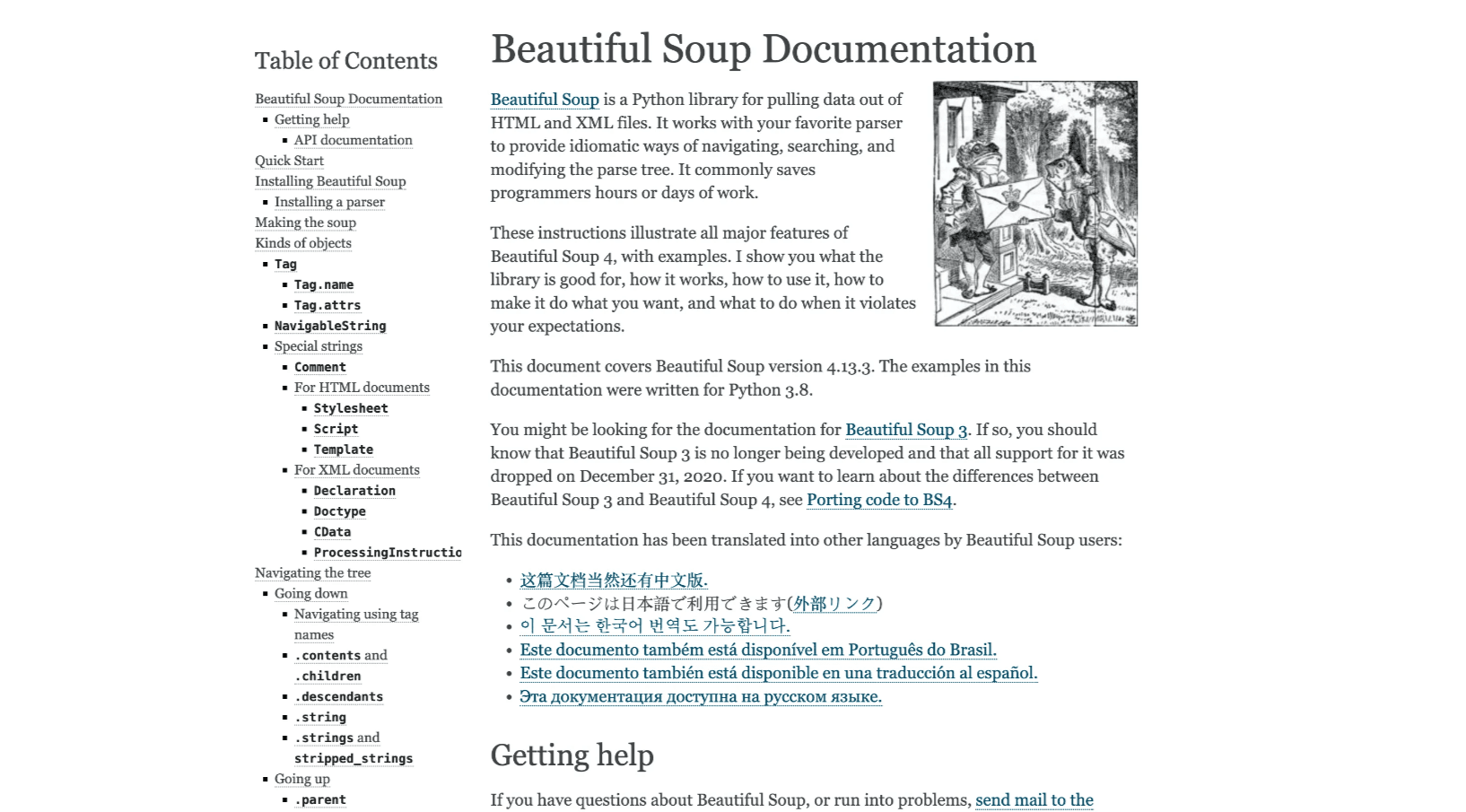

Requests + BeautifulSoup

La combo classica per siti statici. Requests recupera l’HTML, BeautifulSoup lo analizza per estrarre i dati. È leggero, facile da usare e perfetto per progetti piccoli (, ).

Selenium

Quando i dati compaiono solo dopo il caricamento JavaScript, Selenium è la soluzione. Automatizza un vero browser, quindi può gestire login, click e scrolling (). Il rovescio della medaglia? È più lento e richiede un po’ di pazienza per la configurazione.

Scrapy

Per progetti grandi—come crawling di migliaia di pagine o pipeline ricorrenti—Scrapy è il top. È un framework completo per creare spider robusti, gestire la concorrenza e organizzare il codice (). La curva di apprendimento è più ripida, ma ripaga per lavori su larga scala.

Step-by-Step: Il Tuo Primo Estrattore Web con Python

Passiamo alla pratica con un esempio concreto. Andremo a estrarre titoli e prezzi dei libri da —un sito demo perfetto per fare esercizio con lo scraping.

Configurare l’Ambiente Python

Prima di tutto, assicurati di avere Python installato. Poi, apri il terminale e digita:

1pip install requests beautifulsoup4Consiglio di usare un editor di codice come VS Code o PyCharm. Fidati, la colorazione della sintassi ti salverà la vita.

Scrivere il Primo Script di Web Scraping

Ecco uno script base per recuperare la homepage e analizzare i dati dei libri:

1import requests

2from bs4 import BeautifulSoup

3url = "http://books.toscrape.com/"

4response = requests.get(url)

5html_content = response.text

6soup = BeautifulSoup(html_content, 'html.parser')

7book_elements = soup.find_all('article', class_='product_pod')

8books_data = []

9for book in book_elements:

10 title = book.find('h3').find('a')['title']

11 price = book.find('p', class_='price_color').text

12 books_data.append([title, price])

13print(books_data)Cosa succede qui?

- Recuperiamo l’HTML con Requests.

- Lo analizziamo con BeautifulSoup.

- Troviamo tutte le schede libro.

- Estraiamo titolo e prezzo per ogni libro.

Esportare i Dati Estratti

Per rendere i dati davvero utili, salviamoli in un file CSV:

1import csv

2with open('books.csv', 'w', newline='', encoding='utf-8') as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "Price"])

5 writer.writerows(books_data)Ora puoi aprire books.csv in Excel o Google Sheets e vedere il risultato.

Consigli Utili:

- Controlla sempre l’output per errori o dati mancanti.

- Se vedi caratteri strani, assicurati di usare la codifica UTF-8.

- Se lo script smette di funzionare, verifica se la struttura del sito è cambiata.

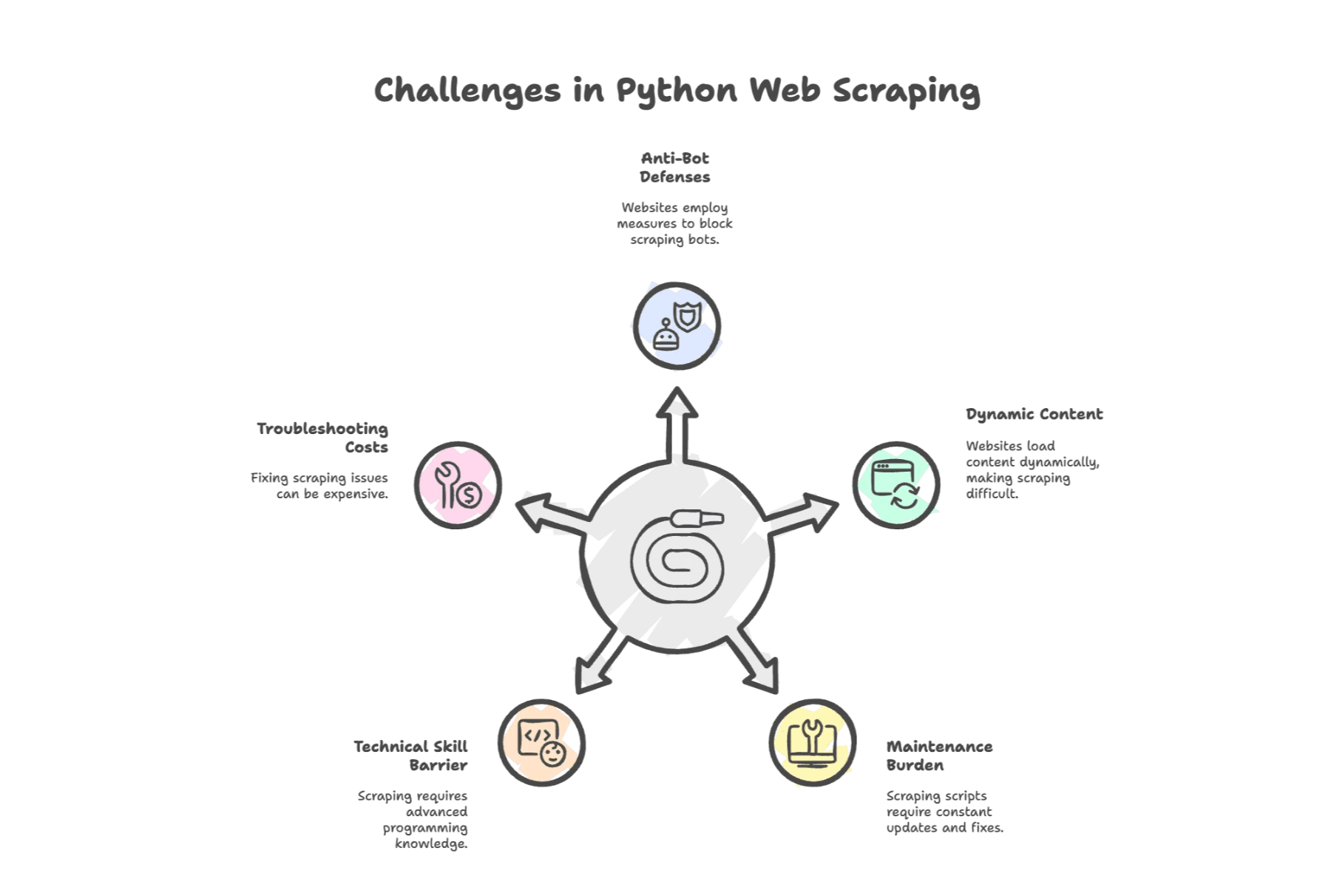

Le Sfide Più Comuni del Web Scraping con Python

Qui iniziano le vere difficoltà. Il web scraping python è potente, ma non sempre una passeggiata. Ecco i problemi più frequenti:

1. Difese Anti-Bot

I siti si difendono. In un recente sondaggio, ha indicato blocchi (ban IP, CAPTCHA) come ostacolo principale. I siti possono rilevare gli script e bloccare l’accesso—spesso con un CAPTCHA.

2. Contenuti Dinamici

I siti moderni usano tanto JavaScript. Se i dati che ti servono si caricano dopo la pagina, Requests + BeautifulSoup non bastano. Serve Selenium o bisogna decifrare un’API.

3. Manutenzione Continua

I siti cambiano spesso. Una piccola modifica all’HTML può rompere lo script. Un’analisi ha rilevato che gli sviluppatori spendono a sistemare estrattori rotti, e le aziende arrivano a spendere 15.000€ l’anno solo in manutenzione.

4. Barriera Tecnica

Anche se Python è semplice, serve conoscere HTML, selettori CSS e a volte i protocolli HTTP. Per chi non è sviluppatore, può sembrare di imparare una nuova lingua—a tutti gli effetti, lo è.

5. Costi di Debug

Quando qualcosa va storto (e succederà), potresti dover investire in proxy, browser headless o servizi esterni. Ogni ora passata a risolvere problemi è un’ora sottratta al tuo vero lavoro.

Strumenti di Web Scraping Automatico: Il Livello Successivo

Cosa può fare allora chi lavora in azienda (o chi in sales ops è sommerso di richieste)? Qui entrano in gioco gli strumenti di web scraping automatico—e, più di recente, gli estrattori AI.

Questi strumenti ti tolgono il peso: niente più codice per ogni sito, niente più debug notturni. Basta selezionare i dati e il gioco è fatto.

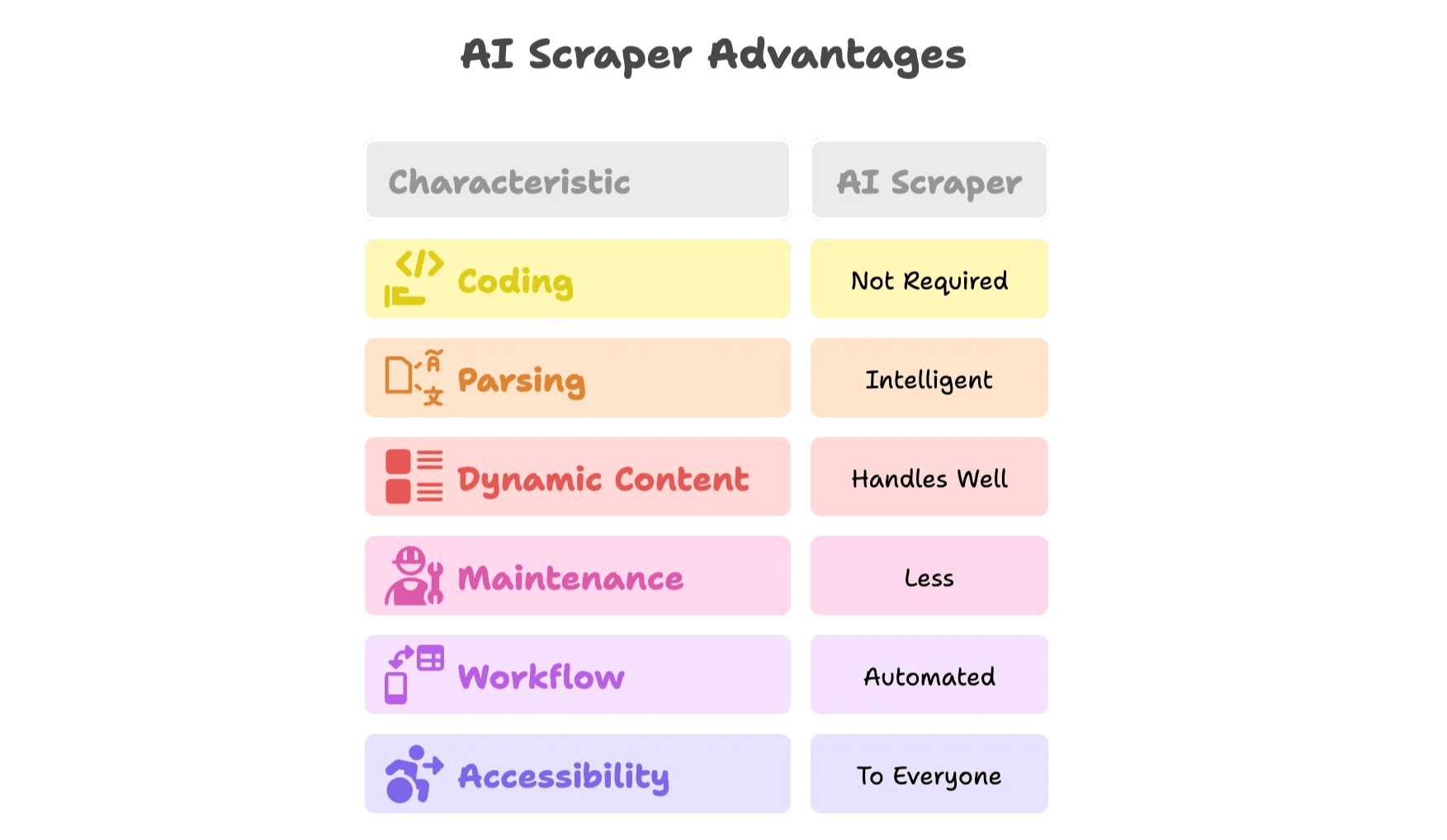

Cosa Cambia con un Estrattore AI?

Gli estrattori AI sono davvero un altro pianeta. Ecco perché:

- Zero codice: Interfacce visuali o estensioni browser ti permettono di selezionare i dati, e l’AI fa tutto il resto.

- Parsing intelligente: I modelli AI riconoscono automaticamente campi come nomi, prezzi, email—senza dover ispezionare l’HTML.

- Gestione contenuti dinamici: Gli estrattori AI lavorano in veri browser, quindi gestiscono JavaScript, scrolling e click.

- Meno manutenzione: Se il sito cambia, l’AI si adatta—o il team aggiorna i template per te.

- Automazione dei flussi di lavoro: Puoi programmare estrazioni, esportare direttamente su Google Sheets, Airtable, Notion o Excel.

- Accessibile a tutti: Niente più attese per il “tecnico Python” del team.

Vediamo come funziona nella pratica con .

Thunderbit: L’Alternativa Intelligente al Web Scraping con Python

Ho co-fondato Thunderbit perché ho visto quante energie i team sprecavano con lo scraping manuale. Il nostro obiettivo? Rendere i dati web accessibili a tutti—senza codice, senza stress, solo risultati.

Funzionalità Chiave dell’Estrattore Web AI di Thunderbit

- Estrattore Web AI in 2 click: Apri il sito, clicca “AI Suggerisci Campi” e lascia che l’AI di Thunderbit proponga le colonne migliori da estrarre. Premi “Estrai” e hai finito.

- Template preimpostati: Per siti popolari (Amazon, Zillow, LinkedIn, ecc.), usa template già pronti—nessuna configurazione.

- Estrazione da sottopagine e paginazione: Thunderbit può cliccare automaticamente su sottopagine (es. dettagli prodotto) e gestire paginazione o scroll infinito.

- Esportazione dati gratuita: Esporta i dati su Excel, Google Sheets, Airtable o Notion—senza limiti o costi nascosti.

- Estrattori Email & Telefono: Estrai subito i contatti da qualsiasi pagina, perfetto per sales e lead generation.

- Trasformazione dati con AI: Riassumi, categorizza, traduci o formatta i dati in tempo reale.

- Estrazioni programmate: Imposta scraping ricorrenti con scheduling in linguaggio naturale.

- Cloud & Browser: Scegli tra scraping cloud veloce o scraping da browser per siti che richiedono login.

- Supporto per 34 lingue: Thunderbit è pensato per team internazionali.

Vuoi vederlo in azione? Prova la nostra e visita il per tutorial e casi d’uso reali.

Quando Passare da Python a un Estrattore AI?

Ecco una checklist rapida per aiutarti a decidere:

| Situazione | Script Python | Estrattore AI (Thunderbit) |

|---|---|---|

| Estrazione semplice, una tantum | ✔️ | ✔️ |

| Contenuti dinamici (JS, login, scroll infinito) | ⚠️ | ✔️ |

| Cambi frequenti del sito, alta manutenzione | ⚠️ | ✔️ |

| Team non tecnico, bisogno di velocità | ⚠️ | ✔️ |

| Integrazione dati multi-piattaforma (Sheets, CRM) | ⚠️ | ✔️ |

| Scraping ricorrente e su larga scala | ⚠️ | ✔️ |

| Necessità di scheduling, arricchimento o automazione | ⚠️ | ✔️ |

Se nel tuo flusso di lavoro vedi tanti ⚠️, è il momento di provare un estrattore AI.

Bonus: Consigli per una Raccolta Dati Web Efficiente e Sostenibile

Che tu usi Python o uno strumento AI, alcune buone pratiche fanno la differenza:

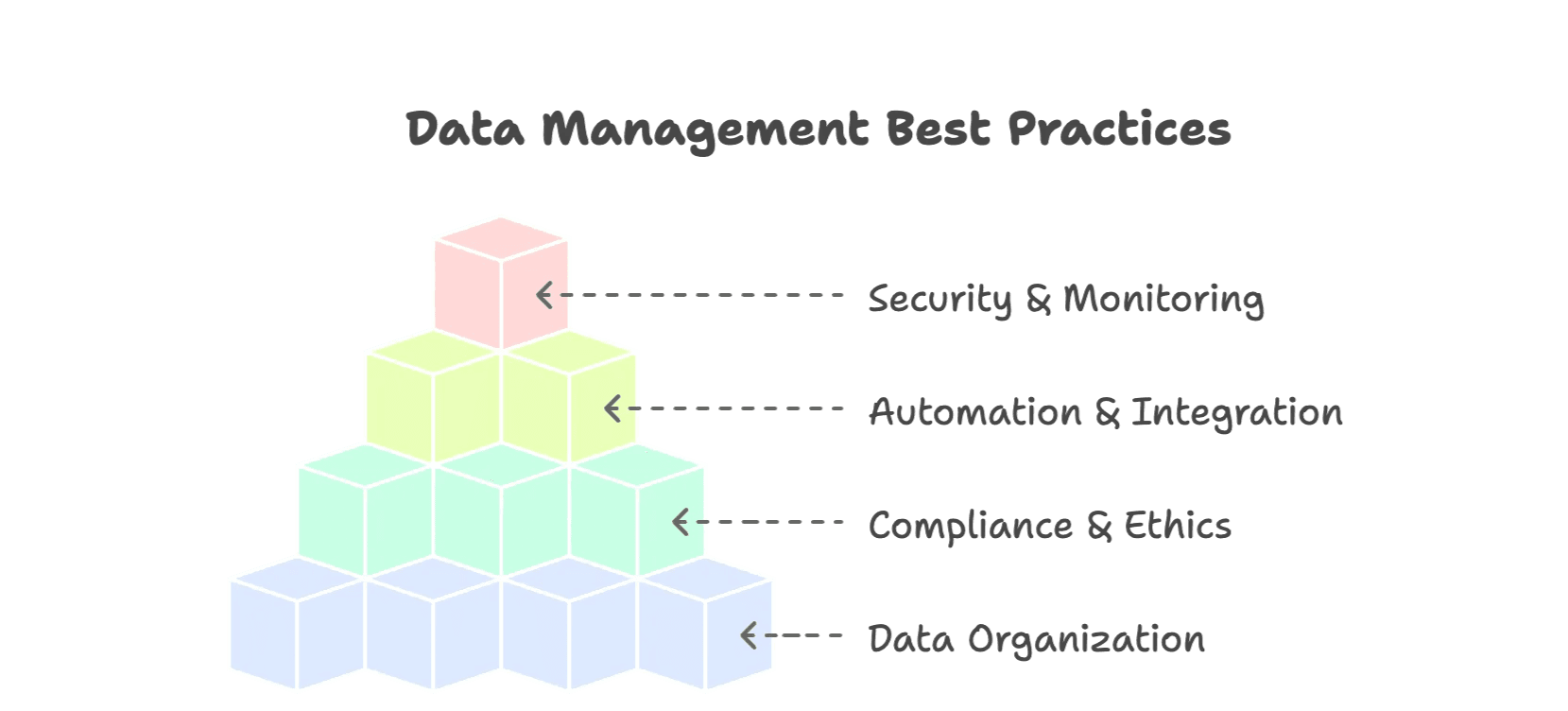

1. Organizza i Tuoi Dati

- Usa formati strutturati (CSV, Excel, database).

- Normalizza i campi (date, valute, categorie).

- Aggiungi metadati (fonte, data estrazione) per dare contesto.

- Elimina duplicati e valida i dati.

2. Rispetta le Regole e l’Etica

- Rispetta robots.txt e i termini d’uso dei siti ().

- Non sovraccaricare i siti—usa ritardi tra le richieste.

- Evita di estrarre dati personali o sensibili.

- Usa API pubbliche quando disponibili.

3. Automatizza e Integra

- Pianifica scraping ricorrenti per dati sempre aggiornati.

- Esporta direttamente nei tuoi strumenti di lavoro (Sheets, Airtable, Notion).

- Usa alert o monitoraggio per intercettare errori subito.

4. Sicurezza e Monitoraggio

- Tieni traccia delle sessioni di scraping e degli errori.

- Fai backup dei dataset.

- Limita l’accesso ai dati sensibili.

Per altri consigli, leggi .

Conclusione: Il Futuro del Web Scraping è più Intelligente

Abbiamo fatto tanta strada dai tempi degli script Python scritti a mano e delle ore passate a sistemare selettori rotti. I dati web sono ormai una risorsa strategica— è destinato ai dati pubblici, e il mercato degli strumenti AI per lo scraping raggiungerà .

Python resta un ottimo modo per imparare le basi e gestire piccoli progetti. Ma con siti sempre più complessi, servono strumenti all’altezza. Gli estrattori AI come Thunderbit offrono un approccio più intelligente ed efficiente per raccogliere e usare i dati web—pensato per i team di oggi.

Se passi più tempo a risolvere problemi che a ottenere risultati, o vuoi scoprire come funziona lo scraping moderno, prova Thunderbit: . Il tuo team sales, ecommerce o operations noterà la differenza.