Lascia che ti racconti la prima volta che ho provato a fare estrazione dati da un sito per lavoro. Ero seduto al tavolo della cucina, una moka fumante da una parte e uno script Python scritto al volo dall’altra, cercando di recuperare i prezzi dei prodotti da un sito concorrente. Mi sono detto: “Ma sì, quanto potrà essere complicato?” Spoiler: mi sono ritrovato con un file CSV pieno di celle vuote e una nuova stima per chiunque dica “automatizza tutto con Python”. Arriviamo al 2025: oggi l’estrazione dati dal web è diventata il motore delle aziende data-driven—dà energia a vendite, ecommerce, marketing e operations con informazioni fresche che sarebbe impossibile raccogliere a mano.

Ma ecco il punto: anche se Python per l’estrazione dati è più potente che mai, lo scenario si sta evolvendo. Il mercato dell’estrazione web è in pieno boom—parliamo di . Quasi per prendere decisioni più intelligenti. Tuttavia, la vera sfida non è solo scrivere codice—ma scegliere lo strumento giusto, scalare il processo e non impazzire dietro a decine di script. In questa guida definitiva, ti mostro tutte le principali librerie Python per l’estrazione dati (con esempi pratici), casi d’uso reali e perché, nonostante il mio amore per Python, penso che soluzioni no-code come siano la scelta migliore per la maggior parte delle aziende nel 2025.

Cos’è l’Estrattore Web Python? Spiegato Semplice

In parole povere: estrazione dati dal web vuol dire automatizzare il copia-incolla. Invece di assumere un esercito di stagisti per raccogliere prezzi, contatti o recensioni, usi un software che visita le pagine web, prende le informazioni che ti servono e le salva in un foglio di calcolo o in un database. Estrarre dati con Python significa scrivere script che scaricano le pagine, analizzano l’HTML e recuperano solo quello che ti interessa.

Immagina di avere un assistente digitale che gira per i siti al posto tuo, 24 ore su 24, senza mai chiedere una pausa caffè. I dati più richiesti dalle aziende? Prezzi, dettagli prodotto, contatti, recensioni, immagini, articoli di news e annunci immobiliari. Alcuni siti offrono API, ma la maggior parte no—o mettono limiti. Qui entra in gioco l’estrazione web: ti permette di accedere a dati pubblici su larga scala, anche quando non c’è il tasto “scarica”.

Perché l’Estrattore Web Python è una Marcia in Più per le Aziende

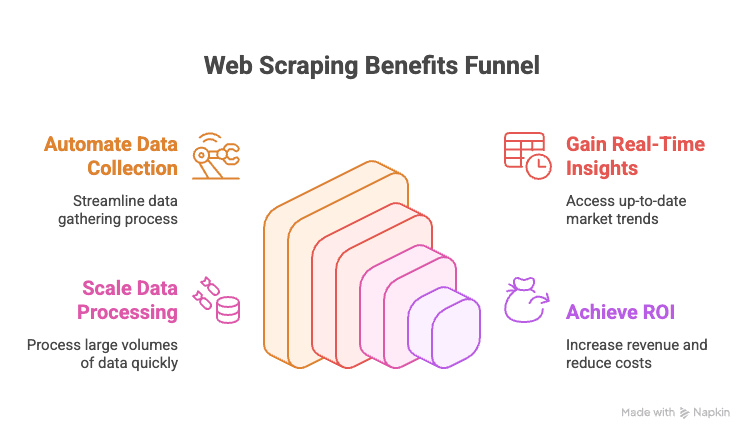

Diciamocelo: nel 2025, se la tua azienda non sfrutta l’estrazione dati dal web, sta lasciando soldi sul tavolo. Ecco perché:

- Automatizza la Raccolta Manuale: Basta copiare e incollare dati da siti concorrenti o elenchi online.

- Informazioni in Tempo Reale: Ottieni prezzi, disponibilità o trend di mercato aggiornati all’istante.

- Scalabilità: Puoi estrarre dati da migliaia di pagine in pochi minuti.

- ROI: Le aziende data-driven registrano .

Ecco una tabella con alcuni casi d’uso ad alto impatto:

| Dipartimento | Esempio d’Uso | Valore Generato |

|---|---|---|

| Vendite | Estrai lead da elenchi, arricchisci con email | Liste di contatti più ampie e mirate |

| Marketing | Monitora prezzi, promozioni, recensioni dei competitor | Campagne più intelligenti, reattività |

| Ecommerce | Controlla prezzi, stock e recensioni dei prodotti | Prezzi dinamici, alert su inventario |

| Operations | Aggrega dati fornitori, automatizza report | Risparmio di tempo, meno errori manuali |

| Immobiliare | Raccogli annunci da più siti | Più offerte, risposte rapide ai clienti |

In breve: l’estrazione dati dal web è la marcia in più per decisioni aziendali più rapide, intelligenti e competitive.

Panoramica: Tutte le Principali Librerie Python per l’Estrattore Web (con Esempi di Codice)

Promesso: ecco una panoramica completa. L’ecosistema Python per l’estrazione dati è vastissimo—c’è una libreria per ogni esigenza, dal semplice download di pagine fino all’automazione completa del browser. Ecco le principali, con esempi pratici:

urllib e urllib3: Le Basi delle Richieste HTTP

Sono gli strumenti integrati di Python per inviare richieste HTTP. Sono basilari, un po’ spartani, ma affidabili per compiti semplici.

1import urllib3, urllib3.util

2http = urllib3.PoolManager()

3headers = urllib3.util.make_headers(user_agent="MyBot/1.0")

4response = http.request('GET', "<https://httpbin.org/json>", headers=headers)

5print(response.status) # Codice di stato HTTP

6print(response.data[:100]) # primi 100 byte del contenutoUsali se vuoi zero dipendenze o il massimo controllo. Ma per la maggior parte dei casi, meglio qualcosa di più semplice—come requests.

requests: La Libreria Python Più Usata per l’Estrattore Web

Se l’estrazione dati Python avesse una mascotte, sarebbe la libreria requests. Semplice, potente, gestisce tutte le complessità delle richieste HTTP.

1import requests

2r = requests.get("<https://httpbin.org/json>", headers={"User-Agent": "MyBot/1.0"})

3print(r.status_code) # 200

4print(r.json()) # contenuto JSON (se la risposta è JSON)Perché è così popolare? Gestisce cookie, sessioni, redirect e altro—così puoi concentrarti sui dati, non sui dettagli tecnici. Ricorda: requests scarica solo l’HTML. Per estrarre i dati, serve un parser come BeautifulSoup.

BeautifulSoup: Analisi HTML Facile e Estrazione Dati

BeautifulSoup è la scelta ideale per analizzare HTML in Python. È tollerante agli errori, facile da imparare e si integra perfettamente con requests.

1from bs4 import BeautifulSoup

2html = "<div class='product'><h2>Widget</h2><span class='price'>$19.99</span></div>"

3soup = BeautifulSoup(html, 'html.parser')

4title = soup.find('h2').text # "Widget"

5price = soup.find('span', class_='price').text # "$19.99"Perfetta per progetti piccoli o medi, o per chi inizia. Per dataset enormi o query complesse, meglio passare a lxml.

lxml e XPath: Analisi HTML/XML Veloce e Potente

Se ti serve velocità o vuoi usare XPath (linguaggio di query per XML/HTML), lxml è la soluzione.

1from lxml import html

2doc = html.fromstring(page_content)

3prices = doc.xpath("//span[@class='price']/text()")XPath ti permette di estrarre dati con grande precisione. lxml è veloce ed efficiente, ma ha una curva di apprendimento più ripida rispetto a BeautifulSoup.

Scrapy: Il Framework per l’Estrattore Web su Larga Scala

Scrapy è il campione per i progetti di estrazione dati più grandi. È un vero framework—pensa a Django, ma per l’estrazione web.

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com/>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 }Scrapy gestisce richieste asincrone, segue i link, organizza pipeline e esporta dati in vari formati. È troppo per piccoli script, ma imbattibile per estrarre dati da migliaia di pagine.

Selenium, Playwright e Pyppeteer: Estrazione da Siti Dinamici

Quando un sito carica i dati tramite JavaScript, serve l’automazione del browser. Selenium e Playwright sono i nomi di riferimento.

Esempio Selenium:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("<https://example.com/login>")

5driver.find_element(By.NAME, "username").send_keys("user123")

6driver.find_element(By.NAME, "password").send_keys("secret")

7driver.find_element(By.ID, "submit-btn").click()

8titles = [el.text for el in driver.find_elements(By.CLASS_NAME, "product-title")]Esempio Playwright:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://website.com>")

6 page.wait_for_selector(".item")

7 data = page.eval_on_selector(".item", "el => el.textContent")Questi strumenti possono gestire qualsiasi sito, ma sono più lenti e pesanti rispetto all’estrazione HTTP pura. Usali solo quando necessario.

MechanicalSoup, RoboBrowser, PyQuery, Requests-HTML: Altri Strumenti Utili

-

MechanicalSoup: Automatizza l’invio di form e la navigazione, basato su Requests e BeautifulSoup.

1import mechanicalsoup 2browser = mechanicalsoup.StatefulBrowser() 3browser.open("<http://example.com/login>") 4browser.select_form('form#loginForm') 5browser["username"] = "user123" 6browser["password"] = "secret" 7browser.submit_selected() 8page = browser.get_current_page() 9print(page.title.text) -

RoboBrowser: Simile a MechanicalSoup, ma meno aggiornato.

-

PyQuery: Parsing HTML in stile jQuery.

1from pyquery import PyQuery as pq 2doc = pq("<div><p class='title'>Hello</p><p>World</p></div>") 3print(doc("p.title").text()) # "Hello" 4print(doc("p").eq(1).text()) # "World" -

Requests-HTML: Unisce richieste HTTP, parsing e anche rendering JavaScript.

1from requests_html import HTMLSession 2session = HTMLSession() 3r = session.get("<https://example.com>") 4r.html.render(timeout=20) 5links = [a.text for a in r.html.find("a.story-link")]

Usali per gestire form, selettori CSS o per un po’ di rendering JS leggero.

Asyncio e Aiohttp: Velocizzare l’Estrattore Web Python

Se devi estrarre dati da centinaia o migliaia di pagine, le richieste sincrone sono troppo lente. Ecco che entrano in gioco aiohttp e asyncio per l’estrazione concorrente.

1import aiohttp, asyncio

2async def fetch_page(session, url):

3 async with session.get(url) as resp:

4 return await resp.text()

5async def fetch_all(urls):

6 async with aiohttp.ClientSession() as session:

7 tasks = [fetch_page(session, url) for url in urls]

8 return await asyncio.gather(*tasks)

9urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

10html_pages = asyncio.run(fetch_all(urls))Questo approccio permette di scaricare decine di pagine in parallelo, velocizzando enormemente il processo.

Librerie Specializzate: PRAW (Reddit), PyPDF2 e Altre

-

PRAW: Per estrarre dati da Reddit tramite API.

1import praw 2reddit = praw.Reddit(client_id='XXX', client_secret='YYY', user_agent='myapp') 3for submission in reddit.subreddit("learnpython").hot(limit=5): 4 print(submission.title, submission.score) -

PyPDF2: Per estrarre testo dai PDF.

1from PyPDF2 import PdfReader 2reader = PdfReader("sample.pdf") 3num_pages = len(reader.pages) 4text = reader.pages[0].extract_text() -

Altre: Esistono librerie per Instagram, Twitter, OCR (Tesseract) e molto altro. Se hai una fonte dati particolare, probabilmente qualcuno ha già creato una libreria Python ad hoc.

Tabella Comparativa: Librerie Python per l’Estrattore Web

| Strumento / Libreria | Facilità d’Uso | Velocità & Scala | Ideale per |

|---|---|---|---|

| Requests + BeautifulSoup | Facile | Media | Principianti, siti statici, script rapidi |

| lxml (con XPath) | Media | Veloce | Grandi volumi, parsing complesso |

| Scrapy | Difficile | Molto Veloce | Enterprise, grandi crawl, pipeline |

| Selenium / Playwright | Media | Lenta | Siti dinamici, interattivi |

| aiohttp + asyncio | Media | Molto Veloce | Alto volume, pagine statiche |

| MechanicalSoup | Facile | Media | Login, form, gestione sessioni |

| PyQuery | Media | Veloce | Fan dei selettori CSS, manipolazione DOM |

| Requests-HTML | Facile | Variabile | Lavori piccoli, rendering JS leggero |

Guida Pratica: Come Costruire un Estrattore Web Python (con Esempi)

Vediamo un esempio concreto: estrarre le schede prodotto da un sito ecommerce (ipotetico), gestire la paginazione ed esportare i dati in CSV.

1import requests

2from bs4 import BeautifulSoup

3import csv

4base_url = "<https://example.com/products>"

5page_num = 1

6all_products = []

7while True:

8 url = base_url if page_num == 1 else f"{base_url}/page/{page_num}"

9 print(f"Scraping page: {url}")

10 response = requests.get(url, timeout=10)

11 if response.status_code != 200:

12 print(f"Page {page_num} returned status {response.status_code}, stopping.")

13 break

14 soup = BeautifulSoup(response.text, 'html.parser')

15 products = soup.find_all('div', class_='product-item')

16 if not products:

17 print("No more products found, stopping.")

18 break

19 for prod in products:

20 name_tag = prod.find('h2', class_='product-title')

21 price_tag = prod.find('span', class_='price')

22 name = name_tag.get_text(strip=True) if name_tag else "N/A"

23 price = price_tag.get_text(strip=True) if price_tag else "N/A"

24 all_products.append((name, price))

25 page_num += 1

26print(f"Collected {len(all_products)} products. Saving to CSV...")

27with open('products_data.csv', 'w', newline='', encoding='utf-8') as f:

28 writer = csv.writer(f)

29 writer.writerow(["Product Name", "Price"])

30 writer.writerows(all_products)

31print("Data saved to products_data.csv")Cosa succede qui?

- Si cicla tra le pagine, si scarica l’HTML, si estraggono nome e prezzo dei prodotti, si interrompe quando non ci sono più risultati.

- I dati vengono esportati in CSV per analisi immediate.

Vuoi esportare in Excel? Usa pandas:

1import pandas as pd

2df = pd.DataFrame(all_products, columns=["Product Name", "Price"])

3df.to_excel("products_data.xlsx", index=False)Gestire Form, Login e Sessioni nell’Estrattore Web Python

Molti siti richiedono login o l’invio di form. Ecco come gestirli:

Con requests e una sessione:

1session = requests.Session()

2login_data = {"username": "user123", "password": "secret"}

3session.post("<https://targetsite.com/login>", data=login_data)

4resp = session.get("<https://targetsite.com/account/orders>")Con MechanicalSoup:

1import mechanicalsoup

2browser = mechanicalsoup.StatefulBrowser()

3browser.open("<http://example.com/login>")

4browser.select_form('form#login')

5browser["user"] = "user123"

6browser["pass"] = "secret"

7browser.submit_selected()Le sessioni ti permettono di mantenere i cookie e restare loggato mentre navighi tra le pagine.

Estrazione di Contenuti Dinamici e Pagine Generate da JavaScript

Se i dati non sono nell’HTML (visualizzando il sorgente vedi solo div vuoti), serve l’automazione del browser.

Esempio Selenium:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3driver.get("<http://examplesite.com/dashboard>")

4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, 'stats-table')))

5html = driver.page_sourceOppure, se trovi l’endpoint API chiamato da JavaScript, usa requests per scaricare direttamente il JSON—molto più veloce.

Esportare i Dati Estratti: CSV, Excel, Database e Altro

-

CSV: Usa il modulo

csvdi Python (vedi sopra). -

Excel: Usa pandas o openpyxl.

-

Google Sheets: Usa la libreria

gspread.1import gspread 2gc = gspread.service_account(filename="credentials.json") 3sh = gc.open("My Data Sheet") 4worksheet = sh.sheet1 5worksheet.clear() 6worksheet.append_row(["Name", "Price"]) 7for name, price in all_products: 8 worksheet.append_row([name, price]) -

Database: Usa

sqlite3,pymysql,psycopg2o SQLAlchemy per database SQL. Per NoSQL,pymongoper MongoDB.

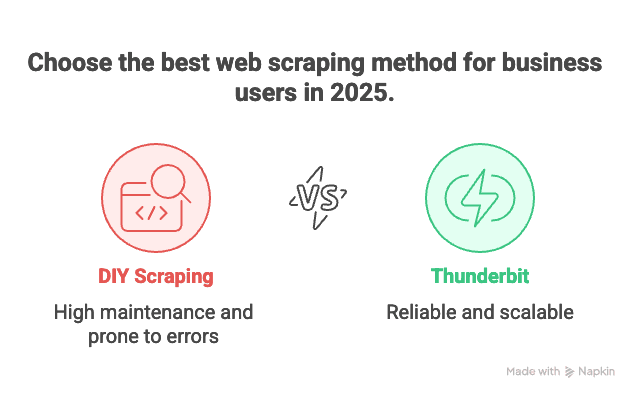

Python vs Soluzioni No-Code Moderne: Perché Thunderbit è la Scelta Top nel 2025

Parliamo dell’elefante nella stanza: la manutenzione. Scrivere i propri script è fantastico—finché non devi gestire 100 siti diversi, ognuno con le sue particolarità, e tutto si rompe la notte prima della consegna del report. Ci sono passato, so cosa vuol dire.

Ecco perché sono un grande fan di . Ecco cosa lo rende la mia prima scelta per le aziende nel 2025:

- Nessun Codice Necessario: Thunderbit offre un’interfaccia visuale. Clicca su “AI Suggerisci Campi”, regola le colonne, premi “Estrai” e hai finito. Niente Python, niente debug, niente maratone su Stack Overflow.

- Scalabilità su Migliaia di Pagine: Devi estrarre 10.000 prodotti? Il motore cloud di Thunderbit lo fa per te, senza dover sorvegliare uno script.

- Zero Manutenzione: Se monitori 100 siti concorrenti per l’ecommerce, mantenere 100 script Python è un incubo. Con Thunderbit, scegli o modifichi un template e l’AI si adatta automaticamente ai cambi di layout.

- Supporto Subpagine e Paginazione: Thunderbit segue i link alle sottopagine, gestisce la paginazione e può arricchire i dati visitando le pagine di dettaglio dei prodotti.

- Template Pronti all’Uso: Per i siti più popolari (Amazon, Zillow, LinkedIn, ecc.), Thunderbit offre template già pronti. Un click e hai i tuoi dati.

- Esportazione Gratuita dei Dati: Esporta in Excel, Google Sheets, Airtable o Notion—senza costi aggiuntivi.

In breve: se vuoi solo i dati, Thunderbit è come avere un maggiordomo digitale. Se sei uno sviluppatore che ama smanettare, Python resta il tuo parco giochi—ma a volte vuoi solo il risultato, senza complicazioni.

Best Practice per un’Estrattore Web Python Etico e Legale

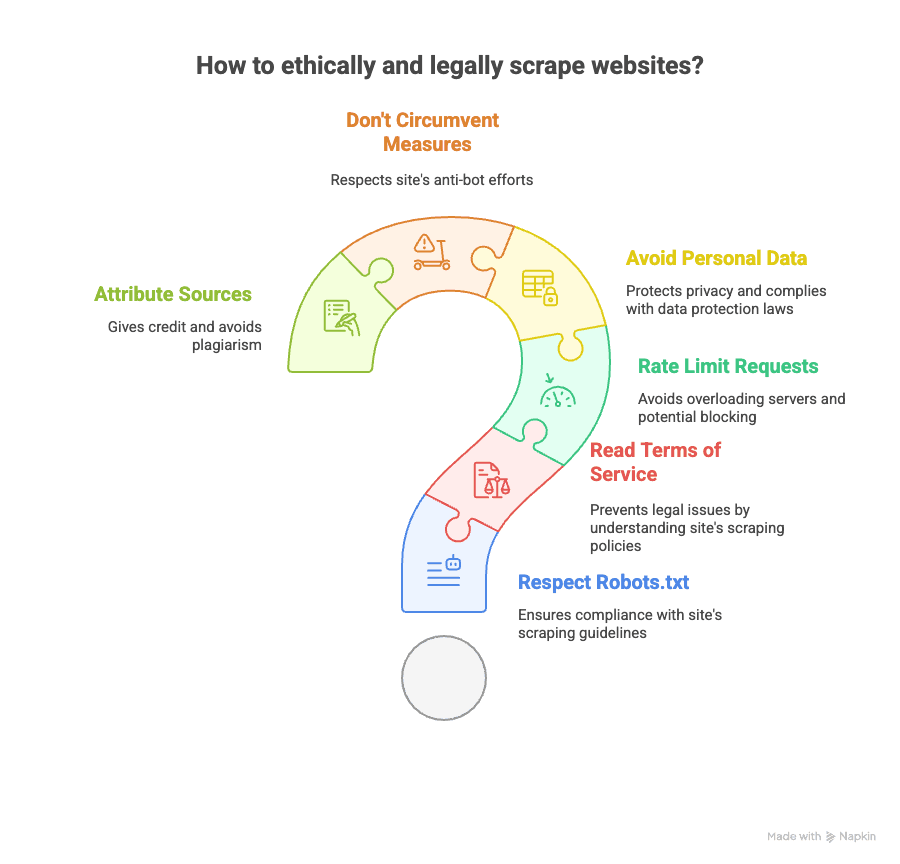

L’estrazione dati dal web è potente, ma richiede responsabilità. Ecco come restare dalla parte giusta della legge (e della coscienza):

- Controlla robots.txt: Rispetta le regole del sito su cosa può essere estratto.

- Leggi i Termini di Servizio: Alcuni siti vietano esplicitamente l’estrazione. Violare i ToS può portare a blocchi o azioni legali.

- Limita la Frequenza: Non sovraccaricare i server—aggiungi pause tra le richieste.

- Evita Dati Personali: Attenzione a email, numeri di telefono o dati sensibili (GDPR, CCPA).

- Non Eludere le Difese Anti-Bot: Se un sito usa CAPTCHA o blocchi aggressivi, valuta bene.

- Cita le Fonti: Se pubblichi analisi, attribuisci sempre la provenienza dei dati.

Per approfondire gli aspetti legali, leggi questa e le .

Risorse per Approfondire l’Estrattore Web Python (Corsi, Documentazione, Community)

Vuoi imparare di più? Ecco una selezione delle migliori risorse:

- Documentazione Ufficiale:

- Libri:

- “Web Scraping with Python” di Ryan Mitchell

- “Automate the Boring Stuff with Python” di Al Sweigart

- Guide Online:

- Video Tutorial:

- Canale YouTube di Corey Schafer

- Community:

E ovviamente, se vuoi vedere come funziona l’estrazione no-code, dai un’occhiata al o al .

Conclusioni & Consigli Finali: Scegliere la Soluzione di Estrazione Dati Giusta nel 2025

- L’estrazione dati dal web con Python è potentissima e flessibile. Se ami il codice, vuoi il massimo controllo e non ti spaventa un po’ di manutenzione, è la scelta giusta.

- Esiste una libreria Python per ogni esigenza: pagine statiche, contenuti dinamici, form, API, PDF, e molto altro.

- Ma per la maggior parte delle aziende, gestire decine di script è un incubo. Se vuoi ottenere dati velocemente, su larga scala e senza laurea in informatica, è la soluzione ideale.

- L’interfaccia no-code e l’AI di Thunderbit ti permettono di estrarre dati da qualsiasi sito in pochi click, gestire subpagine e paginazione, ed esportare dove vuoi—senza scrivere una riga di Python.

- Etica e legalità contano: Controlla sempre le policy dei siti, rispetta la privacy e agisci responsabilmente.

Che tu sia un esperto Python o voglia solo i dati senza complicazioni, nel 2025 gli strumenti sono migliori che mai. Il mio consiglio? Prova entrambi gli approcci, scegli quello che si adatta al tuo flusso di lavoro e lascia che i robot si occupino delle attività ripetitive—ma sempre con rispetto.

E se sei stufo di rincorrere script che si rompono, prova l’. Il tuo futuro (e la tua scorta di caffè) ti ringrazieranno.

Vuoi approfondire? Leggi o per guide pratiche e strategie aggiornate.