Diciamocelo: nessuno si alza la mattina con la voglia matta di copiare e incollare 500 righe di prezzi su un foglio Excel. (Se invece lo fai, tanto di cappello e ti consiglio un buon tutore per il polso!) Che tu sia nelle vendite, nelle operations o semplicemente voglia tenere la tua azienda sempre un passo avanti rispetto ai concorrenti, probabilmente hai già provato sulla tua pelle quanto sia faticoso estrarre dati dai siti web. Oggi il web è una vera miniera d’oro di informazioni e la richiesta di automazione nell’estrazione è alle stelle—.

Dopo anni passati tra SaaS e automazione, ne ho viste di tutti i colori: dalle macro Excel eroiche agli script Python messi insieme alle due di notte. In questa guida ti spiego come usare un parser HTML Python per estrarre dati reali dal web (sì, andremo a prendere insieme i voti dei film su IMDb) e ti racconto anche perché, nel 2025, esistono soluzioni molto più furbe—strumenti AI come che ti fanno saltare tutta la parte di programmazione e ti portano dritto al risultato.

Cos’è un Parser HTML e Perché Usarlo in Python?

Partiamo dalle basi: a cosa serve davvero un parser HTML? Immaginalo come un bibliotecario digitale del web. Legge il codice HTML, spesso un po’ caotico, di una pagina e lo trasforma in una struttura ad albero ordinata. Così puoi estrarre solo le informazioni che ti interessano—titoli, prezzi, link—senza perderti tra tag e div.

Python è la scelta numero uno per questo tipo di lavoro, e non è un caso. È leggibile, perfetto anche per chi è alle prime armi e offre una marea di librerie per scraping e parsing. In effetti, , grazie alla sua semplicità e a una community super attiva.

I Principali Parser HTML in Python

Ecco i protagonisti quando si parla di parsing HTML con Python:

- BeautifulSoup: Il classico, perfetto per chi parte da zero.

- lxml: Velocissimo e potente, ideale per query avanzate.

- html5lib: Super tollerante con HTML disordinato, proprio come un browser.

- PyQuery: Ti permette di usare selettori in stile jQuery direttamente in Python.

- HTMLParser: Il parser integrato di Python—sempre disponibile, ma piuttosto basico.

Ognuno ha le sue particolarità, ma tutti ti aiutano a trasformare HTML grezzo in dati ordinati.

Casi d’Uso: Come le Aziende Usano i Parser HTML in Python

Estrarre dati dal web non è più solo roba da tecnici o data scientist. È diventata una pratica fondamentale anche per vendite e operations. Ecco qualche esempio concreto:

| Caso d'Uso (Settore) | Dati Estratti | Beneficio Aziendale |

|---|---|---|

| Monitoraggio Prezzi (Retail) | Prezzi dei concorrenti, disponibilità prodotti | Prezzi dinamici, margini ottimizzati (fonte) |

| Analisi Prodotti Concorrenti | Schede prodotto, recensioni, disponibilità | Identificazione opportunità, generazione lead (fonte) |

| Lead Generation (B2B) | Nomi aziende, email, contatti | Prospecting automatico, crescita pipeline (fonte) |

| Analisi Sentiment (Marketing) | Post social, recensioni, valutazioni | Feedback in tempo reale, individuazione trend (fonte) |

| Aggregazione Immobiliare | Annunci, prezzi, info agenzie | Analisi mercato, strategie di pricing (fonte) |

| Intelligence Recruiting | Profili candidati, stipendi | Ricerca talenti, benchmark retributivi (fonte) |

In poche parole: se stai ancora copiando dati a mano, stai buttando via tempo e risorse preziose.

Il Kit del Parser HTML Python: Confronto tra le Librerie Più Usate

Andiamo sul pratico. Ecco una panoramica delle librerie Python più popolari per il parsing HTML, così puoi scegliere quella che fa per te:

| Libreria | Facilità d'Uso | Velocità | Flessibilità | Manutenzione | Ideale per |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | Moderata | Principianti, HTML disordinato |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | Moderata | Velocità, XPath, documenti grandi |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | Bassa | Parsing simile al browser, HTML rotto |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | Moderata | Fan di jQuery, selettori CSS |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | Bassa | Task semplici, integrato |

BeautifulSoup: La Scelta per Chi Inizia

BeautifulSoup è il “ciao mondo” del parsing HTML. Ha una sintassi intuitiva, ottima documentazione e gestisce senza problemi HTML anche molto sporco (). Il rovescio della medaglia? Non è la più veloce, soprattutto su pagine grandi o complesse, e non supporta nativamente selettori avanzati come XPath.

lxml: Prestazioni al Top

Se cerchi velocità o vuoi usare query XPath, lxml è la soluzione giusta (). Si basa su librerie C, quindi è rapidissima, ma può essere più complessa da installare e ha una curva di apprendimento più ripida.

Altre Opzioni: html5lib, PyQuery e HTMLParser

- html5lib: Analizza l’HTML come farebbe un browser—ottima per markup problematici, ma lenta ().

- PyQuery: Permette di usare selettori jQuery in Python, ideale se vieni dal front-end ().

- HTMLParser: L’opzione integrata in Python—veloce e sempre disponibile, ma con poche funzionalità.

Step 1: Configurare l’Ambiente Python per il Parsing HTML

Prima di tutto, bisogna preparare l’ambiente Python. Ecco come fare:

-

Installa Python: Scaricalo da se non lo hai già.

-

Installa pip: Di solito incluso da Python 3.4+, ma puoi verificare con

pip --versionnel terminale. -

Installa le librerie (in questa guida useremo BeautifulSoup e requests):

1pip install beautifulsoup4 requests lxmlbeautifulsoup4è il parser.requestsserve per scaricare le pagine web.lxmlè un parser veloce che BeautifulSoup può usare internamente.

-

Verifica l’installazione:

1python -c "import bs4, requests, lxml; print('Tutto ok!')"

Consigli per risolvere problemi:

- Se ricevi errori di permessi, prova con

pip install --user ... - Su Mac/Linux potresti dover usare

python3epip3. - Se vedi “ModuleNotFoundError”, controlla ortografia e ambiente Python.

Step 2: Estrarre Dati da una Pagina Web con Python

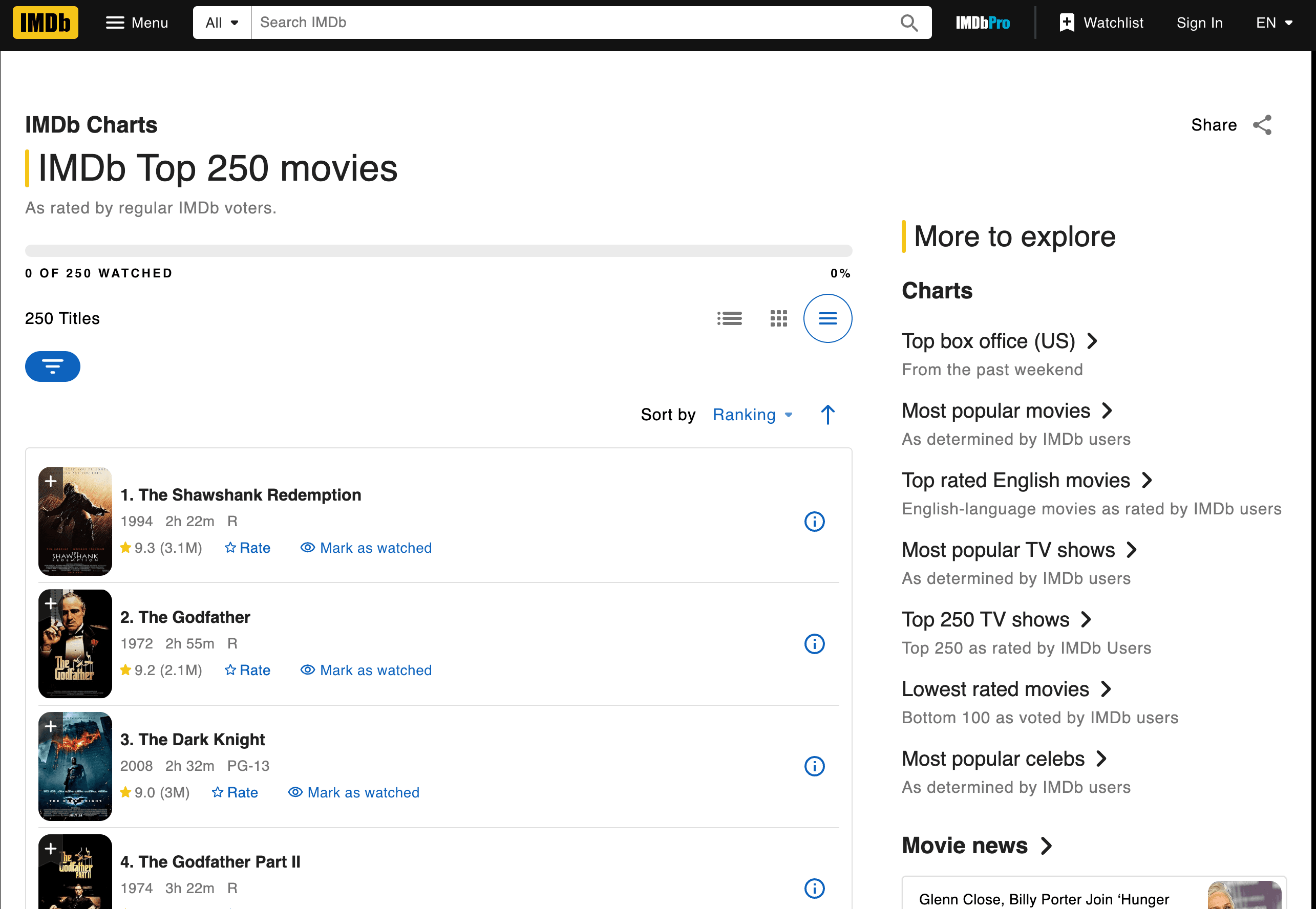

Passiamo all’azione: estraiamo i dati dei Top 250 film su IMDb. Prenderemo titoli, anni e voti.

Scaricare e Analizzare la Pagina

Ecco uno script passo passo:

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# Trova tutte le celle titolo e voto

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# Esempio: primi 3 film

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Voto: {rating}")Cosa succede qui?

- Usiamo

requests.get()per scaricare la pagina. BeautifulSoupanalizza l’HTML.- Cerchiamo i tag

<td>con le classi giuste. - Estraiamo testo per titolo, anno e voto.

Risultato:

11. Le ali della libertà (1994) -- Voto: 9.3

22. Il padrino (1972) -- Voto: 9.2

33. Il cavaliere oscuro (2008) -- Voto: 9.0Come Individuare Tag e Classi Giuste

Come ho fatto a capire quali tag e classi usare? Ho ispezionato l’HTML della pagina IMDb (tasto destro > Ispeziona elemento). Cerca schemi ricorrenti—qui ogni film è in un <td class="titleColumn"> e i voti in <td class="ratingColumn imdbRating"> ().

Consiglio pratico: Se estrai dati da un altro sito, inizia sempre ispezionando la struttura HTML e cerca classi o tag unici.

Salvare ed Esportare i Risultati

Salviamo i dati in un file CSV:

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Titolo', 'Anno', 'Voto'])

13 writer.writerows(movies)Consigli per la pulizia dei dati:

- Usa

.strip()per togliere spazi inutili. - Gestisci dati mancanti con controlli

if. - Per esportare in Excel, puoi aprire il CSV direttamente o usare

pandasper scrivere file.xlsx.

Step 3: Gestire Cambiamenti HTML e Manutenzione

Qui arrivano le vere sfide. I siti web cambiano spesso layout—se IMDb cambia class="titleColumn" in class="movieTitle", il tuo script improvvisamente non trova più nulla. Esperienza già vissuta!

Quando gli Script si Rompono: Problemi Comuni

Problemi tipici:

- Selettori non trovati: Il codice non trova il tag o la classe specificata.

- Risultati vuoti: La struttura della pagina è cambiata o i contenuti ora si caricano via JavaScript.

- Errori HTTP: Il sito ha aggiunto protezioni anti-bot.

Come risolvere:

- Controlla che l’HTML che stai analizzando sia uguale a quello che vedi nel browser.

- Aggiorna i selettori in base alla nuova struttura.

- Se i contenuti sono dinamici, valuta strumenti di automazione browser (come Selenium) o cerca un endpoint API.

Il vero problema? Se estrai dati da 10, 50 o 500 siti diversi, rischi di passare più tempo a correggere script che ad analizzare i dati ().

Step 4: Scalare—Costi Nascosti del Parsing HTML Manuale in Python

Mettiamo che tu voglia estrarre dati non solo da IMDb, ma anche da Amazon, Zillow, LinkedIn e altri siti. Ognuno richiede uno script dedicato. E ogni volta che un sito cambia, devi rimettere mano al codice.

I costi nascosti:

- Manutenzione: .

- Infrastruttura: Servono proxy, gestione errori, monitoraggio.

- Performance: Scalare significa gestire concorrenza, limiti di richiesta e altro.

- Controllo qualità: Più script = più punti in cui qualcosa può rompersi.

Per i team non tecnici, questa situazione diventa ingestibile in fretta. È come assumere una squadra di stagisti per copiare dati tutto il giorno—solo che gli stagisti sono script Python e si “ammalano” ogni volta che cambia un sito.

Oltre i Parser HTML Python: Scopri Thunderbit, l’Alternativa AI

Ed ecco la svolta. E se potessi saltare la programmazione, la manutenzione e ottenere subito i dati che ti servono—indipendentemente da come cambia il sito?

È proprio quello che offre . Si tratta di un Estrattore Web AI per Chrome che ti permette di estrarre dati strutturati da qualsiasi sito in due click. Niente Python, niente script, niente stress.

Parser HTML Python vs Thunderbit: Confronto Diretto

| Aspetto | Parser HTML Python | Thunderbit (vedi prezzi) |

|---|---|---|

| Tempo di setup | Alto (installazione, codice, debug) | Basso (installa estensione, clicca) |

| Facilità d’uso | Richiede programmazione | Nessun codice—punta e clicca |

| Manutenzione | Alta (gli script si rompono spesso) | Bassa (l’AI si adatta da sola) |

| Scalabilità | Complessa (script, proxy, infrastruttura) | Integrata (cloud scraping, batch) |

| Arricchimento dati | Manuale (scrivere altro codice) | Integrato (etichettatura, pulizia, traduzione, sottopagine) |

Perché programmare quando puoi risolvere tutto con l’AI?

Perché Scegliere l’AI per l’Estrazione Dati dal Web?

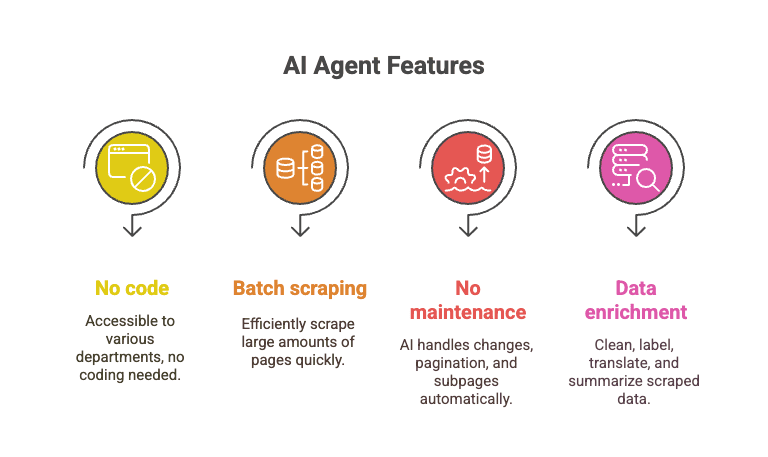

L’agente AI di Thunderbit legge la pagina, ne capisce la struttura e si adatta ai cambiamenti. È come avere un super-assistente che non dorme mai e non si lamenta se cambiano le classi.

- Nessun codice richiesto: Può usarlo chiunque—vendite, operations, marketing, ecc.

- Estrazione massiva: Puoi estrarre 10.000+ pagine nel tempo che impiegheresti a debuggare uno script Python.

- Zero manutenzione: L’AI gestisce cambi layout, paginazione, sottopagine e altro.

- Arricchimento dati: Pulizia, etichettatura, traduzione e sintesi dei dati in tempo reale.

Immagina di estrarre tutti i Top 250 di IMDb, più le schede dettagliate e le recensioni, in pochi click—mentre i tuoi script Python sono ancora bloccati su un errore “NoneType”.

Passo Passo: Estrarre i Voti dei Film IMDb con Thunderbit

Ecco come Thunderbit affronta lo stesso compito su IMDb:

- Installa la .

- Vai alla .

- Clicca sull’icona Thunderbit.

- Clicca su “AI Suggerisci Campi.” Thunderbit leggerà la pagina e proporrà le colonne (Titolo, Anno, Voto).

- Rivedi o modifica le colonne se necessario.

- Clicca su “Estrai.” Thunderbit estrarrà tutte le 250 righe in un attimo.

- Esporta su Excel, Google Sheets, Notion o CSV—come preferisci.

Tutto qui. Niente codice, niente debug, niente “perché la lista è vuota?”.

Vuoi vedere come funziona? Dai un’occhiata al per tutorial video, oppure leggi la nostra per un altro esempio pratico.

Conclusioni: Scegli lo Strumento Giusto per i Tuoi Dati Web

Parser HTML Python come BeautifulSoup e lxml sono strumenti potenti, flessibili e gratuiti. Sono perfetti per chi vuole il massimo controllo e non ha paura di sporcarsi le mani con il codice. Ma richiedono tempo, manutenzione continua e possono diventare un peso man mano che le esigenze crescono.

Per chi lavora in azienda, nelle vendite o semplicemente vuole i dati senza occuparsi del codice, strumenti AI come sono una vera rivoluzione. Permettono di estrarre, pulire e arricchire dati web su larga scala, senza scrivere una riga di codice e senza pensieri.

Il mio consiglio? Scegli Python se ti piace programmare e vuoi la massima personalizzazione. Ma se vuoi risparmiare tempo (e nervi), prova Thunderbit. Perché costruire e mantenere script quando puoi lasciare il lavoro pesante all’AI?

Vuoi approfondire scraping, estrazione dati e automazione AI? Scopri altri tutorial sul , come o .