Non scorderò mai la prima volta che ho visto qualcuno passare ore a copiare e incollare dati da un sito web a un foglio Excel. Sembrava di guardare qualcuno che cerca di svuotare il mare con un bicchierino. Oggi, però, l’automazione dei processi è diventata la normalità—soprattutto quando si parla di web scraping. Ma con sempre più aziende che vogliono automatizzare queste attività ripetitive, la domanda sorge spontanea: meglio affidarsi alla classica RPA (Robotic Process Automation) o puntare su agenti AI e Estrattori Web AI?

Se lavori in commerciale, e-commerce o operations, probabilmente ti sei già trovato davanti a questo bivio. I dati parlano chiaro: , e un altro 19% ci sta pensando seriamente. Nel frattempo, agenti AI ed Estrattori Web AI stanno prendendo piede, promettendo di gestire anche i siti più tosti e dinamici con pochi click. Ma come scegliere? Vediamo cosa significa davvero automazione dei processi, in cosa RPA e agenti AI sono diversi e perché il futuro del web scraping sembra sempre più vicino all’approccio AI di .

Facciamo chiarezza: cos’è davvero l’automazione dei processi?

Partiamo dalle basi: automazione dei processi vuol dire semplicemente “lasciare che il software si occupi delle rogne”. È come avere un autolavaggio per le aziende: le macchine fanno il lavoro ripetitivo e noioso, così le persone possono concentrarsi su quello che conta davvero (o almeno prendersi una pausa caffè in più).

Nel business, automatizzare i processi significa rendere le operazioni di tutti i giorni più snelle, ridurre gli errori e liberare tempo prezioso al team. Nel web scraping, automazione vuol dire usare strumenti per raccogliere dati da siti web—prezzi, contatti, recensioni—senza doverli copiare a mano pagina dopo pagina. Invece di passare ore a fare copia-incolla, imposti un “robot” digitale o un agente che lo fa per te. Un po’ come avere una risposta automatica alle email, ma per tutto il web.

I vantaggi sono lampanti: . E dopo anni passati a sviluppare SaaS e soluzioni di automazione, ti assicuro che—una volta automatizzato il web scraping, non tornerai mai più all’inserimento manuale.

RPA: cos’è la Robotic Process Automation?

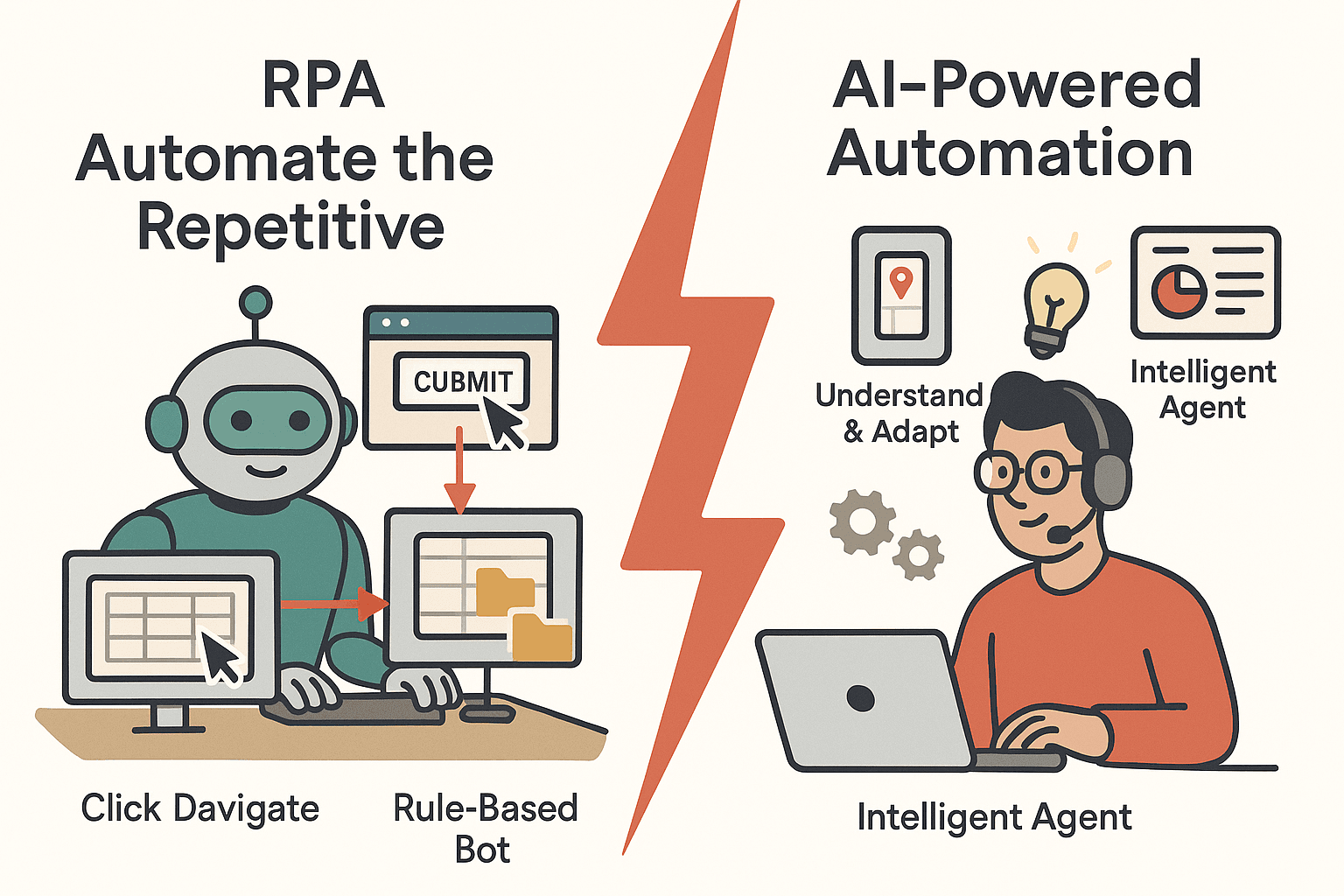

La Robotic Process Automation (RPA) è la veterana dell’automazione dei processi. Usa “robot” software che imitano le azioni umane al computer—cliccano, navigano, copiano e incollano dati tra applicazioni. Questi bot seguono istruzioni precise e regole fisse e sono perfetti per attività ripetitive e ben strutturate.

Esempi tipici di RPA nel web scraping

- Accedere a un sito ed estrarre dati da campi specifici

- Copiare dati da form online a database interni

- Scaricare report programmati da portali web

La RPA è molto usata in settori come finanza, e-commerce e operations. Un negozio online può usarla per monitorare ogni notte i prezzi dei concorrenti, oppure un team finanziario per aggiornare i fogli con le ultime quotazioni.

Punti di forza della RPA

- Affidabilità: I bot non si stancano e non sbagliano. Lavorano 24/7 e sono .

- Conformità: Ogni passaggio è tracciato, perfetto per audit e controlli.

- Implementazione rapida: Per attività semplici e ripetitive, la RPA si configura in fretta—senza grandi complicazioni.

Limiti della RPA

Ma c’è il rovescio della medaglia: la RPA è molto rigida. Se un sito cambia layout o struttura, il bot si blocca. È come imparare a guidare memorizzando ogni curva: basta una deviazione e sei perso. La RPA fatica anche con:

- Contenuti dinamici: Scroll infinito, pop-up o layout che cambiano richiedono logiche extra e manutenzione.

- Dati non strutturati: Se i dati non sono sempre nello stesso punto, la RPA si confonde.

- Manutenzione: .

Insomma, la RPA è perfetta per compiti ripetitivi e ben definiti, ma non è la più flessibile.

Il nuovo arrivato: cos’è un Agente AI?

Ed ecco che entrano in scena gli agenti AI—la nuova generazione dell’automazione, più smart e adattabile. Nel web scraping, un agente AI è un programma autonomo a cui dai un obiettivo (“prendimi tutti i nomi e prezzi dei prodotti da questo sito”) e lui trova da solo il modo migliore per farlo.

In cosa gli agenti AI sono diversi dalla RPA

- Apprendimento e adattamento: Gli agenti AI usano machine learning e linguaggio naturale per capire, decidere e agire. Gestiscono dati non strutturati, imparano da nuovi schemi e si adattano ai cambiamenti.

- Comprensione del contesto: Invece di seguire regole rigide, interpretano il contenuto della pagina—riconoscono schemi, capiscono il contesto e possono persino analizzare immagini o testo libero.

- Istruzioni in linguaggio naturale: Spesso basta spiegare all’agente AI cosa vuoi ottenere, e lui capisce come muoversi.

Immagina la RPA come un impiegato preciso che segue le istruzioni alla lettera, mentre un agente AI è un assistente autonomo che sa improvvisare e adattarsi.

L’Estrattore Web AI: l’evoluzione successiva

Gli Estrattori Web AI fanno un passo in più. Usano modelli avanzati per individuare automaticamente i campi dati, gestire paginazione e scroll infiniti, ed estrarre dati anche da sottopagine—tutto con una configurazione minima. È qui che strumenti come stanno cambiando le regole del gioco, rendendo l’automazione dei processi accessibile a tutti, non solo agli sviluppatori.

Automazione dei processi per il web scraping: perché è fondamentale

Perché automatizzare il web scraping? Perché raccogliere dati a mano è lento, pieno di errori e impossibile da scalare. L’automazione offre:

- Risparmio di tempo: I bot possono estrarre centinaia di pagine in pochi minuti—quello che prima richiedeva giorni o settimane.

- Riduzione dei costi: sostituendo il lavoro manuale con l’automazione.

- Precisione: Dati più coerenti e senza errori.

- Scalabilità: Gli estrattori automatizzati gestiscono migliaia di prodotti o milioni di record.

- Vantaggio competitivo: Dati più freschi e veloci significano decisioni migliori e risposte più rapide.

Ecco una tabella con i casi d’uso più comuni del web scraping e i vantaggi dell’automazione:

| Caso d’uso Web Scraping | Cosa si raccoglie e perché | Vantaggio dell’automazione |

|---|---|---|

| Monitoraggio prezzi concorrenti | Prezzi prodotti, disponibilità | Intelligence sui prezzi in tempo reale, risparmio di ore di controlli manuali |

| Lead Generation | Nomi, email, telefoni | Generazione continua di contatti, libera il team commerciale |

| Ricerche di mercato | Recensioni, valutazioni | Raccolta rapida di opinioni, individuazione di trend |

| Aggregazione cataloghi prodotti | Dettagli prodotti | Database sempre aggiornati, time-to-market più veloce |

| Annunci immobiliari | Prezzi, località | Analisi quotidiana del mercato, report completi |

| Estrazione dati finanziari | Quotazioni, report | Aggiornamenti in tempo reale, gestione di grandi volumi |

| Monitoraggio compliance | Uso del brand, policy | Controlli costanti, alert immediati, tracciabilità |

In breve: .

RPA vs Agente AI: come automatizzano il web scraping?

Vediamo in concreto come RPA e agenti AI affrontano il web scraping. Ecco un confronto diretto:

| Fase | Approccio RPA | Approccio Agente AI |

|---|---|---|

| Configurazione iniziale | L’utente registra ogni azione, definisce ogni campo | L’utente fornisce l’URL e descrive i dati desiderati; l’AI individua i campi automaticamente |

| Flessibilità | Fragile—si rompe con cambiamenti al sito | Adattivo—gestisce layout e schemi nuovi |

| Dati strutturati | Ottimo | Ottimo |

| Dati non strutturati | In difficoltà | Eccelle—analizza testo, immagini, contesto |

| Paginazione/Scrolling | Richiede script dedicati | Rileva e gestisce in automatico |

| Manutenzione | Elevata—serve aggiornare ad ogni modifica | Bassa—l’AI si adatta ai piccoli cambiamenti |

| Competenze tecniche richieste | Medie—serve configurazione | Basse—niente codice, prompt in linguaggio naturale |

| Scalabilità | Limitata da licenze bot | Cloud-native, scala facilmente |

Quando scegliere l’uno o l’altro?

- La RPA è perfetta per siti stabili, prevedibili e dati strutturati—come portali interni o sistemi legacy.

- Gli agenti AI sono ideali per siti dinamici, complessi o che cambiano spesso, o se il tuo team non è tecnico.

RPA per il web scraping: la via tradizionale

Esempio pratico: usando RPA (come UiPath o Automation Anywhere), dovresti:

- Registrare la navigazione: apri il browser, accedi, clicca sulle pagine, copia i dati.

- Il bot ripete queste azioni, scorrendo le pagine e copiando i dati nel foglio di calcolo o database.

Sfide tipiche:

- Cambiamenti al sito: Un nuovo banner o un pulsante rinominato possono bloccare il bot.

- Paginazione: Scroll infinito o pulsanti “Carica altro” richiedono script extra.

- Contenuti dinamici: I bot devono aspettare il caricamento dei dati.

- Anti-bot: CAPTCHAs e blocchi IP possono fermare la RPA.

- Scalabilità: Gestire tanti bot in parallelo può diventare costoso e complicato.

La RPA è ottima per siti interni e prevedibili, ma per il web pubblico può diventare un incubo da mantenere.

Estrattore Web AI: la nuova frontiera dell’automazione

Ecco come lavora un Estrattore Web AI:

- Apri il sito, clicca su “AI Suggerisci Campi” e lascia che l’AI analizzi la pagina.

- L’AI propone una tabella con i dati che può estrarre—nomi prodotti, prezzi, valutazioni, ecc.

- Puoi modificare o accettare i suggerimenti, poi clicchi su “Estrai”.

- L’agente AI gestisce automaticamente paginazione, segue i link alle sottopagine ed esporta i dati su Excel, Google Sheets, Airtable o Notion.

Vantaggi principali:

- Configurazione minima: Niente codice, niente tag manuali—basta descrivere ciò che vuoi.

- Gestione automatica di sottopagine e paginazione: L’AI segue i link in autonomia.

- Parsing intelligente dei dati: L’AI può pulire, formattare e persino categorizzare i dati durante l’estrazione.

- Esportazione semplice: Un click e i dati sono nei tuoi strumenti preferiti.

Per chi non è tecnico (e anche per chi lo è ma vuole risparmiare tempo), è una vera svolta. È come passare dal vecchio Nokia al primo smartphone.

Focus su Thunderbit: Estrattore Web AI come Agente AI

Parliamo di dove ho investito tempo (e parecchie notti insonni): . Thunderbit è un’estensione Chrome Estrattore Web AI che sta diventando un vero agente AI per l’automazione web. Il nostro obiettivo? Rendere il web scraping così semplice che anche tua nonna potrebbe farlo (e magari divertirsi pure).

Cosa rende Thunderbit diverso?

- AI Suggerisci Campi: Un click e l’AI legge la pagina suggerendo le colonne migliori da estrarre.

- Estrazione da sottopagine: Thunderbit può visitare ogni sottopagina (come le schede prodotto) e arricchire la tabella dati—senza configurazioni extra.

- Rilevamento paginazione: Che sia un pulsante “Avanti” o uno scroll infinito, l’AI di Thunderbit lo riconosce e continua l’estrazione.

- Esportazione immediata: Esporta i dati su Excel, Google Sheets, Airtable o Notion con un click—senza costi extra.

- Nessun codice richiesto: Tutto pensato per utenti business, non solo sviluppatori.

- Estrazione in cloud o browser: Scegli se estrarre in cloud (veloce, in parallelo) o nel browser (ideale per siti con login).

- Utility AI gratuite: Estrai email, numeri di telefono o immagini da qualsiasi sito con un click.

- Estrattore Pianificato: Programma estrazioni ricorrenti con linguaggio naturale—“ogni giorno alle 9”—e Thunderbit fa il resto.

Thunderbit nasce per essere il tuo “assistente dati AI” nel browser. Non si tratta solo di estrarre dati, ma di automatizzare tutto il processo, dall’estrazione all’esportazione, con il minimo sforzo. E siamo solo all’inizio: il futuro sono agenti AI capaci non solo di leggere il web, ma anche di agire su di esso.

Vuoi provarlo? .

Scegliere lo strumento giusto: quando usare RPA, Agente AI o entrambi

Come decidere tra RPA e agenti AI (come Thunderbit) per automatizzare il web scraping? Ecco una checklist veloce:

| Fattore decisionale | RPA | Agente AI / Estrattore Web AI |

|---|---|---|

| Dati molto strutturati e sito stabile | ✅ | |

| Dati disordinati, non strutturati o sito che cambia spesso | ✅ | |

| Gestione di contenuti dinamici (scroll infinito, pop-up) | ✅ | |

| Il team ha competenze IT/coding | ✅ | ✅ |

| Il team non è tecnico | ✅ | |

| Conformità/audit richiedono passaggi ripetibili | ✅ | |

| Serve scalare velocemente o estrarre da molti siti | ✅ | |

| Estrazione occasionale o ad hoc | ✅ | |

| Processo ricorrente e ripetitivo | ✅ | ✅ |

| Vuoi combinare i vantaggi | Ibrido possibile | Ibrido possibile |

Consiglio pratico: Oggi molte aziende usano entrambi gli approcci—RPA per flussi interni strutturati e agenti AI per dati web esterni e dinamici. Il futuro è ibrido.

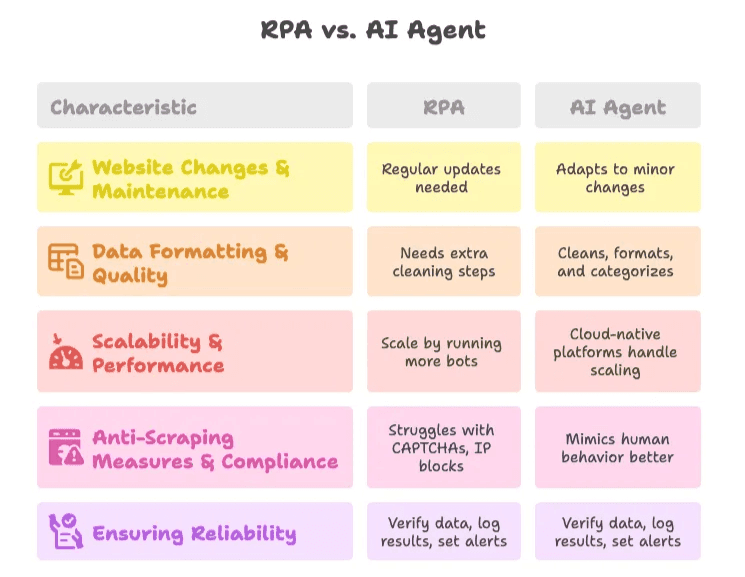

Come superare le sfide comuni nell’automazione del web scraping

1. Cambiamenti ai siti & manutenzione

- RPA: Serve aggiornare spesso quando i siti cambiano. Usa script modulari e monitora per scovare subito i problemi.

- Agente AI: Più resiliente—l’AI si adatta ai piccoli cambiamenti, ma è sempre meglio controllare ogni tanto i risultati.

2. Formattazione & qualità dei dati

- RPA: Bisogna aggiungere passaggi per pulire i dati, o integrare con script/Excel.

- Agente AI: L’AI può pulire, formattare e categorizzare i dati già durante l’estrazione. Usa prompt specifici per risultati top.

3. Scalabilità & performance

- RPA: Si scala avviando più bot, ma occhio a limiti e costi.

- Agente AI: Piattaforme cloud-native come Thunderbit gestiscono la scalabilità per te.

4. Anti-scraping & compliance

- RPA: Può avere problemi con CAPTCHAs e blocchi IP. Meglio limitarsi a siti dove si ha il permesso.

- Agente AI: Alcuni agenti AI simulano meglio il comportamento umano, ma è sempre fondamentale rispettare le policy dei siti e la privacy dei dati.

5. Affidabilità

- Best practice: Controlla sempre i dati estratti, registra i risultati e imposta alert per anomalie. Fai controlli manuali periodici, soprattutto per processi critici.

Il futuro dell’automazione dei processi: gli agenti AI al comando

Qui si fa davvero interessante. Stiamo passando dall’automazione all’autonomia. Gli agenti AI non si limitano a seguire istruzioni: iniziano a prendere decisioni, adattarsi a nuovi scenari e persino suggerire azioni in base ai dati raccolti.

- .

- Entro il 2028, .

- Le piattaforme no-code e low-code stanno rendendo lo sviluppo di agenti AI accessibile a tutti, non solo all’IT.

Noi di Thunderbit lavoriamo proprio per questo futuro. La nostra visione è rendere l’automazione dei processi così intuitiva che chiunque possa automatizzare web scraping, raccolta dati e persino esecuzione di workflow con pochi click e un prompt in linguaggio naturale. Non stiamo solo estraendo dati—stiamo costruendo gli agenti AI che guideranno la prossima ondata di automazione aziendale.

Vuoi vedere dove stiamo andando? Dai un’occhiata al , oppure scopri di più su e .

Considerazioni finali

L’automazione dei processi non serve più solo a sostituire il lavoro manuale—serve a dare più potere ai team, permettendo loro di fare di più, più in fretta e con meno fatica. RPA e agenti AI hanno entrambi il loro ruolo, ma la direzione è chiara: gli Estrattori Web AI come Thunderbit rendono l’automazione più smart, resiliente e alla portata di tutti.

Se stai ancora copiando dati a mano, è il momento di mettere giù il bicchierino e lasciare che i robot facciano il lavoro pesante. E se vuoi vedere cosa possono fare gli agenti AI per la tua azienda, . Il tuo futuro (e il tuo team) ti ringrazierà.

Domande frequenti

1. Qual è la differenza tra RPA e agenti AI nell’automazione dei processi?

La RPA (Robotic Process Automation) segue istruzioni rigide e regole precise per automatizzare attività ripetitive, ideale in ambienti stabili e strutturati. Gli agenti AI, invece, interpretano il contesto, si adattano ai cambiamenti e gestiscono dati non strutturati grazie a machine learning e linguaggio naturale—perfetti per web scraping dinamico e complesso.

2. Perché l’automazione dei processi è importante per il web scraping?

Il web scraping manuale è lento, soggetto a errori e non scalabile. Automatizzare il web scraping fa risparmiare tempo, riduce i costi, migliora la precisione e permette decisioni in tempo reale grazie alla raccolta continua di dati aggiornati senza intervento umano.

3. Quando dovrei usare la RPA invece di un Estrattore Web AI come Thunderbit?

La RPA è ideale per siti prevedibili con dati strutturati e quando serve documentazione rigorosa per la compliance. Se il tuo team ha competenze tecniche e i siti target non cambiano spesso, la RPA può essere una scelta affidabile.

4. Cosa rende Thunderbit diverso dagli strumenti di scraping tradizionali?

Thunderbit utilizza l’AI per individuare automaticamente i campi, gestire la paginazione, estrarre da sottopagine ed esportare i dati con un click—senza bisogno di codice. È pensato per utenti business e supporta scraping sia da browser che da cloud, rendendo l’automazione accessibile anche ai non sviluppatori.

5. Si possono usare insieme RPA e agenti AI?

Sì. Molte aziende usano la RPA per processi interni e stabili e agenti AI come Thunderbit per siti esterni e dinamici. Questo approccio ibrido sfrutta i punti di forza di entrambe le tecnologie per un’automazione più ampia e resiliente.

Approfondimenti: