Il web nel 2026 è diventato un vero e proprio giungla digitale: metà del traffico online arriva da bot e gli Estrattori Web open-source sono il motore silenzioso dietro attività come il monitoraggio prezzi e l’addestramento dell’IA. Dopo anni passati tra SaaS e automazione, posso dirti che scegliere il giusto crawler web self-hosted ti salva da mesi di grattacapi (e da nottate passate a inseguire bug). Che tu debba estrarre dati da qualche pagina prodotto o scandagliare milioni di URL per ricerca, le alternativa open-source a Firecrawl che trovi qui coprono ogni esigenza—indipendentemente dalla scala, dal linguaggio di programmazione o dalla complessità.

C’è però una cosa da tenere a mente: non esiste la soluzione perfetta per tutti. Alcuni team hanno bisogno della potenza di Scrapy o della capacità di archiviazione di Heritrix, altri invece trovano troppo impegnativa la manutenzione delle librerie open-source. Ecco perché qui analizziamo i 9 migliori competitor gratuiti di Firecrawl per il 2026, ti mostriamo i punti di forza di ciascuno e ti aiutiamo a scegliere lo strumento più adatto al tuo business—senza dover perdere tempo in tentativi a vuoto.

Come scegliere la migliore alternativa open-source a Firecrawl per la tua azienda

Prima di entrare nel vivo, parliamo di strategia. L’ecosistema degli Estrattori Web open-source è più vario che mai, e la scelta dipende da alcuni fattori chiave:

- Facilità d’uso: Preferisci un’interfaccia visuale o ti trovi a tuo agio con Python, Go o JavaScript?

- Scalabilità: Devi estrarre dati da un solo sito o vuoi scandagliare milioni di pagine su centinaia di domini?

- Tipo di contenuto: Il sito target è in HTML statico o fa largo uso di JavaScript e caricamenti dinamici?

- Integrazione: Come vuoi utilizzare i dati? Esportazione in Excel, invio a un database o integrazione in pipeline di analytics?

- Manutenzione: Hai risorse per gestire codice personalizzato o preferisci uno strumento che si adatti automaticamente ai cambiamenti dei siti?

Ecco una tabella riassuntiva per aiutarti nella scelta:

| Scenario | Miglior Strumento(i) |

|---|---|

| No-code, navigazione offline | HTTrack |

| Crawling su larga scala, multi-dominio | Scrapy, Apache Nutch, StormCrawler |

| Siti dinamici/ricchi di JS | Puppeteer |

| Automazione form/login richiesto | MechanicalSoup |

| Download/archiviazione siti statici | Wget, HTTrack, Heritrix |

| Sviluppatore Go, alte prestazioni | Colly |

Vediamo ora le 9 migliori alternativa open-source a Firecrawl per il 2026.

1. Scrapy: il top per crawling Python su larga scala

è il punto di riferimento tra i framework open-source per il web crawling. Scritto in Python, è la scelta ideale per chi deve gestire grandi volumi di dati—parliamo di milioni di pagine, aggiornamenti frequenti e logiche complesse.

Perché scegliere Scrapy?

- Scalabilità elevata: Gestisce migliaia di richieste al secondo, usato da aziende che estraggono miliardi di pagine al mese ().

- Estendibile e modulare: Puoi scrivere spider personalizzati, integrare middleware per proxy, gestire login e esportare dati in JSON, CSV o database.

- Community attiva: Tantissimi plugin, documentazione e risposte su Stack Overflow.

- Affidabilità comprovata: Utilizzato in produzione da e-commerce, media e centri di ricerca in tutto il mondo.

Limiti: Curva di apprendimento ripida per chi non è sviluppatore e necessità di manutenzione degli spider quando i siti cambiano. Ma se cerchi controllo totale e scalabilità, Scrapy è imbattibile.

2. Apache Nutch: ideale per motori di ricerca aziendali

è uno dei pionieri tra i crawler open-source, pensato per il crawling su scala internet e per progetti enterprise. Se vuoi costruire un motore di ricerca o scandagliare milioni di domini, Nutch è la soluzione.

Perché Apache Nutch?

- Scalabilità Hadoop: Basato su Hadoop, può gestire miliardi di pagine su cluster di server ().

- Crawling batch: Basta fornire una lista di URL di partenza e lasciarlo lavorare—perfetto per job pianificati su larga scala.

- Integrazione: Compatibile con Solr, Elasticsearch e pipeline di big data.

Limiti: Configurazione complessa (cluster Hadoop, file di configurazione Java) e orientato più al crawling che all’estrazione di dati strutturati. Eccessivo per progetti piccoli, ma insuperabile per la scala web.

3. Heritrix: il migliore per archiviazione web e compliance

è il crawler sviluppato dall’Internet Archive, pensato per l’archiviazione e la conservazione digitale.

Perché Heritrix?

- Archiviazione completa: Cattura ogni pagina, asset e link—perfetto per esigenze legali o snapshot storici.

- Output WARC: Salva tutto in file Web ARChive standard, pronti per analisi o riproduzione.

- Gestione via web: Configura e monitora i crawl tramite interfaccia browser.

Limiti: Richiede molte risorse (disco e RAM), non esegue JavaScript e produce archivi grezzi, non tabelle di dati strutturati. Ideale per biblioteche, archivi o settori regolamentati.

4. Colly: il top per sviluppatori Go ad alte prestazioni

è la scelta preferita dagli sviluppatori Go: leggero, veloce e altamente concorrente.

Perché Colly?

- Velocità eccezionale: Grazie alla concorrenza di Go, Colly può estrarre migliaia di pagine con un uso minimo di risorse ().

- API semplice: Definisci callback per elementi HTML, gestisci cookie e robots.txt in automatico.

- Perfetto per siti statici: Ideale per pagine server-side, API o integrazione in backend Go.

Limiti: Non supporta nativamente il rendering JavaScript (per siti dinamici serve Chromedp o simili) e richiede conoscenza di Go.

5. MechanicalSoup: ideale per automazione di form semplici

è una libreria Python che colma il divario tra semplici richieste HTTP e l’automazione completa del browser.

Perché MechanicalSoup?

- Automazione form: Login, compilazione form e gestione sessioni in modo semplice—ottimo per estrarre dati dietro autenticazione.

- Leggero: Si basa su Requests e BeautifulSoup, quindi è veloce e facile da configurare.

- Ideale per siti interattivi: Se devi inviare form di ricerca o estrarre dati dopo il login, è una scelta azzeccata ().

Limiti: Non esegue JavaScript, quindi non funziona su siti ricchi di JS. Perfetto per pagine statiche o server-side con interazioni semplici.

6. Puppeteer: il migliore per siti dinamici e ricchi di JavaScript

è il coltellino svizzero per estrarre dati da siti moderni e dinamici. È una libreria Node.js che ti dà il pieno controllo su un browser Chrome headless.

Perché Puppeteer?

- Gestisce contenuti dinamici: Perfetto per SPA, infinite scroll e pagine che caricano dati via AJAX ().

- Simulazione utente: Puoi cliccare, compilare form, fare screenshot e persino risolvere CAPTCHA (con plugin).

- Automazione avanzata: Ottimo per test, monitoraggio e scraping di tutto ciò che vede un utente reale.

Limiti: Richiede molte risorse (esegue istanze complete di Chrome), più lento rispetto agli scraper solo HTTP e per scalare serve hardware robusto o orchestrazione cloud.

7. Wget: il classico per download rapidi da riga di comando

è lo strumento storico da riga di comando per scaricare siti statici e file.

Perché Wget?

- Semplicità: Scarica interi siti o directory con un solo comando—senza bisogno di programmare.

- Velocità: Scritto in C, è rapido ed efficiente.

- Ideale per contenuti statici: Perfetto per siti di documentazione, blog o download massivi di file ().

Limiti: Non esegue JavaScript né gestisce form, e scarica pagine grezze (non dati strutturati). Pensalo come un aspirapolvere digitale per siti statici.

8. HTTrack: il migliore per navigazione offline (senza codice)

è la versione user-friendly di Wget, con interfaccia grafica per copiare siti web.

Perché HTTrack?

- Semplicità GUI: Wizard passo-passo, accessibile anche a chi non ha competenze tecniche.

- Navigazione offline: Modifica i link per permettere la consultazione locale dei siti copiati.

- Ottimo per archiviazione: Ideale per ricercatori, marketer o chiunque voglia uno snapshot di un sito senza programmare ().

Limiti: Non supporta contenuti dinamici, può essere lento su siti grandi e non è pensato per estrazione di dati strutturati.

9. StormCrawler: il top per crawling distribuito in tempo reale

è il crawler distribuito e moderno per chi ha bisogno di dati web in tempo reale e su larga scala.

Perché StormCrawler?

- Crawling in tempo reale: Basato su Apache Storm, elabora i dati come stream—perfetto per monitoraggio news o motori di ricerca ().

- Modulare e scalabile: Puoi aggiungere parsing, indicizzazione e moduli personalizzati secondo necessità.

- Usato da Common Crawl: Alimenta il dataset news di uno dei più grandi archivi web pubblici.

Limiti: Richiede sviluppo Java e un cluster Storm, quindi è adatto a team con esperienza in sistemi distribuiti. Troppo complesso per progetti piccoli.

Confronto tra alternative open-source a Firecrawl: quale strumento gratuito fa per te?

Ecco una panoramica comparativa dei 9 strumenti:

| Strumento | Caso d’uso ideale | Vantaggi principali | Svantaggi | Linguaggio / Setup |

|---|---|---|---|---|

| Scrapy | Crawling frequente su larga scala | Potente, scalabile, grande community | Curva di apprendimento, richiede Python | Framework Python |

| Apache Nutch | Crawling enterprise su scala web | Basato su Hadoop, testato su larga scala | Setup complesso, orientato batch | Java/Hadoop |

| Heritrix | Archiviazione, crawling per compliance | Cattura completa, output WARC | Pesante, no JS, archivi grezzi | App Java, web UI |

| Colly | Dev Go, scraping ad alte prestazioni | Veloce, API semplice, concorrenza | No JS, richiede Go | Libreria Go |

| MechanicalSoup | Automazione form, scraping con login | Leggero, gestisce sessioni | No JS, scala limitata | Libreria Python |

| Puppeteer | Siti dinamici/ricchi di JS | Controllo browser completo, automazione | Richiede risorse, serve Node.js | Libreria Node.js |

| Wget | Download siti statici, accesso offline | Semplice, veloce, CLI | No JS, pagine grezze | Tool da riga di comando |

| HTTrack | Utenti non tecnici, archiviazione siti | GUI, navigazione offline facile | No JS, lento su siti grandi | App desktop (GUI) |

| StormCrawler | Crawling distribuito in tempo reale | Scalabile, modulare, real-time | Richiede Java/Storm | Cluster Java/Storm |

Meglio costruire da zero o usare un’alternativa open-source a Firecrawl?

La verità è che sviluppare un crawler da zero può sembrare stimolante—finché non ti ritrovi a gestire manutenzione, proxy e sistemi anti-bot. Gli strumenti open-source sopra racchiudono anni di esperienza e soluzioni collaudate. Secondo i report di settore, affidarsi a soluzioni esistenti è il modo più rapido e affidabile per ottenere risultati senza reinventare la ruota ().

- Scegli open-source se: Le tue esigenze sono coperte dagli strumenti disponibili, vuoi ridurre i tempi di sviluppo e apprezzi il supporto della community.

- Costruisci da zero se: Hai necessità davvero uniche, un team esperto e lo scraping è centrale per il tuo business.

Tieni però presente che open-source non significa “gratis” se consideri il tempo degli sviluppatori, la manutenzione dei server e gli aggiornamenti continui per aggirare le protezioni anti-scraping. Se vuoi la potenza di un crawler senza scrivere codice, c’è un’altra opzione.

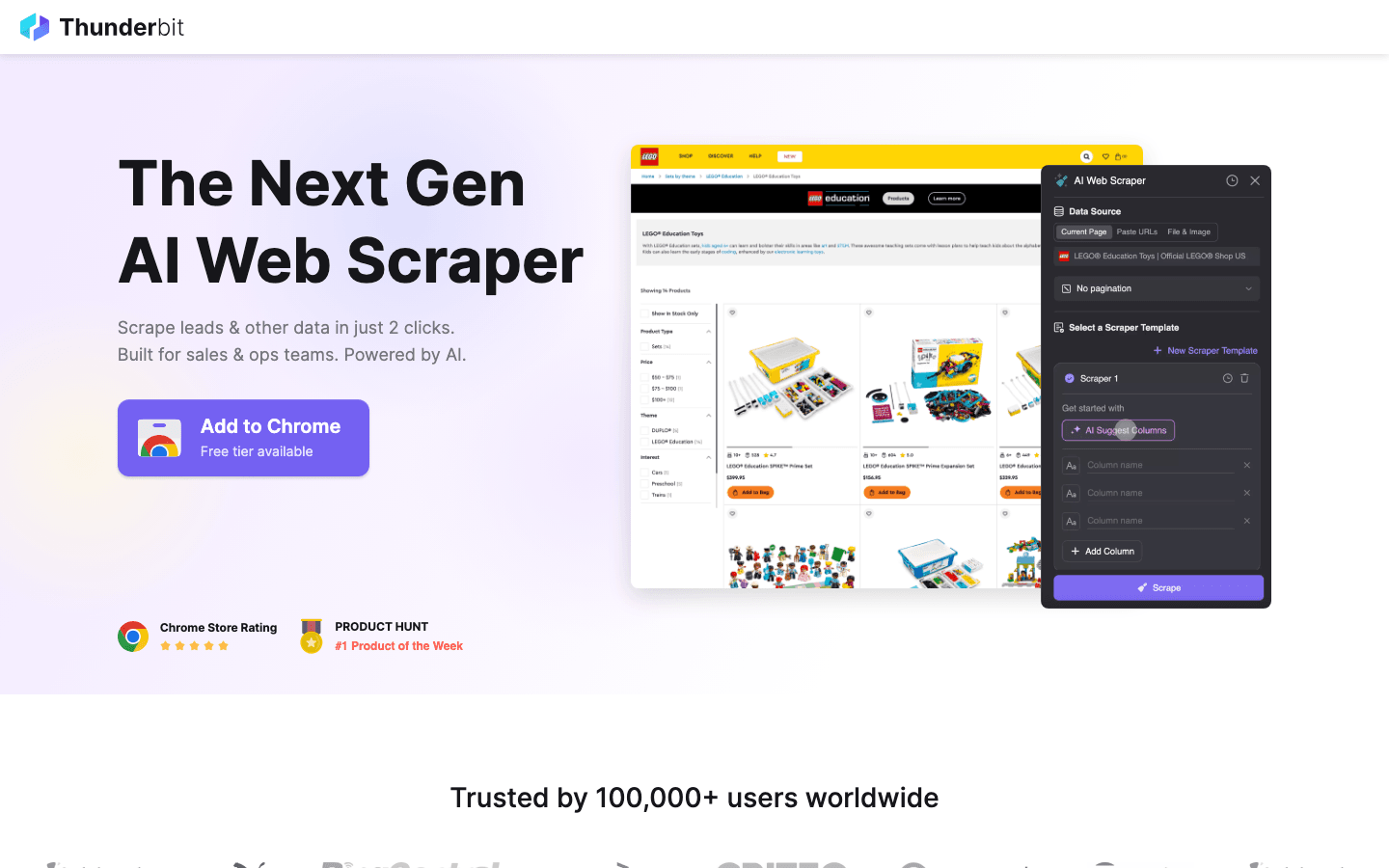

Bonus: se l’open-source è troppo complesso, prova Thunderbit

Gli strumenti elencati sopra sono eccezionali per sviluppatori, ma hanno limiti comuni: richiedono competenze di programmazione, faticano con anti-bot avanzati e necessitano di manutenzione costante.

è la mia raccomandazione per chi vuole superare questi ostacoli. Unisce potenza e semplicità d’uso.

Perché scegliere Thunderbit invece dell’open-source?

- Nessuna programmazione richiesta: A differenza di Scrapy o Puppeteer, Thunderbit è un’estensione Chrome con IA. Basta cliccare su “AI Suggerisci Campi” e lo scraper viene creato per te.

- Gestisce le parti difficili: Contenuti dinamici, infinite scroll e paginazione sono gestiti automaticamente dall’IA, risparmiando ore di scripting.

- Esportazione immediata: Da sito web a Excel, Google Sheets o Notion in pochi click.

- Zero manutenzione: Non devi aggiornare il codice quando il sito cambia—l’IA di Thunderbit si adatta da sola.

Se sei un commerciale, un marketer o un ricercatore che ha bisogno di dati subito senza imparare Python o Go, Thunderbit è il complemento perfetto agli strumenti open-source di questa lista.

Vuoi vederlo in azione? e provala subito.

Conclusione: trova il crawler web self-hosted giusto per il 2026

Il panorama delle alternativa open-source a Firecrawl non è mai stato così ricco. Che tu abbia bisogno della potenza di Scrapy o Nutch, o della precisione archivistica di Heritrix, esiste una soluzione per ogni esigenza aziendale. La chiave è scegliere lo strumento giusto per il tuo caso—non complicarti la vita se ti serve solo una raccolta rapida di dati, e non risparmiare se devi operare su scala internet.

E ricorda: se la strada open-source si rivela troppo tecnica o impegnativa, strumenti AI come Thunderbit sono pronti a semplificarti il lavoro.

Pronto a iniziare? Metti in funzione Scrapy per il tuo prossimo progetto di data mining, oppure per uno scraping semplice e potenziato dall’IA. Se vuoi altri consigli sul web scraping, visita il per approfondimenti e tutorial.

Domande frequenti

1. Qual è il principale vantaggio delle alternative open-source a Firecrawl? Le soluzioni open-source offrono flessibilità, risparmio sui costi e la possibilità di ospitare e personalizzare il tuo Estrattore Web. Eviti il lock-in del fornitore e puoi contare su una community attiva e aggiornamenti costanti.

2. Quale strumento è più adatto a chi non ha competenze tecniche e vuole risultati rapidi? è una scelta open-source valida per la navigazione offline. Tuttavia, per estrarre dati strutturati (come tabelle Excel), consigliamo lo strumento bonus grazie alle sue funzionalità AI.

3. Come gestire siti dinamici e ricchi di JavaScript? è la soluzione ideale: controlla un vero browser e può estrarre qualsiasi contenuto visibile all’utente, incluse SPA e dati caricati via AJAX.

4. Quando conviene usare un crawler avanzato come Apache Nutch o StormCrawler? Se devi scandagliare milioni di pagine su molti domini, o hai bisogno di crawling distribuito in tempo reale (ad esempio per motori di ricerca o monitoraggio news), questi strumenti sono pensati per la massima affidabilità e scalabilità.

5. È meglio costruire un crawler da zero o usare una soluzione open-source esistente? Per la maggior parte dei team, utilizzare e personalizzare uno strumento open-source esistente è più veloce, economico e affidabile. Sviluppa da zero solo se hai esigenze molto specifiche e risorse per la manutenzione a lungo termine.

Buon crawling—che i tuoi dati siano sempre freschi, strutturati e pronti all’uso.

Scopri di più