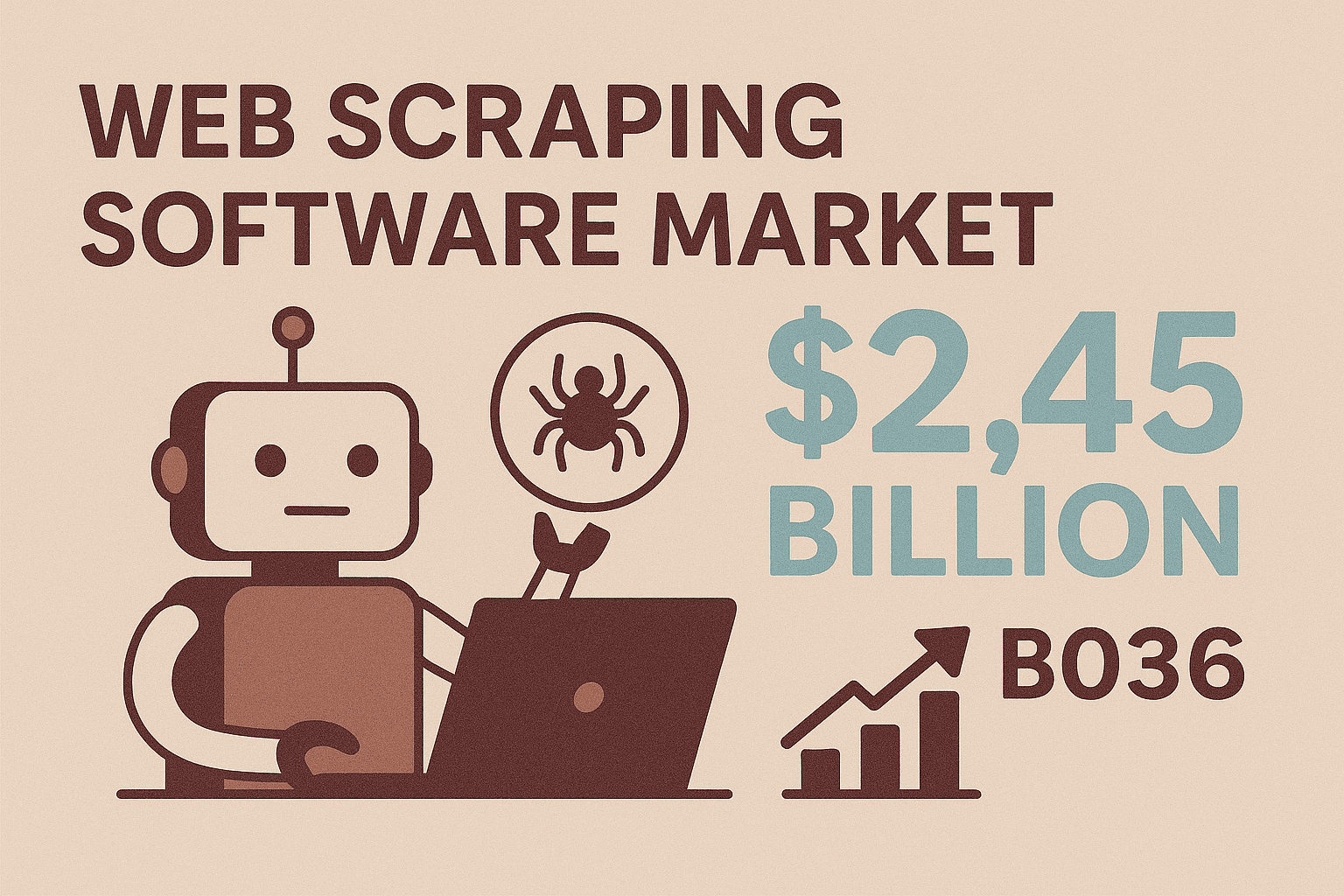

C’è qualcosa di davvero appagante nel vedere uno script che scorre a tutta velocità su un sito, raccogliendo dati mentre tu ti rilassi con un caffè. I tempi in cui lo "screen scraping" significava ore di copia-incolla o continue richieste all’IT per esportazioni extra sono ormai un ricordo. Oggi, lo screen scraping Java è il motore dietro attività come la generazione di lead, il monitoraggio prezzi in tempo reale e molto altro, e non è più una skill riservata solo ai super-sviluppatori. Considerando che il mercato dei software per il web scraping è destinato a toccare i , è chiaro che le aziende puntano su soluzioni automatizzate e flessibili per trasformare il web in dati utili.

Se sei un professionista, un commerciale o uno sviluppatore che vuole estrarre dati strutturati da siti web—soprattutto quelli senza API—lo screen scraping Java è una skill che fa la differenza. In questa guida ti spiego le basi, come partire con le librerie Java più usate, come affrontare le sfide più comuni e come strumenti no-code come possono darti una marcia in più. Che tu voglia costruire uno scraper da zero o sfruttare l’AI per automatizzare tutto, qui trovi consigli pratici e strategie concrete per lavorare in modo più smart, non più duro.

Se sei un professionista, un commerciale o uno sviluppatore che vuole estrarre dati strutturati da siti web—soprattutto quelli senza API—lo screen scraping Java è una skill che fa la differenza. In questa guida ti spiego le basi, come partire con le librerie Java più usate, come affrontare le sfide più comuni e come strumenti no-code come possono darti una marcia in più. Che tu voglia costruire uno scraper da zero o sfruttare l’AI per automatizzare tutto, qui trovi consigli pratici e strategie concrete per lavorare in modo più smart, non più duro.

Fondamenti dello Screen Scraping Java: cos’è e perché conta

Partiamo dalle basi. Screen scraping Java vuol dire usare codice Java per estrarre in automatico informazioni dai siti web—automatizzando la lettura delle pagine e l’estrazione dei dati che ti servono. Diversamente dalle API, che ti danno dati già belli pronti (quando ci sono), lo screen scraping lavora direttamente sulla parte visibile del sito, proprio come faresti tu su Chrome o Firefox.

Perché è importante? Perché la maggior parte dei siti—soprattutto in settori come e-commerce, immobiliare o directory B2B di nicchia—non offre API pubbliche o strumenti di esportazione massiva. Lo screen scraping è la chiave per accedere a questi dati “bloccati”. Con Java hai un arsenale flessibile: puoi scrivere regole su misura, gestire login, cliccare pulsanti e persino analizzare contenuti dinamici e complessi. Ecco perché lo screen scraping Java è la scelta giusta quando gli strumenti standard non bastano o quando serve una logica di estrazione personalizzata.

E la richiesta è in crescita. Le aziende che adottano strumenti moderni di scraping (soprattutto quelli AI-based) riportano nelle attività di estrazione dati, con tassi di accuratezza che sfiorano il 99%. Un bel salto rispetto alla raccolta manuale.

Applicazioni business top dello screen scraping Java

Dove brilla davvero lo screen scraping Java? Ecco alcuni degli usi più strategici in azienda:

| Applicazione | Valore per il business | Scenario d’uso |

|---|---|---|

| Generazione Lead | Automatizza la raccolta di contatti, amplia il funnel di vendita, risparmia tempo | Estrai nomi, ruoli, email, telefoni da LinkedIn o directory online |

| Monitoraggio Prezzi | Tieni traccia dei prezzi dei concorrenti in tempo reale, abilita prezzi dinamici | Analizza siti e-commerce per aggiornamenti quotidiani di prezzi e disponibilità |

| Estrazione Dati Prodotto | Aggrega annunci da più fonti, aggiorna i cataloghi | Raccogli nomi, specifiche, immagini, recensioni da siti di fornitori o rivali |

| Ricerca di Mercato | Raccogli grandi volumi di dati in tempo reale per analisi | Estrai centinaia di recensioni o annunci immobiliari per analisi di tendenza |

| Analisi Competitiva | Individua trend, monitora nuove funzionalità, analizza il sentiment | Aggrega pagine prodotto dei concorrenti, recensioni clienti o menzioni stampa |

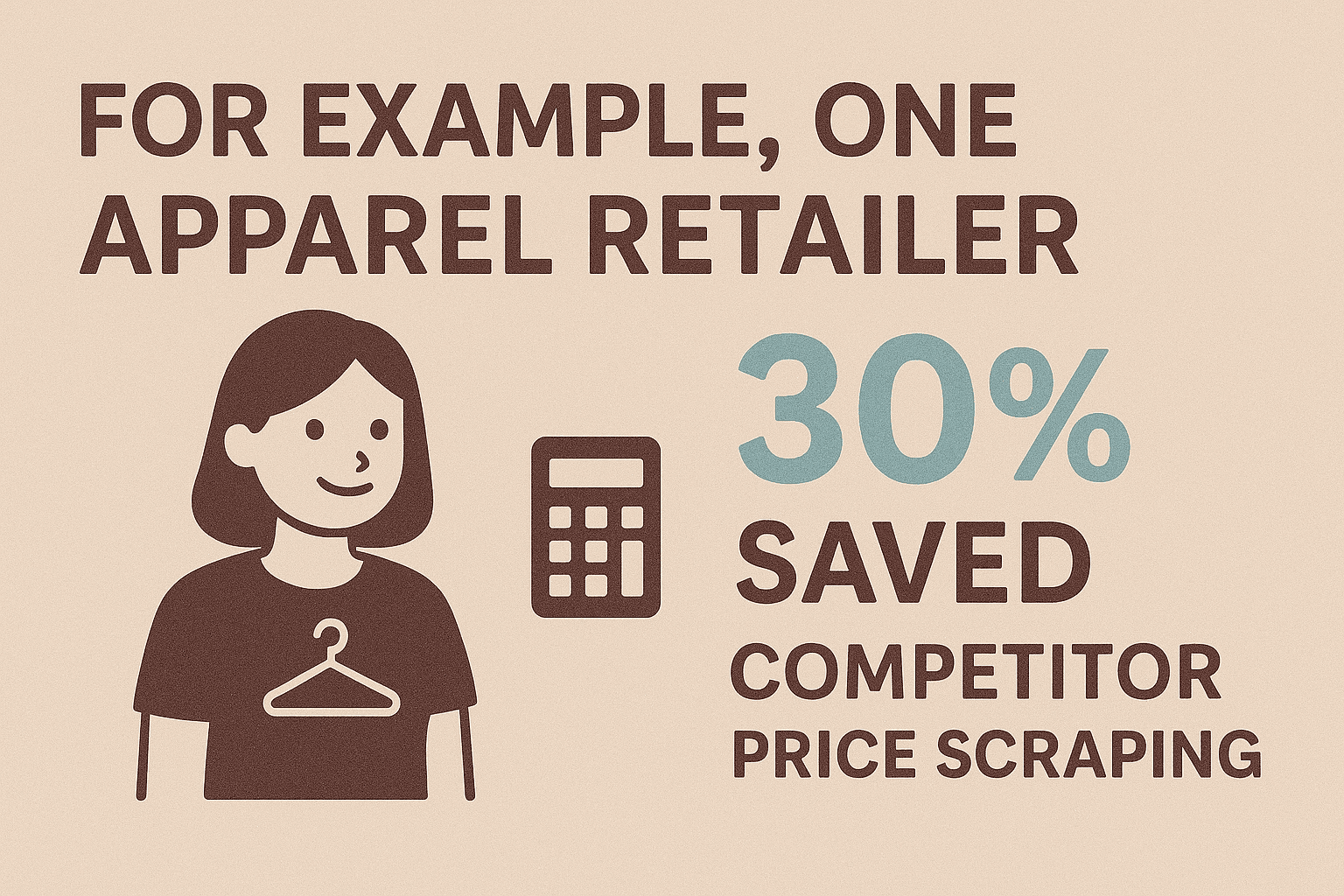

Per esempio, un retailer di moda che ha automatizzato il monitoraggio prezzi dei concorrenti e ottenuto insight sui prezzi in tempo reale. I team commerciali usano lo scraping per creare liste di lead che manualmente richiederebbero settimane. E con oltre , chi lavora nell’e-commerce si affida allo scraping per restare competitivo.

In breve: se ti servono dati dal web e non esiste un’API, lo screen scraping è spesso l’unica strada davvero praticabile.

In breve: se ti servono dati dal web e non esiste un’API, lo screen scraping è spesso l’unica strada davvero praticabile.

Come iniziare: strumenti e librerie must-have per lo screen scraping Java

L’ecosistema Java offre tante librerie che rendono lo screen scraping accessibile anche a chi non è sviluppatore full-time. Ecco le più gettonate:

1. Selenium WebDriver

- Cosa fa: Automatizza un browser vero (Chrome, Firefox) per interagire con siti dinamici e pieni di JavaScript.

- Ideale per: Siti che richiedono login, clic o simulazione del comportamento utente.

- Punti forti: Gestisce tutto ciò che vede l’utente; perfetto per flussi complessi.

- Limiti: Più lento e pesante; serve il driver del browser.

Esempio di codice:

1WebDriver driver = new ChromeDriver();

2driver.get("https://example.com/page");

3String title = driver.getTitle();

4System.out.println("Page title: " + title);

5driver.close();2. Jsoup

- Cosa fa: Scarica e analizza HTML statico con un’API semplice, simile a jQuery.

- Ideale per: Scraping veloce di pagine statiche, blog, news o elenchi prodotti.

- Punti forti: Leggero, veloce, facilissimo da usare, gestisce HTML anche sporco.

- Limiti: Non esegue JavaScript né gestisce contenuti caricati via AJAX.

Esempio di codice:

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements names = doc.select(".product-name");

3for (Element name : names) {

4 System.out.println(name.text());

5}3. HtmlUnit

- Cosa fa: Simula un browser headless in Java, esegue parte del JavaScript.

- Ideale per: Siti moderatamente dinamici dove serve comportamento da browser senza il peso di Selenium.

- Punti forti: Non richiede browser esterni; gestisce richieste HTTP, cookie e script semplici.

- Limiti: Meno robusto di Selenium con framework JS moderni.

Esempio di codice:

1WebClient webClient = new WebClient(BrowserVersion.CHROME);

2HtmlPage page = webClient.getPage("https://example.com");

3DomElement button = page.getElementById("next-btn");

4page = button.click();

5String content = page.asText();4. Altre librerie da tenere d’occhio

- WebMagic, Gecco: Framework avanzati per crawling ed estrazione su larga scala.

- Htmleasy: Super semplice, perfetto per prototipi rapidi e scraping di base.

Confronto tra le principali librerie Java per screen scraping

| Libreria | Supporto contenuti dinamici | Facilità d’uso | Caso d’uso ideale |

|---|---|---|---|

| Selenium | Sì | Media | Siti JS complessi, login, flussi interattivi |

| Jsoup | No | Facile | Pagine statiche, prototipazione veloce |

| HtmlUnit | Parziale | Media | Scraping leggero headless, JS semplice |

| Htmleasy | No | Molto facile | Siti statici semplici, estrazioni rapide |

| WebMagic/Gecco | No (JS) | Media | Crawling su larga scala, estrazione multi-pagina |

Checklist per partire subito:

- Scegli la libreria (Selenium per siti dinamici, Jsoup per pagine statiche).

- Prepara il progetto Java (aggiungi le dipendenze con Maven/Gradle).

- Analizza l’HTML del sito target con gli strumenti sviluppatore del browser.

- Scrivi uno scraper di prova per estrarre e stampare un elemento semplice.

- Sviluppa la logica di estrazione e gestisci la paginazione.

- Esporta i dati (CSV, JSON o direttamente su database).

Step by step: crea il tuo primo screen scraper Java

Facciamo un esempio pratico: estrarre nomi e prezzi dei prodotti da una pagina demo e-commerce usando Jsoup.

Passo 1: Configura il progetto

Aggiungi Jsoup al tuo pom.xml Maven:

1<dependency>

2 <groupId>org.jsoup</groupId>

3 <artifactId>jsoup</artifactId>

4 <version>1.16.1</version>

5</dependency>Passo 2: Scarica la pagina web

1String url = "https://www.scrapingcourse.com/ecommerce/";

2Document doc = Jsoup.connect(url).get();Passo 3: Analizza ed estrai i dati

1Elements productElements = doc.select("li.product");

2for (Element productEl : productElements) {

3 String name = productEl.selectFirst(".woocommerce-loop-product__title").text();

4 String price = productEl.selectFirst(".price").text();

5 System.out.println(name + " -> " + price);

6}Passo 4: Gestisci la paginazione

1Element nextLink = doc.selectFirst("a.next");

2while (nextLink != null) {

3 String nextUrl = nextLink.absUrl("href");

4 doc = Jsoup.connect(nextUrl).get();

5 // Ripeti la logica di estrazione

6 nextLink = doc.selectFirst("a.next");

7}Passo 5: Esporta i dati (esempio CSV)

1FileWriter csvWriter = new FileWriter("products.csv");

2csvWriter.append("Product Name,Price\n");

3for (Element productEl : productElements) {

4 String name = ...;

5 String price = ...;

6 csvWriter.append("\"" + name + "\",\"" + price + "\"\n");

7}

8csvWriter.flush();

9csvWriter.close();Oppure, per JSON:

1List<Product> products = new ArrayList<>();

2// popola la lista nel ciclo

3Gson gson = new Gson();

4String jsonOutput = gson.toJson(products);

5Files.write(Paths.get("products.json"), jsonOutput.getBytes());Gestione dell’output: JSON, CSV e altro

- CSV: Perfetto per Excel, analisi rapide o condivisione con chi non è tecnico.

- JSON: Ottimo per uso programmato, API o dati annidati.

- Excel: Usa Apache POI se ti servono file

.xlsxnativi. - Database: Inserisci direttamente via JDBC per archiviazione a lungo termine.

Scegli il formato che si adatta meglio al tuo flusso di lavoro. Per la maggior parte degli utenti business, CSV o Excel sono la scelta più pratica.

Come superare le sfide: problemi tipici nello screen scraping Java e soluzioni

Lo screen scraping non è sempre una passeggiata. Ecco i problemi più comuni—e come risolverli:

1. Contenuti dinamici (JavaScript/AJAX)

- Problema: I dati si caricano dopo il rendering; Jsoup non li vede.

- Soluzione: Usa Selenium WebDriver per controllare un browser vero, oppure individua le chiamate AJAX e replicale in Java.

2. Sistemi anti-bot

- Problema: I siti bloccano o rallentano le richieste automatiche.

- Soluzione: Rispetta i limiti di crawling, randomizza user agent, ruota gli IP e simula il comportamento umano. Per scraping intensivo, valuta proxy o plugin stealth per Selenium.

3. Cambiamenti nella struttura del sito

- Problema: Cambiamenti nell’HTML rompono i selettori.

- Soluzione: Centralizza i selettori nel codice, usa classi CSS robuste o attributi data, e registra gli errori per risolverli in fretta. Sii pronto ad aggiornare lo scraper quando serve.

4. Qualità e pulizia dei dati

- Problema: Formati incoerenti, valori mancanti o testo disordinato.

- Soluzione: Usa le funzioni di manipolazione stringhe e regex di Java per pulire i dati durante lo scraping. Normalizza i formati (es. numeri di telefono, prezzi) e gestisci i null in modo sicuro.

5. Prestazioni e scalabilità

- Problema: Lo scraping di migliaia di pagine è lento.

- Soluzione: Sfrutta la concorrenza di Java (ExecutorService, thread pool) per parallelizzare le richieste, ma senza sovraccaricare i siti target. Scrivi i risultati su file per evitare problemi di memoria.

Per altri consigli, dai un’occhiata alla .

Perché Thunderbit è il partner perfetto per lo screen scraping Java

Parliamo ora di un aspetto spesso sottovalutato: la manutenzione. Scrivere e aggiornare scraper Java può diventare un lavoro infinito—soprattutto quando i siti cambiano struttura o aggiungono barriere anti-bot. Qui entra in gioco .

Thunderbit è un’estensione Chrome per lo scraping web AI senza codice, pensata per utenti business, team commerciali, marketer e chiunque voglia automatizzare la raccolta dati online—senza scrivere una riga di codice. Ecco perché è rivoluzionaria sia per chi sviluppa in Java che per chi non programma:

- Rilevamento campi con AI: Clicca su “AI Suggerisci Campi” e l’AI di Thunderbit analizza la pagina, suggerendo subito le colonne migliori da estrarre (nomi prodotti, prezzi, email, ecc.).

- Scraping in 2 click: Un click per far trovare i dati all’AI, un altro per estrarli. Niente selettori o script da configurare.

- Scraping di sottopagine: Thunderbit può seguire i link (es. pagine dettaglio prodotto) e arricchire la tabella con info aggiuntive—senza codice manuale.

- Template istantanei: Per siti noti (Amazon, Zillow, Shopify), Thunderbit offre template già pronti per scraping strutturato immediato.

- Riconoscimento tipi di dati: Rileva email, numeri di telefono, date, immagini e altro—esportando dati puliti e subito utilizzabili.

- Accessibilità no-code: Chiunque nel team può usarlo, liberando gli sviluppatori per attività a maggior valore.

- Zero manutenzione: Se il sito cambia, basta cliccare di nuovo su “AI Suggerisci Campi”—l’AI di Thunderbit si adatta da sola.

Thunderbit è perfetto per progetti rapidi, prototipi o per integrare il tuo flusso Java quando serve ottenere dati al volo senza perdere tempo in debug o sviluppo.

Integrare Thunderbit con Java: crea una pipeline dati completa

La vera forza arriva quando unisci la semplicità di Thunderbit con la flessibilità di Java. Ecco come costruire una pipeline dati end-to-end:

- Scraping con Thunderbit: Usa Thunderbit per estrarre dati dal sito target. Puoi programmare scraping ricorrenti o usare template istantanei per i siti più comuni.

- Esporta i dati: Salva i risultati in CSV, Excel, , Airtable o Notion—formati che Java può leggere facilmente.

- Elabora con Java: Scrivi un’app Java che recupera i dati esportati (ad esempio tramite API di Google Sheets o leggendo il CSV), li pulisce o arricchisce e li integra nei tuoi sistemi (CRM, database, analytics).

- Automatizza il flusso: Pianifica Thunderbit per eseguire scraping a intervalli regolari e avvia lo script Java dopo ogni estrazione. Così la pipeline dati va avanti da sola.

Esempio: Il tuo team commerciale vuole una lista aggiornata di lead da una directory ogni lunedì. Thunderbit estrae i dati e li esporta su Google Sheets. L’app Java legge il foglio, elimina i duplicati e importa i nuovi contatti nel CRM. Se il sito cambia struttura, basta aggiornare la configurazione di Thunderbit—senza dover riscrivere codice Java.

Questo approccio ibrido ti dà il meglio di entrambi i mondi: Thunderbit gestisce la complessità e la variabilità del web, Java si occupa della logica di business e dell’integrazione.

Consigli avanzati: scalare e automatizzare lo screen scraping Java

Quando le esigenze crescono, puoi portare tutto a un altro livello:

- Parallelizzazione: Usa i thread pool di Java per estrarre dati da più pagine in parallelo, ma limita la concorrenza per non farti bloccare.

- Schedulazione: Automatizza lo scraping con la libreria Quartz di Java o sfrutta il pianificatore integrato di Thunderbit (basta scrivere la frequenza in linguaggio naturale).

- Gestione errori: Implementa retry, timeout e notifiche (email o Slack) per i run falliti.

- Cloud scraping: La modalità cloud di Thunderbit può estrarre dati da 50 pagine alla volta—perfetta per grandi volumi senza stressare il PC.

- Manutenzione: Documenta gli scraper, centralizza i selettori e registra le anomalie per risolvere tutto in fretta. Con Thunderbit, spesso basta un click su “AI Suggerisci Campi” per aggiornare tutto.

Per volumi enormi (milioni di pagine), valuta framework distribuiti come Apache Nutch o API di scraping cloud—ma per la maggior parte dei casi aziendali, la combo Thunderbit + Java è più che sufficiente e molto meno impegnativa.

Conclusioni e takeaway

Lo screen scraping Java è uno strumento potentissimo per accedere ai dati web—che tu debba creare liste di lead, monitorare la concorrenza o alimentare ricerche di mercato. Ecco cosa portare a casa:

- Java ti dà flessibilità e controllo per scraping personalizzati e complessi—perfetto per login, contenuti dinamici o logiche di business particolari.

- Thunderbit porta semplicità e velocità grazie all’AI e al no-code, rendendo lo scraping accessibile a tutti e riducendo i tempi di setup da ore a minuti.

- Combinando entrambi puoi costruire pipeline dati robuste e veloci: estrai con Thunderbit, elabora e integra con Java.

- Automatizza e scala con parallelizzazione, schedulazione e cloud scraping—senza impazzire con la manutenzione.

- Il futuro è ibrido: Con strumenti AI come Thunderbit sempre più smart, i migliori scraper uniranno codice e no-code per la massima efficienza.

Pronto a portare la tua estrazione dati al livello successivo? , prova a creare il tuo primo scraper Java e scopri quanto tempo (e fatica) puoi risparmiare. Per altri consigli e approfondimenti, visita il .

Domande frequenti

1. Cos’è lo screen scraping Java e in cosa si differenzia dal web scraping?

Lo screen scraping Java consiste nell’uso di codice Java per estrarre dati direttamente dalla parte visibile di un sito (la pagina renderizzata), soprattutto quando non esistono API. È una forma di web scraping, ma il termine “screen scraping” sottolinea l’estrazione di ciò che vede l’utente, non di dati strutturati dal back-end.

2. Quando conviene usare Java per lo screen scraping invece di uno strumento no-code?

Usa Java quando hai bisogno di logica personalizzata, gestire login complessi, interagire con contenuti dinamici o integrare lo scraping nei sistemi aziendali. Gli strumenti no-code come Thunderbit sono ideali per attività rapide, prototipi o per dare autonomia agli utenti non tecnici.

3. Quali sono le sfide più comuni nello screen scraping Java e come risolverle?

I problemi più frequenti sono: contenuti dinamici (risolvi con Selenium), sistemi anti-bot (usa ritardi, proxy e header realistici), cambiamenti nella struttura del sito (centralizza i selettori), pulizia dati (usa le funzioni stringa e regex di Java). Per grandi volumi, sfrutta la concorrenza e una gestione errori robusta.

4. Come Thunderbit si integra con lo screen scraping Java?

L’estensione Chrome AI di Thunderbit rende facile estrarre dati da qualsiasi sito—senza codice. È perfetta per lavori rapidi, prototipi o per integrare il flusso Java quando vuoi risparmiare tempo o evitare problemi di manutenzione. Puoi esportare i dati in formati compatibili con Java, creando una pipeline senza interruzioni.

5. Posso automatizzare una pipeline dati completa con Thunderbit e Java?

Assolutamente! Pianifica scraping ricorrenti con Thunderbit, esporta i risultati su Google Sheets o CSV e usa un’app Java per recuperare, elaborare e integrare i dati. Questo approccio ibrido unisce la velocità e l’adattabilità di Thunderbit con la potenza e la flessibilità di Java.