Il web nel 2025 sembra davvero il selvaggio West: più della metà del traffico online non arriva da persone in carne e ossa. Sì, hai capito bene: oggi bot e crawler generano oltre il 50% di tutto il movimento su Internet (), e solo una piccola fetta di questi sono i "bot buoni" che vuoi davvero: motori di ricerca, anteprime social e strumenti di analisi. Tutti gli altri? Diciamo che spesso non giocano dalla tua parte. Dopo anni passati a sviluppare automazioni e AI in , ho visto quanto il crawler giusto (o quello sbagliato) possa cambiare la SEO, sballare le statistiche, consumare banda o addirittura creare problemi di sicurezza.

Se gestisci un sito, un business o semplicemente vuoi tenere d’occhio la tua presenza digitale, sapere chi sta bussando al tuo server è fondamentale. Ecco perché ho preparato questa guida aggiornata al 2025 sull’elenco dei crawler più importanti: cosa fanno, come riconoscerli e come lasciare entrare solo i bot utili, bloccando quelli dannosi.

Cosa rende un crawler "noto"? User-Agent, IP e controlli

Partiamo dalle basi: cosa si intende per "crawler noto"? In pratica, è un bot che si presenta sempre con uno user-agent riconoscibile (tipo Googlebot/2.1 o bingbot/2.0) e, idealmente, effettua le scansioni da IP pubblicati o blocchi ASN verificabili (). I grandi nomi come Google, Microsoft, Baidu, Yandex e DuckDuckGo pubblicano documentazione sui loro bot e spesso forniscono strumenti o file JSON con gli IP ufficiali (, , ).

Ma c’è un problema: fidarsi solo dello user-agent è rischioso. I bot malevoli spesso si fingono Googlebot o Bingbot per aggirare i controlli (). Per questo la regola d’oro è la doppia verifica: controlla sia lo user-agent che l’IP (o ASN), usando reverse DNS o le liste ufficiali. Se usi uno strumento come , puoi automatizzare tutto: estrai i log, confronta user-agent e incrocia gli IP per avere una lista aggiornata e affidabile di chi visita il tuo sito.

Come usare questo elenco dei crawler

A cosa serve, in concreto, una lista di crawler noti? Ecco come puoi sfruttarla al meglio:

- Allowlist: Assicurati che i bot che vuoi (motori di ricerca, anteprime social) non vengano mai bloccati da firewall, CDN o WAF. Usa i loro IP e user-agent ufficiali per una allowlist precisa.

- Filtraggio Analytics: Escludi il traffico dei bot dalle statistiche, così i dati riflettono solo i visitatori reali e non le scansioni di Googlebot o AhrefsBot ().

- Gestione Bot: Imposta regole di crawl-delay o limitazione per i tool SEO più aggressivi, e blocca o sfida i bot sconosciuti o sospetti.

- Analisi automatica dei log: Usa strumenti AI (come Thunderbit) per estrarre, classificare ed etichettare l’attività dei crawler nei log, così puoi individuare tendenze, scoprire impostori e aggiornare le policy.

Tenere aggiornata la lista dei crawler non è un lavoro da fare una volta sola. Ogni anno spuntano nuovi bot, altri cambiano comportamento e gli attacchi diventano sempre più sofisticati. Automatizzare gli aggiornamenti—ad esempio estraendo le liste ufficiali o i repository GitHub con Thunderbit—ti fa risparmiare tempo e grattacapi.

1. Thunderbit: identificazione crawler e gestione dati con l’AI

non è solo un Estrattore Web AI: è un vero assistente dati per chi vuole davvero capire e gestire il traffico dei crawler. Ecco perché è diverso dagli altri:

- Pre-elaborazione semantica: Prima di estrarre i dati, Thunderbit trasforma pagine web e log in contenuti strutturati in stile Markdown. Questo pre-processing "semantico" permette all’AI di capire davvero il contesto, i campi e la logica di ciò che legge. È una svolta su pagine complesse, dinamiche o piene di JavaScript (come Facebook Marketplace o thread di commenti lunghi) dove i classici Estrattore Web falliscono.

- Doppia verifica: Thunderbit raccoglie velocemente la documentazione ufficiale sugli IP dei crawler e le liste ASN, confrontandole con i log del tuo server. Il risultato? Una "allowlist di crawler affidabili" su cui puoi davvero contare, senza più controlli manuali.

- Estrazione automatica dei log: Basta fornire i log grezzi a Thunderbit: li trasforma in tabelle strutturate (Excel, Sheets, Airtable), etichettando visitatori frequenti, percorsi sospetti e bot noti. Da qui puoi inviare i risultati a WAF o CDN per blocchi, limitazioni o CAPTCHA automatici.

- Compliance e audit: L’estrazione semantica di Thunderbit mantiene una traccia chiara di chi ha avuto accesso, quando e come hai gestito la situazione. Un grande aiuto per GDPR, CCPA e altre normative.

Ho visto team ridurre dell’80% il tempo dedicato alla gestione dei crawler grazie a Thunderbit—finalmente sapendo quali bot aiutano, quali danneggiano e quali sono solo impostori.

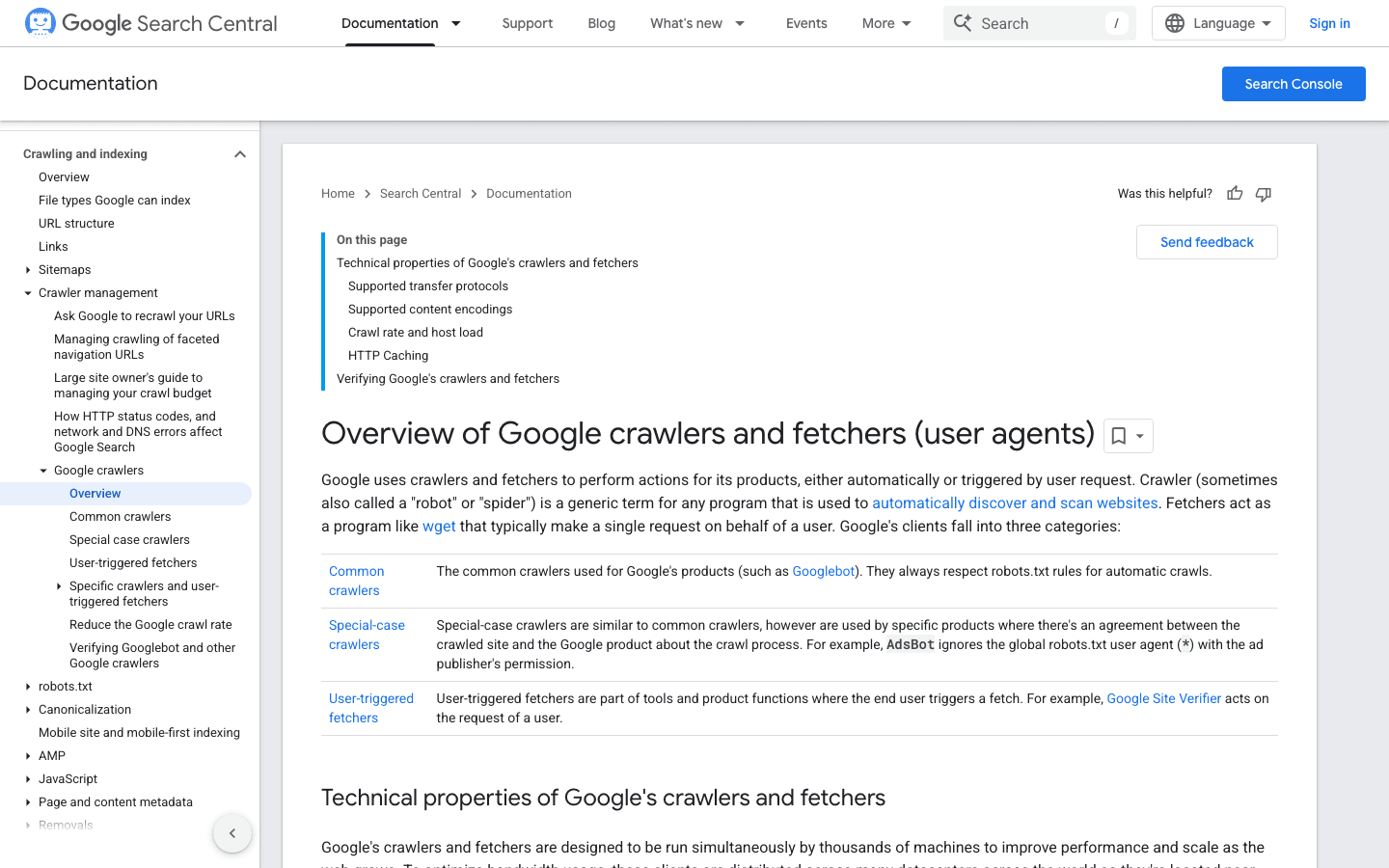

2. Googlebot: lo standard dei motori di ricerca

è il riferimento tra i crawler. Si occupa di indicizzare il tuo sito su Google: se lo blocchi, è come mettere il cartello "Chiuso" sulla tua vetrina digitale.

- User-Agent:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) - Verifica: Usa il o la .

- Consigli di gestione: Consenti sempre Googlebot. Usa robots.txt per guidare (non bloccare) la scansione e regola la frequenza tramite Google Search Console se serve.

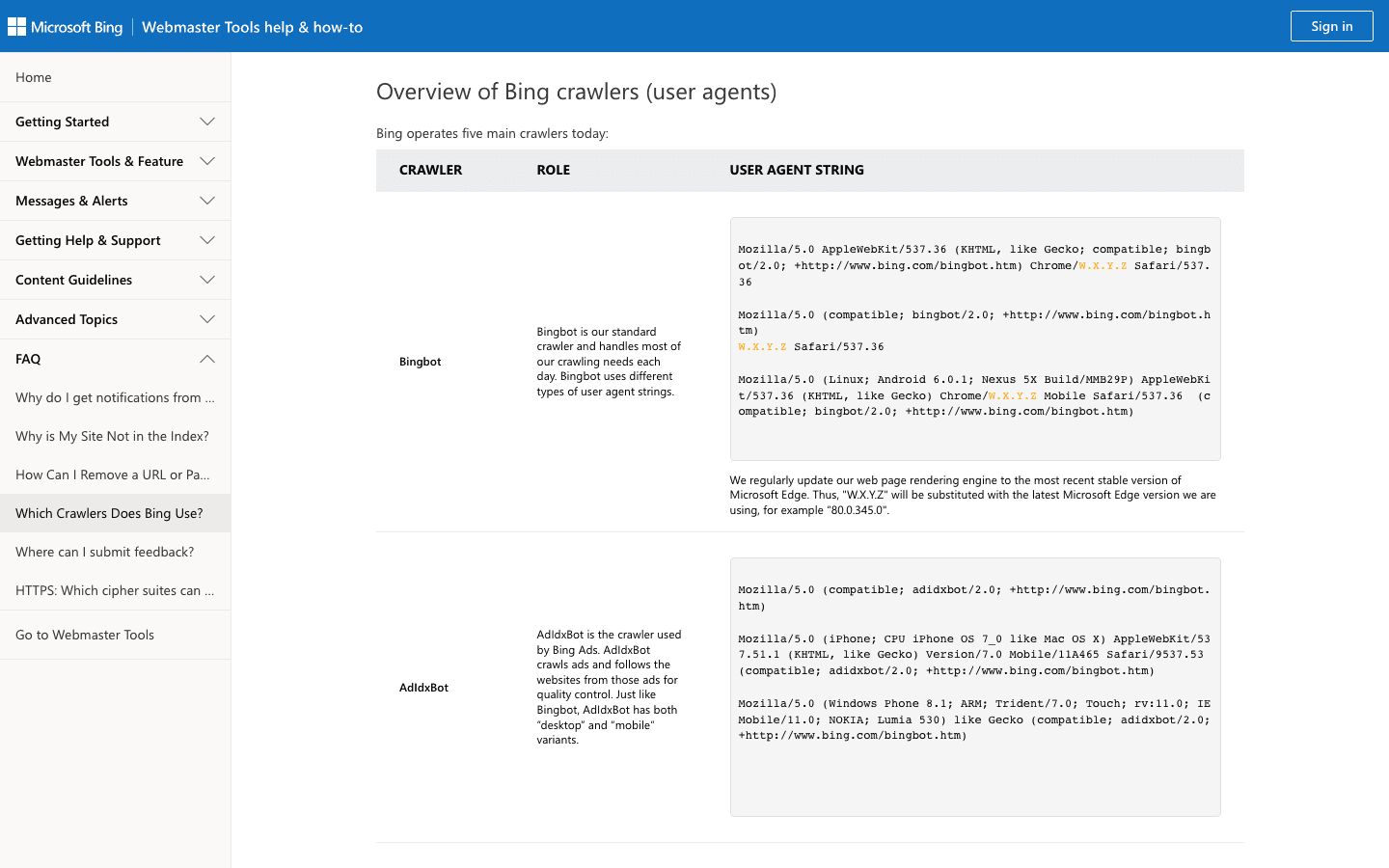

3. Bingbot: l’esploratore web di Microsoft

alimenta i risultati di Bing e Yahoo. È il secondo crawler più importante per la maggior parte dei siti.

- User-Agent:

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) - Verifica: Usa lo e la .

- Consigli di gestione: Consenti Bingbot, gestisci la frequenza tramite Bing Webmaster Tools e usa robots.txt per regolare la scansione.

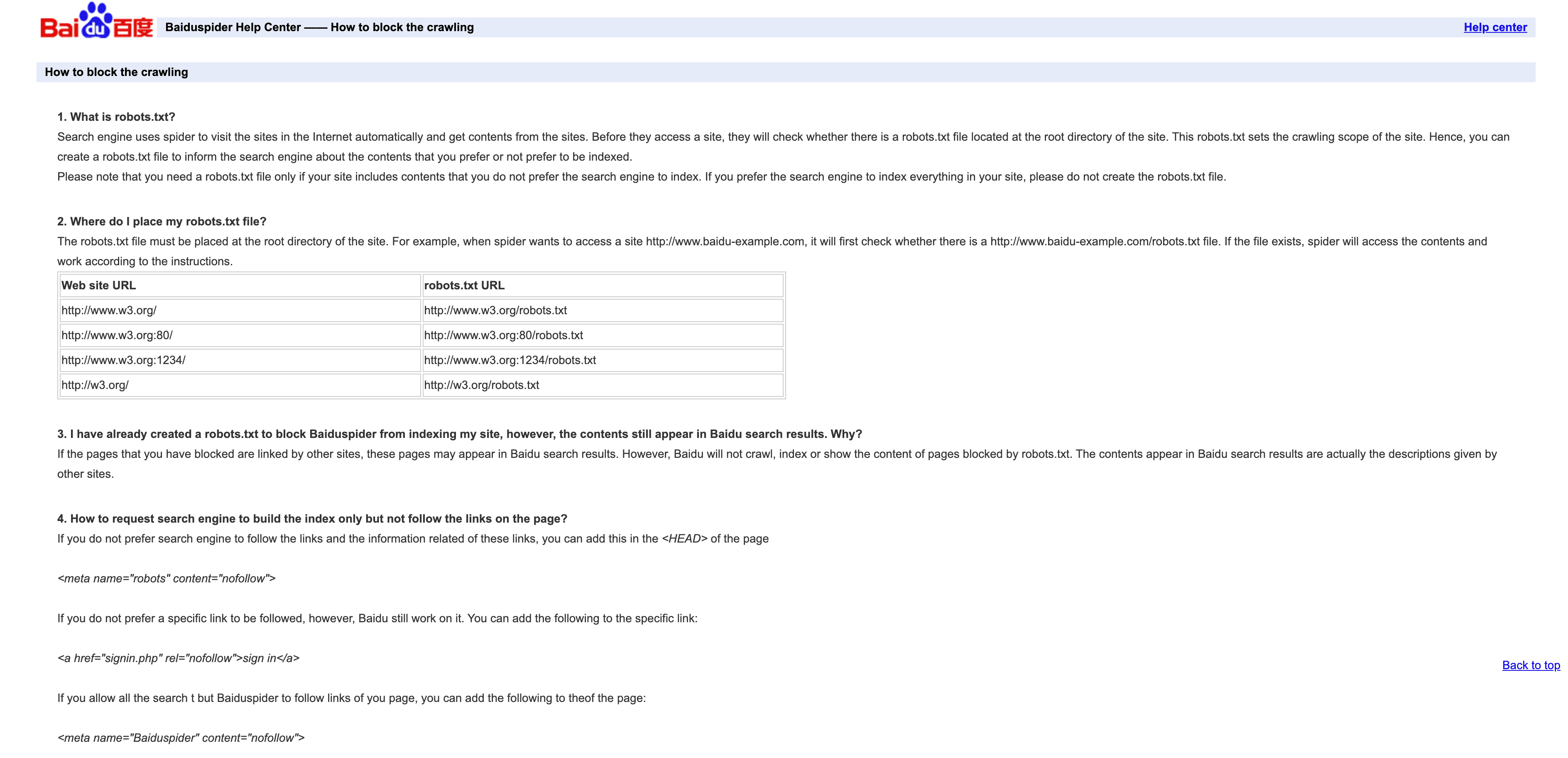

4. Baiduspider: il crawler leader in Cina

è la chiave per il traffico di ricerca cinese.

- User-Agent:

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) - Verifica: Nessuna lista IP ufficiale; controlla la presenza di

.baidu.comnel DNS inverso, ma attenzione ai limiti. - Consigli di gestione: Consenti se vuoi traffico dalla Cina. Usa robots.txt per le regole, ma Baiduspider a volte le ignora. Se non ti interessa la SEO cinese, valuta di limitare o bloccare per risparmiare banda.

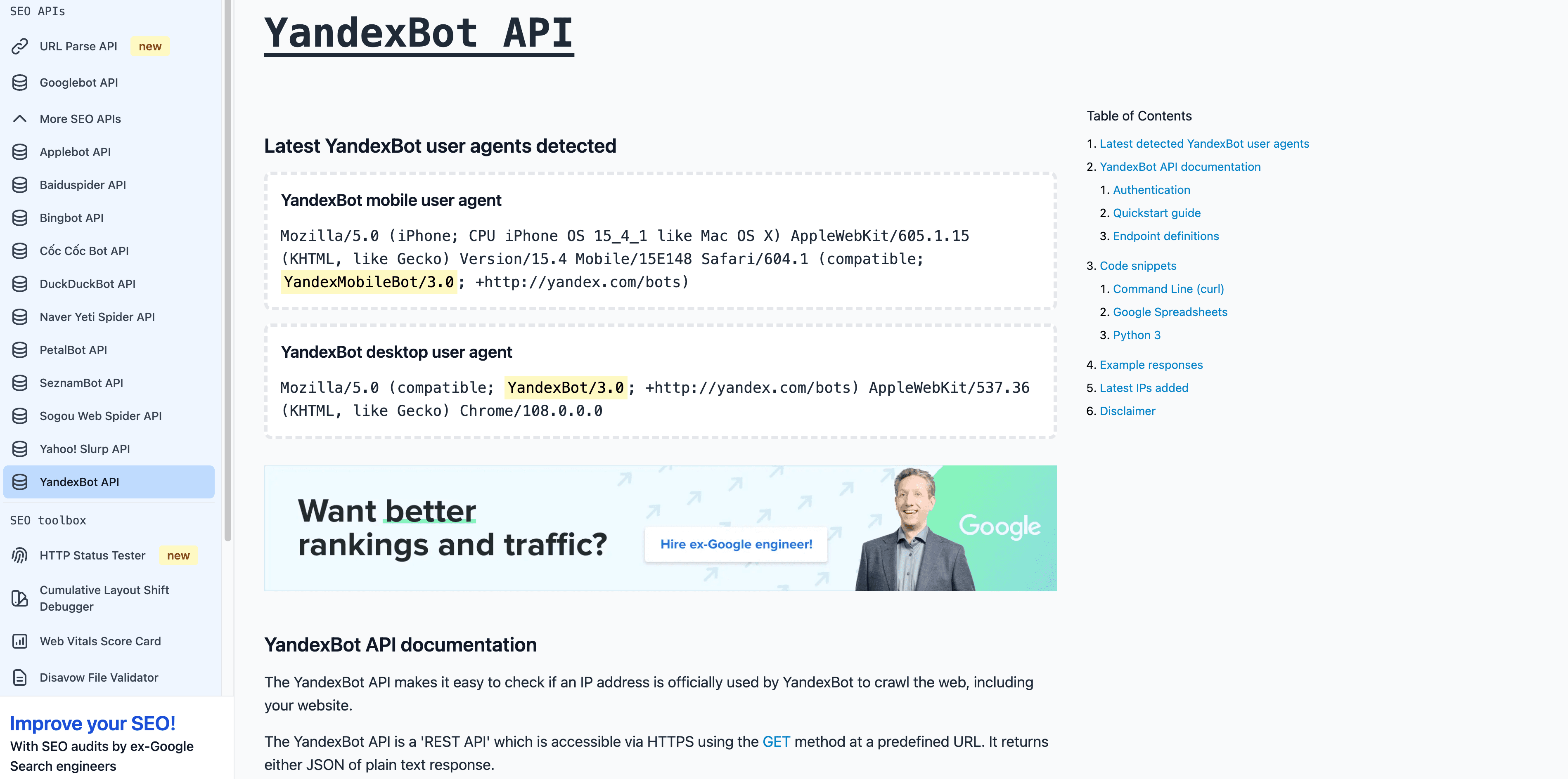

5. YandexBot: il crawler per la Russia

è fondamentale per i mercati russi e CIS.

- User-Agent:

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots) - Verifica: Il DNS inverso deve terminare con

.yandex.ru,.yandex.neto.yandex.com. - Consigli di gestione: Consenti se punti a utenti russofoni. Usa Yandex Webmaster per controllare la scansione.

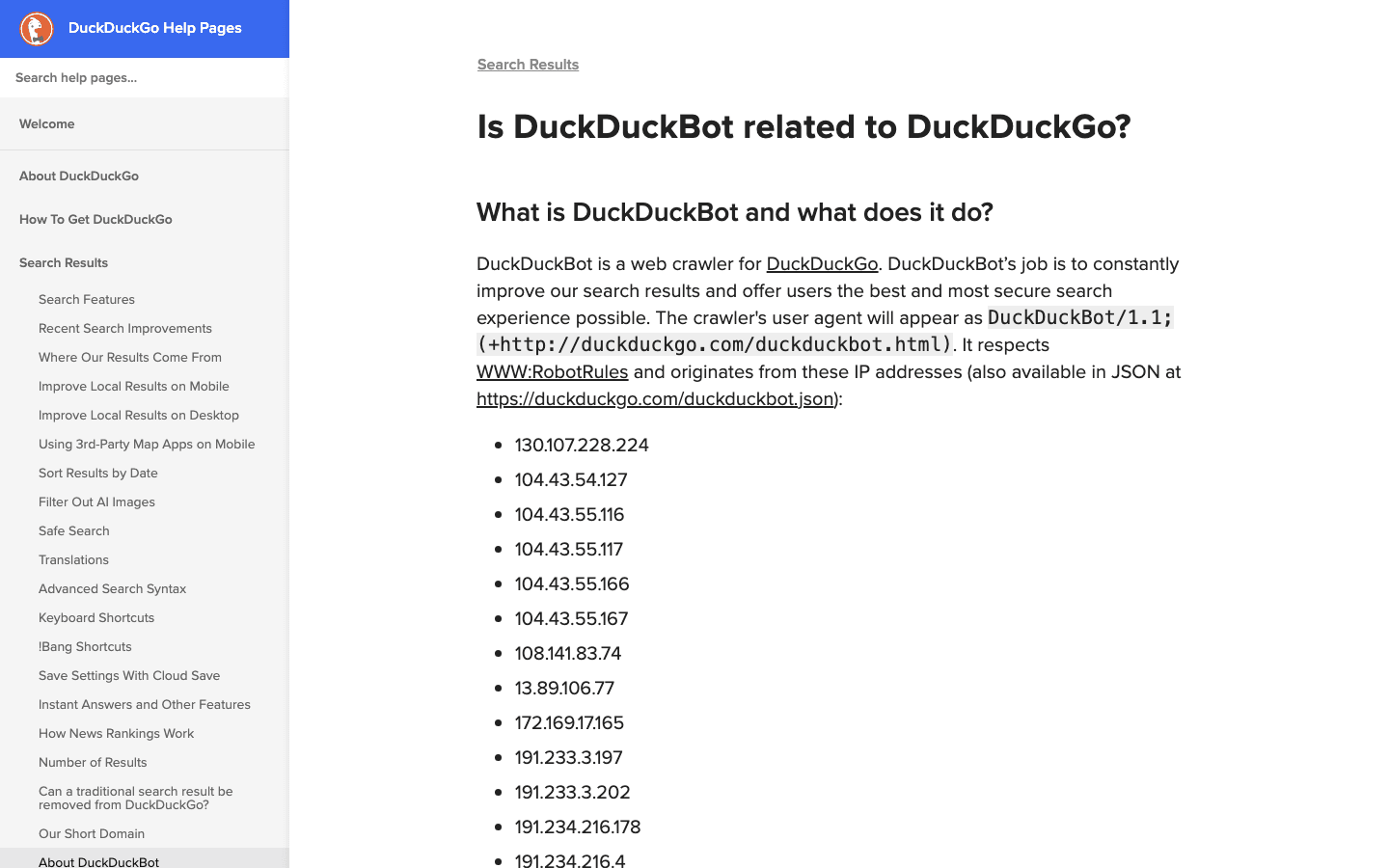

6. DuckDuckBot: il crawler per la privacy

alimenta la ricerca di DuckDuckGo, attenta alla privacy.

- User-Agent:

DuckDuckBot/1.1; (+http://duckduckgo.com/duckduckbot.html) - Verifica: .

- Consigli di gestione: Consenti, a meno che non ti interessi il pubblico attento alla privacy. Carico di scansione basso, facile da gestire.

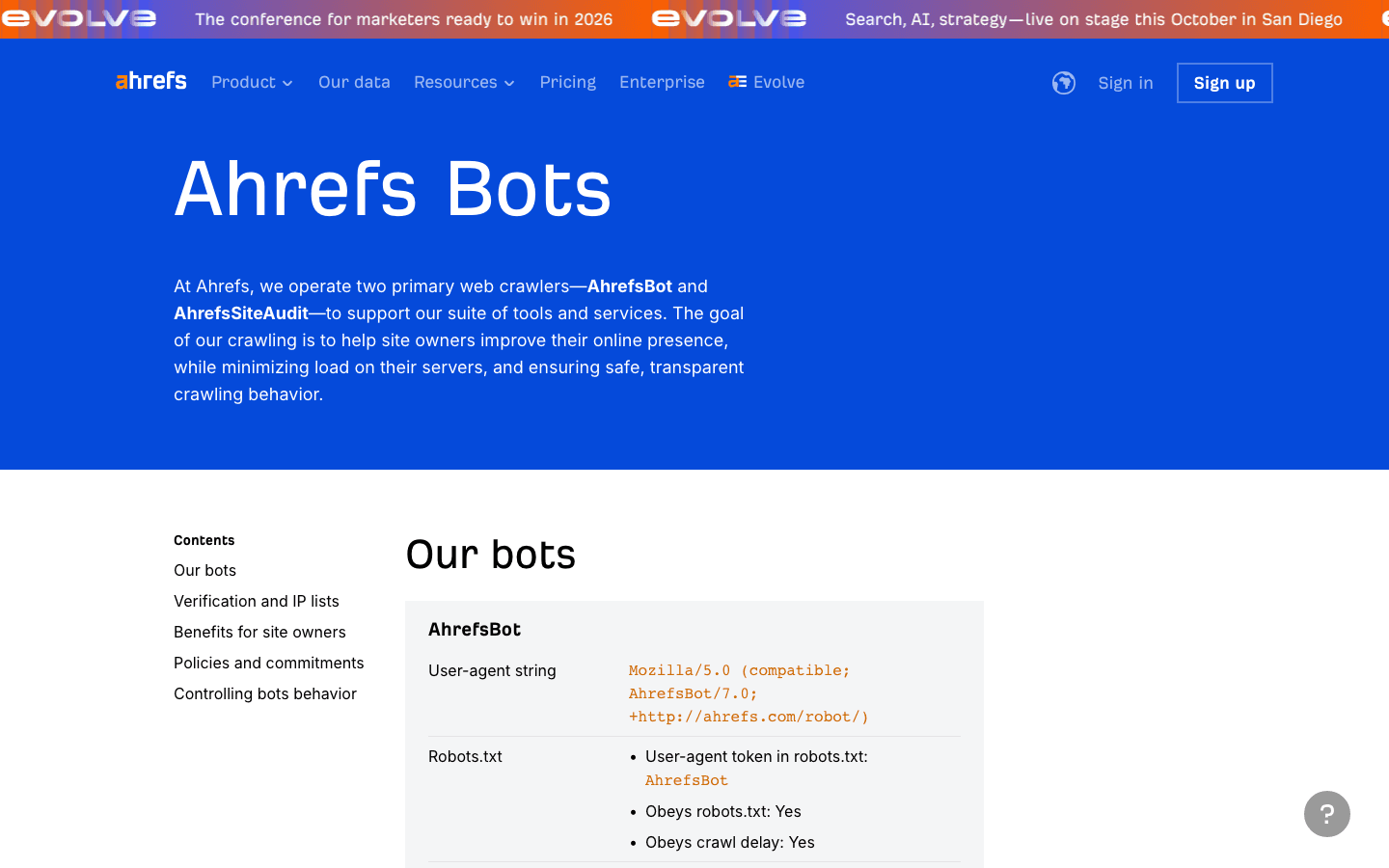

7. AhrefsBot: analisi SEO e backlink

è uno dei principali crawler SEO—ottimo per l’analisi dei backlink, ma può consumare molta banda.

- User-Agent:

Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/) - Verifica: Nessuna lista IP pubblica; verifica tramite UA e DNS inverso.

- Consigli di gestione: Consenti se usi Ahrefs. Usa robots.txt per limitare o bloccare. Puoi .

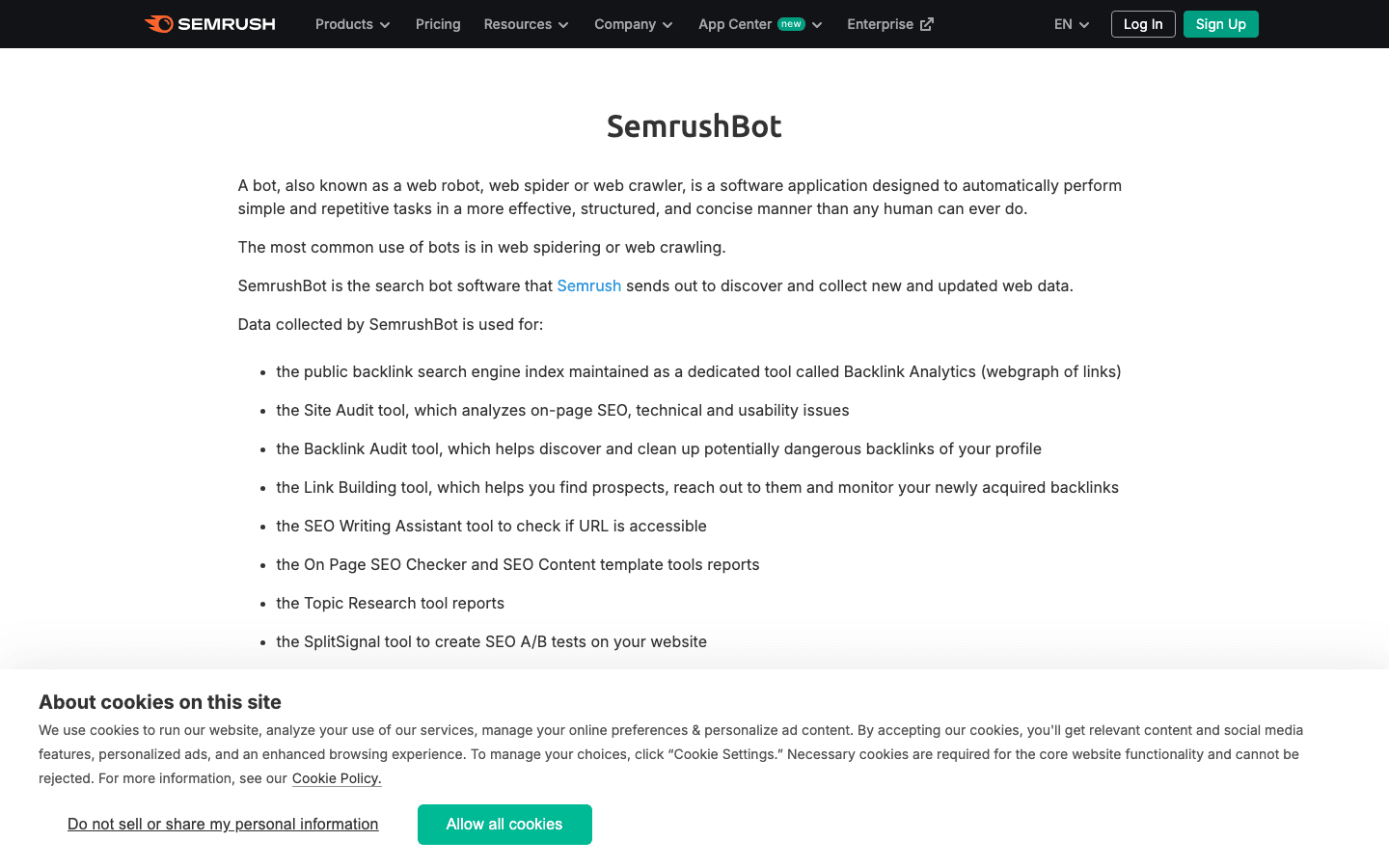

8. SemrushBot: analisi SEO competitiva

è un altro crawler SEO molto diffuso.

- User-Agent:

Mozilla/5.0 (compatible; SemrushBot/1.0; +http://www.semrush.com/bot.html)(e varianti comeSemrushBot-BA,SemrushBot-SI, ecc.) - Verifica: Solo tramite user-agent; nessuna lista IP pubblica.

- Consigli di gestione: Consenti se usi Semrush, altrimenti limita o blocca tramite robots.txt o regole server.

9. FacebookExternalHit: bot per anteprime social

recupera i dati Open Graph per le anteprime di Facebook e Instagram.

- User-Agent:

facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php) - Verifica: Tramite user-agent; gli IP appartengono all’ASN di Facebook.

- Consigli di gestione: Consenti per avere anteprime social ricche. Bloccare significa niente miniature o riassunti su Facebook/Instagram.

10. Twitterbot: crawler per anteprime su X (Twitter)

recupera i dati delle Twitter Card per X (Twitter).

- User-Agent:

Twitterbot/1.0 - Verifica: Tramite user-agent; ASN di Twitter (AS13414).

- Consigli di gestione: Consenti per le anteprime su Twitter. Usa i meta tag Twitter Card per risultati ottimali.

Tabella di confronto: panoramica dei principali crawler

| Crawler | Scopo | Esempio User-Agent | Metodo di verifica | Impatto sul business | Consigli di gestione |

|---|---|---|---|---|---|

| Thunderbit | Analisi log/crawler con AI | N/A (strumento, non bot) | N/A | Gestione dati, classificazione bot | Usa per estrazione log, creazione allowlist |

| Googlebot | Indicizzazione Google Search | Googlebot/2.1 | DNS & lista IP | Fondamentale per la SEO | Consenti sempre, gestisci da Search Console |

| Bingbot | Ricerca Bing/Yahoo | bingbot/2.0 | DNS & lista IP | Importante per SEO Bing/Yahoo | Consenti, gestisci da Bing Webmaster Tools |

| Baiduspider | Ricerca Baidu (Cina) | Baiduspider/2.0 | DNS inverso, UA | Chiave per SEO in Cina | Consenti se punti alla Cina, monitora banda |

| YandexBot | Ricerca Yandex (Russia) | YandexBot/3.0 | DNS inverso su .yandex.ru | Chiave per Russia/Est Europa | Consenti se target RU/CIS, usa strumenti Yandex |

| DuckDuckBot | Ricerca DuckDuckGo | DuckDuckBot/1.1 | Lista IP ufficiale | Pubblico attento alla privacy | Consenti, impatto basso |

| AhrefsBot | Analisi SEO/backlink | AhrefsBot/7.0 | UA, DNS inverso | Tool SEO, può essere pesante | Consenti/limita/blocca via robots.txt |

| SemrushBot | Analisi SEO/competitiva | SemrushBot/1.0 (e varianti) | UA | Tool SEO, può essere aggressivo | Consenti/limita/blocca via robots.txt |

| FacebookExternalHit | Anteprime social | facebookexternalhit/1.1 | UA, ASN Facebook | Engagement social | Consenti per anteprime, usa tag OG |

| Twitterbot | Anteprime Twitter | Twitterbot/1.0 | UA, ASN Twitter | Engagement su Twitter | Consenti per anteprime, usa tag Twitter Card |

Gestire la lista dei crawler: best practice per il 2025

- Aggiorna regolarmente: Il mondo dei crawler cambia in fretta. Prevedi revisioni trimestrali e usa strumenti come Thunderbit per estrarre e confrontare le liste ufficiali ().

- Verifica sempre: Controlla sia user-agent che IP/ASN. Non lasciare che impostori falsino le statistiche o rubino dati ().

- Allowlist per i bot buoni: Assicurati che crawler di ricerca e social non vengano mai bloccati da regole anti-bot o firewall.

- Limita o blocca i bot aggressivi: Usa robots.txt, crawl-delay o regole server per i tool SEO troppo invadenti.

- Automatizza l’analisi dei log: Usa strumenti AI (come Thunderbit) per estrarre, classificare ed etichettare l’attività dei crawler—risparmiando tempo e individuando trend nascosti.

- Bilancia SEO, analytics e sicurezza: Non bloccare i bot che portano valore, ma non lasciare campo libero a quelli dannosi.

Conclusione: tieni aggiornata e utile la tua lista dei crawler

Nel 2025, gestire l’elenco dei crawler non è solo una questione IT: è una priorità che coinvolge SEO, analytics, sicurezza e compliance. Con i bot che ormai dominano il traffico web, è fondamentale sapere chi visita il tuo sito, per quale motivo e come agire di conseguenza. Tieni la lista aggiornata, automatizza dove puoi e sfrutta strumenti come per restare sempre un passo avanti. Il web sarà sempre più affollato—una strategia intelligente e attiva sui crawler è la tua migliore difesa (e attacco) nell’era dei bot.

Domande frequenti

1. Perché è importante mantenere aggiornata la lista dei crawler?

Perché oggi i bot rappresentano oltre la metà del traffico web, ma solo una piccola parte è davvero utile. Tenere aggiornata la lista ti permette di consentire i bot buoni (per SEO e anteprime social) e bloccare o limitare quelli dannosi, proteggendo statistiche, banda e sicurezza dei dati.

2. Come posso distinguere un crawler autentico da uno falso?

Non fidarti solo dello user-agent: verifica sempre l’indirizzo IP o ASN tramite liste ufficiali o DNS inverso. Strumenti come Thunderbit automatizzano il confronto tra log, IP e user-agent pubblicati.

3. Cosa fare se un bot sconosciuto scansiona il mio sito?

Analizza user-agent e IP. Se non è nella tua allowlist e non corrisponde a un bot noto, valuta di limitarlo, sfidarlo o bloccarlo. Usa strumenti AI per classificare e monitorare i nuovi crawler.

4. In che modo Thunderbit aiuta nella gestione dei crawler?

Thunderbit sfrutta l’AI per estrarre, strutturare e classificare l’attività dei crawler dai log, facilitando la creazione di allowlist, l’individuazione di impostori e l’automazione delle policy. Il suo pre-processing semantico è particolarmente efficace su siti complessi o dinamici.

5. Quali rischi ci sono nel bloccare crawler importanti come Googlebot o Bingbot?

Bloccare i crawler dei motori di ricerca può far sparire il tuo sito dai risultati, azzerando il traffico organico. Controlla sempre firewall, robots.txt e regole anti-bot per non escludere per errore i bot fondamentali.

Per approfondire: