Immagina la scena: è lunedì mattina, hai appena preso il tuo caffè e la tua inbox è già piena di notifiche. Un altro tool AI è finito sotto i riflettori per una fuga di dati sensibili. Il CEO vuole risposte, il team legale è in allerta e i clienti iniziano a fare domande sempre più spinose su come vengono gestiti i loro dati da tutti quei sistemi “intelligenti” che avete appena implementato. Benvenuto nel 2026, dove la privacy dati AI non è più solo una questione tecnica: è una questione strategica che può decidere il destino di un brand e la carriera di chi lo guida.

Oggi l’AI è ovunque: dal commerciale al marketing, dal real estate all’e-commerce. Ma mentre l’adozione dell’AI corre veloce, i rischi aumentano altrettanto rapidamente. Solo nell’ultimo anno, gli incidenti legati alla privacy AI sono cresciuti del 56%, e solo il 47% delle persone nel mondo si fida delle aziende AI per la protezione dei propri dati personali—un dato in caduta libera (, ). Dopo anni passati a costruire piattaforme SaaS e automazione (e ora come co-fondatore di ), ti posso dire che conoscere le statistiche privacy dati AI non è solo una questione di compliance: è ciò che separa chi vince da chi resta indietro nell’era digitale.

Lo Stato della Privacy Dati AI nel 2026: I Numeri che Contano

Andiamo dritti al sodo. Se ti servono numeri per la prossima riunione con il board o per una presentazione ai clienti, ecco le statistiche privacy dati AI più importanti del 2026:

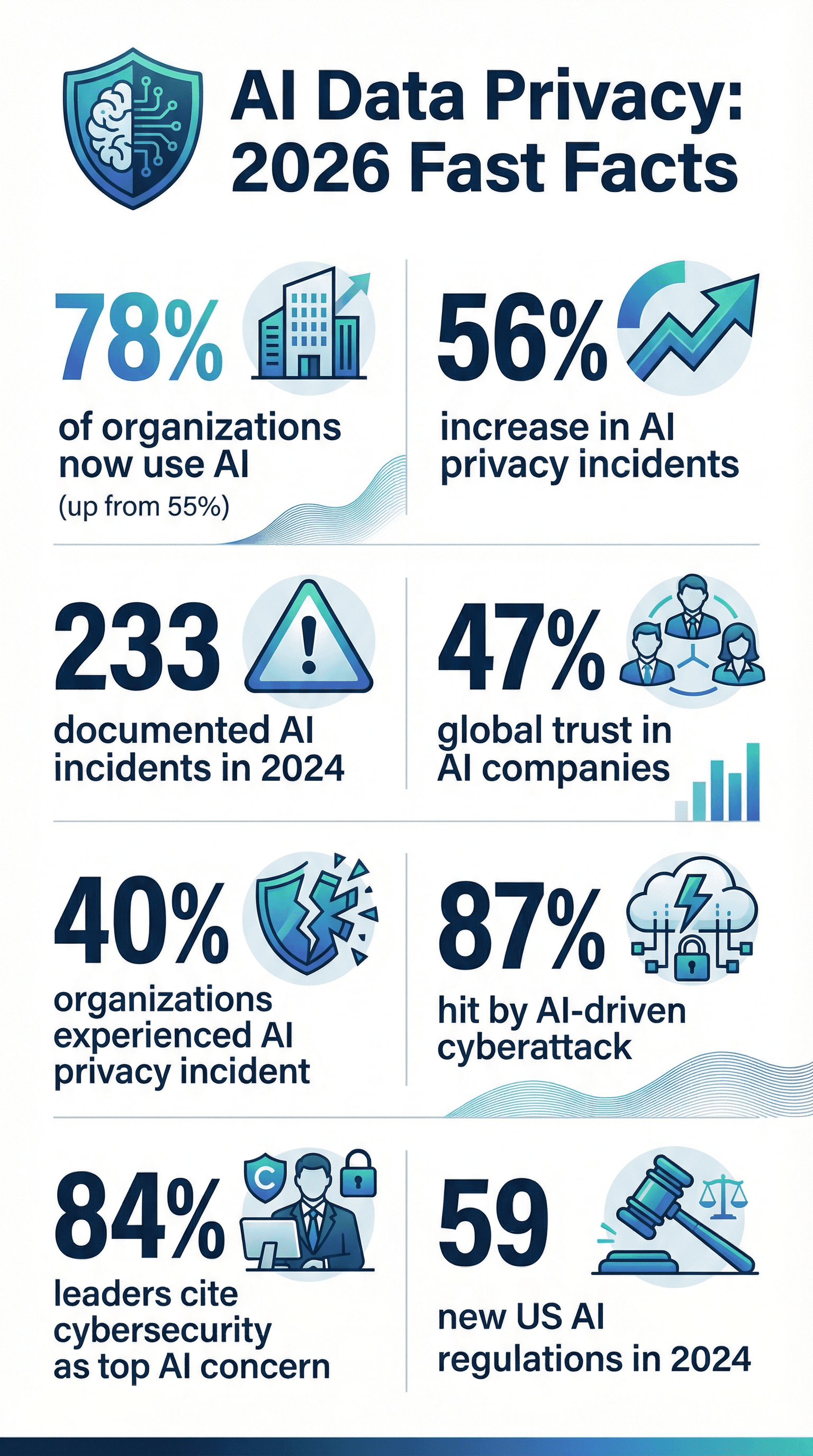

- L’AI è dappertutto: Il 78% delle aziende ha usato l’AI nel 2024, contro il 55% dell’anno prima ().

- Incidenti in crescita: Le violazioni di privacy e sicurezza AI sono aumentate del 56% in un anno, con 233 casi documentati nel 2024 ().

- Violazioni frequenti: Il 40% delle aziende ha già vissuto un incidente privacy AI (), e il 21% ha subito un attacco informatico nell’ultimo anno ().

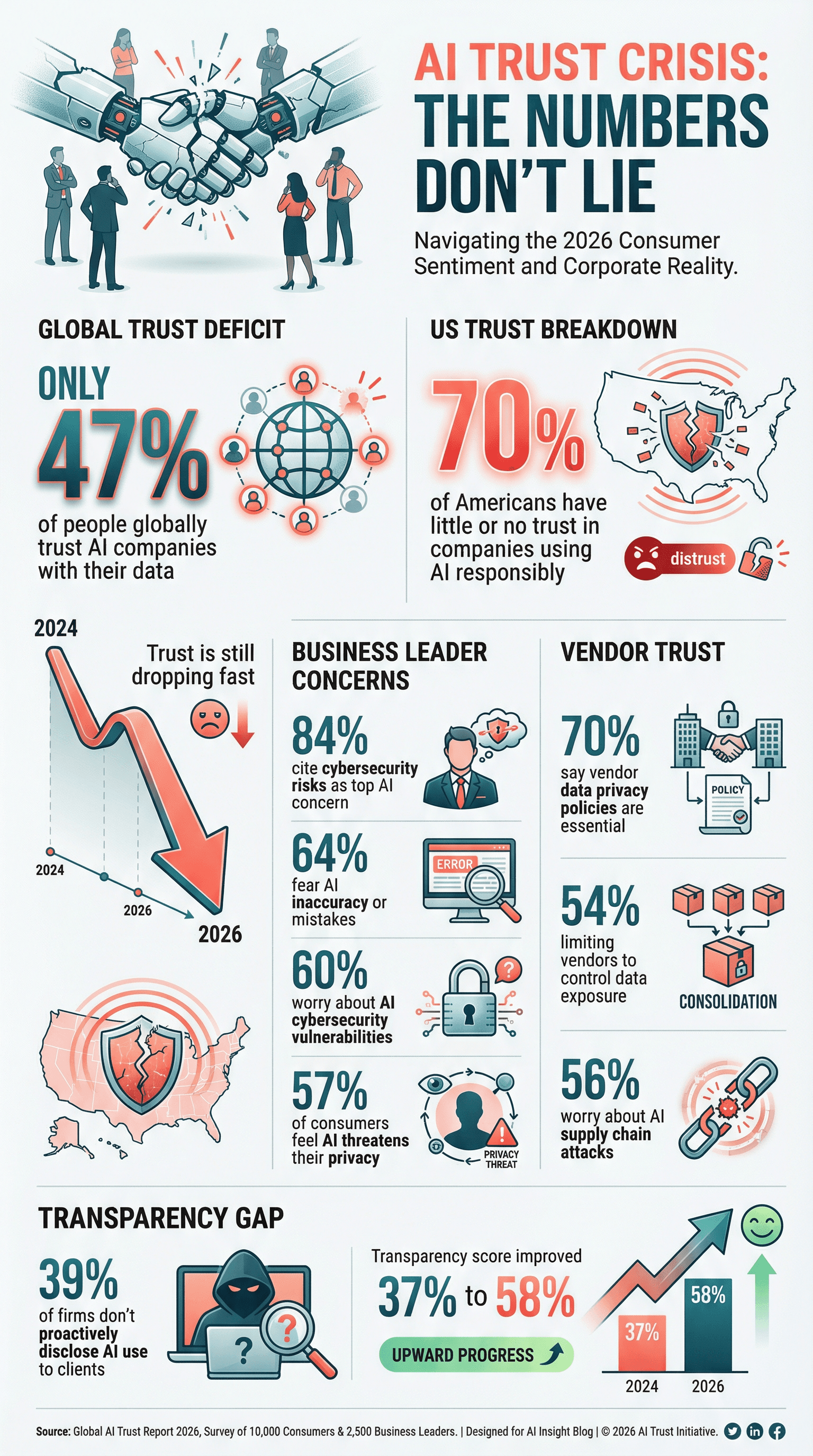

- Fiducia ai minimi storici: Solo il 47% delle persone si fida delle aziende AI nella gestione dei dati, e negli USA il 70% ha poca o nessuna fiducia nell’uso responsabile dell’AI ().

- La privacy è una priorità: Il 61% delle aziende mette la cybersecurity—compresa la protezione dati AI—tra le prime tre priorità strategiche ().

- Controlli sui fornitori: Il 70% delle aziende considera le policy privacy dati dei fornitori essenziali nella scelta dei partner tech ().

- I rischi AI preoccupano i manager: L’84% dei leader aziendali indica i rischi cybersecurity come principale preoccupazione nell’adozione AI ().

- Regolamentazione in aumento: Le agenzie federali USA hanno emanato 59 regolamenti AI nel 2024, più del doppio rispetto al 2023 ().

- Policy formali ancora poche: Solo il 43% delle aziende ha una policy di governance AI, anche se il 77% ci sta lavorando (, ).

- Attacchi AI-driven sempre più diffusi: L’87% delle aziende ha subito un attacco informatico guidato da AI nell’ultimo anno ().

Questi numeri non sono solo curiosità: sono un vero campanello d’allarme per chi si occupa di dati, compliance o trasformazione digitale.

Perché la Privacy Dati AI è più Cruciale che Mai

L’AI non è un semplice upgrade IT: è un cambio di mentalità su come le aziende raccolgono, processano e usano i dati. Diversamente dal software classico, i sistemi AI imparano da enormi moli di dati spesso disordinati, che possono includere di tutto, dalle email dei clienti alle cartelle cliniche. Il punto critico? I modelli AI possono “ricordare” e riproporre informazioni in modi imprevedibili, esponendo dati privati che non dovevano mai uscire ().

Le dimensioni sono da capogiro. Un solo modello AI può processare milioni di record o estrarre dati dal web—spesso senza consenso esplicito. Questo rende la protezione dei dati più importante che mai. E con l’AI che prende decisioni in pochi secondi (come approvare prestiti o selezionare candidati), ogni errore o bias può essere amplificato in un attimo, causando violazioni privacy e grane legali.

Se pensi che basti una policy privacy, ripensaci. L’AI porta rischi nuovi—come data poisoning, inversione del modello e attacchi adversarial—che i controlli classici non riescono a gestire. E le conseguenze reputazionali di un fail privacy AI? Sono pesanti. I clienti se ne vanno, le autorità multano e il brand può metterci anni a riprendersi. Nel 2026, la privacy dati AI non è solo una questione di regole: è una questione di sopravvivenza.

Statistiche Privacy Dati AI: Adozione, Preoccupazioni e Compliance

L’Adozione AI è Quasi Totale

Parliamoci chiaro: l’AI non è più una novità. È mainstream. Nel 2024, il 78% delle aziende usava l’AI, contro il 55% dell’anno prima (). In settori come legale e finanza, le percentuali sono ancora più alte—il 42% degli studi legali usava strumenti AI nel 2025, quasi il doppio rispetto all’anno prima (). Più AI, più dati raccolti, analizzati e (a volte) esposti.

Le Preoccupazioni sulla Privacy Crescono

Con il potere arrivano grandi responsabilità—e tante ansie. Il 57% dei consumatori nel mondo ora pensa che l’AI sia una minaccia seria per la privacy (). Negli USA, il 70% di chi conosce l’AI ha poca o nessuna fiducia nell’uso responsabile dei dati raccolti tramite AI (). Anche i manager sono in ansia: il 64% teme errori o imprecisioni AI, e il 60% cita le vulnerabilità cybersecurity AI come problema serio ().

Con il potere arrivano grandi responsabilità—e tante ansie. Il 57% dei consumatori nel mondo ora pensa che l’AI sia una minaccia seria per la privacy (). Negli USA, il 70% di chi conosce l’AI ha poca o nessuna fiducia nell’uso responsabile dei dati raccolti tramite AI (). Anche i manager sono in ansia: il 64% teme errori o imprecisioni AI, e il 60% cita le vulnerabilità cybersecurity AI come problema serio ().

Compliance: Un Obiettivo che si Sposta Sempre

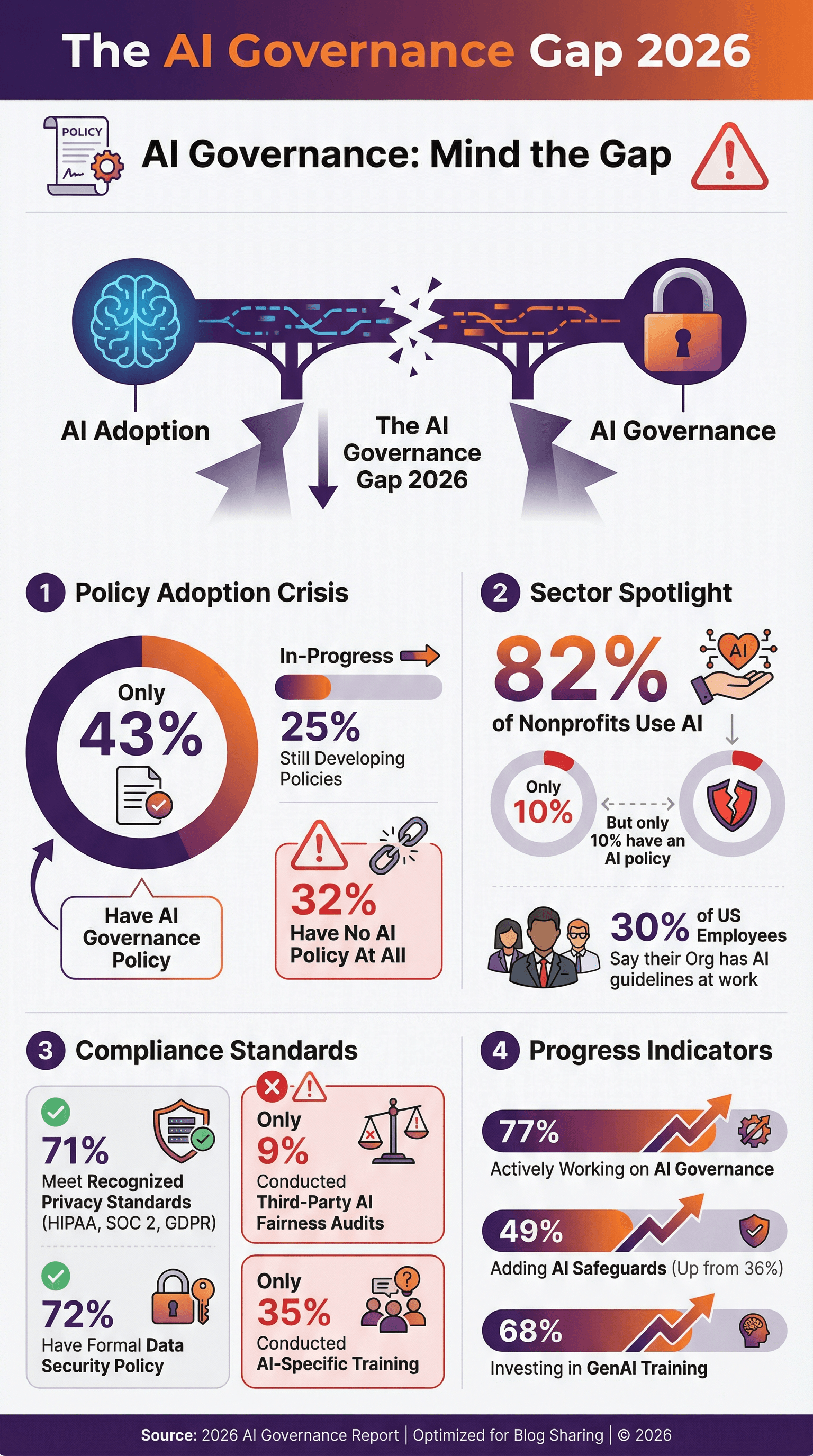

Le aziende cercano di stare al passo con regolamenti come GDPR, CCPA, HIPAA e SOC 2—ma l’AI porta nuove complessità. Il 71% delle aziende dichiara di rispettare standard privacy dati riconosciuti (), e il 72% ha una policy formale di sicurezza dati. Ma qui sta il problema: meno della metà ha una policy specifica di governance o etica AI. Solo il 43% delle aziende ha una policy di governance AI, e un altro 25% la sta sviluppando (, ). Gli altri? Navigano a vista.

Policy Privacy Dati AI: A che Punto Siamo

Le policy formali privacy dati AI stanno passando da “opzionali” a “indispensabili”. Ma i numeri dicono che c’è ancora tanta strada da fare:

- Solo il 43% delle aziende ha una policy di governance AI, con un altro 25% in fase di sviluppo ().

- Negli USA, solo il 30% dei dipendenti dice che la propria azienda ha linee guida o policy sull’uso AI al lavoro ().

- Tra le non profit, l’82% usa l’AI, ma solo il 10% ha una policy AI ().

- La buona notizia? Il 77% delle aziende sta lavorando su misure di governance AI, e tra i grandi utilizzatori la percentuale sfiora il 90% ().

I pionieri aggiornano le policy con clausole su usi vietati dell’AI, obblighi di revisione umana e impegni su equità e trasparenza. Se la tua azienda non ha ancora iniziato, è il momento giusto—meglio prevenire che curare.

Audit e Certificazioni Privacy Dati AI

Le policy sono fondamentali, ma audit e certificazioni dimostrano che le regole vengono davvero rispettate.

- Il 71% delle aziende dichiara conformità a standard come HIPAA, SOC 2 o GDPR ().

- Il 51% richiede ai fornitori la conformità HIPAA per i dati sanitari, e il 45% esige la crittografia end-to-end ().

- Solo il 9% delle aziende ha fatto audit di terze parti sulla correttezza o imparzialità dei propri sistemi AI—ma questa percentuale salirà con l’evoluzione delle regole ().

Certificazioni come SOC 2, ISO 27001 e HITRUST stanno diventando un vero vantaggio competitivo. Se sei un fornitore, aspettati che i clienti chiedano prove. Se sei un acquirente, controlla che i partner siano davvero affidabili.

Cybersecurity AI: Minacce, Incidenti e Difese

Parliamo dell’elefante nella stanza server: l’AI non è solo un bersaglio per gli hacker—è anche un’arma nelle loro mani. E i numeri sono, diciamolo, inquietanti.

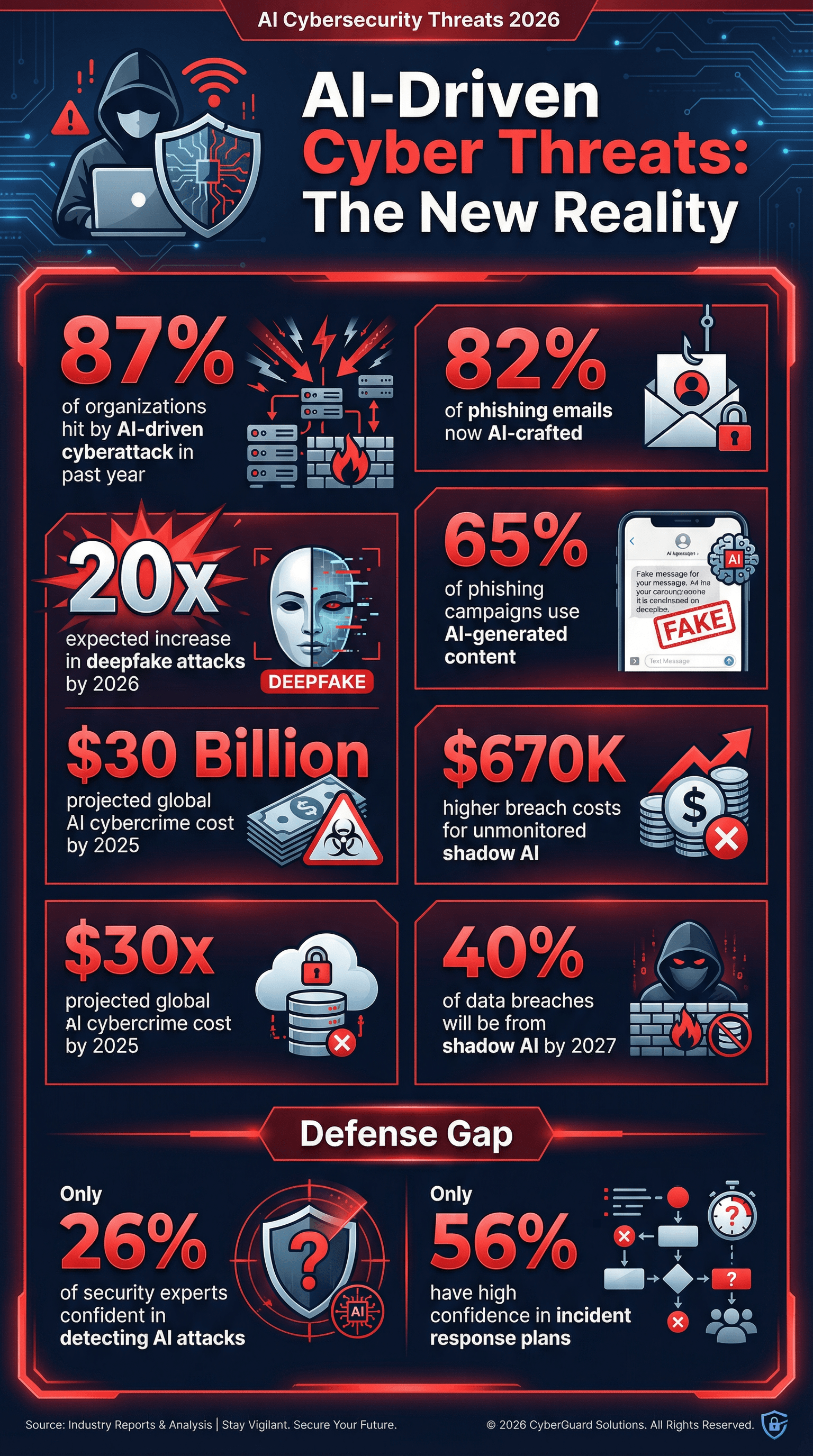

- L’87% delle aziende ha subito un attacco informatico guidato da AI nell’ultimo anno ().

- Il 65% delle campagne phishing ora usa contenuti generati da AI per imitare comunicazioni affidabili ().

- Si stima che l’82% delle email phishing sia realizzato con l’aiuto dell’AI ().

- Gli attacchi deepfake cresceranno di 20 volte entro il 2026 ().

- Il fenomeno dello Shadow AI (uso non autorizzato di AI da parte dei dipendenti) è in crescita—Gartner prevede che il 40% delle violazioni sarà dovuto a uso improprio di AI o sistemi “shadow AI” entro il 2027 ().

Ecco un dato che fa perdere il sonno ai responsabili sicurezza: solo il 26% degli esperti si dice molto sicuro di saper riconoscere attacchi AI-driven (). È come giocare a nascondino con un illusionista.

Attacchi Cyber AI-Driven: I Numeri

- L’87% delle aziende ha affrontato un attacco potenziato dall’AI negli ultimi 12 mesi ().

- Phishing sempre più furbo: Entro fine 2025, oltre l’82% delle email phishing era generato da AI ().

- Deepfake in boom: Gli attacchi audio/video deepfake aumenteranno di 20 volte entro il 2026.

- Shadow AI pericoloso: Entro il 2027, il 40% delle violazioni sarà causato da uso improprio di AI o “shadow AI” ().

- Costi delle violazioni alle stelle: Le aziende con AI non monitorata o shadow AI hanno subito costi medi di violazione superiori di $670.000 rispetto a chi ha controlli più rigidi ().

- Impatto globale: Il cybercrime abilitato dall’AI potrebbe toccare i 30 miliardi di dollari entro il 2025 ().

Se non stai testando le difese contro phishing AI o deepfake, stai rischiando grosso.

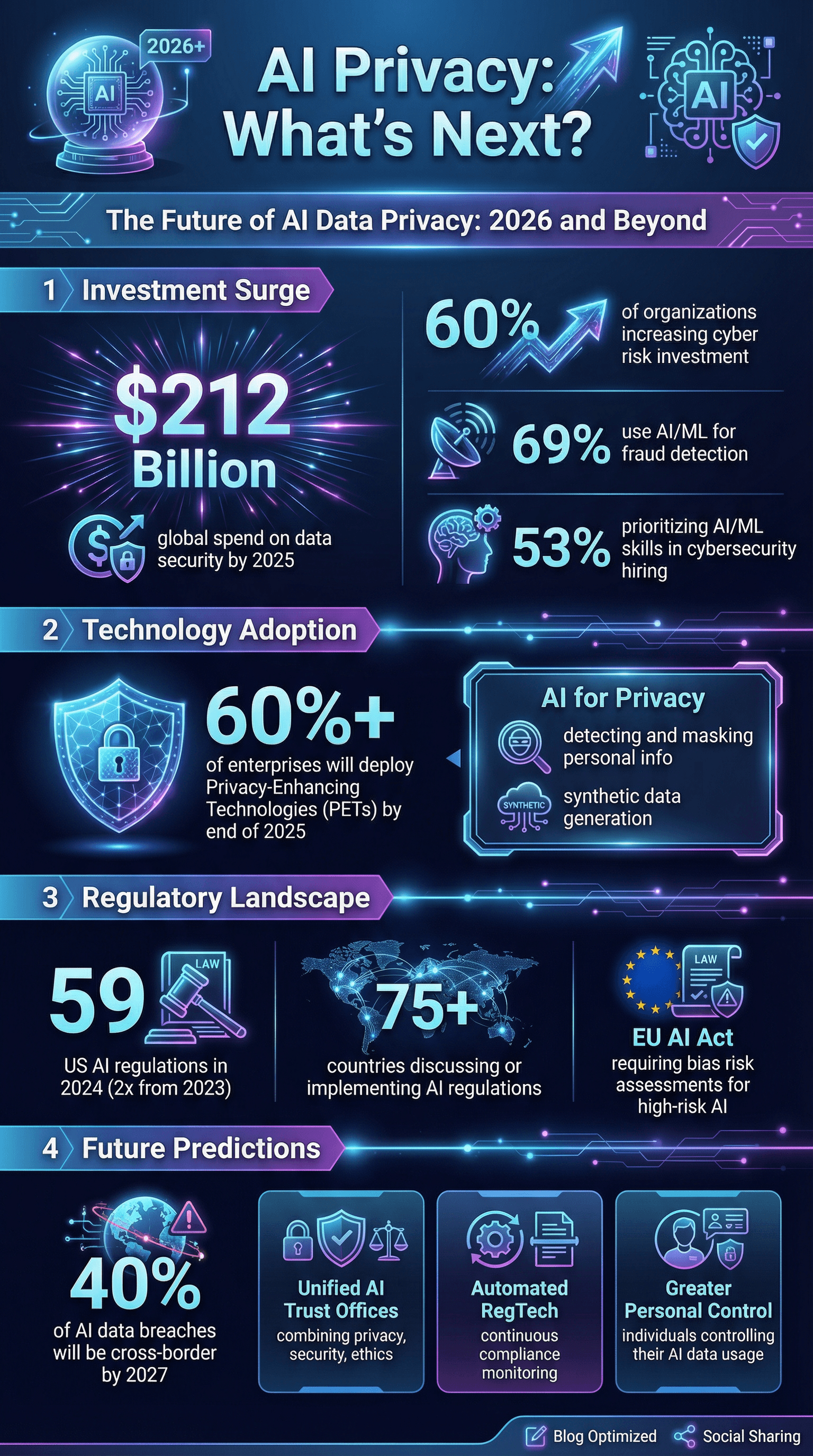

Investimenti Aziendali in Cybersecurity AI

La buona notizia? Le aziende stanno investendo più che mai nella sicurezza AI:

- Il 60% delle aziende sta aumentando gli investimenti nella mitigazione dei rischi cyber, con l’AI come motore principale ().

- Il 69% usa AI o machine learning per rilevare e prevenire frodi ().

- Il 53% dà priorità a competenze AI e ML nelle assunzioni cybersecurity ().

- La spesa globale per sicurezza dati e gestione rischi toccherà i 212 miliardi di dollari entro il 2025 ().

Ma resta un gap: solo il 56% delle aziende si dice molto sicuro dei propri piani di risposta agli incidenti cyber, e ancora meno affrontano scenari specifici AI.

Data Governance AI: Formazione, Controllo e Riduzione Bias

Puoi avere tutta la tecnologia che vuoi, ma se persone e processi non sono pronti, il rischio resta alto.

- Solo il 35% delle aziende ha formato i team su privacy, sicurezza o etica AI ().

- Il 68% investe in formazione AI generativa per i dipendenti ().

- Il 30% si affida al controllo umano come misura di sicurezza AI ().

- Solo il 9% usa audit indipendenti per la correttezza AI ().

- Il 49% sta implementando nuove misure di governance AI, in crescita rispetto al 36% dell’anno prima.

Il bias è un problema privacy serio. Sistemi AI che trattano i dati personali in modo diverso in base a razza, genere o altri fattori possono causare danni e problemi legali. Il 46% dei manager considera l’AI responsabile—compresa l’equità—una priorità per gli investimenti AI (). Ma misurare e ridurre i bias resta una sfida per molti.

Bias e Equità AI: Impatti sulla Privacy

- Incidenti AI legati a bias o problemi sicurezza sono in forte aumento ogni anno ().

- Alcune aziende hanno visto una riduzione del 25% delle disparità di genere nelle raccomandazioni ai candidati dopo interventi sui bias.

- La pressione normativa cresce: il GDPR UE e il prossimo AI Act richiederanno valutazioni dei rischi di bias per i sistemi AI “ad alto rischio”.

Se non stai testando i tuoi sistemi AI per i bias, rischi non solo cattiva pubblicità, ma anche cause legali e perdita di clienti.

Rischi Ecosistema e Fornitori: Consolidamento e Esposizione a Terzi

Nessuna azienda è un’isola. Quasi tutte si affidano a una rete di fornitori, cloud e partner—che possono introdurre rischi privacy.

- Il 54% delle aziende sta riducendo il numero di fornitori per contenere i costi e limitare l’esposizione dati ().

- Il 70% delle aziende considera essenziali le policy privacy dati nella scelta dei fornitori tech.

- Il 56% teme attacchi supply chain guidati da AI ().

La tendenza? Consolidare i fornitori, chiedere controlli privacy più forti e trattare i partner come parte della propria sicurezza.

Pressioni Regolatorie e dei Clienti: Trasparenza e Disclosure Privacy AI

Regolatori e clienti alzano l’asticella. Nel 2024, negli USA ci sono state 59 azioni regolatorie AI, più del doppio rispetto all’anno prima. A livello globale, almeno 75 paesi hanno discusso o introdotto regolamentazioni AI ().

- La trasparenza è la nuova normalità: I clienti si aspettano disclosure sull’uso AI, ma il 39% delle aziende ammette di non informare proattivamente i clienti ().

- Essere pronti agli audit è fondamentale: Devi poter dimostrare la compliance—HIPAA, SOC 2, elenchi strumenti AI e controlli dati.

- I punteggi di trasparenza dei principali sviluppatori AI sono saliti dal 37% al 58% in sei mesi ().

Se non sei pronto per un audit o per un questionario cliente tosto, non sei pronto per il 2026.

Il Futuro della Privacy Dati AI: Cosa ci Aspetta

Guardando avanti, ecco cosa prevedono gli esperti:

- La privacy come vantaggio competitivo: Le aziende che dimostrano sicurezza, privacy ed etica AI conquisteranno i clienti ().

- Governance unificata: Arriveranno “uffici AI Trust” che integrano privacy, sicurezza ed etica.

- Tecnologie per la privacy (PETs): Oltre il 60% delle aziende prevede di adottare PETs entro fine 2025 ().

- Compliance automatizzata: Le RegTech per l’AI diventeranno essenziali, con tool che monitorano costantemente la compliance dei sistemi AI.

- Sfide sui dati transfrontalieri: Entro il 2027, il 40% delle violazioni AI sarà dovuto a uso improprio di dati oltre confine ().

- Maggiore controllo personale: Arriveranno strumenti per gestire come i propri dati vengono usati dall’AI.

- AI per la privacy: L’AI verrà usata per rilevare e mascherare dati personali, generare dati sintetici e altro ancora.

- Risposta agli incidenti e resilienza: Le aziende passeranno dalla sola prevenzione alla resilienza, acquistando anche assicurazioni per incidenti AI e simulando recovery da data poisoning o corruzione dei modelli.

Da appassionato di automazione e AI (e con una sana paranoia privacy), sono convinto che i vincitori del prossimo decennio saranno quelli che tratteranno privacy e sicurezza come fondamentali, non come un’aggiunta a posteriori.

Cosa Significano le Statistiche 2026 Privacy Dati AI per la Tua Azienda

Ecco qualche consiglio pratico per non finire nel prossimo caso di studio negativo:

- Fai della privacy dati AI una parte centrale della strategia. Non aggiungerla dopo: integrala da subito.

- Fai valutazioni complete dei rischi AI. Conosci i tuoi sistemi AI, i flussi dati e i punti critici.

- Investi in formazione e governance AI. Non lasciare che il tuo team sia l’anello debole.

- Rafforza le difese tecniche pensando all’AI. Usa l’AI per contrastare l’AI—implementa strumenti avanzati di monitoraggio e detection.

- Gestisci bene i fornitori. Riduci, seleziona e chiedi prove di compliance.

- Sii trasparente. Comunica a clienti e utenti quando e come usi l’AI—prima che lo faccia qualcun altro.

- Adotta tecnologie privacy. Anonimizza, cifra e riduci i dati dove puoi.

- Preparati al peggio. Prevedi un piano di risposta agli incidenti AI e testalo spesso.

- Tieniti aggiornato su leggi e standard. Il quadro normativo cambia in fretta: non farti trovare impreparato.

- Fai della fiducia la tua bussola. Nel 2026 e oltre, la fiducia è il tuo asset più prezioso.

Fonti e Approfondimenti

Vuoi approfondire o ti servono dati per la prossima presentazione? Ecco alcune delle migliori risorse usate per questo articolo:

- )

Per altri approfondimenti su AI, automazione e privacy dati, visita il o consulta le nostre guide su e .