I web crawler sono i veri ninja invisibili della rete. Ogni volta che cerchi una nuova ricetta, controlli il prezzo delle tue sneakers preferite o confronti hotel per le vacanze, quasi sicuramente un web crawler è già passato da quelle pagine, raccogliendo e sistemando le informazioni che poi trovi pronte. Si stima che oltre sia oggi generata da bot e crawler, non da persone in carne e ossa. Proprio così: mentre tu dormi, questi esploratori digitali girano senza sosta per il web, assicurandosi che le informazioni siano sempre a portata di click.

Ma cosa sono davvero i web crawler? Perché sono così cruciali per aziende, ricercatori e chiunque abbia bisogno di dati freschi? E come strumenti moderni come hanno reso il web crawling accessibile a tutti, non solo a chi sa programmare o alle grandi aziende tech? Dopo anni passati a lavorare su automazione e intelligenza artificiale, ho visto con i miei occhi come i web crawler siano passati da misteriosi “ragni” a strumenti fondamentali per il business di tutti i giorni. Vediamo insieme cosa sono, come funzionano e perché sono la chiave per accedere ai dati in modo più smart nel 2025.

I Web Crawler: gli esploratori digitali del web

Ma quindi, cosa sono davvero i web crawler? In poche parole, i web crawler (detti anche spider o bot) sono programmi automatici che navigano il web in modo sistematico, visitando una pagina dopo l’altra e raccogliendo informazioni lungo il percorso. Immaginali come stagisti super efficienti: non si stancano mai, non si lamentano e possono visitare milioni di pagine in un solo giorno.

Un web crawler parte da una lista di indirizzi web (i famosi “seed”), visita ognuno di questi e segue i link che trova per scoprire nuove pagine. Durante il viaggio, copia i contenuti, indicizza i dati e costruisce una mappa aggiornata del web (). È così che i motori di ricerca come Google sanno cosa c’è online e come i siti di comparazione prezzi o gli strumenti di ricerca di mercato tengono i dati sempre freschi.

In parole semplici: i web crawler sono gli esploratori che rendono Internet ricercabile, confrontabile e utilizzabile.

I diversi tipi di Web Crawler: funzioni e specializzazioni

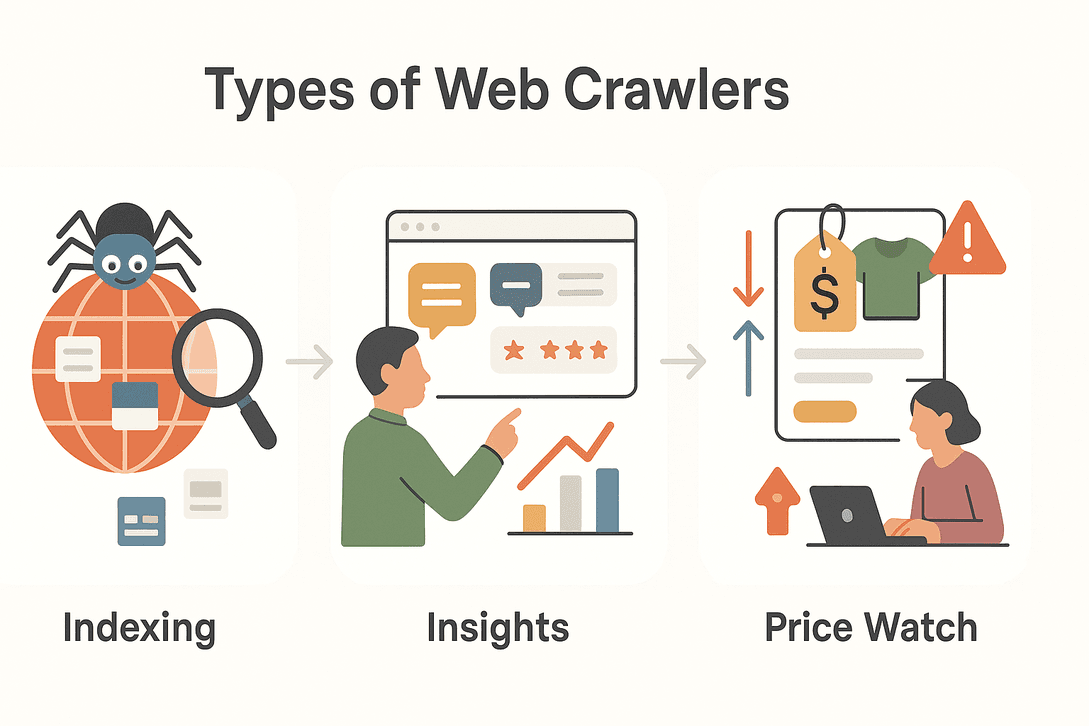

Non tutti i web crawler sono uguali. A seconda dell’obiettivo, esistono diversi tipi di crawler, ognuno con una funzione ben precisa. Ecco una panoramica dei principali:

Non tutti i web crawler sono uguali. A seconda dell’obiettivo, esistono diversi tipi di crawler, ognuno con una funzione ben precisa. Ecco una panoramica dei principali:

| Tipo | Funzione principale | Esempio d’uso |

|---|---|---|

| Crawler dei motori di ricerca | Indicizzano il web per i risultati di ricerca | Googlebot, Bingbot che scoprono nuovi siti |

| Crawler per data mining | Raccolgono grandi quantità di dati per analisi | Ricerche di mercato, studi accademici |

| Crawler per monitoraggio prezzi | Tracciano prezzi e disponibilità di prodotti | Comparazione prezzi e-commerce, pricing dinamico |

| Crawler per aggregazione contenuti | Raccolgono articoli, news o post per aggregazione | Portali di notizie, content curation |

| Crawler per lead generation | Estraggono contatti e dati aziendali | Prospecting commerciale, directory B2B |

Vediamo più da vicino alcune di queste categorie:

Crawler dei motori di ricerca

Quando scrivi una domanda su Google, ti affidi al lavoro dei crawler dei motori di ricerca. Questi bot scandagliano il web 24 ore su 24, scoprono nuove pagine, aggiornano quelle già esistenti e indicizzano i contenuti per renderli trovabili nei risultati. Senza i crawler, i motori di ricerca non saprebbero cosa c’è di nuovo, cosa è cambiato o cosa esiste online ().

Crawler per data mining e ricerche di mercato

Aziende e ricercatori usano i crawler per raccogliere enormi quantità di dati da analizzare. Vuoi sapere quante volte viene citato un brand concorrente online? O monitorare il sentiment su un nuovo prodotto? I crawler per data mining possono scandagliare forum, recensioni, social media e molto altro, trasformando il caos del web in informazioni ordinate ().

Crawler per monitoraggio prezzi e prodotti

Nel mondo dell’e-commerce, prezzi e dettagli dei prodotti cambiano di continuo. I crawler per il monitoraggio prezzi tengono d’occhio la concorrenza, segnalando variazioni di prezzo, cambi di disponibilità o nuovi lanci. Questo permette strategie di pricing dinamico e aiuta le aziende a restare sempre sul pezzo ().

Perché i Web Crawler sono fondamentali per l’accesso ai dati oggi

Diciamolo chiaro: il web è troppo grande per essere gestito a mano. Esistono (e il numero cresce ogni minuto), con migliaia di nuove pagine che spuntano ogni istante. I web crawler permettono di:

- Raccogliere dati su larga scala: Visitare milioni di pagine in poche ore.

- Restare sempre aggiornati: Monitorare costantemente cambiamenti, nuovi contenuti o notizie dell’ultimo minuto.

- Accedere a informazioni dinamiche e in tempo reale: Reagire subito a variazioni di mercato, prezzi o trend emergenti.

- Prendere decisioni basate sui dati: Alimentare motori di ricerca, ricerche di mercato, gestione del rischio e modelli finanziari ().

In un mondo dove , i web crawler sono i motori che tengono in movimento il flusso di informazioni.

I principali utilizzi dei Web Crawler nei diversi settori

I web crawler non sono solo roba da giganti tech o motori di ricerca. Ecco come vengono usati in vari settori:

| Settore | Utilizzo | Vantaggio |

|---|---|---|

| Vendite | Lead generation | Creare liste di potenziali clienti da directory |

| E-commerce | Monitoraggio prezzi | Tracciare prezzi, stock e cambiamenti dei prodotti |

| Marketing | Aggregazione contenuti | Curare news, articoli e menzioni sui social |

| Immobiliare | Aggregazione annunci | Unire annunci da più fonti in un unico database |

| Viaggi | Confronto tariffe e hotel | Monitorare prezzi, disponibilità e policy |

| Finanza | Monitoraggio rischi | Tracciare news, documenti e sentiment per investimenti |

Esempio pratico:

Un’agenzia immobiliare usa i crawler per raccogliere dettagli, foto e servizi degli immobili da diversi portali, offrendo ai clienti una panoramica aggiornata del mercato ().

Un team e-commerce imposta crawler per monitorare SKU e prezzi dei concorrenti, adattando la propria strategia in tempo reale ().

Come funziona un Web Crawler: il processo passo dopo passo

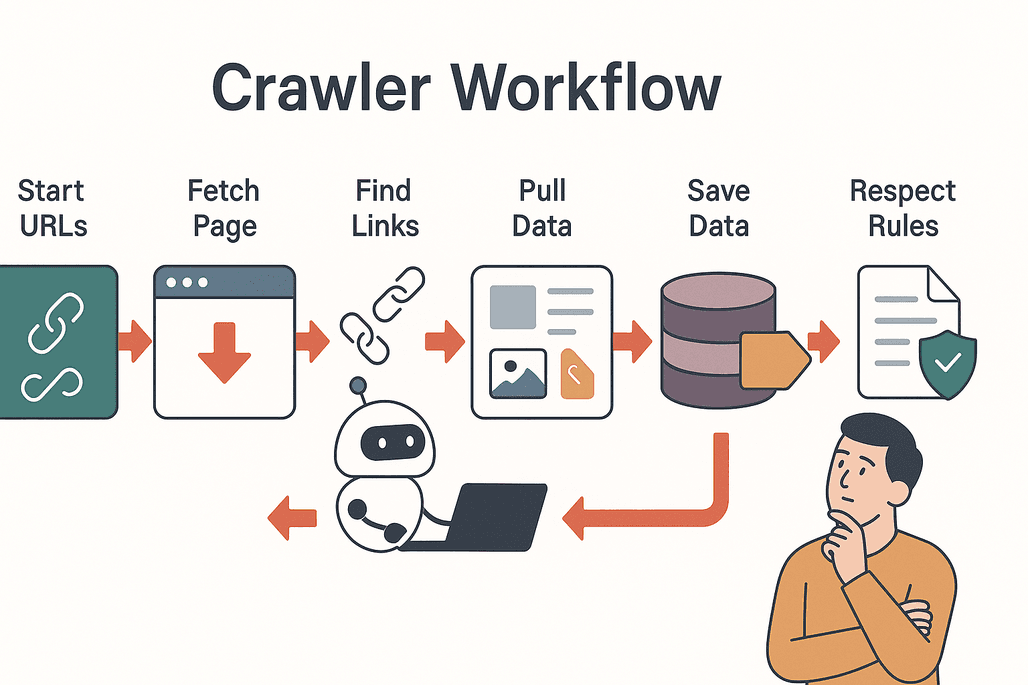

Facciamo chiarezza su come funziona. Ecco i passaggi tipici di un web crawler:

Facciamo chiarezza su come funziona. Ecco i passaggi tipici di un web crawler:

- Partenza dai seed: Il crawler inizia da una lista di URL di partenza.

- Visita e scarica: Accede a ciascuna pagina e ne scarica i contenuti.

- Estrae i link: Trova tutti i collegamenti presenti nella pagina.

- Segue i link: Aggiunge i nuovi link non ancora visitati alla coda.

- Estrae i dati: Copia e struttura le informazioni rilevanti (testi, immagini, prezzi, ecc.).

- Salva i risultati: I dati vengono archiviati in un database o esportati per l’analisi.

- Rispetta le regole: Il crawler controlla il file

robots.txtdi ogni sito per sapere cosa è consentito, evitando le aree vietate ().

Best practice:

- Fai crawling in modo rispettoso (senza stressare i server).

- Rispetta privacy e limiti legali.

- Evita contenuti duplicati e richieste inutili.

Sfide e aspetti da considerare nell’uso dei Web Crawler

Il web crawling non è sempre una passeggiata. Ecco alcune difficoltà tipiche:

- Carico sui server: Troppe richieste possono rallentare o bloccare un sito.

- Contenuti duplicati: I crawler possono rivisitare le stesse pagine o bloccarsi in loop.

- Privacy e legalità: Non tutti i dati sono accessibili—controlla sempre termini d’uso e normative sulla privacy.

- Barriere tecniche: Alcuni siti usano CAPTCHA, contenuti dinamici o sistemi anti-bot per bloccare i crawler ().

Consigli utili:

- Imposta una frequenza di crawling rispettosa.

- Monitora eventuali cambiamenti nella struttura dei siti.

- Rimani aggiornato sulle normative in materia di privacy dei dati.

Thunderbit: i Web Crawler alla portata di tutti

Ed ecco la vera svolta. Fino a poco tempo fa, configurare un web crawler voleva dire scrivere codice, impostare parametri e perdere ore a risolvere problemi tecnici. Con , tutto questo è acqua passata.

Thunderbit è un Estrattore Web AI per Chrome pensato per utenti business—senza bisogno di programmare. Ecco perché è diverso dagli altri:

- Istruzioni in linguaggio naturale: Basta scrivere cosa vuoi (“Estrai tutti i nomi e prezzi dei prodotti da questa pagina”) e l’AI di Thunderbit si occupa di tutto.

- Suggerimenti AI per i campi: Clicca su “AI Suggerisci Campi” e Thunderbit analizza la pagina, consigliando le colonne migliori da estrarre.

- Estrazione da sottopagine: Vuoi più dettagli? Thunderbit può visitare ogni sottopagina (come dettagli prodotto o profili LinkedIn) e arricchire automaticamente il tuo dataset.

- Template pronti all’uso: Per i siti più popolari (Amazon, Zillow, Shopify, ecc.), usa template preimpostati per estrarre dati in un click.

- Esportazione semplice: Invia i dati direttamente su Excel, Google Sheets, Airtable o Notion—senza passaggi extra.

- Esportazione gratuita: Scarica i risultati in CSV o JSON, senza costi.

Thunderbit è già scelto da , tra team di vendita, operatori e-commerce e professionisti del settore immobiliare.

Thunderbit vs. Web Crawler tradizionali

Ecco come Thunderbit si confronta con i metodi classici:

| Caratteristica | Thunderbit | Crawler tradizionali |

|---|---|---|

| Tempo di configurazione | 2 click (l’AI si occupa di tutto) | Ore/giorni (configurazione manuale) |

| Competenze tecniche | Nessuna (istruzioni in italiano) | Alte (codice, selettori, script) |

| Flessibilità | Funziona su qualsiasi sito, si adatta ai cambiamenti | Si rompe con cambi layout |

| Estrazione sottopagine | Integrata, nessuna configurazione extra | Richiede script manuali |

| Opzioni di esportazione | Excel, Sheets, Airtable, Notion, CSV, JSON | Di solito solo CSV/JSON |

| Manutenzione | L’AI si adatta automaticamente | Richiede frequenti aggiustamenti |

Con Thunderbit, non serve essere sviluppatori né perdere tempo con impostazioni complicate. Basta un click e l’AI fa tutto il lavoro pesante ().

Come iniziare con i Web Crawler grazie a Thunderbit

Vuoi provarlo? Ecco come iniziare con Thunderbit in pochi minuti:

- Installa la .

- Apri il sito che vuoi esplorare.

- Clicca sull’icona Thunderbit e scegli “AI Suggerisci Campi.” L’AI proporrà le colonne più adatte in base ai contenuti della pagina.

- Modifica i campi se necessario, poi clicca su “Estrai.” Thunderbit raccoglierà i dati, anche dalle sottopagine se lo desideri.

- Esporta i risultati su Excel, Google Sheets, Airtable, Notion o scarica in CSV/JSON.

Tutto qui—niente template, niente codice, zero complicazioni. Che tu debba monitorare prezzi, creare una lista di lead o aggregare notizie, Thunderbit rende il web crawling semplice come ordinare una pizza.

Conclusione: i Web Crawler sono la chiave per dati più intelligenti

I web crawler sono i motori invisibili che alimentano il nostro mondo digitale, rendendo le informazioni accessibili, ricercabili e utilizzabili da chiunque. Dai motori di ricerca ai team di vendita, dall’e-commerce al real estate, i crawler sono ormai strumenti indispensabili per chi ha bisogno di dati affidabili e aggiornati.

E grazie a strumenti moderni basati su AI come , non serve essere programmatori per sfruttarne la potenza. Bastano pochi click per trasformare il web in una risorsa strutturata e pronta all’uso—per decisioni più intelligenti e nuove opportunità.

Vuoi scoprire cosa possono fare i web crawler per la tua attività? e inizia subito a esplorare i dati nascosti del web. Per altri consigli e approfondimenti, visita il .

Domande frequenti

1. Che cos’è esattamente un web crawler?

Un web crawler è un programma automatico (chiamato anche spider o bot) che naviga sistematicamente su Internet, visita pagine web, segue i link e raccoglie informazioni per indicizzazione o analisi.

2. In cosa si differenziano i web crawler dagli estrattori web?

I web crawler sono pensati per scoprire e mappare grandi porzioni del web, seguendo i link da una pagina all’altra. Gli estrattori web, invece, si concentrano sull’estrazione di dati specifici da pagine precise. Molti strumenti moderni (come Thunderbit) combinano entrambe le funzioni.

3. Perché i web crawler sono importanti per le aziende?

I web crawler permettono alle aziende di accedere a informazioni aggiornate su larga scala—che si tratti di monitorare i prezzi dei concorrenti, aggregare contenuti o costruire liste di lead. Supportano decisioni in tempo reale e aiutano a restare competitivi.

4. È legale usare i web crawler?

Il web crawling è generalmente legale se fatto in modo responsabile e rispettando i termini d’uso e le policy sulla privacy dei siti. Controlla sempre il file robots.txt e rispetta le normative sulla privacy dei dati.

5. Come semplifica Thunderbit il web crawling?

Thunderbit usa l’AI per automatizzare configurazione, selezione dei campi ed estrazione dati. Con istruzioni in linguaggio naturale e template pronti, chiunque può esplorare ed estrarre dati dai siti—senza bisogno di codice o competenze tecniche. I dati possono essere esportati direttamente su Excel, Google Sheets, Airtable o Notion per un utilizzo immediato.

Per saperne di più