Il web è davvero una miniera d’oro di dati: nel 2024, il volume globale di informazioni digitali ha toccato la cifra pazzesca di . Una curiosità? Più del 90% dei dati mondiali è stato creato solo negli ultimi due anni. Per chi lavora nel business, questo vuol dire che la prossima idea vincente, un nuovo contatto o un vantaggio competitivo potrebbero essere nascosti online—basta solo saperli scovare.

Ed è qui che entra in gioco l’estrazione automatica dei dati dai siti. Che tu sia nel commerciale, nell’e-commerce o nella ricerca di mercato, saper raccogliere e organizzare dati dal web in modo automatico è davvero un superpotere. E se non hai mai programmato, nessun problema: Python rende tutto più semplice. In questa guida ti porto passo passo, dall’installazione alla pulizia dei dati, e ti faccio vedere anche una soluzione senza codice con per risultati immediati.

Cos’è il Web Scraping con Python?

Partiamo dalle basi: web scraping vuol dire estrarre dati dai siti in modo automatico. Immagina di voler raccogliere i prezzi di un e-commerce, creare una lista di potenziali clienti da una directory o monitorare le novità dei concorrenti. Invece di copiare e incollare a mano (chi ha tempo?), puoi scrivere uno script che fa tutto per te.

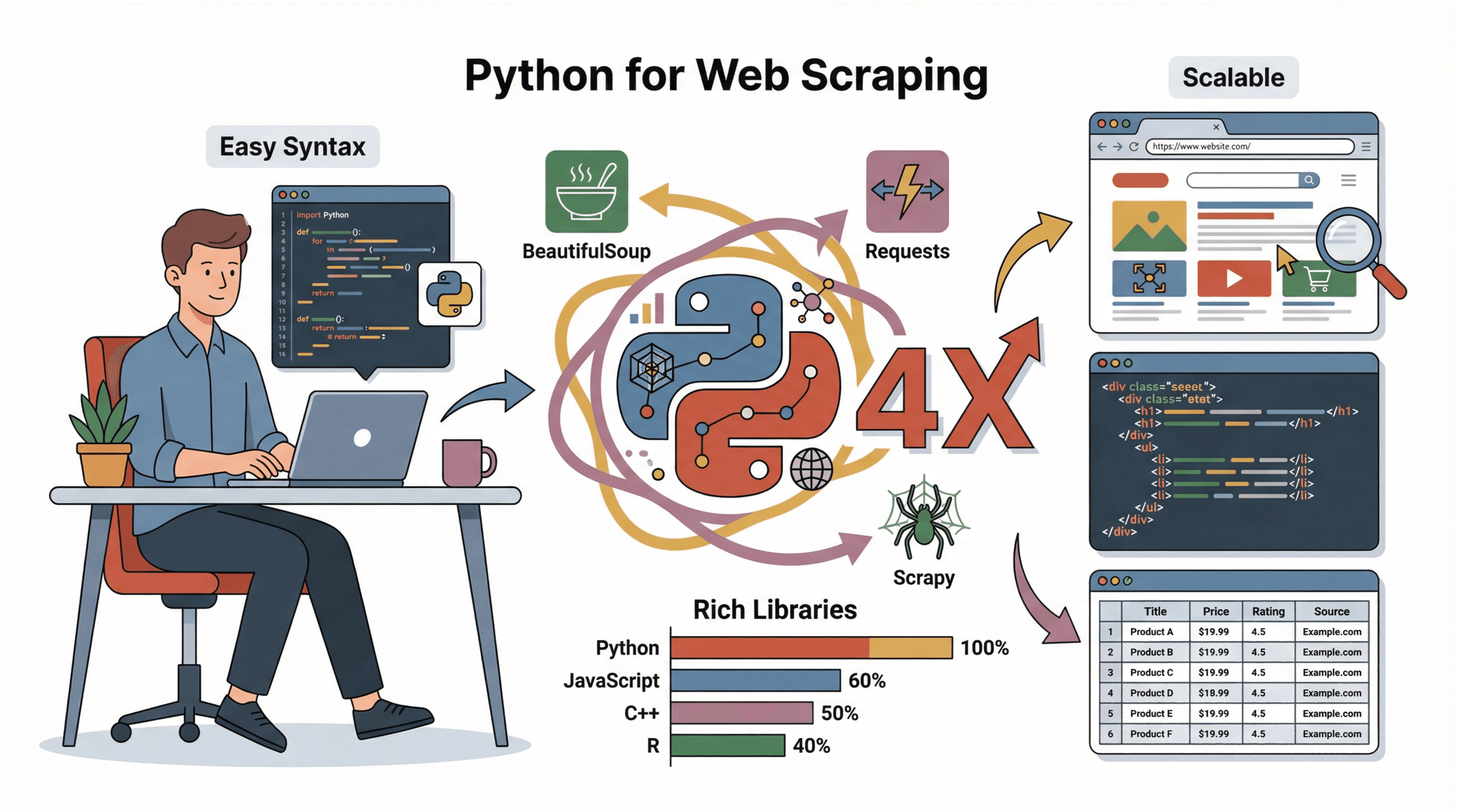

Web scraping con Python significa usare Python per automatizzare questo processo. Grazie alla sua sintassi semplice e alle librerie potenti, Python è perfetto anche per chi non ha mai programmato. Puoi scaricare pagine web, analizzarne il contenuto e salvare i dati in modo strutturato in pochissimo tempo.

Le aziende usano il web scraping per:

- Generare lead: Creare elenchi di potenziali clienti da directory o siti di recensioni.

- Monitorare i prezzi: Tenere d’occhio i prezzi dei concorrenti o la disponibilità dei prodotti.

- Fare ricerche di mercato: Raccogliere notizie, recensioni o menzioni sui social.

- Gestire l’operatività: Ottenere info su fornitori, offerte di lavoro o annunci immobiliari.

Insomma, se i dati sono su un sito, Python ti aiuta a recuperarli in modo veloce e su larga scala.

Perché Python è la Scelta Migliore per il Web Scraping

Ho provato diversi linguaggi per il web scraping (e sì, anch’io ho avuto i miei momenti “perché non va?”). Ma Python spicca, ecco perché:

Ho provato diversi linguaggi per il web scraping (e sì, anch’io ho avuto i miei momenti “perché non va?”). Ma Python spicca, ecco perché:

- Facilissimo da imparare: La sintassi di Python è chiara e leggibile, perfetta anche per chi non è programmatore.

- Ecosistema ricchissimo: Librerie come , e rendono tutto più semplice.

- Community super attiva: Online trovi tutorial, forum e esempi di codice per ogni esigenza.

- Scalabilità: Python va bene sia per script veloci che per progetti di scraping complessi e su larga scala.

Rispetto a JavaScript, C++ o R, Python è più accessibile e perfetto per prototipi rapidi e analisi dati (). Ecco perché è la scelta preferita sia dai principianti che dalle aziende.

Iniziare: Come Preparare l’Ambiente Python per il Web Scraping

Prima di iniziare a estrarre dati, serve installare Python e alcune librerie base. Ecco come fare, anche se non hai mai installato Python:

-

Installa Python:

- Scarica l’ultima versione da .

- Su Windows, seleziona “Add Python to PATH” durante l’installazione.

- Su Mac, puoi usare con

brew install python3. - Su Linux, usa il gestore pacchetti:

sudo apt install python3 python3-pip.

-

Installa pip (il gestore pacchetti di Python):

- Di solito pip è già incluso. Controlla con

pip --version. - Se non c’è, reinstalla Python o usa

python -m ensurepip --upgrade.

- Di solito pip è già incluso. Controlla con

-

Crea un ambiente virtuale (opzionale, ma consigliato):

- Nella cartella del progetto, esegui:

python -m venv env - Attivalo:

- Windows:

.\env\Scripts\activate - Mac/Linux:

source env/bin/activate

- Windows:

- Nella cartella del progetto, esegui:

-

Installa le librerie necessarie:

- Con l’ambiente virtuale attivo, esegui:

1pip install requests beautifulsoup4 pandas scrapy - Per siti dinamici, puoi aggiungere anche

selenium.

- Con l’ambiente virtuale attivo, esegui:

-

Scegli un editor di codice:

- Se sei alle prime armi, , o sono ottimi.

Tips utili:

- Se

pipnon viene riconosciuto, prova conpython -m pip install .... - Se hai errori di permessi, apri il terminale come amministratore o usa

sudosu Mac/Linux. - Su Windows, riavvia il terminale dopo aver installato Python.

Analizzare la Struttura di un Sito Prima di Fare Scraping

Prima di scrivere codice, è fondamentale capire come è fatto il sito da cui vuoi estrarre i dati. Ecco come faccio di solito:

-

Apri gli strumenti per sviluppatori:

- In Chrome, clicca col destro su un elemento e scegli “Ispeziona”, oppure premi

F12. - Vedrai la struttura HTML nella scheda “Elements”.

- In Chrome, clicca col destro su un elemento e scegli “Ispeziona”, oppure premi

-

Trova i dati che ti interessano:

- Usa lo strumento “Seleziona elemento” (icona a forma di puntatore) e clicca sui dati che vuoi estrarre (es. titolo prodotto o prezzo).

- L’HTML corrispondente verrà evidenziato.

-

Individua i pattern:

- Cerca tag, classi o ID unici. Ad esempio:

<h2 class="product-title">Laptop XYZ</h2>. - Nota se i dati sono in una lista (

<ul>,<div class="item">, ecc.) o in una tabella.

- Cerca tag, classi o ID unici. Ad esempio:

-

Controlla la paginazione:

- Cerca pulsanti “Avanti” o numeri di pagina nell’HTML. Se vedi URL come

?page=2, puoi gestirli in uno script.

- Cerca pulsanti “Avanti” o numeri di pagina nell’HTML. Se vedi URL come

-

Il contenuto è dinamico?

- Se i dati non compaiono nel sorgente pagina (

Ctrl+U), probabilmente sono caricati via JavaScript. In questo caso, valuta l’uso di Selenium o cerca un endpoint API.

- Se i dati non compaiono nel sorgente pagina (

Per una guida visiva, è super utile.

Usare Requests per Scaricare il Contenuto di una Pagina Web

La libreria è perfetta per scaricare pagine web con Python. Ecco un esempio base:

1import requests

2url = "https://www.bbc.com/news"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status() # Solleva un errore per risposte non valide

6html = response.textTips:

- Imposta sempre un

User-Agentrealistico per evitare blocchi (). - Controlla

response.status_code(200 = OK, 404 = non trovato, 403 = vietato, 429 = troppe richieste).

Analizzare l’HTML con BeautifulSoup: Come Estrarre i Dati

Ora che hai l’HTML, puoi estrarre le info che ti servono. lo rende facilissimo:

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3titles = [h.get_text(strip=True) for h in soup.select("h3")]Operazioni tipiche:

- Estrarre testo:

element.get_text(strip=True) - Ottenere link:

[a['href'] for a in soup.select('a')] - Cercare per classe:

soup.find_all('span', class_='price') - Estrarre immagini:

[img['src'] for img in soup.select('img')] - Gestire tabelle: Usa

soup.select('table')e cicla tra righe/celle.

Tips per HTML disordinato:

- Usa

soup.select_one()per il primo elemento trovato. - Se un campo manca, controlla che non sia

Noneprima di accedere agli attributi. - Per layout strani, potresti dover scrivere logica personalizzata o usare espressioni regolari.

Scrapy: Framework Potente e Scalabile per il Web Scraping

Se le tue esigenze crescono (centinaia o migliaia di pagine), è la soluzione perfetta. Scrapy è un framework completo per navigare siti, gestire richieste, seguire link ed esportare dati.

Perché scegliere Scrapy?

- Velocissimo: Scrapy scarica più pagine in parallelo (asincrono).

- Funzionalità integrate: Gestisce retry, cache ed esportazione in CSV/JSON.

- Scalabilità: Perfetto per progetti grandi o scraping ricorrente.

Flusso di lavoro base con Scrapy:

- Installa:

pip install scrapy - Crea un progetto:

scrapy startproject myproject - Definisci una classe Spider con

start_urlse un metodoparse. - Usa

yieldper seguire link o estrarre dati. - Avvia:

scrapy crawl spidername -o output.csv

Per iniziare, dai un’occhiata alla .

Alternativa No-Code: Estrattore Web AI di Thunderbit per Risultati Immediati

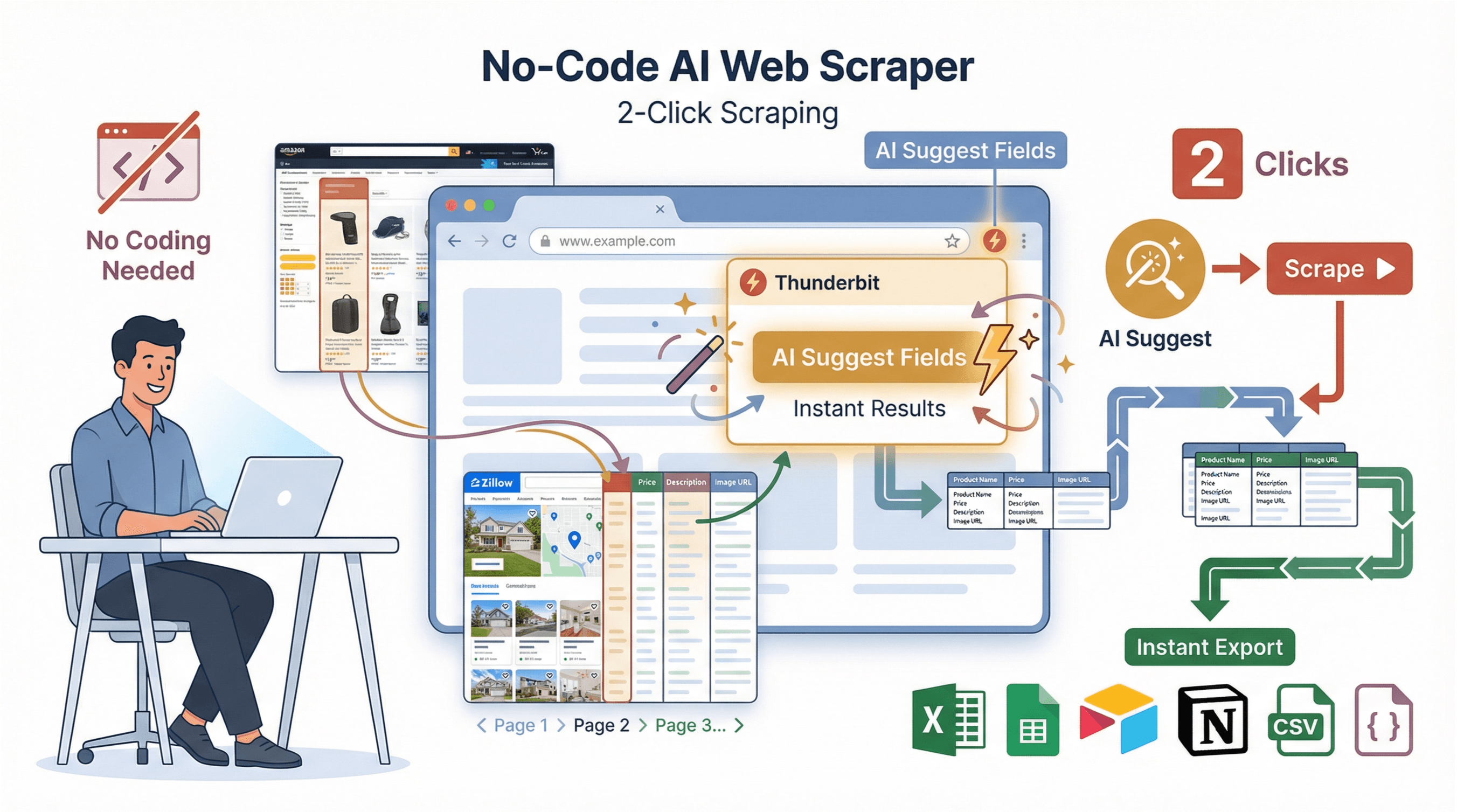

Diciamolo chiaro: non tutti hanno voglia di smanettare con codice, dipendenze o errori. Ecco perché abbiamo creato : un Estrattore Web AI come estensione Chrome, pensato per chi vuole risultati in pochi clic.

Diciamolo chiaro: non tutti hanno voglia di smanettare con codice, dipendenze o errori. Ecco perché abbiamo creato : un Estrattore Web AI come estensione Chrome, pensato per chi vuole risultati in pochi clic.

Come funziona Thunderbit:

- AI Suggerisce i Campi: Clicca su “AI Suggerisci Campi” e Thunderbit analizza la pagina, proponendo le colonne migliori da estrarre.

- Estrazione in 2 clic: Premi “Estrai” e Thunderbit fa tutto il resto—paginazione, sottopagine e anche layout complessi.

- Estrazione da sottopagine: Vuoi più dettagli? Thunderbit può visitare ogni sottopagina (come dettagli prodotto o profili) e arricchire la tua tabella in automatico.

- Template pronti: Per siti famosi (Amazon, Zillow, Instagram, Shopify), usa template già pronti per esportare in un clic.

- Esportazione gratuita: Esporta su Excel, Google Sheets, Airtable, Notion, CSV o JSON—senza costi nascosti.

Thunderbit vs. Python: Confronto Rapido

| Funzionalità | Python (Manuale) | Thunderbit (No-Code) |

|---|---|---|

| Tempo di configurazione | 30–60 minuti | 2 minuti |

| Richiede codice | Sì | No |

| Gestione paginazione | Con codice personalizzato | Sì, in automatico |

| Estrazione sottopagine | Cicli manuali | 1 clic |

| Esportazione dati | Scrivere codice per CSV/Excel | 1 clic su Sheets/Excel/Notion |

| Manutenzione | Aggiornamenti manuali se il sito cambia | L’AI si adatta automaticamente |

| Ideale per | Logica personalizzata, integrazioni | Risultati rapidi, chi non programma |

Per approfondire, leggi la .

Pulizia e Salvataggio dei Dati: Come Rendere Utili i Dati Estratti

I dati grezzi estratti raramente sono subito pronti all’uso. Ecco come pulirli e salvarli con :

1import pandas as pd

2# Supponiamo di avere una lista di dizionari chiamata scraped_data

3df = pd.DataFrame(scraped_data)

4# Rimuovi duplicati

5df = df.drop_duplicates()

6# Filtra le righe con valori mancanti

7df = df.dropna(subset=['title', 'price'])

8# Converte il prezzo in float (rimuove $ e virgole)

9df['price'] = df['price'].str.replace('$', '').str.replace(',', '').astype(float)

10# Salva in CSV

11df.to_csv('results.csv', index=False)Best practice:

- Controlla sempre la presenza di dati mancanti o incoerenti.

- Normalizza i formati (es. date, prezzi).

- Salva in CSV per condivisione rapida, oppure usa Excel/Google Sheets per collaborare.

- Per grandi volumi, valuta un database (come SQLite o PostgreSQL).

Tutorial Passo Passo: Web Scraping con Python dall’Inizio alla Fine

Mettiamo tutto insieme con un esempio pratico: estrarre titoli e prezzi da un sito e-commerce di esempio.

1. Analizza il Sito

Supponiamo di voler estrarre dati da . Analizzando la pagina notiamo:

- I titoli dei libri sono nei tag

<h3>dentro<article class="product_pod">. - I prezzi sono in

<p class="price_color">.

2. Scarica la Pagina

1import requests

2url = "http://books.toscrape.com/"

3headers = {"User-Agent": "Mozilla/5.0"}

4response = requests.get(url, headers=headers)

5response.raise_for_status()

6html = response.text3. Analizza ed Estrai i Dati

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3books = []

4for article in soup.select("article.product_pod"):

5 title = article.h3.a["title"]

6 price = article.select_one("p.price_color").get_text(strip=True)

7 books.append({"title": title, "price": price})4. Pulisci e Salva i Dati

1import pandas as pd

2df = pd.DataFrame(books)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df.to_csv('books.csv', index=False)

5print(f"Salvati {len(df)} libri in books.csv")5. Consigli per la Risoluzione dei Problemi

- Se

booksè vuoto, ricontrolla i selettori CSS. - Se hai errori di codifica, apri il CSV con codifica UTF-8.

- Per più pagine, cicla su URL come

http://books.toscrape.com/catalogue/page-2.html.

Consiglio avanzato: Per siti dinamici o flussi complessi, valuta Selenium o Scrapy—oppure lascia che Thunderbit faccia tutto per te.

Conclusioni e Punti Chiave

Fare web scraping con Python apre un mondo di possibilità per chi lavora con i dati, dalla generazione di lead all’analisi di mercato. Ecco cosa abbiamo visto:

- Python è la scelta numero uno per il web scraping grazie a semplicità e librerie potenti.

- Requests e BeautifulSoup sono gli strumenti base per scaricare e analizzare HTML.

- Scrapy è perfetto per progetti di scraping su larga scala.

- Thunderbit offre un’alternativa no-code, basata su AI, per risultati immediati—ideale per chi vuole solo i dati senza scrivere codice.

- Pulizia e salvataggio sono fondamentali per trasformare i dati grezzi in informazioni utili.

Se vuoi approfondire, prova a creare il tuo estrattore su un sito di test, oppure e scopri quanto è veloce ottenere dati strutturati da qualsiasi sito. Per altri consigli e tutorial, visita il .

Buon scraping—che i tuoi dati siano sempre puliti, ordinati e pronti all’uso!

Domande Frequenti

1. Il web scraping è legale?

In generale, estrarre dati pubblici dai siti è legale, ma è importante rispettare i termini di servizio, il file robots.txt e le normative sulla privacy come il GDPR. Evita di raccogliere dati personali senza consenso e non cercare di aggirare login o barriere di sicurezza ().

2. Qual è la differenza tra Requests, BeautifulSoup e Scrapy?

- Requests scarica le pagine web.

- BeautifulSoup analizza ed estrae dati dall’HTML.

- Scrapy è un framework completo per crawling ed estrazione dati su larga scala, gestendo più pagine ed esportazioni.

3. E se il sito carica i dati tramite JavaScript?

Se i dati non sono nell’HTML iniziale, usa o Playwright per automatizzare il browser, oppure analizza le chiamate di rete per trovare API accessibili direttamente.

4. Come evitare di essere bloccati durante lo scraping?

Usa header realistici (soprattutto User-Agent), inserisci ritardi casuali tra le richieste e non sovraccaricare il server. Per scraping su larga scala, ruota gli IP o usa proxy ().

5. Posso estrarre dati senza programmare?

Assolutamente sì. ti permette di estrarre dati da qualsiasi sito in due clic grazie all’AI—senza scrivere codice. Installa l’estensione Chrome, descrivi cosa ti serve ed esporta subito i tuoi dati.

Per altre guide e consigli avanzati, non perderti il .

Approfondisci