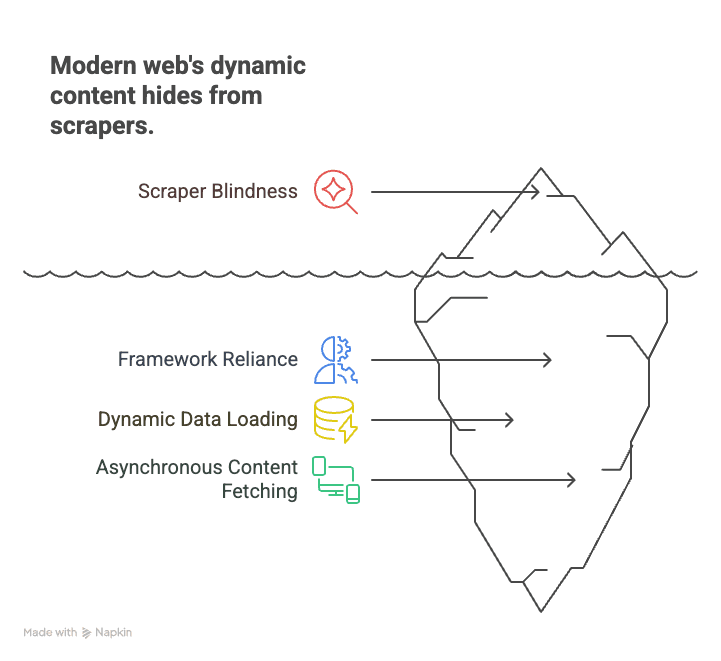

Se ti sei mai cimentato nell’estrazione di dati da un sito moderno—che sia un portale immobiliare, un ecommerce o il tuo social preferito—sai bene che spesso ti trovi davanti a un muro. Carichi la pagina, dai un’occhiata all’HTML e… niente. I dati che cerchi (prezzi, annunci, recensioni) sembrano spariti nel nulla. Il motivo? Oggi il web non è più solo HTML: quasi il 99% dei siti sfrutta JavaScript lato client per mostrare i contenuti (). I vecchi crawler sono come chi legge il copione di un film senza vedere le scene: si perdono tutta l’azione che avviene in tempo reale.

Dopo anni nel mondo SaaS e dell’automazione, ho visto come questo cambiamento abbia spiazzato aziende, team commerciali e ricercatori. Ma la bella notizia è che oggi il crawling JavaScript non è più roba da sviluppatori. Con il giusto approccio (e una mano da strumenti AI come ), chiunque può estrarre dati anche dai siti più dinamici e interattivi. Vediamo insieme cos’è il crawling JavaScript, perché è fondamentale e come iniziare—senza scrivere una riga di codice.

Cos’è il Crawling JavaScript? Perché è Fondamentale per Estrarre Dati dal Web di Oggi?

Partiamo dalle basi. Il crawling JavaScript significa usare uno strumento o un bot capace di caricare una pagina web, eseguire tutti gli script JavaScript e recuperare i contenuti che compaiono dopo che gli script sono stati eseguiti. È un salto enorme rispetto al vecchio scraping HTML, che si limitava a prendere il codice sorgente inviato dal server. Oggi, quell’HTML è spesso solo una cornice vuota: i veri dati (prodotti, recensioni, prezzi) vengono inseriti da JavaScript, magari solo dopo che hai scrollato o cliccato qualcosa.

Perché è così importante? Perché il web moderno gira su framework come React, Angular e Vue. Queste SPA (Single Page Application) caricano i dati in tempo reale, lasciando al buio gli scraper statici. Qualche esempio:

- Ecommerce: Prezzi e disponibilità appaiono solo dopo aver scrollato o selezionato un filtro.

- Immobiliare: Gli annunci si caricano man mano che scorri, con dettagli aggiunti al volo.

- Social media: Post, commenti e like vengono recuperati in modo asincrono, quindi non sono visibili nell’HTML iniziale.

I crawler tradizionali vedono solo una pagina vuota e si perdono tutto il resto. Il crawling JavaScript, invece, è come aprire la pagina in Chrome, lasciar caricare tutto e poi estrarre quello che vedi—proprio come farebbe una persona.

In breve: Se vuoi estrarre dati da quasi qualsiasi sito moderno nel 2025, devi imparare il crawling JavaScript. Altrimenti, ti perdi la maggior parte delle informazioni ().

Le Sfide Principali del Crawling JavaScript (e Come Superarle)

Il crawling JavaScript non è solo “scraping con qualche passaggio in più”. Ha le sue difficoltà specifiche. Ecco cosa ti aspetta—e come puoi affrontarlo.

Rendering Dinamico dei Contenuti

La sfida: La maggior parte dei contenuti non si trova nell’HTML. Viene caricata da JavaScript dopo l’apertura della pagina—magari dopo uno scroll, un click o una chiamata di rete. Se prendi solo l’HTML, ottieni contenitori vuoti o segnaposto.

La soluzione: Usa un browser headless—uno strumento che simula un vero browser, esegue tutti gli script e aspetta che i contenuti compaiano. Strumenti come e sono lo standard. Permettono di:

- Aprire una pagina e lasciare che JavaScript venga eseguito.

- Attendere che elementi specifici si carichino (ad esempio “.product-list”).

- Estrarre i contenuti completi dal DOM.

Questo metodo è ormai il riferimento per estrarre dati da siti dinamici ().

Barriere Anti-Bot e Anti-Automazione

La sfida: I siti sono sempre più bravi a bloccare i bot. Puoi imbatterti in:

- CAPTCHA

- Ban di IP o limiti di frequenza

- Browser fingerprinting (capiscono se sei un utente reale)

- Honeypot (link-trappola per bot)

La soluzione: Agisci in modo responsabile e simula il comportamento umano:

- Rispetta robots.txt e i termini d’uso.

- Modera le richieste—aggiungi ritardi casuali, non stressare il server.

- Ruota gli IP se estrai dati su larga scala (sempre in modo etico).

- Usa header reali del browser ed evita segnali evidenti da bot.

- Non superare login o CAPTCHA senza autorizzazione.

Thunderbit, ad esempio, invita gli utenti a estrarre solo dati pubblici e integra le migliori pratiche per la conformità ().

Scroll Infinito ed Eventi Attivati dall’Utente

La sfida: Molti siti usano lo scroll infinito o richiedono click per caricare altri dati. Se il tuo scraper prende solo ciò che è visibile all’inizio, ti perdi la maggior parte dei contenuti.

La soluzione: Usa l’automazione del browser per:

- Simulare lo scroll (caricando più risultati come farebbe un utente).

- Cliccare su pulsanti “Carica altro” o su tab.

- Attendere che i nuovi contenuti compaiano prima di estrarre i dati.

L’AI di Thunderbit riconosce questi schemi e gestisce automaticamente scroll e paginazione, senza bisogno di script personalizzati ().

Prestazioni e Scalabilità

La sfida: Ogni pagina aperta con un browser headless consuma molte risorse. Estrarre dati da centinaia o migliaia di pagine può essere lento e pesante per il tuo computer.

La soluzione: Usa il crawling concorrente—apri più browser o tab in parallelo. O, ancora meglio, delega tutto al cloud. L’acceleratore cloud di Thunderbit (Lightning Network) può estrarre dati da 50 pagine contemporaneamente, velocizzando enormemente i lavori più grandi ().

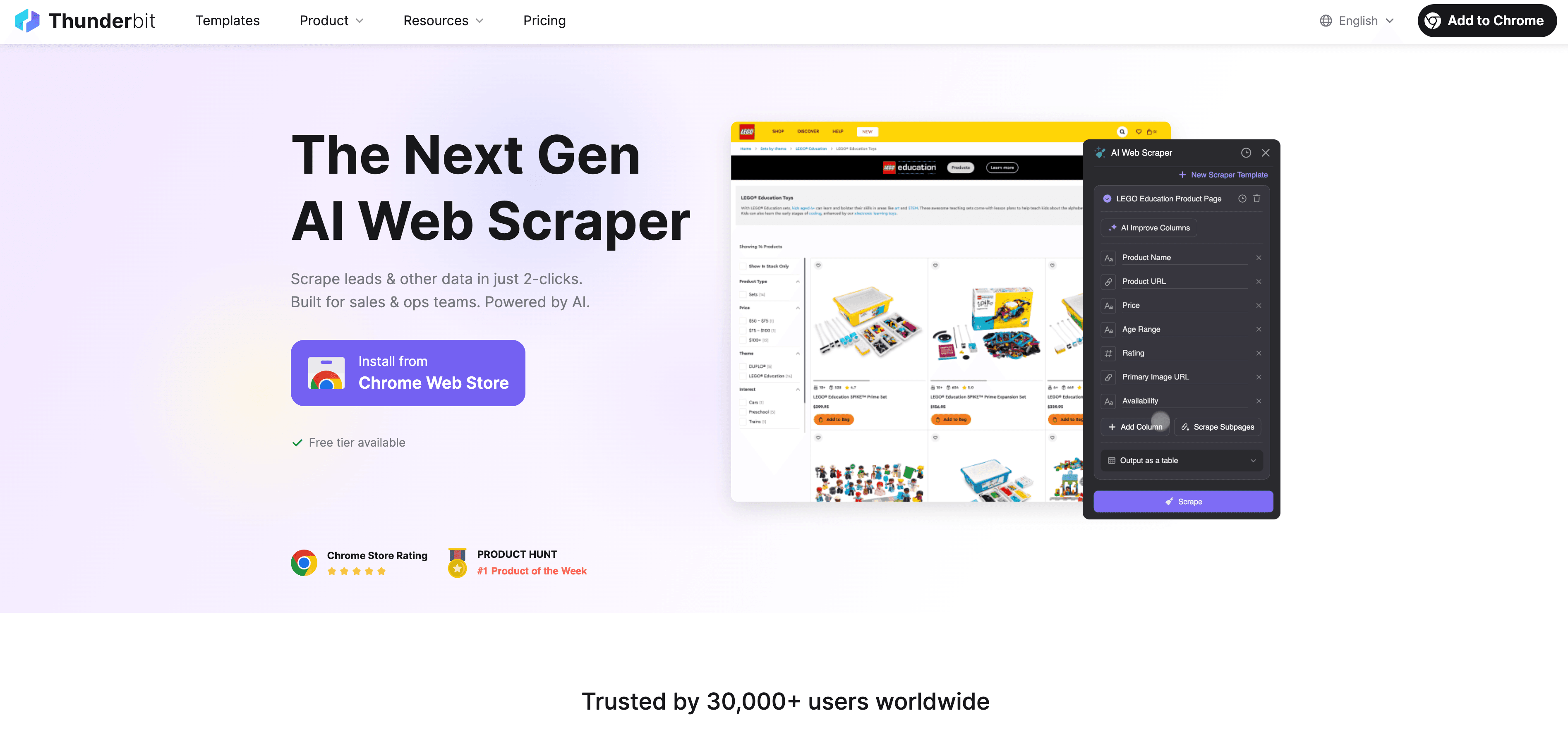

Thunderbit: Il Modo Più Semplice e Potente per il Crawling JavaScript

Diciamolo chiaro: la maggior parte degli utenti business non vuole scrivere codice, debuggare selettori o gestire script. Ecco perché abbiamo creato : un estrattore web AI pensato per chi ha bisogno di dati da siti dinamici e ricchi di JavaScript, senza essere sviluppatore.

Ecco come Thunderbit rende il crawling JavaScript una passeggiata:

- AI Suggerisci Campi: Basta cliccare su “AI Suggerisci Campi” e l’AI di Thunderbit analizza la pagina, suggerisce le colonne migliori da estrarre e imposta i tipi di dati giusti. Niente più tentativi a vuoto.

- Estrazione in Linguaggio Naturale: Descrivi ciò che vuoi in italiano (“Prendi nome prodotto, prezzo e valutazione”) e Thunderbit capisce come ottenerlo.

- Gestione dei Contenuti Dinamici: Thunderbit lavora in un vero browser (il tuo Chrome o nel cloud), esegue tutto il JavaScript e aspetta che i dati si carichino—proprio come farebbe una persona.

- Supporto Subpagine e Paginazione: Devi estrarre dati da più pagine o seguire link a sottopagine (come dettagli prodotto)? Thunderbit lo fa in automatico, unendo tutto in una sola tabella.

- Accelerazione Cloud: Per lavori grandi, la Lightning Network di Thunderbit estrae dati da 50 pagine alla volta nel cloud, senza affaticare il tuo PC.

- Interfaccia No-Code e Intuitiva: Se sai usare Excel, sai usare Thunderbit. Tutto a portata di click, senza configurazioni tecniche.

- Esportazione Gratuita dei Dati: Esporta i dati su Excel, Google Sheets, Airtable, Notion o in formato JSON—senza costi aggiuntivi.

Thunderbit è già scelto da oltre 30.000 utenti in tutto il mondo, tra team commerciali, operatori ecommerce e professionisti del settore immobiliare ().

AI Suggerisci Campi & Estrazione in Linguaggio Naturale

Qui Thunderbit fa davvero la differenza. Invece di cercare nell’HTML o scrivere selettori XPath, basta un click e l’AI fa tutto il lavoro pesante. Analizza la pagina, ne comprende la struttura e suggerisce esattamente cosa estrarre. Vuoi qualcosa di specifico? Scrivilo in italiano—l’AI di Thunderbit lo collega agli elementi giusti.

È una svolta per chi inizia: non serve conoscere HTML, CSS o JavaScript. Basta dire cosa vuoi e lasciare che l’AI si occupi del resto ().

Paginazione e Crawling di Sottopagine

Thunderbit non si limita a una sola pagina. Può:

- Riconoscere e gestire la paginazione (cliccando su “Avanti” o scrollando per caricare altri dati).

- Estrarre dati da sottopagine (come dettagli prodotto, profili autore o recensioni) e unirli alla tabella principale.

- Gestire lo scroll infinito simulando le azioni dell’utente, così ottieni tutti i dati, non solo quelli visibili all’inizio.

Ad esempio, vuoi estrarre tutti i prodotti di una categoria ecommerce con 20 pagine? Thunderbit clicca su ogni pagina e unisce i risultati. Ti servono dettagli da ogni scheda prodotto? Attiva il crawling delle sottopagine e Thunderbit visita ogni link, raccoglie le info aggiuntive e arricchisce il tuo dataset ().

Lightning Network & Accelerazione Cloud: Scala il Tuo Crawling JavaScript

Se devi estrarre dati da centinaia o migliaia di pagine, farlo una per volta non è sostenibile. Qui entra in gioco la Lightning Network di Thunderbit.

- Scraping nel Cloud: Affida il lavoro pesante ai server cloud di Thunderbit (in USA, UE e Asia). Il cloud può estrarre dati da 50 pagine contemporaneamente, velocizzando enormemente i lavori più grandi.

- Crawling Concorrente: Invece di aspettare che ogni pagina si carichi nel tuo browser, il cloud di Thunderbit suddivide il lavoro tra molti worker. Devi estrarre dati da 1.000 pagine prodotto? Il cloud lo fa in pochi minuti, non in ore.

- Crawling Programmato: Vuoi monitorare prezzi o annunci ogni giorno? Imposta una raccolta programmata in linguaggio naturale (“ogni giorno alle 9”) e Thunderbit eseguirà il lavoro in automatico, esportando i dati su Google Sheet o nel tuo database ().

È la soluzione perfetta per team commerciali, ecommerce e operations che hanno bisogno di dati aggiornati su larga scala—senza sviluppatori o server dedicati.

Estrazione Multi-Pagina e Bulk

Thunderbit ti permette di:

- Estrarre interi elenchi o cataloghi (ad esempio tutti i prodotti di una categoria, tutti gli annunci di una zona).

- Esportare i risultati su Excel, Google Sheets, Airtable o Notion con un click.

- Risparmiare ore (o giorni) di lavoro manuale—un utente ha estratto centinaia di annunci immobiliari, con dettagli degli agenti, in meno di 10 minuti.

Guida Pratica: Come Iniziare il Crawling JavaScript con Thunderbit

Vuoi provarlo? Ecco come iniziare con Thunderbit—anche se non hai mai estratto dati da un sito.

Configura la Tua Prima Estrazione

- Installa Thunderbit: Scarica l’. Registrati gratuitamente.

- Scegli il Sito: Vai sul sito da cui vuoi estrarre dati. Se serve il login, accedi prima (Thunderbit lavora nel tuo browser).

- Apri Thunderbit: Clicca sull’icona Thunderbit nella barra di Chrome. Scegli la fonte dati (pagina attuale, elenco di URL o caricamento file).

- Scegli la Modalità di Esecuzione: Per lavori piccoli o siti con login, usa la modalità Browser. Per grandi volumi, passa alla modalità Cloud per estrazione parallela.

- AI Suggerisci Campi: Clicca su “AI Suggerisci Campi”. L’AI di Thunderbit analizzerà la pagina e suggerirà le colonne da estrarre (es. “Nome Prodotto”, “Prezzo”, “URL Immagine”).

- Personalizza le Colonne: Rinomina, aggiungi o rimuovi campi secondo le tue esigenze. Aggiungi istruzioni AI personalizzate per formattare o categorizzare i dati.

- Configura Paginazione/Scroll: Se il sito usa paginazione o scroll infinito, attiva l’opzione corrispondente nelle impostazioni di Thunderbit.

- Clicca su “Estrai”: Thunderbit caricherà le pagine, eseguirà tutto il JavaScript ed estrarrà i dati in una tabella.

Estrazione ed Esportazione dei Dati

- Anteprima Risultati: Thunderbit mostra i dati in tabella. Controlla che siano completi e corretti.

- Esporta: Clicca su “Esporta” per scaricare in Excel, CSV, JSON o inviare direttamente su Google Sheets, Airtable o Notion.

- Verifica: Confronta qualche riga con il sito live per assicurarti che tutto sia corretto.

- Risoluzione Problemi: Se mancano dati, prova a scrollare la pagina, modifica le istruzioni AI o passa alla modalità Cloud per prestazioni migliori.

Per guide dettagliate, consulta la o il .

Best Practice per un Crawling JavaScript Sicuro e Conforme

Con grandi poteri di scraping arrivano grandi responsabilità. Ecco come restare dalla parte giusta della legge (e dell’etica):

- Rispetta robots.txt e i Termini di Servizio: Controlla sempre se il sito consente lo scraping. Se è vietato, non rischiare ().

- Evita di estrarre dati personali: GDPR e CCPA considerano nomi, email e profili come dati protetti—anche se pubblici. Estrai info personali solo se hai un motivo valido e consenso.

- Non superare login o CAPTCHA: È un’area grigia (o peggio). Limita l’estrazione ai dati pubblici.

- Modera le richieste: Non sovraccaricare i server. La modalità cloud di Thunderbit distanzia le richieste e ruota gli IP per evitare blocchi.

- Usa i dati in modo etico: Non ripubblicare contenuti protetti da copyright o usare i dati in modo improprio.

- Cancella su richiesta: Se qualcuno chiede la rimozione dei suoi dati, fallo subito.

Thunderbit è progettato per favorire la conformità—solo dati pubblici, niente hacking, esportazione trasparente per un uso responsabile.

Come Evitare Rischi Legali

- Limita l’estrazione a dati pubblici e non personali.

- Non estrarre dati da siti che lo vietano esplicitamente.

- In caso di dubbi, chiedi il permesso o usa l’API ufficiale del sito.

- Tieni traccia di cosa hai estratto e quando.

- Rispetta subito eventuali richieste di rimozione.

Per approfondire, leggi .

Confronto tra Soluzioni di Crawling JavaScript: Thunderbit vs. Strumenti Tradizionali

| Aspetto | Puppeteer/Playwright (Codice) | Sitebulb (SEO Crawler) | Thunderbit (AI No-Code) |

|---|---|---|---|

| Tempo di Configurazione | Ore (richiede codice) | Medio (configurazione) | Minuti (punta e clicca) |

| Competenze Richieste | Alte (solo sviluppatori) | Medie | Basse (chiunque) |

| Gestione Contenuti JS | Sì (script manuali) | Sì (per SEO) | Sì (AI, automatico) |

| Paginazione/Sottopagine | Script manuali | Limitato | Automatico (AI rileva) |

| Manutenzione | Alta (si rompe ai cambi) | Media | Bassa (AI si adatta) |

| Scalabilità | Manuale (scrivere codice) | Limitata | Cloud integrato (50x) |

| Esportazione | Manuale (scrivere codice) | CSV/Excel | Excel, Sheets, Notion |

| Ideale per | Dev, flussi personalizzati | Audit SEO | Utenti business, analisti |

Thunderbit è la scelta ideale per chi vuole risultati rapidi senza complicazioni tecniche ().

Conclusioni & Punti Chiave

Il crawling JavaScript non è più una competenza di nicchia—è fondamentale per chiunque abbia bisogno di dati web nel 2025. Con quasi il 99% dei siti che usano script lato client, lo scraping tradizionale non basta più (). La buona notizia? Non serve essere sviluppatori per impararlo.

Ecco cosa ricordare:

- I contenuti dinamici sono ovunque: Per estrarre dati dai siti moderni serve uno strumento che esegua JavaScript.

- Le sfide ci sono, ma si superano: Browser headless, attese intelligenti e accelerazione cloud permettono di estrarre anche i dati più complessi.

- Thunderbit semplifica tutto: Con suggerimenti AI, estrazione in linguaggio naturale, supporto a sottopagine e paginazione, e accelerazione cloud, Thunderbit rende il crawling JavaScript accessibile a tutti.

- Rispetta le regole: Segui sempre le policy dei siti, le leggi sulla privacy e le linee guida etiche.

- Inizia subito: Installa Thunderbit, scegli un sito e scopri quanti dati puoi ottenere in pochi click.

Vuoi approfondire? Dai un’occhiata al per altre guide, o guarda i nostri per demo passo-passo.

Buon crawling—che i tuoi dati siano sempre dinamici, completi e pronti all’uso.

Domande Frequenti

1. Cos’è il crawling JavaScript e in cosa si differenzia dallo scraping tradizionale?

Il crawling JavaScript utilizza uno strumento che carica una pagina web, esegue tutti gli script JavaScript ed estrae i contenuti che compaiono dopo l’esecuzione degli script. Lo scraping tradizionale prende solo l’HTML grezzo, perdendo la maggior parte dei dati sui siti moderni.

2. Perché serve il crawling JavaScript per estrarre dati business?

Perché quasi tutti i siti moderni usano JavaScript per caricare i contenuti in modo dinamico. Senza crawling JavaScript, ti perdi annunci, recensioni, prezzi e altri dati chiave.

3. Come Thunderbit semplifica il crawling JavaScript per chi inizia?

Thunderbit usa l’AI per suggerire i campi, gestire i contenuti dinamici e automatizzare paginazione e sottopagine. Puoi descrivere ciò che vuoi in italiano—senza scrivere codice.

4. Il crawling JavaScript è legale? A cosa devo fare attenzione?

Il crawling JavaScript è legale se fatto responsabilmente—limita l’estrazione ai dati pubblici, rispetta robots.txt e i termini d’uso, ed evita dati personali senza consenso. Thunderbit promuove la conformità e l’uso responsabile.

5. Come posso scalare il crawling JavaScript per lavori grandi?

La Lightning Network di Thunderbit (scraping cloud) ti permette di estrarre dati da 50 pagine alla volta, rendendo semplice gestire grandi volumi come monitoraggio prezzi o lead generation su migliaia di pagine.

Per Saperne di Più: