Lasciami dire una cosa: poche cose nel mondo digitale danno la stessa soddisfazione di vedere un elenco ordinato e completo di tutte le pagine di un sito web—è un po’ come ritrovare finalmente tutti i calzini dopo aver fatto il bucato. Ma se ti sei mai cimentato nel recuperare tutte le pagine di un sito per un audit dei contenuti, una migrazione o anche solo per curiosità, sai bene che la faccenda è tutt’altro che semplice. Ho visto team passare ore (o addirittura giorni) a mettere insieme elenchi da sitemap, ricerche su Google ed esportazioni dal CMS, solo per scoprire che mancavano ancora pagine nascoste o dinamiche. E non ti dico quella volta che ho aiutato un amico a esportare tutti gli URL del suo WordPress—tra caffè e crisi esistenziali, è stata un’avventura.

La buona notizia? Non devi più giocare a nascondino digitale con il tuo sito. In questa guida ti spiego tutti i metodi principali per trovare gli URL di un sito web—dai classici ai più innovativi—compreso come strumenti basati sull’AI come possono rendere il processo molto più rapido, completo e, perché no, anche piacevole. Che tu sia un marketer, uno sviluppatore o semplicemente quello a cui hanno detto “recupera tutti gli URL”, qui trovi passaggi pratici, esempi reali e confronti sinceri per scegliere la soluzione migliore per il tuo team.

Perché potresti aver bisogno di recuperare tutte le pagine di un sito: casi d’uso reali

Prima di vedere come si fa, parliamo del perché. Perché così tanti team hanno bisogno di trovare tutti gli URL di un sito? Non è solo una questione SEO—è una necessità che riguarda marketing, vendite, IT e operations. Ecco alcuni degli scenari più comuni:

- Audit SEO e strategia dei contenuti: Gli audit dei contenuti sono ormai la norma, con . Un elenco completo di URL è la base per valutare le performance, aggiornare i vecchi contenuti e migliorare il posizionamento. Infatti, .

- Restyling e migrazioni del sito: ), e ogni migrazione richiede una mappatura degli URL per evitare link rotti e perdita di SEO.

- Compliance e manutenzione: I team operativi devono individuare pagine orfane o obsolete—magari vecchi micrositi di campagne ancora online, pronti a creare imbarazzo.

- Analisi della concorrenza: Marketing e vendite estraggono le pagine dei competitor per elenchi di prodotti, prezzi o articoli, alla ricerca di opportunità o lead.

- Lead generation e outreach: I team commerciali spesso devono raccogliere elenchi di store locator, directory di rivenditori o pagine membri per attività di outreach.

- Inventario dei contenuti: I content marketer tengono traccia di tutti i post, landing page, PDF e altro per evitare duplicazioni e massimizzare il valore.

Ecco una tabella riassuntiva degli scenari:

| Scenario | Chi ne ha bisogno | Perché serve un elenco completo |

|---|---|---|

| Audit SEO / Audit contenuti | SEO specialist, Content marketer | Valutare ogni contenuto; pagine mancanti = analisi incompleta, opportunità di ottimizzazione perse |

| Migrazione/Restyling sito | Sviluppatori web, SEO, IT, Marketing | Mappare vecchi e nuovi URL, impostare redirect, evitare link rotti e perdita SEO |

| Analisi competitor | Marketing, Vendite | Vedere tutte le pagine dei competitor; le pagine nascoste possono rivelare opportunità |

| Lead Generation | Team commerciali | Raccogliere pagine di contatto/risorse per outreach; nessun potenziale lead viene perso |

| Inventario contenuti | Content marketing | Mantenere un archivio aggiornato, individuare gap, evitare duplicati e revisionare vecchie pagine |

E l’impatto di pagine mancanti o nascoste? È concreto. Immagina di pianificare un restyling e dimenticare una landing page che ancora converte, o di fare un audit e perdere il 5% delle pagine perché non sono indicizzate. Questo significa perdita di fatturato, penalizzazioni SEO e, a volte, grattacapi di PR che non avevi previsto.

I metodi tradizionali per trovare gli URL di un sito: panoramica

Entriamo nel vivo: come si fa, davvero, a recuperare tutte le pagine di un sito? Esistono diversi metodi collaudati—alcuni rapidi e semplici, altri più approfonditi (e spesso più laboriosi). Ecco una panoramica:

Ricerca Google e operatori di ricerca

Come funziona:

Apri Google e digita site:iltuosito.com. Google mostrerà tutte le pagine che ha indicizzato per quel dominio. Puoi affinare la ricerca con parole chiave o sottocartelle (es. site:iltuosito.com/blog).

Cosa ottieni:

Un elenco delle pagine indicizzate—cioè quelle che Google conosce del tuo sito.

Limitazioni:

- Mostra solo ciò che è indicizzato, non tutto ciò che esiste

- Si ferma dopo poche centinaia di risultati, anche per siti grandi

- Non mostra pagine nuove, nascoste o volutamente non indicizzate

Quando usarlo:

Perfetto per una panoramica veloce o per siti piccoli, ma non per un audit completo.

Controllo di robots.txt e Sitemap.xml

Come funziona:

Visita iltuosito.com/robots.txt e cerca le righe “Sitemap:”. Apri la sitemap (di solito iltuosito.com/sitemap.xml o /sitemap_index.xml). Le sitemap elencano gli URL che il proprietario vuole far indicizzare.

Cosa ottieni:

Un elenco delle pagine principali—spesso tutti i post, le pagine prodotto, ecc. .

Limitazioni:

- Le sitemap includono solo le pagine che il proprietario vuole indicizzare—le pagine orfane o nascoste spesso mancano

- Le sitemap possono essere obsolete se non vengono rigenerate

- Alcuni siti hanno più sitemap; potresti doverle cercare

Quando usarlo:

Perfetto se possiedi il sito o vuoi una panoramica delle pagine principali di un competitor. Ma ricorda: vedi solo ciò che il proprietario vuole mostrarti.

SEO Spider e crawler

Come funziona:

Strumenti come Screaming Frog, Sitebulb o DeepCrawl simulano un crawler dei motori di ricerca. Inserisci l’URL del sito e lo strumento segue tutti i link interni, costruendo un elenco delle pagine trovate.

Cosa ottieni:

Potenzialmente tutte le pagine collegate internamente, più dati come codici di stato e meta tag.

Limitazioni:

- Le pagine orfane (non collegate) vengono perse a meno che non vengano inserite manualmente

- Le pagine dinamiche o generate da JavaScript possono essere saltate se lo strumento non supporta la navigazione headless

- La scansione di siti grandi può richiedere molto tempo e risorse

- Richiede competenze tecniche e configurazione

Quando usarlo:

Ideale per SEO specialist o sviluppatori che fanno audit approfonditi. Meno adatto a chi non ha competenze tecniche.

Google Search Console e Analytics

Come funziona:

Se hai accesso al sito, Google Search Console (GSC) e Analytics permettono di esportare elenchi di URL.

- GSC: I report Copertura e Prestazioni mostrano URL indicizzati ed esclusi (fino a 1.000 per esportazione, di più via API).

- Analytics: Mostra tutte le pagine che hanno ricevuto traffico in un certo periodo (GA4 consente fino a 100.000 righe per esportazione).

Limitazioni:

- GSC e Analytics mostrano solo le pagine che Google conosce o che hanno ricevuto traffico

- Limiti di esportazione (1.000 righe per GSC, 100k per GA4)

- Richiede proprietà/verifica del sito; non utilizzabile per analisi competitor

- Le pagine senza traffico o non indicizzate non compaiono

Quando usarlo:

Ottimo per il proprio sito, soprattutto prima di una migrazione o audit. Non adatto per analisi della concorrenza.

Dashboard del CMS

Come funziona:

Se il sito è su WordPress, Shopify o altro CMS, spesso puoi esportare l’elenco di pagine e post direttamente dal pannello di amministrazione (a volte serve un plugin).

Cosa ottieni:

Un elenco di tutti i contenuti—pagine, post, prodotti, ecc.

Limitazioni:

- Richiede accesso admin

- Potrebbe non includere pagine dinamiche o non di contenuto

- Se il sito usa più sistemi (blog, shop, documentazione), dovrai unire le esportazioni

Quando usarlo:

Ideale per chi possiede il sito e vuole fare un inventario o un backup. Non utile per analisi competitor.

I limiti dei metodi tradizionali per recuperare le pagine di un sito

Diciamolo chiaro: nessuno di questi metodi è perfetto. Ecco i principali punti deboli:

- Complessità tecnica: Molti metodi richiedono competenze tecniche o strumenti specifici. Per chi non è esperto, può essere un vero ostacolo. Un audit manuale può richiedere .

- Copertura incompleta: Ogni metodo può saltare alcune pagine—l’indice di Google non mostra le non indicizzate o nuove, le sitemap saltano le orfane, i crawler saltano le non collegate o dinamiche, le esportazioni CMS tutto ciò che è fuori dal sistema.

- Sforzo manuale e tempo: Spesso bisogna unire dati da più fonti, deduplicare e pulire—un lavoro noioso e soggetto a errori. C’è chi condivide “trucchi” come copiare/incollare da sitemap in Excel o usare script da terminale.

- Aggiornamento e freschezza: Gli elenchi diventano obsoleti rapidamente. I metodi tradizionali richiedono di ripetere tutto ogni volta che il sito cambia.

- Accesso e permessi: Alcuni metodi richiedono accesso admin o proprietà del sito—non adatti per analisi competitor.

- Sovraccarico di dati: I crawler SEO possono sommergerti di dati tecnici quando ti serve solo un semplice elenco di URL.

In sintesi, il processo tradizionale è come “cercare di cucinare una torta mentre la ricetta cambia in continuazione e il forno ogni tanto si blocca.” (Sì, è una vera analogia di una content strategist—e la capisco bene.)

Scopri Thunderbit: il modo AI per trovare tutti gli URL di un sito

E ora la parte interessante. E se potessi semplicemente chiedere a un assistente “vai su quel sito e fammi l’elenco di tutte le pagine”, e lui lo facesse davvero—senza codice, senza complicazioni? Questo è esattamente ciò che fa .

Thunderbit è un’estensione Chrome Estrattore Web AI pensata per chi non è tecnico (ma abbastanza potente anche per i professionisti). Usa l’intelligenza artificiale per “leggere” i siti, strutturare i dati ed esportare tutti gli URL—comprese pagine nascoste, dinamiche e sottopagine. Non serve scrivere codice o configurare impostazioni complesse. Basta aprire il sito, cliccare su “AI Suggerisci Campi” e lasciare che Thunderbit faccia il lavoro pesante.

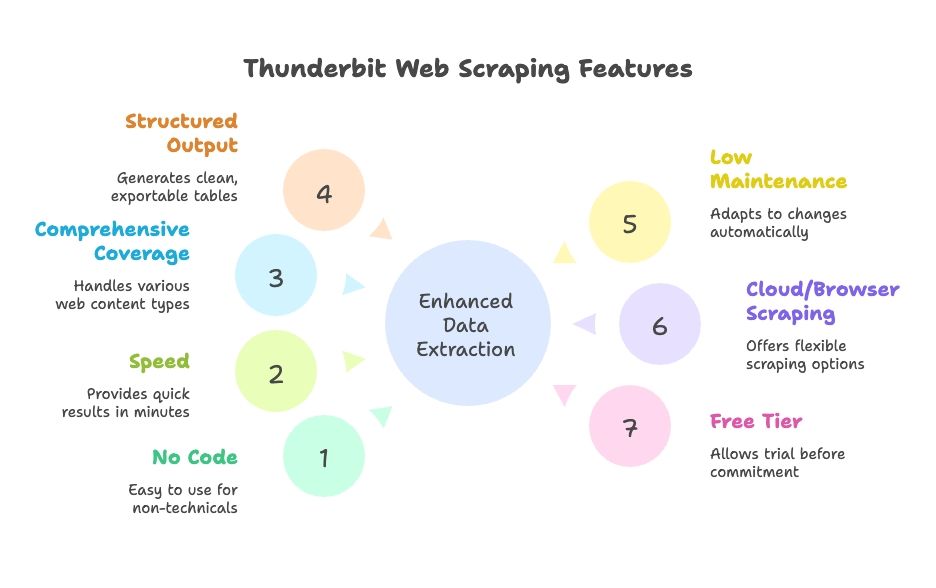

Perché Thunderbit fa la differenza:

- Nessun codice o configurazione: Interfaccia in linguaggio naturale, guidata dall’AI. Tutti nel team possono usarlo.

- Velocità: Risultati in pochi minuti, non ore.

- Copertura completa: Gestisce contenuti dinamici, paginazione, infinite scroll e sottopagine.

- Output strutturato: Tabelle pulite, pronte per l’esportazione su Google Sheets, Excel, Airtable, Notion, CSV o JSON.

- Bassa manutenzione: L’AI si adatta automaticamente ai cambiamenti del sito; meno aggiustamenti necessari.

- Cloud o scraping da browser: Scegli la modalità più adatta al tuo flusso di lavoro.

- Versione gratuita disponibile: Provalo senza impegno.

Come Thunderbit semplifica il recupero delle pagine di un sito

Vediamo in pratica come funziona Thunderbit. Ti mostro come passare da “mi serve l’elenco di tutte le pagine del mio sito” a “ecco il foglio Excel, capo” in pochi clic.

Passo 1: Installa e avvia Thunderbit

Scarica la e fissala nel browser. Vai sul sito che vuoi analizzare (ad esempio la homepage) e clicca sull’icona Thunderbit per aprire l’interfaccia.

Consiglio: Thunderbit offre crediti gratuiti ai nuovi utenti, così puoi provarlo senza inserire la carta di credito.

Passo 2: Scegli la fonte dei dati

Thunderbit di default estrae i dati dalla pagina corrente, ma puoi anche inserire un elenco di URL (come una sitemap o pagine di categoria) se vuoi partire da una sezione specifica.

- Per la maggior parte dei siti, inizia dalla homepage o dalla pagina della sitemap.

- Per e-commerce, puoi partire da una categoria o da una pagina elenco prodotti.

Passo 3: Usa “AI Suggerisci Campi” per rilevare gli URL

Qui entra in gioco la magia dell’AI. Clicca su “AI Suggerisci Campi” (o “AI Suggerisci Colonne”). L’AI di Thunderbit analizza la pagina, riconosce i pattern e suggerisce colonne come “Titolo Pagina” e “URL Pagina” per tutti i link trovati. Puoi modificare queste colonne secondo le tue esigenze.

- Sulla homepage, potresti ottenere link di navigazione, footer e link in evidenza.

- Su una sitemap, avrai un elenco pulito di URL.

- Puoi aggiungere o rimuovere colonne, o affinare ciò che vuoi estrarre.

L’AI di Thunderbit fa il lavoro difficile—niente più XPaths o selettori CSS. È come avere uno stagista robot che capisce davvero cosa vuoi.

Passo 4: Attiva lo scraping delle sottopagine

La maggior parte dei siti non elenca tutte le pagine in homepage. Qui entra in gioco la funzione Scraping Sottopagine di Thunderbit. Segna la colonna URL come link da “seguire” e Thunderbit cliccherà su ogni link trovato, estraendo altri URL da quelle pagine. Puoi anche impostare template annidati per scraping multi-livello.

- Per elenchi paginati o pulsanti “carica altri”, attiva Paginazione & Scorrimento così Thunderbit continua finché trova tutto.

- Per siti con sottodomini o sezioni (come un blog su ), Thunderbit può seguirli se lo indichi.

Passo 5: Avvia lo scraping

Clicca su “Estrai” e guarda Thunderbit all’opera. Riempirà una tabella con gli URL (e altri campi scelti) in tempo reale. Per siti grandi, puoi lasciarlo lavorare in background e tornare quando ha finito.

Passo 6: Rivedi ed esporta

Al termine, rivedi i risultati—Thunderbit ti permette di ordinare, filtrare e rimuovere duplicati direttamente nell’app. Poi esporta i dati con un clic su Google Sheets, Excel, CSV, Airtable, Notion o JSON. Niente più copia-incolla o formattazioni caotiche.

Tutto il processo? Per un sito piccolo o medio, puoi ottenere l’elenco completo degli URL in meno di 10 minuti. Per siti grandi, resta comunque molto più veloce (e meno stressante) che mettere insieme dati da più fonti.

Scoprire pagine nascoste e dinamiche con Thunderbit

Una delle funzioni che preferisco di Thunderbit è la gestione delle pagine che i tool tradizionali spesso saltano:

- Contenuti generati da JavaScript: Poiché Thunderbit lavora in un vero browser, può catturare pagine che si caricano dinamicamente (come job board o elenchi prodotti con scroll infinito).

- Pagine orfane o non collegate: Se hai un indizio (come una sitemap o una funzione di ricerca), Thunderbit può usarlo per trovare pagine non collegate altrove.

- Sottodomini o sezioni: Thunderbit può seguire i link tra sottodomini se necessario, dandoti una visione completa del sito.

- Interazione come un utente: Devi compilare una casella di ricerca o cliccare un filtro per svelare pagine nascoste? Il Riempimento automatico AI di Thunderbit gestisce anche questo.

Esempio reale: Un team marketing doveva trovare tutte le vecchie landing page—molte non erano più collegate ma esistevano ancora. Usando Thunderbit per estrarre i risultati di Google e inserendo pattern noti di URL, hanno recuperato decine di pagine dimenticate, evitando confusione (e qualche grattacapo).

Thunderbit vs. metodi tradizionali: velocità, semplicità e copertura

Mettiamo Thunderbit a confronto diretto con i metodi classici:

| Aspetto | Ricerca Google “site:” | Sitemap XML | SEO Crawler (Screaming Frog) | Google Search Console | Esportazione CMS | Estrattore Web AI Thunderbit |

|---|---|---|---|---|---|---|

| Velocità | Molto veloce, ma limitata | Istantanea se disponibile | Variabile (minuti/ore) | Rapida per siti piccoli | Istantanea per siti piccoli | Veloce, configurazione in pochi minuti, scraping automatico |

| Facilità d’uso | Molto facile | Facile | Media (richiede setup) | Media | Facile (se admin) | Facilissima, nessun codice |

| Copertura | Bassa (solo indicizzate) | Alta per le pagine previste | Alta per le collegate | Alta per indicizzate, limite export | Media (solo contenuti) | Altissima, gestisce dinamiche e sottopagine |

| Output & integrazione | Copia-incolla manuale | XML (da elaborare) | CSV con molti dati extra | CSV/Excel, max 1.000 righe | CSV/XML, da pulire | Tabella pulita, export 1-click su Sheets, Excel, ecc. |

| Manutenzione | Da rifare manualmente | Da aggiornare | Nuova scansione a ogni modifica | Export periodico | Export dopo modifiche | Bassa—AI si adatta, puoi programmare scraping |

Thunderbit eccelle per facilità d’uso, completezza e integrazione. I metodi tradizionali hanno ciascuno i loro punti di forza, ma richiedono più lavoro per unire i risultati e mantenerli aggiornati. L’AI di Thunderbit si adatta ai cambiamenti del sito, così non devi continuamente modificare impostazioni o ripetere esportazioni manuali.

Quale metodo scegliere: a chi conviene cosa?

Allora, quale metodo fa per te? Ecco il mio consiglio, dopo anni passati ad aiutare team a gestire i dati dei loro siti:

- SEO specialist / Sviluppatori: Se ti servono dati tecnici approfonditi (meta tag, link rotti, ecc.) o stai auditando un sito enterprise enorme, un crawler o uno script personalizzato può avere senso. Ma anche in questi casi, Thunderbit ti dà rapidamente l’elenco degli URL da usare con altri strumenti.

- Marketer, content strategist, project manager: Thunderbit è una salvezza. Niente più attese per l’IT o esportazioni da unire. Se ti serve un inventario dei contenuti, un’analisi competitor o un audit veloce, con Thunderbit fai tutto da solo.

- Team commerciali / Lead gen: Thunderbit rende facile estrarre elenchi di sedi, eventi o directory membri da qualsiasi sito—senza codice.

- Siti piccoli / Attività rapide: Per siti minuscoli, un controllo manuale o la sitemap può bastare. Ma Thunderbit è così veloce da valere comunque la pena, per non rischiare di dimenticare nulla.

- Budget: I metodi tradizionali costano poco (a parte il tuo tempo). Thunderbit ha una versione gratuita e piani a pagamento accessibili. Ricorda: il tuo tempo ha valore!

- Esigenze dati molto personalizzate: Se ti servono dati molto specifici o logiche complesse, uno scraper personalizzato può essere necessario. Ma l’AI di Thunderbit copre la maggior parte dei casi con pochissima configurazione.

Consigli pratici:

- Se hai meno di 1.000 pagine, prova l’export da Google Search Console—ma verifica che sia completo.

- Se non hai accesso al sito o ti serve analizzare un competitor, Thunderbit o un crawler sono la scelta giusta.

- Se vuoi risparmiare tempo e avere una soluzione scalabile, Thunderbit è imbattibile.

- Per il lavoro di squadra, l’export diretto su Google Sheets di Thunderbit è un grande vantaggio.

Molte aziende usano un approccio ibrido: Thunderbit per attività rapide e per abilitare i non tecnici, strumenti tradizionali per audit approfonditi.

Riepilogo: ottenere tutte le pagine di un sito per ogni esigenza aziendale

In sintesi:

- Avere un elenco completo delle pagine del sito è fondamentale per SEO, strategia dei contenuti, migrazioni e ricerca commerciale. Evita sorprese, link rotti e occasioni perse. Oggi la maggior parte dei marketer fa audit dei contenuti almeno una volta l’anno ().

- I metodi tradizionali esistono, ma nessuno è perfetto. Nessun approccio garantisce un elenco completo e aggiornato. Spesso servono competenze tecniche e l’unione di più output.

- Lo scraping AI (Thunderbit) è la soluzione moderna. Thunderbit usa l’AI per fare il “lavoro pesante” e i clic, rendendo l’estrazione dati accessibile a tutti. Gestisce contenuti dinamici, sottopagine ed esporta dati pronti all’uso—risparmiando tempo e riducendo errori. Nei confronti diretti, Thunderbit fa in pochi minuti ciò che prima richiedeva ore, senza curva di apprendimento ().

- Scegli il metodo in base alle tue esigenze e al team. Usa tutti gli strumenti per siti enormi, ma per la maggior parte delle aziende Thunderbit basta e avanza.

- Tienilo aggiornato. Audit regolari ti permettono di individuare problemi in anticipo e mantenere il sito snello ed efficace. La programmazione di Thunderbit lo rende fattibile, mentre i processi manuali spesso vengono saltati per la fatica.

In conclusione: Non ci sono più scuse per non sapere cosa c’è sul tuo sito (o su quello dei competitor). Con il giusto approccio puoi ottenere un elenco completo di tutte le pagine e usare queste informazioni per migliorare SEO, esperienza utente e strategia di business. Lavora in modo più intelligente, non più duro—lascia che l’AI faccia il lavoro pesante e assicurati che nessuna pagina venga dimenticata.

Prossimi passi

Se vuoi smettere di temere la richiesta “recuperami tutti gli URL”, e provalo sul tuo sito o su quello di un competitor. Rimarrai sorpreso da quanto tempo (e stress) risparmierai. E se vuoi approfondire il tema dello scraping, dai un’occhiata agli altri articoli del , come o .

Domande frequenti

1. Perché dovrei voler ottenere l’elenco di tutte le pagine di un sito?

Team SEO, marketing, vendite e IT hanno spesso bisogno di elenchi completi di URL per audit dei contenuti, migrazioni, lead generation e analisi competitor. Un elenco completo e accurato aiuta a evitare link rotti, duplicazioni o contenuti dimenticati e a scoprire nuove opportunità.

2. Quali sono i metodi tradizionali per trovare tutti gli URL di un sito?

I metodi più comuni includono la ricerca Google con site:, il controllo di sitemap.xml e robots.txt, l’uso di tool SEO come Screaming Frog, l’esportazione dal CMS (WordPress, ecc.) e l’estrazione di pagine indicizzate/visitare da Google Search Console e Analytics. Tuttavia, ogni metodo ha limiti di copertura e praticità.

3. Quali sono i limiti dei metodi tradizionali per trovare URL?

I metodi classici spesso saltano pagine dinamiche, orfane o non indicizzate. Possono richiedere competenze tecniche, ore di lavoro per unire e pulire i dati e non sono adatti a siti grandi o audit ripetuti. Spesso serve anche accesso admin, che non è sempre possibile.

4. Come semplifica Thunderbit il processo di recupero delle pagine di un sito?

Thunderbit è un estrattore web AI che analizza i siti come farebbe un utente—cliccando sulle sottopagine, gestendo JavaScript e strutturando i dati in automatico. Non richiede codice, funziona tramite estensione Chrome ed esporta elenchi puliti di URL su Google Sheets, Excel, CSV e altro in pochi minuti.

5. Chi dovrebbe usare Thunderbit e chi i tool tradizionali?

Thunderbit è ideale per marketer, content strategist, team commerciali e utenti non tecnici che vogliono elenchi di URL completi e veloci senza complicazioni. I tool tradizionali sono più adatti per audit tecnici approfonditi che richiedono metadati o script personalizzati. Molti team usano entrambi—Thunderbit per velocità e semplicità, i tool classici per analisi dettagliate.