Diciamocelo senza giri di parole: nel 2025 il web sembra proprio un gigantesco foglio Excel che si aggiorna di continuo—peccato che nessuno abbia mai pensato di aggiungere un bel tasto “Esporta in Excel”. (Magari ci fosse davvero!) Dopo anni passati a sviluppare SaaS e strumenti di automazione, ho visto con i miei occhi quanto i team di vendita, marketing e operations siano sempre a caccia di dati web freschi e affidabili—che si tratti di liste di lead, monitoraggio prezzi dei concorrenti o analisi del mercato immobiliare. Ma se la fame di dati cresce, il modo di raccoglierli sta cambiando a vista d’occhio.

Java è sempre stato il cavallo di battaglia per chi si lancia in progetti di web scraping con java su larga scala. Ma diciamoci la verità: a meno che tu non sia uno sviluppatore che sogna in Java, mettere in piedi un estrattore Java può sembrare come montare un mobile IKEA senza istruzioni e con qualche vite in più. Ecco perché sono davvero entusiasta della nuova ondata di estrattore web ai—come , che abbiamo creato proprio per rendere l’estrazione dati una passeggiata, senza scrivere una riga di codice o conoscere l’HTML. In questa guida ti porto a scoprire entrambi i mondi: perché Java è ancora fondamentale, cosa serve per costruire un estrattore e come gli strumenti AI stanno rendendo il web scraping no code davvero per tutti.

Perché il Web Scraping con Java Conta Ancora nel 2025

Anche se ormai spopolano strumenti no-code e soluzioni AI, Java resta il motore sotto il cofano di molti dei più grandi progetti di estrazione dati. Il motivo? Java offre prestazioni solide, affidabilità e un controllo totale—tutto quello che serve quando si parla di estrazione dati a livello enterprise.

I Punti di Forza di Java

- Lead Generation & Vendite: Grazie alla potenza di Java, puoi estrarre milioni di profili da directory o LinkedIn in una notte. Immagina di svegliarti con il CRM pieno di nuovi contatti—senza nemmeno aver acceso la macchinetta del caffè.

- Monitoraggio Prezzi della Concorrenza: I team e-commerce si affidano a Java per tenere d’occhio migliaia di prodotti sui siti rivali, aggiornando i prezzi in tempo reale. Target, ad esempio, ha visto un ) grazie a strategie di pricing data-driven.

- Raccolta Dati Immobiliari: Agenti e investitori usano Java per aggregare annunci, prezzi storici e dati demografici da più fonti, così da scovare nuove opportunità ().

- Ricerche di Mercato Finanziario: Le società di investimento si affidano alla stabilità di Java per estrarre 24/7 prezzi di titoli, notizie e sentiment online—perché in finanza, anche pochi secondi fanno la differenza.

Il Compromesso: Flessibilità vs. Accessibilità

Java ti dà il massimo controllo: puoi personalizzare ogni dettaglio dell’estrattore, gestire casi particolari e integrarlo direttamente nei tuoi sistemi. Ma c’è un rovescio della medaglia—serve davvero saper programmare. Per chi non è sviluppatore, la curva di apprendimento è tosta e la manutenzione richiede tempo. Ecco perché, se Java resta la scelta per i progetti più complessi, sempre più utenti business si affidano a soluzioni AI e web scraping no code per le esigenze di tutti i giorni ().

Le Basi: Cos’è il Web Scraping con Java?

Facciamo chiarezza—niente paroloni.

Fare web scraping con java vuol dire scrivere un programma che si comporta come un browser robot: visita una pagina web, legge il contenuto e raccoglie i dati che ti servono. È come avere un assistente digitale che copia e incolla per te, ma molto più veloce (e senza pause caffè).

Come funziona:

- Invio della Richiesta: Il tuo programma Java recupera l’HTML grezzo di una pagina—proprio come fa il browser.

- Parsing dell’HTML: Il programma analizza la struttura della pagina (tutti quei tag

<div>,<span>,<table>). - Estrazione Dati: Gli dici cosa cercare (es. “prendi tutti i prezzi nei

<span class='price'>”). - Esportazione: I dati vengono salvati in un file CSV, Excel o in un database.

Per i siti statici, il processo è piuttosto lineare. Per quelli dinamici (dove i contenuti si caricano via JavaScript), servono strumenti extra per simulare un browser vero. Ne parliamo tra poco.

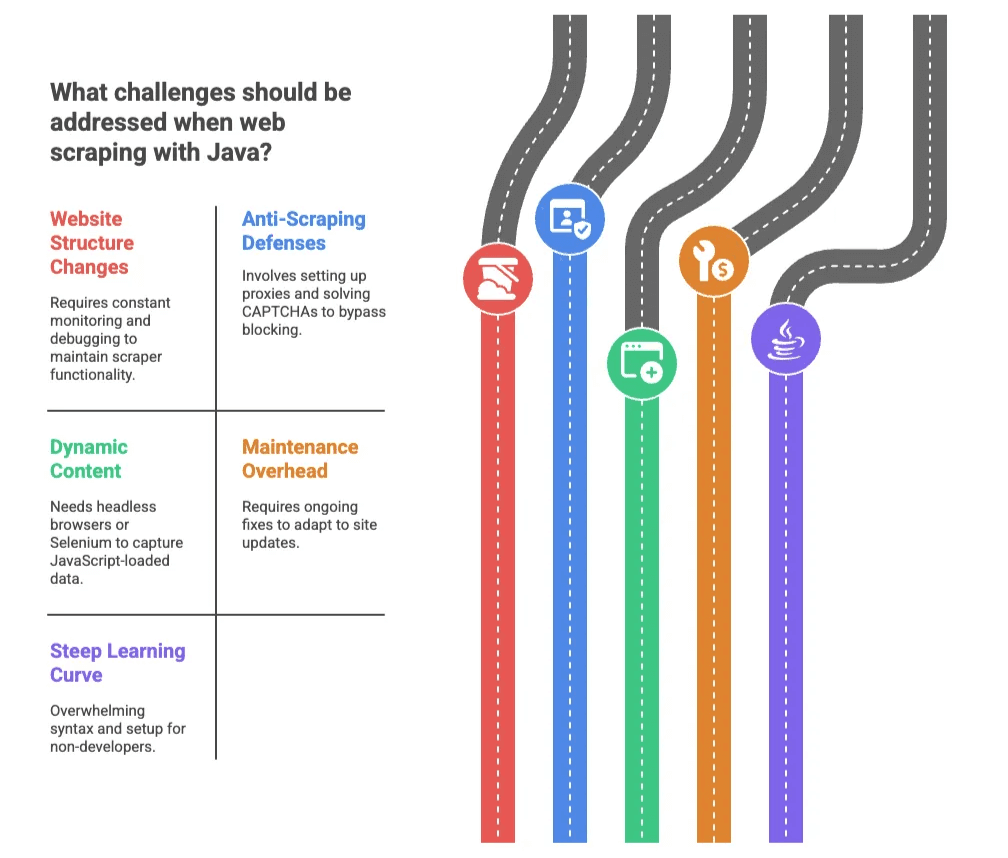

Le Principali Sfide del Web Scraping con Java

Java è potente, ma non sempre una passeggiata—soprattutto se il “parco” è pieno di CAPTCHA, blocchi IP e HTML che cambia ogni settimana. Ecco le difficoltà più comuni:

1. Cambiamenti nella Struttura dei Siti

I siti web cambiano look proprio quando il tuo estrattore sembra andare alla grande. Basta rinominare una classe CSS e il tuo scraper smette di funzionare, costringendoti a fare debug a notte fonda ().

2. Difese Anti-Scraping

I siti si difendono con CAPTCHA, ban degli IP e limiti di frequenza. In un recente sondaggio, il ha indicato i blocchi come il principale ostacolo. Gestirli in Java vuol dire configurare proxy, risolvere CAPTCHA e sentirsi in un eterno gioco a colpire la talpa digitale.

3. Contenuti Dinamici

I siti moderni spesso caricano dati con JavaScript dopo il caricamento iniziale. Gli scraper Java di base non vedono questi contenuti. Serve usare browser headless o strumenti come Selenium—che aumentano la complessità e rallentano il processo.

4. Manutenzione Continua

Anche dopo aver creato l’estrattore, dovrai metterci mano spesso. Ogni aggiornamento del sito può rompere il codice, e tu (o il tuo sviluppatore) dovrai sistemare tutto.

5. Curva di Apprendimento Ripida

Per chi non è sviluppatore, la sintassi e la configurazione di Java possono essere scoraggianti. Anche piccoli errori generano messaggi criptici. È come imparare a guidare con il cambio manuale—ma l’auto è in fiamme e la strada è fatta di HTML.

Web Scraping Tradizionale con Java: Cosa Serve?

Se vuoi comunque metterti alla prova con il codice, ecco come si svolge di solito il processo:

| Fase | Approccio con Java | Approccio con Strumento AI/No-Code |

|---|---|---|

| Configurazione Ambiente | Installa JDK, IDE, aggiungi librerie (può richiedere ore per i principianti) | Installa estensione browser o registrati (pochi minuti) |

| Identifica i Dati | Ispeziona HTML, scrivi selettori (serve conoscenza HTML/CSS) | L’AI rileva i campi, oppure selezioni con un clic |

| Gestione Contenuti Dinamici | Usa Selenium o HtmlUnit (complesso, più lento) | Gestito automaticamente dallo strumento |

| Debug & Correzioni | Leggi errori, modifica codice, testa più volte | Lo strumento gestisce la maggior parte dei problemi; l’utente può affinare la selezione dei campi |

| Esportazione Dati | Scrivi codice per salvare CSV/DB, integrazione manuale | Esporta con un clic su Excel, Google Sheets, Airtable, Notion |

| Manutenzione | Monitora cambiamenti sito, aggiorna codice (lavoro continuo) | L’AI si adatta ai cambiamenti, minimo sforzo utente |

Le Librerie Java più Usate per il Web Scraping

- Jsoup: Perfetta per HTML statico. Facile da usare, ma non gestisce contenuti caricati via JavaScript ().

- HtmlUnit: Simula un browser, esegue JavaScript. Più lento e a volte fatica con le tecnologie web moderne.

- Selenium: Controlla un vero browser (Chrome, Firefox), perfetto per siti dinamici. Potente, ma complesso per chi non programma.

In breve: Queste librerie sono ideali per sviluppatori, ma per chi lavora in azienda possono sembrare come costruire un razzo per ordinare una pizza.

Soluzioni Estrattore Web AI: L’Estrattore Web per Tutti

Qui arriva la vera rivoluzione. Gli estrattore web ai come stanno cambiando le regole, rendendo l’estrazione dati accessibile a chiunque—anche senza una riga di codice.

Come Funziona Thunderbit

- AI Suggerisce i Campi: Premi un pulsante e l’AI analizza la pagina, suggerendo colonne e tipi di dati da estrarre. Niente più ispezione HTML.

- Flusso in 2 Clic: Basta “AI Suggerisci Campi” e “Estrai”—al resto pensa l’AI.

- Estrazione da Sottopagine: Vuoi più dettagli? Thunderbit può visitare automaticamente ogni sottopagina (come pagine prodotto o profili) e arricchire la tua tabella.

- Esporta Ovunque: Invia i dati direttamente su Excel, Google Sheets, Airtable o Notion con un clic.

- Estrazione Cloud o Browser: Scegli il cloud per la velocità (fino a 50 pagine in parallelo) o il browser per siti che richiedono login.

E sì, è davvero così semplice. Ho visto utenti senza alcuna esperienza tecnica passare da “non so cosa sia un selettore” a “ho estratto 500 prodotti concorrenti” in meno di 10 minuti.

Thunderbit vs. Web Scraping Java Tradizionale: Confronto Rapido

| Caratteristica | Java Tradizionale | Thunderbit Estrattore Web AI |

|---|---|---|

| Tempo di Setup | Da ore a giorni | Minuti (installa estensione Chrome) |

| Competenze Richieste | Java, HTML, CSS, debug | Nessuna (solo navigazione web di base) |

| Manutenzione | Manuale, continua | L’AI si adatta automaticamente |

| Esportazione Dati | Codifica manuale | 1 clic su Excel, Sheets, Airtable, Notion |

| Contenuti Dinamici | Complesso (Selenium/HtmlUnit) | Gestito automaticamente |

| Estrazione Sottopagine | Scrivi logica personalizzata | Integrato, basta un clic |

| Scalabilità | Multithreading, proxy | Estrazione cloud, parallelizzata |

| Costo | Tempo sviluppatore, infrastruttura | Piani accessibili, versione gratuita disponibile |

Per la maggior parte degli utenti business, l’approccio Thunderbit è una boccata d’aria fresca. È come passare dal cambio manuale all’auto a guida autonoma.

Passo dopo Passo: Come Iniziare il Web Scraping con Java

Vuoi comunque provare Java? Ecco una panoramica semplice e senza tecnicismi:

-

Configura l’Ambiente: Installa Java Development Kit (JDK) e un IDE come IntelliJ o Eclipse. Aggiungi una libreria come Jsoup per il parsing HTML ().

-

Scegli il Target: Apri il sito nel browser, ispeziona l’HTML e individua gli elementi che ti interessano (es. nomi prodotti, prezzi).

-

Scrivi il Codice: Usa Jsoup per recuperare la pagina e selezionare i dati. Ad esempio:

1Document doc = Jsoup.connect("http://example.com/page").get(); 2Elements prices = doc.select("span.price"); 3for (Element price : prices) { 4 System.out.println(price.text()); 5} -

Gestisci la Paginazione: Cicla tra più pagine modificando l’URL o seguendo i link “Successivo”.

-

Esporta i Dati: Salva i risultati in un file CSV per aprirli in Excel o Google Sheets.

-

Testa e Affina: Esegui l’estrattore, correggi eventuali errori e perfeziona i selettori.

Consigli per Mantenere il Tuo Estrattore Java

- Controlla i Risultati: Verifica regolarmente che i dati non siano vuoti o mancanti.

- Centralizza i Selettori: Tieni tutti i selettori HTML in un unico punto per aggiornamenti rapidi.

- Gestisci i Blocchi: Usa proxy e ruota gli user agent se vieni bloccato.

- Documenta Tutto: Commenta il codice e annota cosa fa ogni parte.

- Rispetta la Legge: Controlla sempre i termini d’uso e il robots.txt del sito prima di estrarre dati.

Se ti sembra tanto lavoro… lo è. Ecco perché sempre più team scelgono strumenti AI.

Quando Scegliere Strumenti AI come Thunderbit

Quale strada seguire? Ecco la mia opinione, dopo anni di esperienza:

Scegli Java se:

- Hai bisogno di logiche ultra-personalizzate, integrazione profonda o estrazione su larga scala.

- La tua azienda ha requisiti di sicurezza o compliance stringenti.

- Hai sviluppatori e tempo per mantenere il codice.

Scegli Thunderbit (o un altro estrattore web ai) se:

- Non programmi (o non vuoi farlo).

- Ti serve il dato subito, con setup minimo.

- Il sito cambia spesso o devi estrarre dati da tanti siti diversi.

- Vuoi esportare direttamente su Excel, Google Sheets, Airtable o Notion.

- Vuoi risparmiarti stress e complicazioni.

Thunderbit è perfetto per team di vendita, e-commerce e immobiliare che vogliono automatizzare la raccolta dati senza dipendere dall’IT. È ideale anche per progetti spot, generazione rapida di lead o monitoraggio della concorrenza—insomma, ogni situazione in cui velocità e semplicità fanno la differenza.

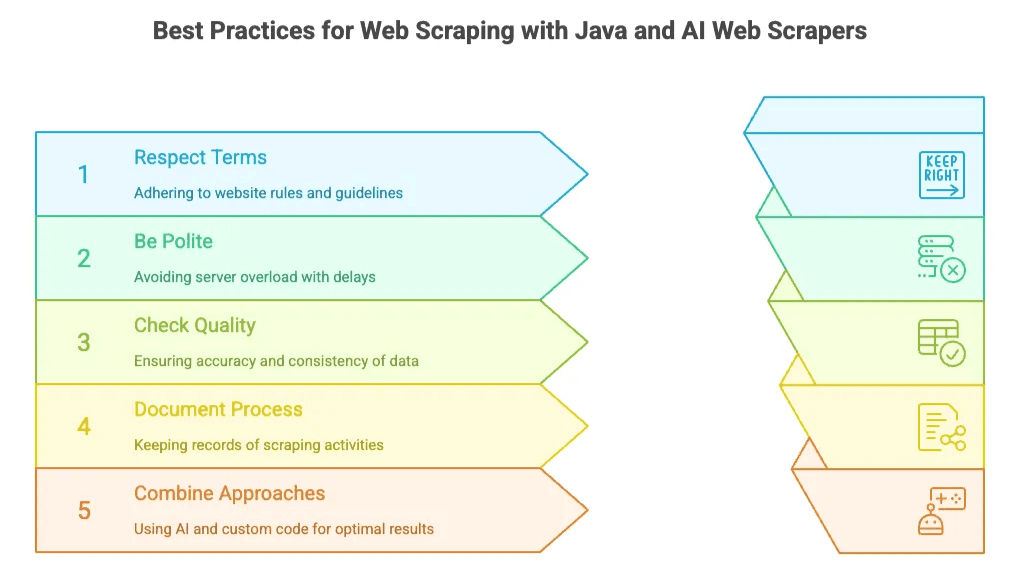

Best Practice per il Web Scraping con Java e Estrattore Web AI

Qualunque sia la tua scelta, ci sono alcune regole d’oro:

- Rispetta i Termini dei Siti: Controlla sempre robots.txt e termini d’uso. Non estrarre dati privati o sensibili.

- Sii Gentile: Non sovraccaricare i server—aggiungi pause tra le richieste se programmi, o usa il throttling integrato negli strumenti AI.

- Verifica la Qualità dei Dati: Controlla che i risultati siano accurati e coerenti. Il “Prompt AI Campo” di Thunderbit può aiutarti a pulire e strutturare i dati in tempo reale.

- Documenta il Processo: Tieni traccia di cosa estrai, da dove e con quale frequenza.

- Combina gli Approcci: A volte partire con uno strumento AI per risultati rapidi e poi passare al codice per esigenze avanzate è la soluzione migliore.

Conclusioni: Il Futuro del Web Scraping per le Aziende

Nel 2025 il web scraping è sinonimo di opportunità. Java resta la scelta top per progetti enterprise su misura. Ma per la stragrande maggioranza degli utenti business—vendite, marketing, operations—l’arrivo di estrattore web ai come significa che non serve più essere sviluppatori per sfruttare la potenza dei dati web.

Il mercato è in piena crescita: si prevede che il software di web scraping raggiungerà , e il userà strumenti di analisi automatizzata entro il 2028. Il messaggio è chiaro: le decisioni data-driven sono il futuro, e gli strumenti sono sempre più potenti.

Se sei indeciso, prova . È gratuita per iniziare e potresti sorprenderti di quanto puoi ottenere in pochi clic. (E se sei uno sviluppatore appassionato di Java, non preoccuparti—ci sarà sempre bisogno delle tue competenze, soprattutto per le sfide più toste.)

Vuoi saperne di più? Dai un’occhiata al nostro per guide, tutorial e best practice—tra cui e .

Buon scraping—che i tuoi dati siano sempre freschi, precisi e a portata di clic. Se solo tutto nella vita fosse così semplice, vero?

Domande Frequenti

1. Perché usare ancora Java per il web scraping nel 2025?

Java resta una delle scelte migliori per scraping su larga scala grazie a velocità, affidabilità e flessibilità. È ideale per monitoraggio finanziario, analisi prezzi della concorrenza e raccolta di grandi database di lead—soprattutto quando serve controllo avanzato o integrazione backend.

2. Quali sono gli svantaggi del web scraping con Java?

Nonostante la potenza, Java comporta diverse sfide: curva di apprendimento ripida, manutenzione costante, frequenti rotture dovute a cambiamenti HTML, difficoltà con siti ricchi di JavaScript e setup complesso con proxy, CAPTCHA e gestione della paginazione.

3. Come semplificano il processo gli strumenti AI come Thunderbit?

Thunderbit automatizza tutto: rileva i campi con l’AI, gestisce contenuti dinamici, naviga tra sottopagine ed esporta i dati direttamente su Excel o Notion. Nessun codice, HTML o configurazione—perfetto anche per chi non è tecnico.

4. Quando conviene usare Thunderbit invece di Java?

Thunderbit è ideale per utenti business che vogliono dati rapidi e affidabili senza scrivere codice. Perfetto per prospecting, monitoraggio e-commerce e ricerche rapide dove contano velocità e semplicità più che la personalizzazione estrema.

5. Posso combinare Java e strumenti AI per il web scraping?

Assolutamente sì. Molti team iniziano con strumenti AI come Thunderbit per risultati immediati, poi passano a Java per esigenze avanzate o su larga scala. È un approccio ibrido che unisce facilità d’uso e potenza del codice personalizzato.

Scopri di più: