Ricordo ancora la prima volta che ho provato a tirare fuori una lista di potenziali clienti da un sito. Mi sono detto: “So usare JavaScript, quanto potrà essere complicato?” Dopo qualche ora, ero già sommerso tra selettori che cambiavano, contenuti che sparivano davanti ai miei occhi e mille trappole anti-bot. E non sono certo l’unico— oggi mette i dati al centro del proprio business, e lo web scraping è diventato fondamentale. Ma con i siti che si evolvono di continuo, fare web scraping con JavaScript è sia un superpotere che una bella sfida.

In questa guida ti racconto tutto quello che ho imparato su web scraping con JavaScript: dalle basi alle rogne più comuni, fino a come strumenti moderni con AI come possono farti risparmiare ore di lavoro sui selettori. Che tu stia raccogliendo prodotti per il tuo ecommerce o costruendo una pipeline di lead per le vendite, vediamo insieme come affrontare lo scraping del web con JavaScript (e un pizzico di AI).

Web Scraping con JavaScript: Le Basi e i Limiti

Partiamo dal principio: fare web scraping con JavaScript vuol dire estrarre dati dai siti in modo automatico, usando script che girano nel browser o con Node.js sul backend. JavaScript è la lingua madre del web, quindi viene spontaneo usarlo per queste cose—soprattutto grazie a librerie come Cheerio (per HTML statico) e Puppeteer o Playwright (per automatizzare browser headless).

Perché JavaScript è così gettonato nello scraping?

- Accesso diretto al DOM: Nel browser puoi esplorare la pagina proprio come farebbe un utente normale.

- Ecosistema ricco: Node.js offre librerie potenti per richieste HTTP, parsing e automazione.

- Flessibilità: Puoi automatizzare login, click, scroll—tutto quello che fai in Chrome, puoi scriptarlo.

Ma c’è il rovescio della medaglia: i siti moderni cambiano di continuo. Usano JavaScript per caricare contenuti dinamici, modificare il DOM e mettere in piedi difese anti-bot. Il risultato? Il tuo script oggi va, domani si rompe. Ti ritrovi spesso a rincorrere selettori, gestire pop-up e inseguire dati che si caricano in modo asincrono. È un po’ come giocare a whack-a-mole, ma con più parentesi graffe.

Perché le Pagine Complesse Mettono in Crisi lo Scraping con JavaScript

Una volta bastava scaricare l’HTML e cercare i dati che ti servivano. Oggi, invece, siti come Facebook Marketplace, Amazon o anche semplici portali immobiliari sono costruiti con framework JavaScript che generano contenuti al volo, nascondono dati dietro scroll infiniti e annidano informazioni in strutture DOM complicate.

Il semplice parsing dell’HTML non basta più. Ad esempio, estrarre recensioni o commenti nidificati non vuol dire solo trovare il <div> giusto—serve capire le relazioni tra gli elementi, il contesto di ogni campo e, a volte, anche il significato dei dati.

Qui serve una pre-elaborazione più intelligente. Non basta più “prendere tutto l’HTML e sperare nel meglio”: serve un modo per capire davvero la pagina—cos’è il nome di un prodotto, cos’è un prezzo, cos’è una recensione? È una sfida per il JavaScript classico, ma è proprio qui che gli strumenti AI fanno la differenza.

Soluzioni Classiche di Web Scraping con JavaScript

Parliamo di strumenti. Il classico stack per lo scraping in JavaScript di solito include uno (o più) di questi:

- Cheerio: Perfetto per HTML statico. È come avere jQuery sul server.

- Puppeteer/Playwright: Automazione di browser headless. Questi strumenti avviano un vero browser, eseguono JavaScript e ti permettono di interagire con la pagina come se fossi un utente (o un robot caffeinomane).

Il flusso di lavoro tipico è:

- Richiedi la pagina (con o senza browser headless).

- Aspetta che i contenuti si carichino (spesso con

waitForSelectoro simili). - Analizza il DOM per trovare i dati che ti servono.

- Estrai e struttura i risultati.

Sembra facile, vero? Ma c’è un problema: ogni volta che il sito cambia layout, i tuoi selettori smettono di funzionare. Se spunta un nuovo pop-up, lo script si blocca. Se l’ordine dei campi cambia, i dati si confondono. La manutenzione diventa infinita.

Confronto tra le Principali Librerie di Scraping JavaScript

| Caratteristica | Cheerio | Puppeteer | Playwright |

|---|---|---|---|

| Ideale per | HTML statico | Pagine dinamiche | Pagine dinamiche |

| Automazione browser | No | Sì | Sì |

| Gestisce contenuti JS | No | Sì | Sì |

| Velocità | Veloce | Più lento | Più lento |

| Semplicità API | Semplice | Media | Media |

| Evasione anti-bot | Limitata | Media | Media |

| Multi-browser | No | Solo Chrome | Chrome, Firefox, WebKit |

| Casi d’uso | Siti semplici, API | Siti interattivi | Siti interattivi |

Cheerio è velocissimo per pagine statiche o API che restituiscono HTML, ma non può eseguire JavaScript. Puppeteer e Playwright sono ideali per contenuti dinamici, ma sono più pesanti e richiedono più configurazione. Entrambi permettono di automatizzare login, click e scroll, ma dovrai comunque scrivere logica per ogni cambiamento del sito.

Thunderbit: Web Scraping Potenziato dall’AI per Flussi JavaScript

Qui viene il bello. In Thunderbit abbiamo capito che lo scraping non è solo “prendere HTML”, ma capire la pagina come farebbe una persona. Così abbiamo creato , un’estensione Chrome Estrattore Web AI che porta la comprensione semantica nello scraping.

Come funziona?

- Thunderbit trasforma la pagina web in una rappresentazione Markdown—una versione più pulita e ordinata della pagina.

- L’AI analizza il Markdown per identificare campi, relazioni e contesto—così riconosce prezzi, recensioni e ignora elementi decorativi.

- Il risultato? Ottieni dati strutturati e etichettati, resistenti ai cambi di layout, contenuti dinamici e modifiche nella gerarchia del DOM.

Per chi lavora nel business, significa meno pulizia manuale dei dati, meno script che si rompono e più tempo per analizzare i risultati. Per gli sviluppatori, vuol dire concentrarsi sull’automazione della navigazione (login, click, scroll) e lasciare a Thunderbit l’estrazione dei dati.

Passo-Passo: Web Scraping con JavaScript (Metodo Classico e con Thunderbit)

Passiamo alla pratica. Ecco un esempio concreto: estrarre prodotti da un sito ecommerce di esempio. Prima useremo il metodo classico con Puppeteer, poi vedrai come velocizzare tutto affidando l’estrazione a Thunderbit.

Passo 1: Prepara l’Ambiente di Scraping JavaScript

Prima di tutto: installa . Poi installa Puppeteer:

1npm install puppeteerSe preferisci Playwright (che supporta più browser), usa:

1npm install playwrightSe non sei tecnico, nessun problema: copia e incolla i codici, ti spiego ogni passaggio.

Passo 2: Naviga e Interagisci con Pagine Dinamiche

I siti moderni spesso nascondono i dati dietro login, pop-up e scroll infiniti. Ecco come automatizzare questi passaggi con Puppeteer:

1const puppeteer = require('puppeteer');

2(async () => {

3 const browser = await puppeteer.launch({ headless: true });

4 const page = await browser.newPage();

5 // Vai alla pagina di login

6 await page.goto('https://example.com/login');

7 await page.type('#username', 'your_username');

8 await page.type('#password', 'your_password');

9 await page.click('#login-button');

10 await page.waitForNavigation();

11 // Vai alla lista prodotti

12 await page.goto('https://example.com/products');

13 // Scroll per caricare altri articoli

14 await page.evaluate(async () => {

15 for (let i = 0; i < 5; i++) {

16 window.scrollBy(0, window.innerHeight);

17 await new Promise(resolve => setTimeout(resolve, 1000));

18 }

19 });

20 // Attendi il caricamento dei prodotti

21 await page.waitForSelector('.product-card');

22 // ... (estrarremo i dati nel prossimo step)

23})();Questo script effettua il login, va alla pagina prodotti e scrolla per caricare altri articoli. L’importante è aspettare che gli elementi siano visibili—altrimenti rischi di estrarre dati vuoti.

Passo 3: Estrai i Dati con JavaScript

Ora estraiamo i dati. Supponiamo che ogni prodotto sia in un div .product-card:

1const products = await page.$$eval('.product-card', cards =>

2 cards.map(card => ({

3 name: card.querySelector('.product-title').innerText,

4 price: card.querySelector('.product-price').innerText,

5 link: card.querySelector('a').href,

6 }))

7);

8console.log(products);Occhio a questi problemi:

- I selettori cambiano facilmente. Se

.product-titlediventa.title, lo script si rompe. - Dati nascosti. Prezzi o recensioni possono essere caricati via AJAX dopo il caricamento della pagina.

- Difese anti-bot. Troppe richieste possono portare a blocchi.

Passo 4: Potenzia l’Estrazione con Thunderbit AI

Qui entra in gioco Thunderbit. Invece di impazzire con selettori e logica fragile, puoi passare l’HTML renderizzato (o anche uno screenshot) a Thunderbit per l’estrazione AI.

Come funziona in pratica?

- Usa Puppeteer o Playwright per automatizzare navigazione, login e spostamenti.

- Quando sei sulla pagina giusta, prendi l’HTML:

1const pageContent = await page.content();- Invia questo HTML a Thunderbit (tramite la ) per l’estrazione AI.

Thunderbit:

- Converte la pagina in Markdown per un parsing semantico più semplice.

- Usa l’AI per identificare campi, relazioni e contesto.

- Restituisce dati strutturati che puoi esportare su Excel, Google Sheets, Airtable o Notion.

Niente più inseguimenti di selettori o pulizia manuale dei dati.

Gestire Contenuti Dinamici e Caricamenti Asincroni

I contenuti dinamici sono il peggior nemico di chi fa scraping. I siti amano caricare dati dopo il rendering iniziale—scroll infinito, pulsanti “Carica altro” o recensioni via AJAX.

Strategie classiche:

- Usa

waitForSelectorper aspettare che gli elementi compaiano. - Attendi che la rete sia “idle” (nessuna richiesta in corso) prima di estrarre.

- Simula scroll o click per caricare altri dati.

Ma questi metodi sono fragili. Se il sito cambia logica di caricamento, lo script si rompe.

Il metodo Thunderbit: Convertendo la pagina in Markdown e lasciando che l’AI analizzi la struttura, Thunderbit è meno dipendente da gerarchie DOM o ID specifici. Anche se il layout cambia, finché il contenuto è presente, l’AI di Thunderbit riesce quasi sempre a trovarlo ed estrarlo. Risultato: meno manutenzione e dati più affidabili.

Costruire una Pipeline di Dati Sostenibile: Dallo Script agli Insight Aziendali

Lo scraping non è solo un’attività occasionale—è l’inizio di una pipeline di dati. Ecco come la vedo io:

- Automatizza navigazione ed estrazione con JavaScript (Puppeteer/Playwright).

- Affida a Thunderbit la strutturazione e l’etichettatura AI dei dati.

- Esporta i risultati sul tuo strumento preferito: Excel, Google Sheets, Airtable, Notion.

- Pianifica attività ricorrenti con il di Thunderbit—descrivi l’intervallo (“ogni lunedì alle 9”), inserisci le URL e lascia che Thunderbit faccia il resto.

- Chiudi il cerchio integrando i dati strutturati nei tuoi flussi di lavoro aziendali—che sia per contattare clienti, monitorare prezzi o fare ricerche di mercato.

Questa combinazione—JavaScript per l’automazione, Thunderbit per l’estrazione AI—ti permette di creare pipeline ripetibili e a bassa manutenzione che mantengono il tuo business aggiornato con dati freschi e affidabili.

Conclusione: Scegli il Metodo di Web Scraping Giusto per Te

Quindi, qual è il modo migliore per fare scraping con JavaScript? Ecco la mia opinione:

- Lo scraping classico con JavaScript (Cheerio, Puppeteer, Playwright) è ottimo per siti semplici o quando vuoi il massimo controllo sull’automazione. Ma richiede tanta manutenzione—i selettori cambiano, i layout si modificano e le difese anti-bot sono sempre più toste.

- L’estrazione AI con Thunderbit aggiunge una comprensione semantica. È più resistente ai cambiamenti, riduce la pulizia manuale e ti permette di concentrarti sull’analisi invece che sul debug degli script.

Quando usare cosa?

- Per estrazioni rapide e una tantum su pagine semplici, usa Cheerio o Puppeteer.

- Per siti complessi e dinamici—o se vuoi un flusso di lavoro a prova di futuro—combina i tuoi script JavaScript con l’estrazione AI di Thunderbit.

- Per chi non vuole scrivere codice, l’estensione Chrome di Thunderbit è il modo più semplice per passare da pagina web a foglio di calcolo in due click.

Vuoi altri esempi? Dai un’occhiata al per approfondimenti su , e molto altro.

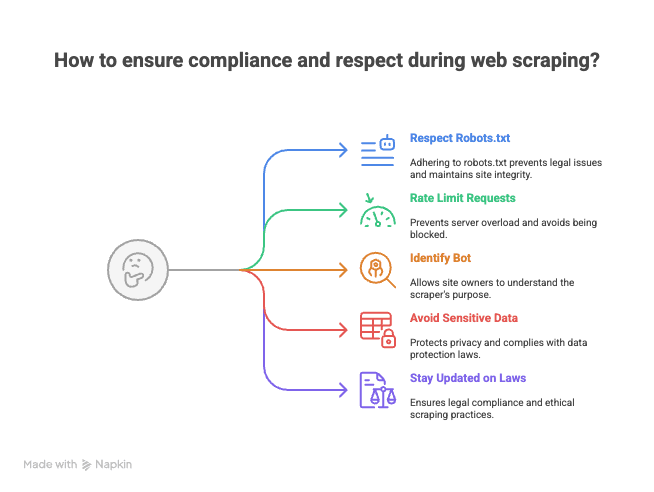

Bonus: Consigli per uno Scraping Etico e a Norma

Prima di lanciare i tuoi script di scraping, un consiglio da chi ha già ricevuto qualche “gentile” email dagli admin dei siti:

- Rispetta robots.txt e i termini di servizio. Non tutti i siti vogliono essere estratti.

- Limita la frequenza delle richieste. Non stressare i server—dilaziona le richieste per evitare blocchi (o peggio, blacklist).

- Identifica il tuo bot. Usa una User-Agent personalizzata così i proprietari sanno chi sei.

- Evita dati sensibili o personali. Limita l’estrazione a informazioni pubbliche e rispetta la privacy.

- Tieniti aggiornato su leggi e best practice. Lo scraping web è una zona grigia in alcune giurisdizioni.

Ricorda: con grande potere di scraping arriva anche grande responsabilità (e, a volte, una diffida formale).

Fare web scraping con JavaScript è sia un’arte che una scienza. Con gli strumenti giusti—e un po’ di AI—puoi trasformare il web nel tuo database personale. E se ti blocchi, sai dove trovarmi (probabilmente a debuggare selettori con una tazza di caffè e una scheda Thunderbit aperta).

Buon scraping!

Domande Frequenti

1. Cos’è lo web scraping con JavaScript e perché è così diffuso?

Lo scraping con JavaScript consiste nell’estrarre dati dai siti tramite script eseguiti nel browser o con Node.js sul backend. È popolare perché JavaScript permette accesso diretto al DOM, offre tante librerie per richieste HTTP e automazione, e consente di automatizzare interazioni come login, click e scroll.

2. Quali sono le principali difficoltà nello scraping di siti moderni e dinamici?

I siti moderni spesso usano framework JavaScript per caricare contenuti dinamici, nascondere dati dietro scroll infiniti o pop-up e cambiare spesso layout. Questo rende i metodi classici fragili: basta un cambio di selettore o un caricamento asincrono per rompere lo script.

3. Come si confrontano Cheerio, Puppeteer e Playwright per lo scraping JavaScript?

- Cheerio è ideale per HTML statico ed è veloce, ma non gestisce contenuti generati da JavaScript né automazione browser.

- Puppeteer e Playwright sono pensati per pagine dinamiche, supportano automazione browser e gestiscono contenuti JavaScript, ma sono più lenti e richiedono più configurazione. Playwright supporta più browser, Puppeteer principalmente Chrome.

4. Quali vantaggi offre Thunderbit rispetto ai metodi classici?

Thunderbit utilizza l’AI per comprendere semanticamente le pagine web, convertendole in un formato Markdown strutturato e poi estraendo i dati etichettati. Questo approccio è più resistente ai cambi di layout, riduce la necessità di pulizia manuale e minimizza la manutenzione rispetto allo scraping basato sui selettori.

5. Quali sono le best practice per uno scraping conforme ed etico?

- Controlla e rispetta sempre robots.txt e i termini di servizio del sito.

- Limita la frequenza delle richieste per non sovraccaricare i server.

- Identifica il tuo bot con una User-Agent personalizzata.

- Evita di estrarre dati sensibili o personali, concentrati su informazioni pubbliche.

- Rimani aggiornato su leggi e best practice nella tua zona.

Per Approfondire: