Viviamo in un mondo dove i dati sono ovunque e la corsa a sfruttarli è sempre più agguerrita. Ogni giorno, miliardi di pagine web vengono passate al setaccio per raccogliere informazioni, monitorare prezzi, trovare nuovi contatti o fare ricerca—alimentando tutto, dalle battaglie di prezzo nell’e-commerce alle nuove frontiere dell’AI (). Il mercato globale dell’estrazione dati dal web è destinato a superare i 9 miliardi di dollari entro la fine del 2025 e, se non stai ancora usando un Estrattore Web efficiente, rischi davvero di lasciarti scappare grandi occasioni ().

Dopo anni passati tra SaaS e automazione, ho capito quanto la scelta dell’estrattore web giusto possa fare la differenza tra un progetto che decolla e uno che si arena. E ultimamente, Rust mi ha davvero sorpreso per le sue potenzialità. In questa guida ti spiego perché Rust è una bomba per creare un estrattore web, come iniziare passo dopo passo e come puoi abbinarlo a strumenti AI come per ottenere il massimo: velocità, sicurezza e meno grattacapi.

Perché puntare su Rust per il tuo Estrattore Web?

Andiamo dritti al sodo: perché Rust? Me lo chiedono spesso, soprattutto chi è abituato a Python o Node.js per il web scraping. Ecco cosa rende Rust speciale:

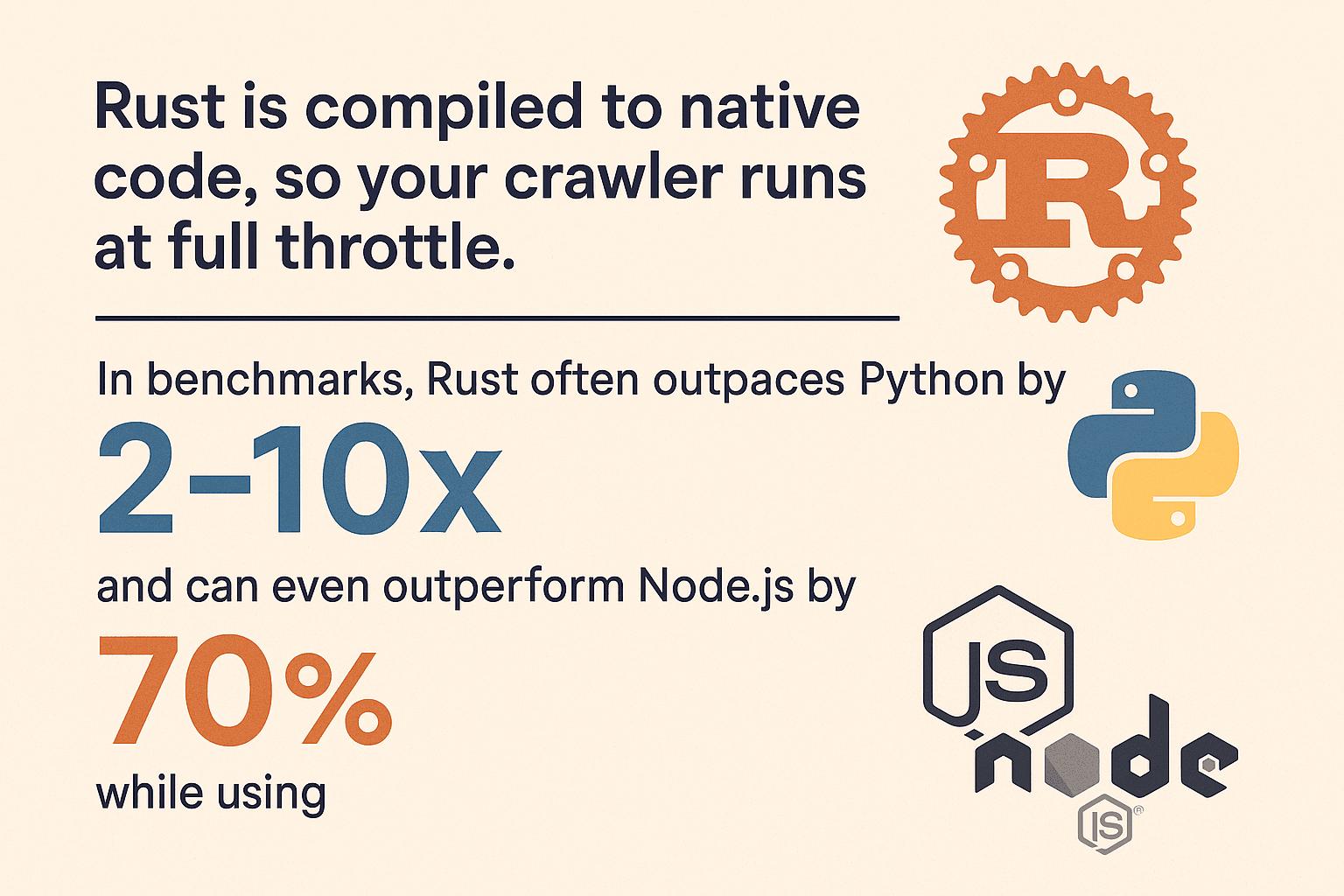

- Velocità fuori dal comune: Rust viene compilato in codice nativo, quindi il tuo estrattore va a tutta birra. Nei test, Rust batte Python di 2–10 volte nei compiti più pesanti e può essere più veloce di Node.js del 70% usando il 90% di memoria in meno (, ).

- Gestione della memoria a prova di bomba: Il sistema di proprietà di Rust elimina crash misteriosi e memory leak. Il compilatore ti segnala gli errori prima che diventino un incubo.

- Concorrenza senza stress: Rust nasce per la concorrenza. Vuoi scaricare 100 pagine in parallelo? Nessun problema: il sistema di tipi di Rust protegge i tuoi thread e previene le condizioni di race.

- Affidabilità: La gestione degli errori di Rust (con

ResulteOption) ti costringe a pensare ai casi di fallimento. Il tuo estrattore non si bloccherà per una richiesta andata male. - Sicurezza: Niente buffer overflow, niente null pointer. Le garanzie di sicurezza di Rust rendono il tuo estrattore meno vulnerabile a contenuti web strani o malevoli.

Rispetto a Python (facile, ma lento e pesante in memoria) o Node.js (ottimo per l’I/O, ma single-threaded e assetato di RAM), Rust offre prestazioni e stabilità di altissimo livello—soprattutto quando i dati da gestire diventano tanti ().

Come preparare l’ambiente per un Estrattore Web in Rust

Pronto a metterti all’opera? Ecco come preparare il tuo ambiente Rust:

1. Installa Rust e Cargo

Rust si installa tramite , che gestisce le versioni di Rust e lo strumento di build cargo. Scarica l’installer per il tuo sistema operativo e segui le istruzioni. Su Windows, potresti dover installare Visual C++ Build Tools se richiesto.

Controlla che sia tutto ok:

1rustc --version

2cargo --versionSe vedi i numeri di versione, sei pronto.

2. Crea un nuovo progetto

Apri il terminale e digita:

1cargo new rust_web_crawler

2cd rust_web_crawlerAvrai un progetto nuovo con Cargo.toml e src/main.rs.

3. Aggiungi le dipendenze fondamentali

Per l’estrazione dati dal web, ti serviranno:

- (client HTTP)

- (parsing HTML con selettori CSS)

- (runtime async, se vuoi scraping asincrono)

- (per esportare i dati)

Aggiungile con:

1cargo add reqwest scraper csv tokio --features fullOppure modifica il tuo Cargo.toml:

1[dependencies]

2reqwest = { version = "0.11", features = ["blocking"] }

3scraper = "0.16"

4csv = "1.1"

5tokio = { version = "1.28", features = ["full"] }4. Scegli l’IDE e gli strumenti giusti

Personalmente consiglio VS Code con l’estensione : hai completamento automatico, documentazione inline e linting. Per progetti più grandi, anche JetBrains CLion o IntelliJ con il plugin Rust sono ottimi.

5. Dritte per risolvere i problemi

- Se

cargonon viene trovato, assicurati che la cartella.cargo/binsia nel tuo PATH. - Su Windows, installa eventuali strumenti C++ mancanti se richiesto.

- Se hai errori sulle dipendenze, prova

cargo updateo controlla che non ci siano errori di battitura inCargo.toml.

Guida pratica: crea il tuo primo Estrattore Web in Rust

Costruiamo un estrattore base che scarica una pagina, estrae dati di prodotto e li esporta in CSV. Partiamo semplice, poi puoi espandere come vuoi.

Scaricare pagine web con Rust

Importa reqwest:

1use reqwest::blocking::get;

2fn main() {

3 let url = "https://www.scrapingcourse.com/ecommerce/";

4 let response = get(url);

5 let html_content = response.unwrap().text().unwrap();

6 println!("{}", html_content);

7}In produzione, sostituisci gli unwrap() con una gestione degli errori più robusta:

1let response = match reqwest::blocking::get(url) {

2 Ok(resp) => resp,

3 Err(err) => {

4 eprintln!("Request failed for {}: {}", url, err);

5 return;

6 }

7};Parsing ed estrazione dei dati

Ora usiamo scraper per analizzare l’HTML ed estrarre le informazioni dei prodotti.

1use scraper::{Html, Selector};

2let document = Html::parse_document(&html_content);

3let product_selector = Selector::parse("li.product").unwrap();

4for product in document.select(&product_selector) {

5 let name = product

6 .select(&Selector::parse("h2").unwrap()).next()

7 .map(|e| e.text().collect::<String>());

8 let price = product

9 .select(&Selector::parse(".price").unwrap()).next()

10 .map(|e| e.text().collect::<String>());

11 let url = product

12 .select(&Selector::parse("a").unwrap()).next()

13 .and_then(|e| e.value().attr("href"))

14 .map(|s| s.to_string());

15 let image = product

16 .select(&Selector::parse("img").unwrap()).next()

17 .and_then(|e| e.value().attr("src"))

18 .map(|s| s.to_string());

19 println!("Name: {:?}, Price: {:?}, URL: {:?}, Image: {:?}", name, price, url, image);

20}Questo metodo, ispirato a , funziona benissimo per pagine e-commerce o elenchi.

Gestione degli URL e prevenzione dei duplicati

Per un vero crawler, dovrai seguire i link ed evitare di visitare la stessa pagina più volte. Ecco un pattern classico:

1use std::collections::{HashSet, VecDeque};

2let mut to_visit = VecDeque::new();

3let mut visited = HashSet::new();

4to_visit.push_back(start_url.to_string());

5visited.insert(start_url.to_string());

6while let Some(url) = to_visit.pop_front() {

7 // Fetch and parse page...

8 for link in extracted_links {

9 let abs_link = normalize_url(&link, &url); // Usa la crate `url`!

10 if !visited.contains(&abs_link) {

11 visited.insert(abs_link.clone());

12 to_visit.push_back(abs_link);

13 }

14 }

15}Ricorda di normalizzare gli URL (usando la crate ) per gestire percorsi relativi, slash finali e frammenti.

Concorrenza: come rendere l’estrazione dati super veloce

Qui Rust dà davvero il meglio. Scaricare una pagina alla volta è lento—meglio andare in parallelo.

Opzione 1: Multi-threading

Avvia più thread, ognuno lavora sulla coda. Usa Arc<Mutex<>> per lo stato condiviso. Per progetti piccoli va benissimo.

Opzione 2: Async/Await con Tokio

Per prestazioni serie, usa l’asincronia. Con tokio e reqwest async puoi lanciare centinaia di richieste in parallelo senza saturare la RAM.

1use reqwest::Client;

2use futures::future::join_all;

3let client = Client::new();

4let urls = vec![/* ... */];

5let fetches = urls.into_iter().map(|url| {

6 let client_ref = &client;

7 async move {

8 match client_ref.get(url).send().await {

9 Ok(resp) => {

10 let text = resp.text().await.unwrap_or_default();

11 // Parse text...

12 }

13 Err(e) => eprintln!("Error fetching {}: {}", url, e),

14 }

15 }

16});

17join_all(fetches).await;L’asincronia in Rust non è solo veloce—è anche sicura. Niente data race, niente bug strani. Solo pura efficienza ().

Esportare e salvare i dati raccolti

Una volta raccolti i dati, probabilmente vorrai esportarli. La crate lo rende facilissimo:

1use csv::Writer;

2use std::fs::File;

3let file = File::create("products.csv").expect("could not create file");

4let mut writer = Writer::from_writer(file);

5writer.write_record(&["Name", "Price", "URL", "Image"]).unwrap();

6for prod in &products {

7 let name = prod.name.as_deref().unwrap_or("");

8 let price = prod.price.as_deref().unwrap_or("");

9 let url = prod.url.as_deref().unwrap_or("");

10 let image = prod.image.as_deref().unwrap_or("");

11 writer.write_record(&[name, price, url, image]).unwrap();

12}

13writer.flush().unwrap();Puoi anche serializzare direttamente le struct con o esportare in JSON per dati più complessi.

Thunderbit: estrazione dati web senza stress e in pochi click

Parliamo ora di . Per quanto mi piaccia programmare, a volte serve solo il dato—subito. Thunderbit è un’estensione Chrome con AI che ti permette di estrarre dati in pochi click, senza scrivere una riga di codice.

Thunderbit è un Estrattore Web AI per Chrome che aiuta chi lavora nel business a raccogliere dati dai siti usando l’intelligenza artificiale. È uno strumento di produttività che fa risparmiare tempo e automatizza le attività ripetitive online.

Cosa rende Thunderbit speciale?

- AI che suggerisce i campi: Thunderbit analizza la pagina e ti propone le colonne da estrarre—nomi, email, prezzi, e molto altro ().

- Estrazione con un click: Basta premere “Estrai” e Thunderbit raccoglie i dati in una tabella ordinata.

- Estrazione da sottopagine: Hai bisogno di info da pagine di dettaglio? Thunderbit visita ogni link e arricchisce la tabella in automatico ().

- Gestione paginazione e scroll infinito: Thunderbit riconosce e gestisce pagine con paginazione o scroll infinito.

- Esportazione gratuita dei dati: Esporta in Excel, Google Sheets, Notion, Airtable o CSV—senza complicazioni.

- AI Autofill: Automatizza la compilazione di form o login con l’AI, così puoi estrarre dati anche dietro autenticazione.

Thunderbit è una vera manna sia per chi lavora nel business che per gli sviluppatori—soprattutto con siti dinamici o complessi.

Quando usare Thunderbit e quando Rust

- Thunderbit: Perfetto per prototipi rapidi, estrazioni una tantum o per dare autonomia anche a chi non sa programmare.

- Rust: L’ideale per progetti su larga scala, personalizzati o integrati dove servono massime prestazioni e controllo.

E la vera forza sta nel combinarli.

Confronto: Rust contro le altre tecnologie

Un po’ di numeri: come si comporta Rust rispetto agli altri?

| Linguaggio/Framework | Velocità | Uso Memoria | Concorrenza | Stabilità | Ecosistema |

|---|---|---|---|---|---|

| Rust | 🚀🚀🚀 | 🟢 Bassa | 🟢 Eccellente | 🟢 Alta | Media |

| Python (Scrapy) | 🚀 | 🔴 Alta | 🟡 Limitata | 🟡 Media | 🟢 Ampio |

| Node.js | 🚀🚀 | 🔴 Alta | 🟢 Buona | 🟡 Media | 🟢 Ampio |

| Go | 🚀🚀 | 🟢 Bassa | 🟢 Eccellente | 🟢 Alta | Media |

- Rust è spesso 2–10 volte più veloce di Python e può usare meno del 10% della memoria (, ).

- Node.js è ottimo per l’I/O, ma l’esecuzione JS è single-threaded e può rallentare con parsing pesanti.

- Go è un ottimo rivale, ma la sicurezza della memoria e le astrazioni di Rust lo rendono ideale per estrattori ad alte prestazioni e lunga durata.

Se devi estrarre dati su larga scala o vuoi il massimo delle prestazioni, Rust è difficile da battere.

Unire Thunderbit e Rust per il massimo risultato

Il mio flusso di lavoro preferito? Usare Thunderbit e Rust insieme.

- Prototipazione rapida: Usa Thunderbit per mappare velocemente un sito e ottenere dati di esempio. Così capisci la struttura prima di scrivere codice.

- Dividi e conquista: Lascia a Thunderbit le pagine dinamiche, complesse o protette (grazie ad AI Autofill e scraping su sottopagine), mentre Rust si occupa delle pagine statiche o API.

- Estrazione programmata: Imposta estrazioni pianificate con Thunderbit per raccolte regolari, poi elabora o integra i dati con Rust.

- Dai autonomia ai non sviluppatori: Il team marketing o operations può usare Thunderbit per esigenze spot, lasciando agli sviluppatori i compiti più complessi.

- Resilienza: Se il tuo estrattore Rust si rompe per un cambio di layout, l’AI di Thunderbit spesso si adatta subito—senza dover toccare il codice.

Questo approccio ibrido ti dà il meglio di entrambi: velocità e flessibilità con Thunderbit, potenza e controllo con Rust.

Consigli pratici e dritte per Estrattori Web in Rust

Costruire un estrattore robusto non è solo questione di codice—serve anticipare le vere sfide del web.

Problemi tipici

- Anti-bot: Usa User-Agent realistici, rispetta

robots.txt, limita la frequenza delle richieste e valuta l’uso di proxy per scraping intensivo (). - CAPTCHA e login: Per siti con CAPTCHA o login complicati, usa AI Autofill di Thunderbit o un browser headless (es. o )—ma solo se serve davvero.

- Siti pieni di JavaScript: Se i dati arrivano via AJAX, cerca le API sottostanti. Se serve eseguire JS, valuta Thunderbit o un browser headless.

- Gestione errori: Usa sempre una gestione errori robusta (

Result,Option), imposta timeout e registra gli errori per il debug. - Concorrenza: Usa strutture thread-safe (

Arc<Mutex<>>oDashMap) ed evita colli di bottiglia sullo stato condiviso. - Gestione memoria: Se estrai milioni di pagine, salva i dati su disco invece di tenerli tutti in RAM.

- Etica e conformità: Rispetta i termini dei siti, non sovraccaricare i server e presta attenzione alle normative sulla privacy.

Best practice

- Codice modulare: Separa logica di download, parsing e salvataggio per una manutenzione più semplice.

- Parametri configurabili: Usa file di configurazione o argomenti CLI per URL, concorrenza, ritardi, ecc.

- Logging: Usa la crate

logper log strutturati. - Testing: Scrivi test unitari per il parsing usando HTML di esempio.

- Monitoraggio: Tieni d’occhio salute del crawler—CPU, memoria, errori—soprattutto per lavori lunghi.

Per altri consigli, dai un’occhiata alla guida di e al tutorial di .

Conclusioni e takeaway

Creare un estrattore web in Rust non è solo una sfida tecnica—è un vero vantaggio strategico nel mondo dei dati. Ecco cosa portare a casa:

- Rust è una bestia per l’estrazione dati: veloce, sicuro e pensato per la concorrenza.

- Segui i passi giusti: Prepara l’ambiente, scarica e analizza le pagine, gestisci gli URL, aggiungi concorrenza ed esporta i dati.

- Thunderbit è il jolly per estrazioni rapide e senza codice—soprattutto su siti complessi o dinamici.

- Combina entrambi per il massimo: Thunderbit per prototipi e pagine difficili, Rust per scalabilità e personalizzazione.

- Sii pratico: A volte la soluzione migliore sono pochi click, non centinaia di righe di codice.

Se vuoi portare la tua estrazione dati al livello successivo, prova Rust—e lascia che ti tolga le castagne dal fuoco quando serve. Vuoi altri consigli su scraping e automazione? Dai un’occhiata al .

Buon scraping—che i tuoi dati siano sempre puliti, veloci e un po’ più smart.

Domande frequenti

1. Perché dovrei usare Rust per creare un estrattore web invece di Python o Node.js?

Rust offre prestazioni nettamente superiori, sicurezza della memoria e supporto avanzato alla concorrenza. Python e Node.js sono ottimi per script veloci, ma Rust è ideale per estrattori su larga scala, affidabili e performanti ().

2. Quali sono le librerie essenziali per creare un estrattore web in Rust?

Ti servono reqwest per le richieste HTTP, scraper per il parsing HTML, tokio per la concorrenza asincrona e csv per esportare i dati. La crate url è utile per normalizzare gli URL.

3. Come gestire siti ricchi di JavaScript o autenticati in Rust?

Per siti con tanto JS, cerca le API sottostanti o usa un browser headless con crate come fantoccini. Per pagine protette, gestisci i cookie con reqwest o usa la funzione AI Autofill di Thunderbit per automatizzare il login.

4. Qual è il vantaggio di combinare Thunderbit con Rust?

Thunderbit accelera l’estrazione dati con scraping AI e senza codice—perfetto per prototipi, pagine dinamiche o per chi non è sviluppatore. Rust è ideale per estrattori personalizzati e ad alte prestazioni. Insieme, ti permettono di lavorare velocemente e scalare senza problemi.

5. Come evitare blocchi o ban durante l’estrazione dati?

Rispetta robots.txt, usa header realistici, limita la frequenza delle richieste e valuta l’uso di proxy per scraping intensivo. Fai sempre scraping in modo etico e conforme alle normative ().

Vuoi vedere Thunderbit in azione? e inizia subito a estrarre dati in modo smart. Per altri approfondimenti su automazione e scraping, visita il .

Scopri di più