Se ti sei mai domandato come fa Google a sapere tutto quello che succede online—persino quel vecchio post che hai pubblicato nel 2012—sappi che non sei l’unico. Non è magia, né un esercito di stagisti che passano le notti a leggere internet. Il vero segreto sono i crawler: esploratori digitali che girano senza sosta per mappare, catalogare e indicizzare i siti di tutto il mondo. Dopo anni passati a sviluppare strumenti di automazione e intelligenza artificiale (e sì, ogni tanto anche a mandare in tilt qualche sito web), ho capito quanto questi bot influenzino ciò che vediamo online. Se gestisci un sito web, capire come funzionano i crawler non è solo una curiosità da smanettoni: può davvero fare la differenza tra essere trovati o restare nell’ombra.

Facciamo chiarezza su cosa sono i crawler, come “leggono” il tuo sito web, perché sono fondamentali per la SEO e cosa puoi fare per non perdere visibilità online. E, visto che sono un vero fan dell’automazione intelligente, ti mostrerò come strumenti innovativi come stanno cambiando il modo di lavorare sia per chi possiede un sito web sia per chi lavora con i dati.

Crawler: cosa sono e come funzionano?

Pensa a un crawler come a un bibliotecario digitale—o magari a un ragno super organizzato—che ha il compito di esplorare il web, un link dopo l’altro. In parole semplici, un crawler (chiamato anche spider o bot) è un software che naviga sistematicamente tra i siti web, recuperando pagine, seguendo collegamenti e raccogliendo informazioni su quello che trova. È così che motori di ricerca come Google e Bing costruiscono i loro enormi indici di contenuti online.

Ecco come funziona, in breve:

- Parte da una lista di URL conosciuti (come la tua homepage o alcuni siti “seed”).

- Scarica il contenuto HTML di ogni pagina.

- Estrae i link e li aggiunge all’elenco delle pagine da visitare.

- Ripete il processo, passando da un link all’altro, catalogando nuove pagine e aggiornando l’indice del motore di ricerca.

Immagina un bibliotecario che corre tra scaffali infiniti, annotando ogni titolo e incrociando le informazioni—ma alla velocità e alla scala di internet. Senza i crawler, gran parte del web sarebbe invisibile ai motori di ricerca e, di conseguenza, agli utenti.

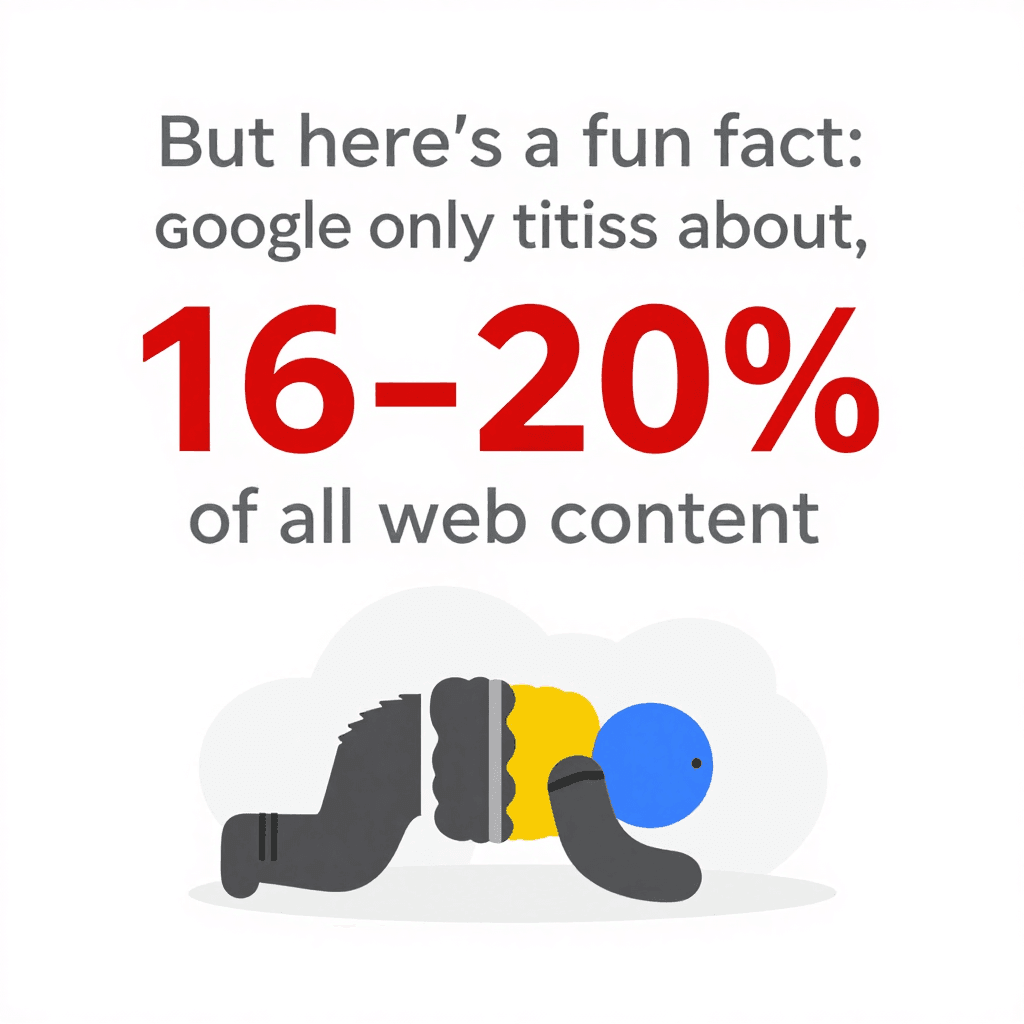

Curiosità: nonostante tutta questa potenza, Google indicizza solo circa . Il resto rimane nel “deep web”, fuori dalla portata della maggior parte dei bot. Ecco perché la struttura del tuo sito web—e quanto sia accessibile ai crawler—è fondamentale.

Curiosità: nonostante tutta questa potenza, Google indicizza solo circa . Il resto rimane nel “deep web”, fuori dalla portata della maggior parte dei bot. Ecco perché la struttura del tuo sito web—e quanto sia accessibile ai crawler—è fondamentale.

Come i crawler leggono e comprendono i contenuti di un sito web

I crawler non vedono il tuo sito web come lo vede una persona. Non si interessano a font particolari, immagini spettacolari o effetti speciali che hai curato nei dettagli. Caricano il codice HTML, leggono il testo, analizzano i tag e seguono i link. È un po’ come leggere la piantina di un edificio invece di passeggiare tra le stanze.

Ecco cosa conta davvero per i crawler:

- Struttura HTML: Cercano titoli, paragrafi, elenchi e collegamenti.

- Link interni: Sono le strade che guidano i crawler nelle varie sezioni del sito web. Se una pagina non è collegata, per un crawler è praticamente invisibile.

- Navigazione e sitemap: Menu ben organizzati e sitemap aggiornate sono come un navigatore GPS che aiuta i crawler a trovare i contenuti più importanti.

- Metadati e dati strutturati: Tag come

<title>,<meta description>e i markup Schema.org aiutano i crawler a capire di cosa parla una pagina, anche se non è chiaro dal testo principale.

Se vuoi vederla in modo tecnico, pensa al tuo sito web come a una città. I crawler sono i corrieri, mentre i link interni e le sitemap sono i cartelli stradali e le mappe che li aiutano a raggiungere ogni indirizzo.

Il ruolo di Sitemap e Robots.txt nel comportamento dei crawler

Due file sono fondamentali per il modo in cui i crawler interagiscono con il tuo sito web:

-

XML Sitemap: È un elenco leggibile dalle macchine delle pagine chiave del tuo sito web. È come consegnare al bibliotecario la lista di tutti i tuoi libri e dove trovarli. Una buona sitemap assicura che i crawler non si perdano contenuti importanti, anche se la struttura dei link interni non è perfetta. Per siti web grandi o complessi, aggiungere una sitemap completa può .

-

robots.txt: È un semplice file di testo nella radice del sito web che indica ai crawler dove possono (o non possono) accedere. Vuoi tenere i bot fuori dall’area amministrativa o bloccare pagine duplicate? Si fa qui. Ma attenzione: un solo errore di battitura (come

Disallow: /) può bloccare tutto il sito web dai motori di ricerca—un classico errore SEO. Usa robots.txt per .

Consiglio: indica sempre la sitemap nel robots.txt. È come dire “Inizia il tour da qui!”.

Perché i crawler sono fondamentali per il tuo sito web: SEO e traffico

Parliamoci chiaro: se un crawler non riesce a raggiungere una pagina, per il web è come se non esistesse. Niente crawl = niente indice = niente traffico dai motori di ricerca. Tutto il lavoro su contenuti, design e branding? Inutile, se Googlebot non lo trova.

Perché è così importante? Perché e . Se il tuo sito web non è ottimizzato per i crawler, perdi la principale fonte di visitatori.

Un sito web ben scansionato significa:

Un sito web ben scansionato significa:

- Più pagine indicizzate: Più possibilità di apparire nei risultati di ricerca.

- Migliori posizionamenti: I motori di ricerca valutano meglio la pertinenza dei tuoi contenuti.

- Aggiornamenti più rapidi: I nuovi contenuti vengono indicizzati e posizionati più velocemente.

- Esperienza utente migliore: Gli utenti trovano ciò che cercano, aumentando la tua autorevolezza e il traffico.

Ci sono tantissimi casi di siti web che hanno visto crescere il traffico semplicemente risolvendo problemi di crawl—come link rotti o tag noindex dimenticati. È il classico caso di “nascosto in bella vista”.

L’influenza dei crawler sul posizionamento nei motori di ricerca

I motori di ricerca usano i dati raccolti dai crawler per decidere quali pagine sono più rilevanti per una determinata ricerca. Analizzano:

- Qualità dei contenuti e parole chiave

- Link interni ed esterni

- Frequenza di aggiornamento delle pagine

- Ottimizzazione per dispositivi mobili (Google ora usa l’indicizzazione mobile-first)

Per i siti web molto grandi esiste anche il concetto di crawl budget—cioè il numero di pagine che un motore di ricerca scansiona in un certo periodo. Se hai 100.000 pagine ma Googlebot ne visita solo 5.000 al giorno, potrebbero volerci settimane per indicizzare tutto. Ecco perché una (dove la maggior parte delle pagine è a pochi click dalla homepage) è così efficace: aiuta i crawler a raggiungere e ri-scansionare i contenuti più facilmente.

I limiti dei crawler tradizionali: le sfide dei siti web moderni

Qui le cose si fanno più complicate. Il web di oggi è pieno di JavaScript, contenuti dinamici e aree protette da login. I crawler tradizionali—soprattutto quelli più semplici—possono perdersi, bloccarsi o arrendersi.

Le difficoltà più comuni sono:

- Contenuti dinamici e JavaScript: Molti crawler vedono solo l’HTML iniziale. Se i contenuti si caricano tramite JavaScript (come lo scroll infinito o i pulsanti “carica altri”), un bot base potrebbe non vedere nulla. Anche il crawler di Google, che può eseguire JavaScript, a volte indicizza solo parzialmente i siti web molto dinamici, soprattutto se i contenuti si caricano lentamente o dopo un’interazione ().

- Contenuti dietro login: Se una pagina richiede l’accesso, la maggior parte dei crawler non può entrarci. Di solito è voluto, ma a volte contenuti pubblici finiscono dietro un login per errore.

- robots.txt o meta tag configurati male: Un solo errore può bloccare intere sezioni del sito web ai crawler.

- Sistemi anti-bot: CAPTCHAs, limiti di accesso o blocchi per user agent sconosciuti possono fermare i crawler.

Con , i crawler hanno dovuto evolversi parecchio. Ma ci sono ancora tanti modi in cui i tuoi contenuti possono restare invisibili.

Quando i crawler tradizionali non bastano: contenuti dinamici e JavaScript

Immagina di gestire un ecommerce dove i prodotti si caricano man mano che l’utente scorre la pagina. Un crawler tradizionale potrebbe vedere solo i primi 20 prodotti, ignorando tutti gli altri. O magari le recensioni appaiono solo dopo aver cliccato su una scheda—di nuovo, invisibili per la maggior parte dei bot.

Il risultato? Contenuti preziosi non vengono indicizzati e perdi traffico dai motori di ricerca. La soluzione è offrire percorsi alternativi (come link di paginazione o HTML generato dal server) e testare come i crawler vedono il tuo sito web con strumenti come l’URL Inspection di Google Search Console.

Crawler intelligenti: come Thunderbit gestisce le pagine complesse

Qui viene il bello—perché è proprio questo il tipo di sfida che abbiamo voluto risolvere con . Thunderbit non è un semplice crawler: è un agente di estrazione dati potenziato dall’AI, capace di “leggere” i siti web come una persona, estrarre dati strutturati e gestire tutte le complessità del web moderno.

Cosa rende Thunderbit diverso?

- AI Suggerisci Campi: Invece di costringerti a cercare tra l’HTML o scrivere codice, l’AI di Thunderbit analizza la pagina e suggerisce le colonne migliori da estrarre—come “Nome prodotto”, “Prezzo” o “Email di contatto”. Puoi modificare i suggerimenti, ma il lavoro pesante lo fa lui.

- Estrazione da sottopagine: Vuoi più dettagli? Thunderbit può visitare automaticamente ogni sottopagina (come le schede prodotto o i profili utente), raccogliere le informazioni aggiuntive e arricchire il tuo dataset. Niente più click manuali o copia-incolla.

- Gestisce JavaScript e login: Thunderbit funziona come estensione Chrome (o in un vero browser nel cloud), quindi può eseguire JavaScript, attendere il caricamento dei contenuti dinamici e persino estrarre dati da pagine dove sei loggato.

- Si adatta ai cambiamenti del sito web: I tradizionali scraper si rompono se cambia il layout del sito web. L’AI di Thunderbit legge la pagina ogni volta da zero, quindi piccoli cambiamenti non bloccano il tuo flusso di lavoro.

- Estrazione programmata: Vuoi monitorare prezzi o aggiornare una lista di lead ogni mattina? Imposta una pianificazione in linguaggio naturale (“ogni lunedì alle 9”) e Thunderbit farà tutto da solo.

Thunderbit è pensato per utenti business—sales, marketing, ecommerce, real estate—che hanno bisogno di dati, non di complicazioni. E sì, esportare su Google Sheets, Notion o Airtable richiede solo un click (ed è completamente gratuito).

Le funzioni AI di Thunderbit per ottimizzare i crawler

La vera forza di Thunderbit è nell’elaborazione del linguaggio naturale. Non si limita a estrarre testo grezzo—capisce il contesto. Ad esempio, distingue tra un numero di telefono, un’email o un prezzo prodotto, e può estrarre, etichettare e persino tradurre i dati in tempo reale.

I feedback degli utenti sono entusiasti. Un recensore ha scritto: “Thunderbit è il mio strumento preferito per trovare i contatti degli influencer. Prima pagavo per database, ora li creo in pochi minuti.” Questo è il tipo di salto di qualità che mi piace vedere.

E se hai mai provato a estrarre dati da un sito web che cambia layout ogni settimana (vero, piattaforme ecommerce?), apprezzerai l’approccio “senza manutenzione” di Thunderbit. L’AI si adatta, così non devi più sistemare script rotti.

Come ottimizzare il tuo sito web per i crawler: struttura, strategia e strumenti smart

Cosa puoi fare per rendere il tuo sito web un paradiso per i crawler? Ecco alcune strategie collaudate:

- Progetta un’architettura logica: Tieni le pagine importanti a pochi click dalla homepage. Una (navigazione ampia, profondità ridotta) migliora l’efficienza del crawl e l’indicizzazione.

- Collega bene le pagine interne: Usa link contestuali tra pagine correlate. Controlla e correggi regolarmente i link rotti.

- Mantieni aggiornata la sitemap XML: Elenca tutti gli URL importanti e inviala a Google Search Console e Bing Webmaster Tools.

- Ottimizza il robots.txt: Consenti l’accesso ai contenuti chiave, blocca solo ciò che è necessario e controlla sempre di non bloccare per errore.

- La velocità conta: Pagine veloci e senza errori vengono scansionate meglio. Ottimizza le immagini, usa una CDN e risolvi gli errori del server.

- Gestisci i contenuti duplicati: Usa i tag canonical e non sprecare il crawl budget su pagine duplicate o quasi identiche.

- Sfrutta dati strutturati e metadati: Implementa Schema.org per prodotti, articoli, eventi, ecc., e cura i meta tag.

- Monitora l’attività dei crawler: Usa i report Index Coverage e Crawl Stats di Google Search Console per individuare problemi in anticipo.

- Testa con strumenti smart: Usa Thunderbit o strumenti simili per vedere come il tuo sito web appare a un crawler e per mantenere efficienti i tuoi flussi di dati.

Allineare la struttura del sito web alle esigenze dei crawler

Una struttura ben pensata non aiuta solo i bot, ma anche gli utenti. Audit regolari (con strumenti come Screaming Frog o Sitebulb) ti aiutano a individuare problemi di crawl, link rotti e pagine orfane prima che penalizzino il posizionamento.

E non dimenticare il mobile: con l’indicizzazione mobile-first di Google, il tuo sito web mobile deve contenere tutti i contenuti e i link importanti presenti nella versione desktop. Altrimenti rischi di lasciare pagine preziose fuori dall’indice ().

Thunderbit vs. crawler tradizionali: confronto rapido

Ecco una panoramica:

| Aspetto | Thunderbit (Estrattore Web AI) | Crawler/Scraper tradizionale |

|---|---|---|

| Facilità d’uso | Nessun codice, AI suggerisce i campi, gli utenti business iniziano in 2 click. | Configurazione tecnica, spesso richiede codice o selettori manuali. |

| Adattabilità | L’AI si adatta ai cambiamenti di layout, manutenzione minima. | Si rompe se cambia la struttura del sito, richiede aggiornamenti manuali. |

| Contenuti dinamici | Gestisce JavaScript, login ed elementi interattivi di default. | Spesso limitato all’HTML statico, fatica con JS o contenuti protetti da login. |

| Crawl sottopagine | Estrazione integrata da sottopagine e paginazione, unisce i dati automaticamente. | Configurazione manuale per la profondità, crawling ricorsivo richiede lavoro extra. |

| Strutturazione dati | L’AI produce tabelle pronte all’uso con colonne significative, supporta vari tipi di dati (testo, numeri, email, immagini, PDF, ecc.). | Output grezzo, l’utente deve definire la struttura, limitato all’HTML salvo personalizzazioni. |

| Integrazione | Esportazione con un click su Google Sheets, Notion, Airtable, CSV, ecc. | Di solito richiede esportazione/importazione manuale, poche integrazioni dirette. |

| Ostacoli ai bot | Gestisce proxy, user agent, retry automatici; approccio a cascata per massimizzare il successo. | L’utente deve gestire blocchi IP, CAPTCHA, ecc.—spesso complesso e costoso. |

| Utenti target | Utenti business non tecnici: sales, marketing, operations, ecommerce, real estate. | Sviluppatori, IT, data engineer. |

| Prezzi | Basato su crediti, piano gratuito disponibile, paghi solo ciò che usi. | Abbonamento, licenze o costi server; spesso costi nascosti per proxy o manutenzione. |

In sintesi: Thunderbit porta la potenza dei crawler avanzati a tutti, non solo agli sviluppatori. È veloce, preciso e si adatta al web che cambia.

In sintesi: come sfruttare al meglio i crawler per il tuo sito web

- I crawler sono la chiave della visibilità online. Se il tuo sito web non è ottimizzato per i crawler, perdi traffico e nuovi visitatori.

- Struttura e strategia sono fondamentali. Navigazione logica, link interni, sitemap e robots.txt sono i tuoi migliori alleati.

- I siti web moderni richiedono crawler più intelligenti. JavaScript, contenuti dinamici e login possono bloccare i bot tradizionali—ma strumenti AI come gestiscono la complessità.

- Il monitoraggio costante è essenziale. Usa Search Console, audit di crawl e strumenti di scraping smart per mantenere il sito web sano e visibile.

- Aggiorna la tua cassetta degli attrezzi. Che tu faccia SEO o costruisca pipeline di dati, valuta come i crawler intelligenti possono farti risparmiare tempo, aumentare la precisione e supportare decisioni di business migliori.

Vuoi vedere come Thunderbit può aiutarti a scansionare, indicizzare ed estrarre dati anche dai siti web più complessi? e provala subito. Per altri consigli su web scraping, SEO e automazione, visita il .

Domande frequenti

1. Cos’è un crawler e perché è importante per il mio sito web?

Un crawler è un software che naviga e indicizza i contenuti dei siti web per i motori di ricerca. Se il tuo sito web non è ottimizzato per i crawler, le tue pagine potrebbero non apparire nei risultati di ricerca, rendendo difficile farti trovare dagli utenti.

2. Come influiscono sitemap e robots.txt sui crawler?

Le sitemap guidano i crawler verso le pagine più importanti, mentre il robots.txt indica dove possono o non possono accedere. Entrambi sono essenziali per una scansione e indicizzazione efficiente.

3. Quali problemi incontrano i crawler tradizionali con i siti web moderni?

I crawler tradizionali hanno difficoltà con contenuti generati da JavaScript, elementi dinamici, pagine protette da login e sistemi anti-bot. Di conseguenza, possono non indicizzare o indicizzare solo parzialmente contenuti importanti.

4. In che modo Thunderbit gestisce diversamente i siti web complessi?

Thunderbit usa l’AI per “leggere” le pagine come una persona, gestire JavaScript e login, ed estrarre dati strutturati anche da sottopagine e contenuti dinamici. Si adatta ai cambiamenti del sito web e non richiede codice.

5. Quali sono le best practice per rendere il mio sito web crawler-friendly?

Mantieni una struttura logica, usa link interni, aggiorna sitemap e robots.txt, ottimizza la velocità e monitora regolarmente l’attività dei crawler. Usa strumenti smart come Thunderbit per testare e migliorare la crawlabilità del sito web.

Vuoi approfondire? Scopri altre guide sul o iscriviti al nostro per restare aggiornato su automazione web e scraping AI.

Scopri di più