Nel 2025, i dati online sono diventati il vero motore di tutto: dalle strategie di vendita più furbe alle analisi di mercato più dettagliate. Ho visto personalmente team di ogni settore—dall’ecommerce al real estate, passando per il SaaS—impegnarsi a trasformare pagine web caotiche in fogli di calcolo ordinati e subito pronti all’uso. Se stai leggendo questa guida, probabilmente anche tu vuoi entrare in questo mondo. La bella notizia? Python è il compagno perfetto per lo scraping, e oggi è davvero alla portata di tutti—anche se non sei uno sviluppatore di professione.

In questa guida ti porto passo passo nei fondamentali dell’estrazione dati dal web con Python: dal tuo primo script fino a progetti più avanzati con framework come Scrapy. Vedremo anche come strumenti AI come stanno rivoluzionando il modo in cui le aziende raccolgono dati, rendendo tutto più veloce e semplice che mai. Che tu sia un principiante curioso o un professionista in cerca di nuove soluzioni, qui troverai passaggi pratici, esempi di codice e dritte utili per diventare davvero esperto di estrattore web.

Cos’è lo Web Scraping in Python? Una panoramica veloce

Fare web scraping significa automatizzare l’estrazione di informazioni dai siti web—praticamente insegni al tuo computer a copiare e incollare dati per te, ma a una velocità e su una scala che manualmente sarebbe impossibile. In Python, si tratta di scrivere script che recuperano pagine web, analizzano l’HTML e raccolgono solo le informazioni che ti servono: prezzi, contatti, recensioni e molto altro.

Per chi lavora nel business, l’estrattore web è una vera miniera d’oro. I team di vendita lo usano per creare liste di potenziali clienti, chi si occupa di ecommerce tiene d’occhio i prezzi dei concorrenti, gli analisti seguono le tendenze di mercato—tutto trasformando contenuti web non strutturati in dati pronti per l’analisi. Python spicca perché è potente ma anche facile da imparare, diventando la scelta preferita per progetti di scraping di ogni dimensione ().

Perché Python è la lingua preferita per lo Web Scraping

Ma perché tutti puntano su Python per lo scraping? Tre motivi: è semplice, ha un ecosistema di librerie incredibile e una community sempre pronta a darti una mano.

- Sintassi leggibile: Il codice Python è facile da scrivere e ancora più facile da leggere. Non serve essere ingegneri per iniziare.

- Librerie potenti: Strumenti come BeautifulSoup, Scrapy e Requests rendono scraping, parsing e crawling un gioco da ragazzi.

- Versatilità: Python non è solo scraping. È fortissimo anche nell’analisi dati e nell’automazione, così puoi passare dai dati grezzi agli insight senza cambiare linguaggio.

- Supporto della community: Bloccato su una struttura HTML strana? Qualcuno su Stack Overflow ha già risolto il problema.

Ecco un confronto tra Python e altri linguaggi:

| Linguaggio | Vantaggi | Svantaggi | Ideale per |

|---|---|---|---|

| Python | Sintassi semplice, librerie ricche, community | Più lento di C++/Java in termini di velocità | Tutti i tipi di scraping |

| JavaScript | Gestisce siti dinamici nativamente | Parsing HTML meno maturo, gestione async | Single-page app, siti dinamici |

| R | Ottimo per analisi dati | Meno framework per scraping | Task piccoli, analisi statistiche |

| Java/C# | Performance elevate, livello enterprise | Verboso, più codice necessario | Sistemi integrati di grandi dimensioni |

Python è costantemente tra i linguaggi più usati per lo scraping e nel 2023 ha superato SQL come terzo linguaggio più utilizzato al mondo ().

Strumenti e librerie essenziali per lo Web Scraping in Python

Ecco il kit base per iniziare con lo scraping in Python:

- Requests: La libreria di riferimento per fare richieste HTTP. Recupera le pagine web come se fossi nel browser.

- BeautifulSoup: Il coltellino svizzero per analizzare HTML e XML. Permette di cercare, filtrare ed estrarre dati dalle pagine.

- Scrapy: Un framework completo per scraping e crawling su larga scala.

- Selenium: Automatizza il browser per estrarre dati da siti dinamici e ricchi di JavaScript.

- Altri:

lxmlper parsing veloce,pandasper manipolare dati, ePlaywrightper automazione browser moderna.

Quando usare cosa?

- Requests + BeautifulSoup: Perfetto per pagine statiche e progetti piccoli.

- Scrapy: Ideale per esplorare tanti link, gestire la paginazione ed esportare dati su larga scala.

- Selenium/Playwright: Da usare quando serve interagire con JavaScript o simulare azioni utente.

Iniziare: Configurare l’ambiente Python per lo Web Scraping

Prepariamo l’ambiente. Anche se sei alle prime armi con Python, la configurazione è semplice.

-

Installa Python: Scarica Python 3.x da . Assicurati che sia nel PATH di sistema.

-

Crea un ambiente virtuale: Così tieni le dipendenze del progetto in ordine.

1python3 -m venv venv 2# Attiva l’ambiente: 3# Su Windows: 4venv\Scripts\activate 5# Su Mac/Linux: 6source venv/bin/activate -

Installa le librerie:

1pip install requests beautifulsoup4 scrapy selenium -

Organizza il progetto: Per script semplici basta un file

.py. Per Scrapy, usascrapy startproject mio_progettoper creare la struttura. -

Testa l’installazione:

1import requests, bs4, scrapy, selenium 2print("Tutte le librerie importate correttamente!") -

Imposta uno User-Agent (consigliato): Alcuni siti bloccano “Python-requests” di default. Simula un browser:

1headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

Complimenti, sei pronto per iniziare a estrarre dati!

Analizzare HTML con BeautifulSoup: Il tuo primo Estrattore Web in Python

Facciamo insieme un estrattore semplice. Raccoglieremo citazioni e autori da —un sito pensato proprio per fare pratica.

Passo 1: Analisi della struttura del sito

- Apri il sito in Chrome.

- Clicca con il tasto destro su una citazione e scegli “Ispeziona”.

- Ogni citazione è in un

<div class="quote">, con il testo in<span class="text">e l’autore in<small class="author">.

Passo 2: Scrivere ed eseguire lo script

Ecco uno script base:

1import requests

2from bs4 import BeautifulSoup

3url = "http://quotes.toscrape.com/page/1/"

4headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64)"}

5res = requests.get(url, headers=headers)

6if res.status_code != 200:

7 print(f"Richiesta fallita: {res.status_code}")

8 exit()

9soup = BeautifulSoup(res.text, "html.parser")

10quote_divs = soup.find_all("div", class_="quote")

11for div in quote_divs:

12 quote_text = div.find("span", class_="text").get_text(strip=True)

13 author = div.find("small", class_="author").get_text(strip=True)

14 print(f"{quote_text} --- {author}")Errori comuni:

- Se un elemento manca, controlla che non sia

Noneprima di usare.get_text(). - Verifica sempre i selettori nel browser.

Scalare: Ottimizzare lo Web Scraping in Python con Scrapy

Quando le tue esigenze passano da “solo questa pagina” a “tutto il sito e le sue sottopagine”, è il momento di Scrapy.

- Architettura: Scrapy usa “spiders” (classi che definiscono come navigare e analizzare), pipelines (per processare i dati) e richieste asincrone per la velocità.

- Perché Scrapy? È pensato per la scalabilità—può gestire migliaia di pagine, errori e esportare dati in CSV/JSON senza complicazioni.

Quando scegliere Scrapy invece di BeautifulSoup

- Devi esplorare molte pagine o seguire link automaticamente.

- Vuoi supporto integrato per retry, limiti di velocità e pipeline dati.

- Stai costruendo un estrattore che userai spesso o condividerai con il team.

Scrapy in pratica: esempio di progetto

Ecco uno spider che raccoglie tutte le citazioni da tutte le pagine:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/page/1/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 "text": quote.css("span.text::text").get(),

9 "author": quote.css("small.author::text").get(),

10 "tags": quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)Esegui con:

1scrapy crawl quotes -O quotes.jsonE ti ritrovi un file JSON con tutti i dati—senza dover scrivere cicli manuali.

Quando il tuo progetto cresce, l’architettura e la velocità di Scrapy lo rendono la scelta ideale per l’estrazione dati su larga scala.

Thunderbit: Strumenti AI che potenziano lo Web Scraping in Python

Diciamolo chiaro: anche con Python, lo scraping può diventare complicato—soprattutto con siti dinamici, sottopagine o layout che cambiano spesso. Qui entra in gioco .

Thunderbit è un’estensione Chrome basata su AI che ti permette di estrarre dati da qualsiasi sito in due click:

- AI Suggerisce i campi: L’intelligenza artificiale analizza la pagina e suggerisce le colonne migliori da estrarre (come “Nome prodotto”, “Prezzo”, ecc.).

- Estrai: Un altro click e Thunderbit raccoglie tutti i dati—gestendo paginazione, sottopagine e anche lo scroll infinito.

Perché adoro Thunderbit:

- Nessun codice richiesto: Perfetto per utenti business e analisti.

- Gestisce siti complessi: Contenuti dinamici, sottopagine e layout che cambiano? L’AI si adatta.

- Esportazione immediata: Invia i dati direttamente su Excel, Google Sheets, Airtable o Notion.

- Estrazione da sottopagine: Vuoi dettagli da ogni prodotto o profilo? Thunderbit visita ogni sottopagina e arricchisce la tua tabella in automatico.

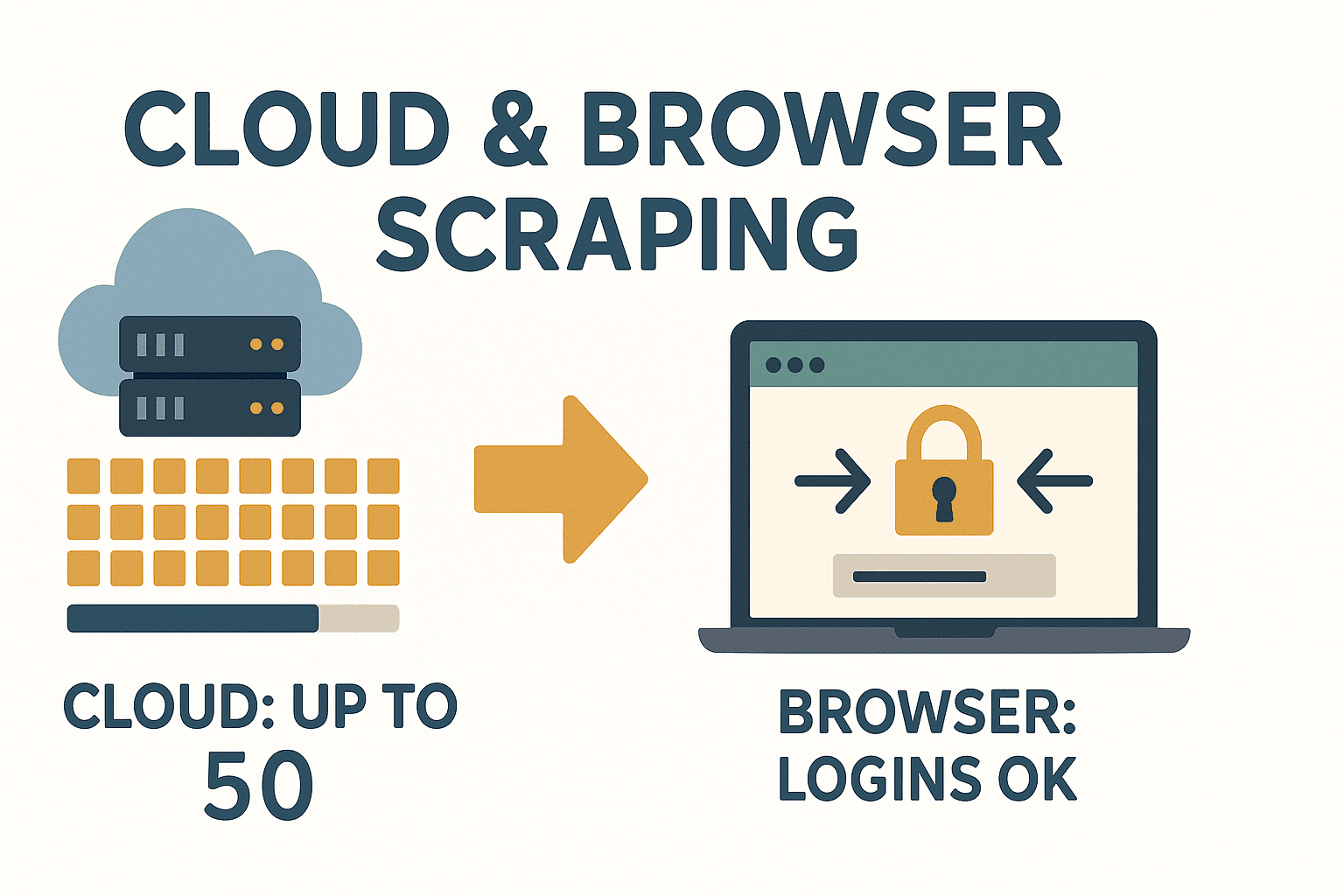

- Modalità cloud o browser: Estrai fino a 50 pagine alla volta nel cloud, oppure usa il browser per siti che richiedono login.

Thunderbit è una svolta per chi ha bisogno di dati subito e non vuole impazzire ogni volta che un sito cambia.

Thunderbit è una svolta per chi ha bisogno di dati subito e non vuole impazzire ogni volta che un sito cambia.

Quando usare strumenti AI come Thunderbit

- Hai bisogno di dati subito e non vuoi aspettare l’IT o scrivere codice.

- Il sito è complesso, dinamico o cambia spesso.

- Vuoi permettere anche ai colleghi meno tecnici di raccogliere dati.

- Vuoi estrarre e arricchire i dati (tradurre, categorizzare, ecc.) in un’unica soluzione.

Thunderbit si integra perfettamente nei flussi Python—usalo per prototipi rapidi, siti complessi o quando vuoi evitare la manutenzione. Per approfondire, leggi il .

Gestire contenuti dinamici e paginazione nello Web Scraping Python

I siti moderni fanno largo uso di JavaScript, e questo può complicare lo scraping. Ecco come affrontare la situazione:

- Contenuti dinamici: Se i dati vengono caricati da JS (e non sono nell’HTML iniziale), usa Selenium o Playwright per automatizzare il browser, attendere il caricamento e poi estrarre.

- Paginazione: Cicla sui link “Successivo” o incrementa il numero di pagina nell’URL. Scrapy gestisce tutto in modo elegante con il suo sistema di follow delle richieste.

Esempio: Gestire la paginazione con BeautifulSoup

1page = 1

2while True:

3 url = f"http://quotes.toscrape.com/page/{page}/"

4 res = requests.get(url, headers=headers)

5 if res.status_code == 404:

6 break

7 soup = BeautifulSoup(res.text, 'html.parser')

8 quotes = soup.find_all("div", class_="quote")

9 if not quotes:

10 break

11 # ...estrai citazioni...

12 page += 1Per scroll infinito o pulsanti “Carica altro”: Usa Selenium per scrollare o cliccare, oppure controlla la scheda di rete per trovare chiamate API che puoi replicare con Requests.

Salvataggio dati: dove archiviare i dati estratti

Una volta ottenuti i dati, è importante salvarli in modo utile.

- CSV: Universale, perfetto per Excel/Sheets.

1import csv 2with open('data.csv', 'w', newline='') as f: 3 writer = csv.DictWriter(f, fieldnames=['name', 'price']) 4 writer.writeheader() 5 for row in data: 6 writer.writerow(row) - Excel: Usa pandas per esportare velocemente.

1import pandas as pd 2df = pd.DataFrame(data) 3df.to_excel('data.xlsx', index=False) - Database: Per progetti grandi o continui, usa SQLite o PostgreSQL.

1import sqlite3 2conn = sqlite3.connect('scraped_data.db') 3# ...crea tabella, inserisci dati... 4conn.close()

Scegli il formato che si adatta meglio al tuo flusso di lavoro. Per condividere con colleghi non tecnici, Excel o Google Sheets sono spesso la scelta migliore.

Aspetti legali ed etici nello Web Scraping in Python

Lo scraping è potente, ma va usato con responsabilità. Ecco come restare dalla parte giusta:

- Estrai solo dati pubblici: Se serve login o è dietro un paywall, valuta bene.

- Controlla i Termini di Servizio: Alcuni siti vietano esplicitamente lo scraping. Ignorare le regole può portare a blocchi o peggio ().

- Rispetta robots.txt: Non è vincolante legalmente, ma è buona educazione.

- Evita dati personali: GDPR e CCPA vietano la raccolta di nomi, email o numeri di telefono senza consenso.

- Non sovraccaricare i server: Inserisci ritardi, limita la frequenza delle richieste e lavora in orari di basso traffico.

Checklist rapida per la conformità:

- Leggi i ToS e robots.txt del sito.

- Evita dati personali o sensibili.

- Cita sempre la fonte dei dati.

- Sii rispettoso: non sovraccaricare il server.

Per approfondire le buone pratiche legali, vedi .

Risoluzione problemi e best practice per scraping affidabile in Python

Lo scraping non è sempre una passeggiata. Ecco come affrontare le difficoltà:

- Errori HTTP (403, 404, 429): Imposta uno User-Agent realistico, rallenta le richieste e gestisci gli errori con cura.

- IP bloccati: Usa proxy o ruota l’IP se lavori su larga scala—ma chiediti sempre se stai oltrepassando i limiti etici.

- CAPTCHA: Se incontri un CAPTCHA, valuta se continuare. Esistono servizi per risolverli, ma è un’area grigia.

- Cambiamenti nella struttura del sito: Usa selettori robusti, controlla che gli elementi non siano

Nonee proteggi il codice con try/except. - Problemi di encoding: Usa sempre UTF-8 e testa l’output su Excel o Sheets.

Best practice:

- Registra ogni passaggio—così saprai dove si è rotto qualcosa.

- Riprova le richieste fallite con backoff.

- Testa lo scraper su poche pagine prima di scalarlo.

- Monitora l’output—se il numero di elementi cala, qualcosa è cambiato.

E se sei stanco di correggere scraper ogni volta che un sito cambia, ricorda: usa l’AI per adattarsi automaticamente ai nuovi layout.

L’approccio AI di Thunderbit ti permette di concentrarti sulle analisi, non sulla manutenzione.

Conclusioni & punti chiave

Lo web scraping in Python è una vera marcia in più per chi lavora con i dati—trasforma il caos del web in informazioni strutturate e subito utilizzabili. Ecco cosa abbiamo visto:

- Python è la scelta numero uno per lo scraping, grazie alla sintassi chiara e alle librerie potenti.

- Requests + BeautifulSoup sono perfetti per lavori piccoli e pagine statiche; Scrapy è lo strumento ideale per crawling automatizzato su larga scala.

- Thunderbit porta l’AI nello scraping, rendendolo accessibile a tutti—senza codice, senza stress, solo dati.

- Gestisci contenuti dinamici e paginazione con Selenium o le funzioni integrate di Scrapy.

- Salva i tuoi dati in CSV, Excel o database—a seconda delle esigenze aziendali.

- Rispetta la legge e l’etica: Estrai solo dati pubblici, rispetta le regole dei siti ed evita dati personali.

- Costruisci scraper robusti: Registra, riprova e monitora i cambiamenti. Oppure lascia che l’AI di Thunderbit si occupi di tutto.

Pronto a iniziare? Prova a creare il tuo primo estrattore web Python—oppure, se vuoi saltare la programmazione, e scopri quanto può essere semplice estrarre dati dal web. Per altri consigli e approfondimenti, visita il .

Domande frequenti

1. Lo web scraping in Python è legale?

Lo scraping è legale se raccogli solo dati pubblici e rispetti i termini di servizio del sito, robots.txt e le leggi sulla privacy come GDPR. Evita dati personali o sensibili e controlla sempre le regole prima di iniziare ().

2. Qual è la differenza tra BeautifulSoup e Scrapy?

BeautifulSoup è un parser HTML leggero—ottimo per lavori semplici o una singola pagina. Scrapy è un framework completo per esplorare molte pagine, gestire la paginazione ed esportare dati su larga scala. Usa BeautifulSoup per script rapidi, Scrapy per progetti complessi ().

3. Come gestire siti ricchi di JavaScript in Python?

Usa Selenium o Playwright per automatizzare il browser, attendere il caricamento JavaScript e poi estrarre i dati. In alternativa, controlla la scheda di rete per trovare chiamate API replicabili con Requests.

4. Cosa rende Thunderbit diverso dalle librerie Python per scraping?

Thunderbit sfrutta l’AI per suggerire i campi, gestire sottopagine e adattarsi ai cambi di layout—senza bisogno di codice. È perfetto per utenti business e team che vogliono dati subito, senza la manutenzione degli scraper tradizionali ().

5. Come posso archiviare e condividere i dati estratti con il mio team?

Esporta i dati in CSV o Excel per condividerli facilmente, oppure usa pandas per salvarli in database per progetti più grandi. Thunderbit permette di esportare direttamente su Google Sheets, Airtable, Notion o scaricare in CSV/Excel gratuitamente.

Buon scraping—che i tuoi dati siano sempre puliti, strutturati e pronti all’uso.