Il web si espande a una velocità pazzesca e, se lavori nel business, nella tecnologia o sei semplicemente un fanatico dei dati come me, avrai già capito che il vero tesoro sta nei dati che riesci a raccogliere—non solo in quelli che hai sotto gli occhi. Oggi le aziende fanno a gara per automatizzare la raccolta di dati online, tanto che il mercato globale dell’estrazione dati dal web è destinato a toccare i . E un dato che fa riflettere: oltre il già utilizza crawler o estrattori web per alimentare sistemi di intelligenza artificiale, analisi e processi aziendali.

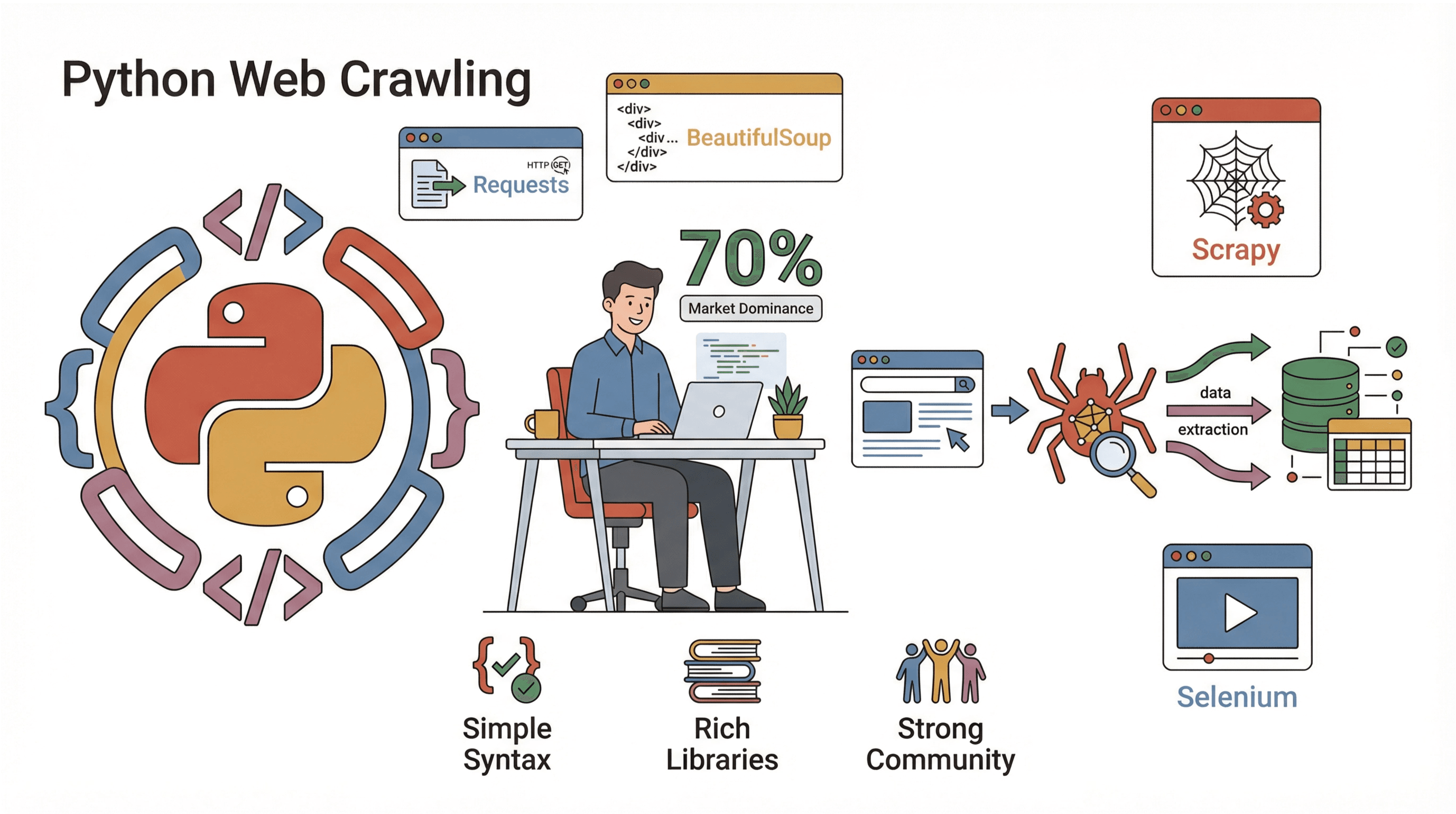

Ma come si entra in questo mondo? Per la maggior parte delle persone, la risposta è Python. È il linguaggio preferito per creare crawler di siti web: semplice, potente e pieno di librerie che ti semplificano la vita. In questa guida ti spiego cos’è un crawler, perché Python è la scelta top, come costruirne uno passo dopo passo e come strumenti come possono rendere tutto ancora più facile (soprattutto se preferisci cliccare invece che programmare). Che tu sia uno sviluppatore, un marketer che ama i dati o semplicemente vuoi automatizzare le solite attività ripetitive, qui troverai dritte per portare la raccolta dati web a un altro livello.

Cos’è un Website Crawler? (E Perché Dovresti Interessartene)

Facciamo chiarezza: un website crawler è un programma che naviga il web in automatico, visita pagine, segue link e (se serve) raccoglie dati lungo il percorso. Immaginalo come un super-navigatore che non si stanca mai, non si distrae e non chiude mai la scheda sbagliata. I crawler sono il motore dei motori di ricerca (tipo Googlebot), ma vengono usati anche dalle aziende per monitorare prezzi, fare ricerche di mercato e molto altro.

Ma qual è la differenza tra crawling e scraping? Il crawling serve a scoprire e mappare le pagine (come disegnare la mappa di una città), mentre lo scraping serve a estrarre dati specifici da quelle pagine (come raccogliere tutti i menù dei ristoranti in città). Nella pratica, spesso si fanno entrambe le cose: si esplorano le pagine e poi si estraggono i dati che servono ().

Esempi pratici di utilizzo dei crawler in azienda:

- Lead generation: Raccogli in automatico contatti da directory o social network.

- Monitoraggio prezzi: Tieni d’occhio prezzi e disponibilità dei concorrenti su migliaia di prodotti.

- Content monitoring: Ricevi notifiche quando il tuo brand viene citato su news, blog o forum.

- SEO auditing: Analizza il tuo sito per link rotti o metadati mancanti.

- Ricerche di mercato: Aggrega annunci immobiliari, offerte di lavoro o recensioni di prodotti per analisi approfondite.

Se hai mai sognato di poterti clonare per seguire tutte le ricerche online, un crawler è la soluzione più vicina che puoi trovare.

Perché i Website Crawler Sono Fondamentali per l’Automazione Aziendale

Andiamo dritti al punto: perché le aziende investono in crawler ed estrattori web? Perché il ritorno è enorme. Ecco una panoramica di come diversi team li usano e quali vantaggi ottengono:

| Caso d’uso | Vantaggio principale | Chi lo usa |

|---|---|---|

| Lead Generation | Automatizza la creazione di liste di potenziali clienti | Vendite, Recruiting |

| Monitoraggio Prezzi | Informazioni in tempo reale sui concorrenti | E-commerce, Product Team |

| Content Monitoring | Protezione del brand, individuazione trend | Marketing, PR |

| Audit SEO | Salute del sito, miglioramento posizionamento | SEO, Webmaster |

| Ricerche di Mercato | Dataset aggiornati e su larga scala per analisi | Analisti, Ricerca |

Uno studio ha dimostrato che automatizzare una raccolta dati settimanale (da 5-7 siti) ha fatto risparmiare a un solo dipendente oltre 50 ore l’anno—moltiplica questo per un intero team e capirai perché dopo aver iniziato a usare i crawler.

Python: La Scelta Migliore per Creare un Website Crawler

Perché Python è il re del web crawling? Tre motivi chiave:

Perché Python è il re del web crawling? Tre motivi chiave:

- Semplicità: La sintassi di Python è leggibile, perfetta anche per chi è alle prime armi e permette di scrivere crawler funzionanti in poche righe.

- Ecosistema di librerie: Python offre una marea di librerie per ogni fase del crawling: scaricare pagine, analizzare HTML, gestire JavaScript e molto altro.

- Community: Con quasi il realizzati in Python, troverai una community enorme, tantissimi tutorial e soluzioni a qualsiasi problema.

Le principali librerie Python per il web crawling:

- Requests: Il modo più semplice per scaricare pagine web (HTTP GET/POST).

- BeautifulSoup: Perfetta per analizzare HTML e trovare elementi specifici.

- Scrapy: Un framework completo per progetti di crawling su larga scala.

- Selenium: Automatizza il browser per estrarre dati da siti che usano tanto JavaScript.

Rispetto ad altri linguaggi (come Java o C#), Python ti permette di passare dall’idea al crawler funzionante in pochissimo tempo. E se lavori con i dati, puoi collegare direttamente l’output del crawler a Pandas per l’analisi—senza passaggi complicati.

Confronto tra Metodi di Parsing: Regex, BeautifulSoup e Scrapy

Quando si tratta di estrarre dati dalle pagine web, hai diverse opzioni. Ecco come si confrontano i principali metodi:

| Metodo | Come funziona | Pro 🟢 | Contro 🔴 | Ideale per |

|---|---|---|---|---|

| Regex | Cerca pattern nell’HTML grezzo | Veloce per pattern semplici e noti | Fragile, si rompe se l’HTML cambia | Script rapidi, estrazione URL |

| BeautifulSoup | Analizza l’HTML come un albero, cerca tag | Facile, flessibile, gestisce HTML disordinato | Più lento su pagine grandi, logica manuale | Script di scraping piccoli/medi |

| Scrapy | Framework completo, parsing CSS/XPath | Veloce, scalabile, gestisce crawling e parsing | Curva di apprendimento, più configurazione | Crawler su larga scala/produttivi |

- Regex è come usare un metal detector sulla spiaggia: veloce, ma rischi di perdere qualcosa se la sabbia si sposta.

- BeautifulSoup è come avere una mappa e una pala: puoi scavare ovunque, ma devi camminare tu.

- Scrapy è come arrivare con una squadra e camion: esagerato per una spiaggetta, ma imbattibile per grandi progetti.

Se sei alle prime armi, ti consiglio Requests + BeautifulSoup: impari le basi e puoi sempre passare a Scrapy quando vuoi scalare.

Guida Pratica: Come Creare un Website Crawler in Python Passo Dopo Passo

Pronto a metterti in gioco? Costruiamo un crawler base che visita pagine, segue link e raccoglie dati. Ti spiego ogni passaggio, con codice pronto da copiare e modificare.

Passo 1: Prepara l’Ambiente Python

Assicurati di avere Python 3.10+ installato (controlla con python --version). Ti consiglio di creare un ambiente virtuale per il progetto:

1python -m venv venv

2source venv/bin/activate # Su Windows: venv\Scripts\activatePoi installa le librerie che ti servono:

1pip install requests beautifulsoup4Fatto! Apri il tuo editor preferito e sei pronto a scrivere il crawler.

Passo 2: Scrivi il Primo Script di Crawler

Iniziamo scaricando una singola pagina. Ecco uno script semplice:

1import requests

2def crawl_page(url):

3 response = requests.get(url)

4 response.raise_for_status() # Errore se non 200 OK

5 print(response.text[:500]) # Anteprima dei primi 500 caratteri

6crawl_page("https://www.scrapingcourse.com/ecommerce/")Dovresti vedere un pezzo di HTML nella console—segno che la connessione funziona.

Passo 3: Segui i Link e Raccogli Più Dati

Ora facciamo in modo che il crawler segua i link e visiti più pagine. Teniamo una lista di URL da visitare e un set di URL già visti (per evitare cicli):

1from bs4 import BeautifulSoup

2start_url = "https://www.scrapingcourse.com/ecommerce/"

3urls_to_visit = [start_url]

4visited_urls = set()

5max_pages = 20 # Limite di sicurezza

6while urls_to_visit and len(visited_urls) < max_pages:

7 current_url = urls_to_visit.pop(0)

8 try:

9 resp = requests.get(current_url)

10 resp.raise_for_status()

11 except Exception as e:

12 print(f"Impossibile recuperare {current_url}: {e}")

13 continue

14 soup = BeautifulSoup(resp.text, "html.parser")

15 print(f"Crawled: {current_url}")

16 for link_tag in soup.find_all("a", href=True):

17 url = link_tag['href']

18 if not url.startswith("http"):

19 url = requests.compat.urljoin(current_url, url)

20 if url.startswith(start_url) e url not in visited_urls:

21 urls_to_visit.append(url)

22 visited_urls.add(current_url)Questo script esplora fino a 20 pagine, seguendo solo i link interni al sito. Vedrai ogni URL man mano che viene visitato.

Passo 4: Estrai Dati dalle Pagine

Supponiamo di voler raccogliere nomi e prezzi dei prodotti da ogni pagina. Ecco come potresti fare:

1product_data = []

2while urls_to_visit and len(visited_urls) < max_pages:

3 # ... (come sopra)

4 soup = BeautifulSoup(resp.text, "html.parser")

5 if "/page/" in current_url or current_url == start_url:

6 items = soup.find_all("li", class_="product")

7 for item in items:

8 name = item.find("h2", class_="product-name")

9 price = item.find("span", class_="price")

10 link = item.find("a", class_="woocommerce-LoopProduct-link")

11 if name and price and link:

12 product_data.append({

13 "name": name.get_text(),

14 "price": price.get_text(),

15 "url": link['href']

16 })

17 # ... (resto della logica)

18# Salva in CSV

19import csv

20with open("products.csv", "w", newline="") as f:

21 writer = csv.DictWriter(f, fieldnames=["name", "price", "url"])

22 writer.writeheader()

23 writer.writerows(product_data)

24print(f"Estratti {len(product_data)} prodotti.")Ora hai un file CSV con tutti i prodotti raccolti—pronto per analisi, upload o per stupire i colleghi.

Passo 5: Debug e Ottimizzazione del Crawler

Costruire un crawler è una cosa, renderlo affidabile è un’altra. Ecco qualche dritta pratica (frutto anche di errori personali):

- Imposta l’header User-Agent: Alcuni siti bloccano “Python-requests” di default. Fingi di essere un browser:

1headers = {"User-Agent": "Mozilla/5.0"} 2requests.get(url, headers=headers) - Gestisci gli errori: Usa try/except per saltare pagine rotte o bloccate.

- Evita loop infiniti: Tieni traccia degli URL visitati e imposta un limite massimo di pagine.

- Rallenta le richieste: Inserisci

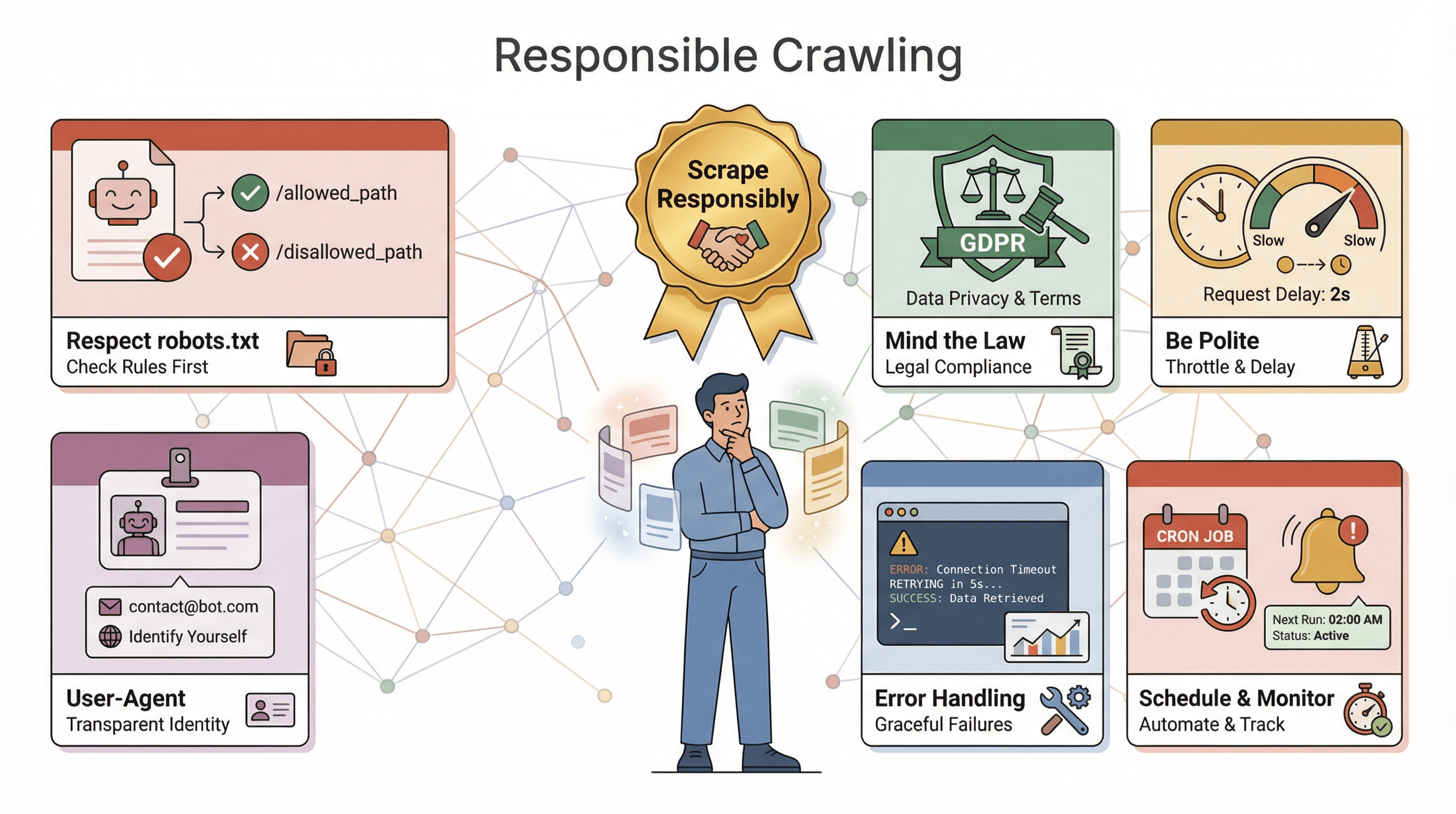

time.sleep(1)tra una richiesta e l’altra per non farti bloccare. - Controlla robots.txt: Rispetta sempre le regole di crawling di un sito ().

- Logga i progressi: Stampa o registra ogni URL visitato—fondamentale per il debug.

Se il tuo crawler viene bloccato, restituisce contenuti strani o manca dei dati, controlla gli header, rallenta e assicurati di non violare le regole anti-bot.

Thunderbit: Semplifica il Crawling dei Siti Web con l’AI

Parliamo ora del “pulsante facile” per il crawling: . Per quanto ami Python, a volte vuoi solo i dati—senza configurazioni, debug o manutenzione. Thunderbit è un’estensione Chrome Estrattore Web AI che ti permette di estrarre dati da qualsiasi sito in pochi clic.

Cosa rende Thunderbit speciale?

- AI Suggerisce i Campi: L’AI di Thunderbit analizza la pagina e ti suggerisce quali dati puoi estrarre—senza dover ispezionare l’HTML o scrivere selettori.

- No-code, tutto dal browser: Funziona direttamente nel browser, anche su siti che richiedono login o usano tanto JavaScript.

- Estrazione da sottopagine: Vuoi più dettagli? Thunderbit può visitare automaticamente ogni sottopagina (es. dettagli prodotto) e arricchire la tua tabella.

- Esportazione immediata: Esporta i dati su Excel, Google Sheets, Airtable o Notion—senza dover gestire file CSV.

- Estrazione cloud o locale: Scegli tra estrazione veloce in cloud (per siti pubblici) o modalità browser (per siti con login o complessi).

- Pianificazione automatica: Imposta estrazioni programmate—senza cron job o server.

Per chi lavora in azienda, Thunderbit è una vera svolta. Passi da “mi serve questo dato” a “ecco il mio foglio di calcolo” in pochi minuti. E se sei uno sviluppatore, Thunderbit può affiancare i tuoi script—usalo per lavori rapidi o come backup quando il codice ha bisogno di una pausa.

Vuoi vedere come funziona? e prova a estrarre dati dal tuo sito preferito. Il piano gratuito ti permette di estrarre alcune pagine, mentre i piani a pagamento partono da soli 15$/mese per 500 crediti.

Cosa Considerare Quando Crei un Website Crawler in Python

Prima di lanciare il tuo crawler, qualche consiglio (e avvertimento):

Prima di lanciare il tuo crawler, qualche consiglio (e avvertimento):

- Rispetta robots.txt: Quasi tutti i siti pubblicano un file

robots.txtche indica cosa è permesso ai crawler. Ignorarlo può portare a blocchi o, peggio, a problemi legali. Controlla e rispetta sempre queste regole (). - Attenzione alla legge: Alcuni siti vietano lo scraping nei termini di servizio. Se raccogli dati personali, potrebbero applicarsi normative come GDPR o CCPA (). In caso di dubbio, limita la raccolta a dati pubblici e non sensibili.

- Sii educato: Non sovraccaricare i siti con troppe richieste—rallenta il crawler, varia i tempi e evita le ore di punta.

- Identificati: Usa una stringa User-Agent personalizzata e, se fai scraping su larga scala, considera di inserire un contatto.

- Gestisci errori e log: I siti cambiano, le pagine si rompono, i dati si sporcano. Prevedi gestione errori, logging e monitoraggio per risolvere rapidamente.

- Pianifica e monitora: Per estrazioni regolari, usa strumenti di pianificazione (come cron o il pianificatore integrato di Thunderbit) e imposta avvisi se il crawler fallisce o non raccoglie dati.

La regola d’oro: estrai dati in modo responsabile. Il web è una risorsa condivisa—non essere “quel bot” che rovina tutto.

Consigli Avanzati: Scala e Potenzia il Tuo Website Crawler in Python

Quando hai preso confidenza con le basi, puoi portare il tuo crawler a un livello superiore. Ecco alcune strategie avanzate:

- Gestisci JavaScript: Usa Selenium o Playwright per estrarre dati da siti che caricano contenuti dinamicamente.

- Scala il progetto: Per grandi volumi, passa a Scrapy o usa librerie asincrone (come

aiohttp) per richieste concorrenti. - Usa proxy: Ruota gli indirizzi IP per evitare blocchi durante estrazioni massive.

- Automatizza i flussi dati: Scrivi direttamente su database o integra con storage cloud per dataset voluminosi.

- Monitora e ricevi alert: Imposta logging, controlli di salute e notifiche per crawler che lavorano a lungo.

Se il tuo crawler diventa fondamentale, valuta servizi gestiti o API per delegare le parti più pesanti. E se estrai dati da siti diversi, struttura il codice in modo modulare per aggiornare facilmente i parser.

Conclusioni & Punti Chiave

Creare un website crawler in Python è una delle skill più utili nell’era dei dati. Ecco cosa abbiamo visto:

- I website crawler automatizzano la visita e l’estrazione di dati dalle pagine web—fondamentali per automazione, ricerca e analisi competitiva.

- Python è la scelta numero uno grazie a sintassi semplice, librerie potenti e una community vastissima.

- I metodi di parsing fanno la differenza: usa regex per script rapidi, BeautifulSoup per la maggior parte dei casi, Scrapy per progetti grandi.

- Passo dopo passo, puoi passare dal download di una pagina al crawling di un intero sito e al salvataggio di dati strutturati—senza essere un esperto.

- Thunderbit va oltre: ti permette di estrarre dati con l’AI, senza codice e con esportazione immediata—perfetto per chi vuole risultati subito.

- Crawling responsabile: rispetta le regole dei siti, gestisci gli errori e metti sempre l’etica al primo posto.

- Scalabilità: puoi crescere con gli strumenti giusti—Selenium per JavaScript, Scrapy per la concorrenza, Thunderbit per l’automazione no-code.

Il modo migliore per imparare è iniziare in piccolo: scrivi uno script, prova Thunderbit e scopri quali dati puoi ottenere. Il web è la tua miniera (o il tuo buffet di dati, se hai fame come me).

Vuoi approfondire? Dai un’occhiata a queste risorse:

- per altri consigli, guide e tecniche avanzate.

Buon crawling—che i tuoi estrattori siano veloci, i dati puliti e il caffè non finisca mai.

Domande Frequenti

1. Qual è la differenza tra un website crawler e un estrattore web?

Un crawler visita e scopre sistematicamente le pagine web (come mappare un sito), mentre un estrattore raccoglie dati specifici da quelle pagine. Nella pratica, spesso si usano entrambi: il crawler trova le pagine, l’estrattore prende i dati.

2. Perché Python è così popolare per creare website crawler?

Python è facile da imparare, ha librerie potenti (Requests, BeautifulSoup, Scrapy, Selenium) e una community enorme. Quasi il 70% dei progetti di web scraping usa Python: è lo standard del settore.

3. Quando usare regex, BeautifulSoup o Scrapy per il parsing?

Regex va bene per pattern semplici e prevedibili. BeautifulSoup è la scelta migliore per la maggior parte degli script: facile e flessibile. Scrapy è ideale per crawler su larga scala o in produzione che richiedono velocità, concorrenza e funzionalità avanzate.

4. Come si confronta Thunderbit con la programmazione di un crawler in Python?

Thunderbit ti permette di estrarre dati con l’AI e senza codice: basta cliccare, selezionare i campi ed esportare. Perfetto per utenti business o lavori rapidi. Python offre più controllo e personalizzazione, ma richiede programmazione e manutenzione.

5. Quali aspetti legali o etici devo considerare quando faccio crawling?

Controlla e rispetta sempre il robots.txt, segui i termini di servizio del sito, evita di raccogliere dati sensibili o personali senza consenso e rallenta le richieste per non sovraccaricare i server. Un’estrazione responsabile mantiene il web accessibile a tutti.

Vuoi provarci? o apri il tuo editor Python preferito e inizia a esplorare. I dati ti aspettano—vai a prenderli!

Scopri di più