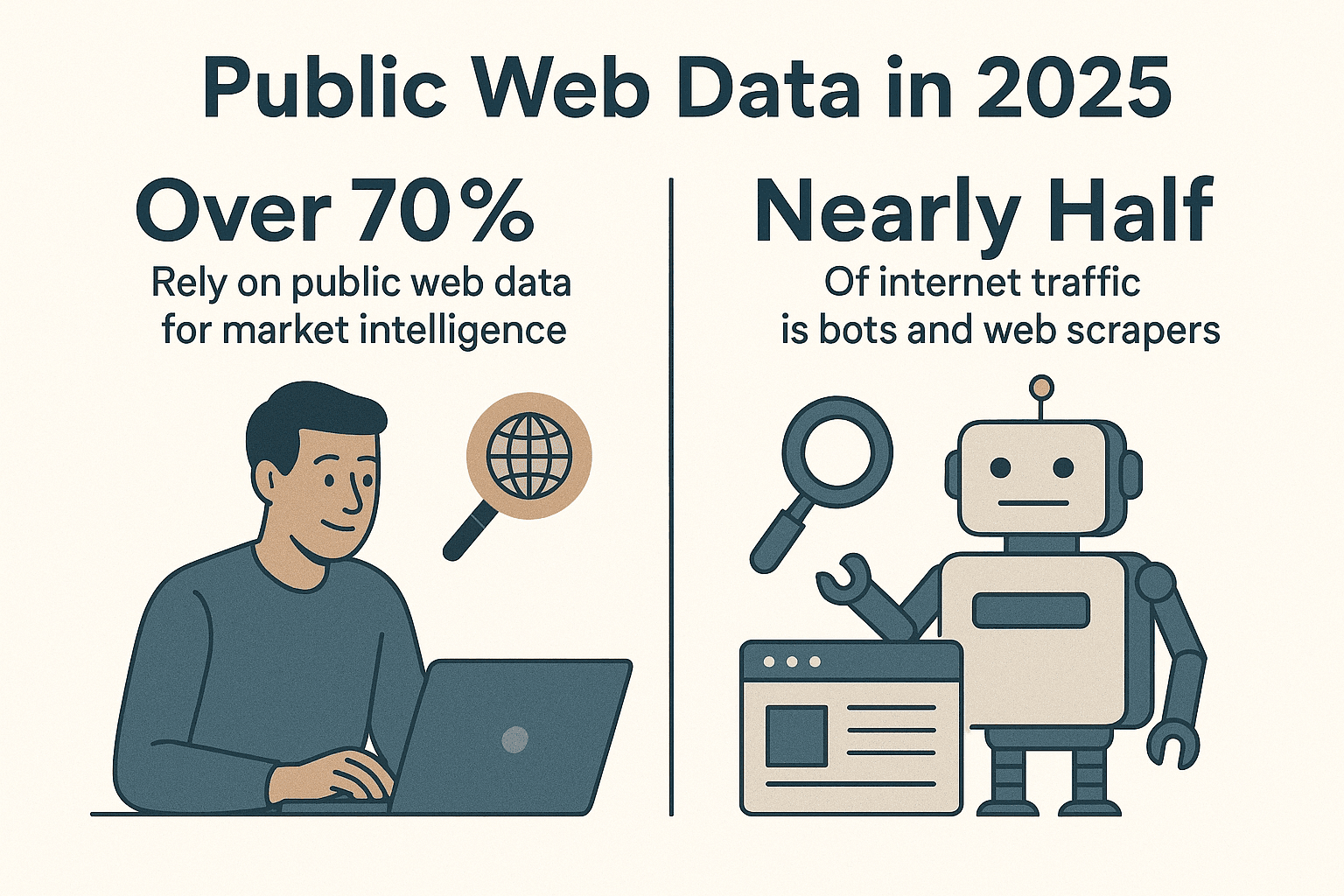

Il web è davvero una miniera d’oro di dati e ormai le aziende fanno a gara per trasformare questo caos in informazioni utili. Oggi, più del , e quasi metà del traffico online è generato da bot e Estrattori Web, non da persone (). Dopo anni passati a sviluppare strumenti di automazione (e sì, anche web spider che hanno visto più siti di me!), posso dirti una cosa: se ancora non stai usando un web spider Python per automatizzare la raccolta dati, ti stai perdendo una grossa occasione per lavorare meglio e più in fretta.

Python è ormai la scelta numero uno per chi fa web scraping, e non è un caso. Che tu sia in vendite, marketing, operations o ricerca, un web spider Python ben fatto ti fa risparmiare ore di lavoro e ti apre le porte a informazioni che altrimenti sarebbero fuori portata. In questa guida ti spiego come costruire da zero un web spider Python efficiente, ti consiglio le librerie e le pratiche migliori, e ti mostro come strumenti come possono rivoluzionare il tuo modo di lavorare—soprattutto quando ti imbatti in quei siti dinamici che fanno impazzire anche i programmatori più esperti.

Python è ormai la scelta numero uno per chi fa web scraping, e non è un caso. Che tu sia in vendite, marketing, operations o ricerca, un web spider Python ben fatto ti fa risparmiare ore di lavoro e ti apre le porte a informazioni che altrimenti sarebbero fuori portata. In questa guida ti spiego come costruire da zero un web spider Python efficiente, ti consiglio le librerie e le pratiche migliori, e ti mostro come strumenti come possono rivoluzionare il tuo modo di lavorare—soprattutto quando ti imbatti in quei siti dinamici che fanno impazzire anche i programmatori più esperti.

Perché Scegliere Python per Creare un Web Spider?

Diciamolo subito: Python è il re del web scraping. Secondo le ultime statistiche, quasi , lasciando indietro JavaScript e altri linguaggi. Nel 2024, Python ha addirittura superato JavaScript come linguaggio più popolare su GitHub (), grazie soprattutto al suo ruolo centrale nella data science e nell’automazione.

Cosa rende Python così perfetto per i web spider?

- Semplicità e chiarezza: La sintassi di Python è pulita e facile da capire, ideale sia per chi inizia sia per chi vuole andare veloce.

- Ecosistema di librerie enorme: Librerie come , , , e coprono tutto: dal download delle pagine all’analisi dell’HTML, fino all’automazione del browser.

- Comunità super attiva: Se hai un problema, trovi sempre qualcuno che ti aiuta, oltre a tutorial e snippet per ogni esigenza.

- Flessibilità: Puoi partire da uno script semplice e arrivare a web spider che scandagliano migliaia di pagine.

Rispetto ad altri linguaggi, Python ti dà il giusto mix tra potenza e facilità d’uso. JavaScript (Node.js) è ottimo per i contenuti dinamici, ma la programmazione asincrona può essere un ostacolo per chi inizia. Java e C# sono solidi ma più pesanti. Python ti lascia concentrarti sui dati, senza complicarti la vita.

Come Preparare l’Ambiente per il Tuo Web Spider Python

Prima di iniziare a “tessere la tua ragnatela”, serve un ambiente ben preparato. Ecco come faccio io ogni volta che parto con un nuovo progetto:

1. Installa Python 3

Scarica l’ultima versione di Python 3.x da o usa il gestore pacchetti del tuo sistema operativo. Assicurati che python o python3 sia accessibile dal terminale.

2. Crea un Ambiente Virtuale

Isola le dipendenze del progetto con un ambiente virtuale:

1python3 -m venv .venv

2# Su Unix/Mac

3source .venv/bin/activate

4# Su Windows

5.venv\Scripts\activateCosì tieni i pacchetti in ordine ed eviti casini tra progetti diversi.

3. Installa le Librerie Essenziali

Con l’ambiente virtuale attivo, installa le librerie principali:

1pip install requests beautifulsoup4 lxml scrapy selenium pandas sqlalchemyA cosa servono:

- Requests: Scarica le pagine web tramite HTTP.

- BeautifulSoup: Analizza e naviga l’HTML.

- lxml: Parsing HTML/XML veloce (usato da BeautifulSoup per le performance).

- Scrapy: Framework completo per crawling su larga scala.

- Selenium: Automatizza il browser per siti dinamici e pieni di JavaScript.

- pandas: Pulizia e manipolazione dei dati.

- SQLAlchemy: Salva i dati nei database.

Ora sei pronto a creare qualsiasi cosa: dallo script veloce a una vera “squadra” di web spider.

Scegliere la Libreria Python Giusta per il Tuo Web Spider

Python offre una scelta vastissima di strumenti per il web scraping. Ecco come decido cosa usare:

| Libreria/Strumento | Facilità d’uso | Velocità & Scala | Ideale per |

|---|---|---|---|

| Requests + BeautifulSoup | Facilissimo | Media (una pagina alla volta) | Principianti, pagine statiche, lavori rapidi |

| Scrapy | Curva di apprendimento più ripida | Molto veloce (async, concorrente) | Crawling su larga scala, scraping di interi siti |

| Selenium/Playwright | Media | Più lento (overhead browser) | Siti ricchi di JS, pagine dietro login |

| aiohttp + asyncio | Media (async) | Molto veloce (tanti URL insieme) | Scraping statico ad alto volume |

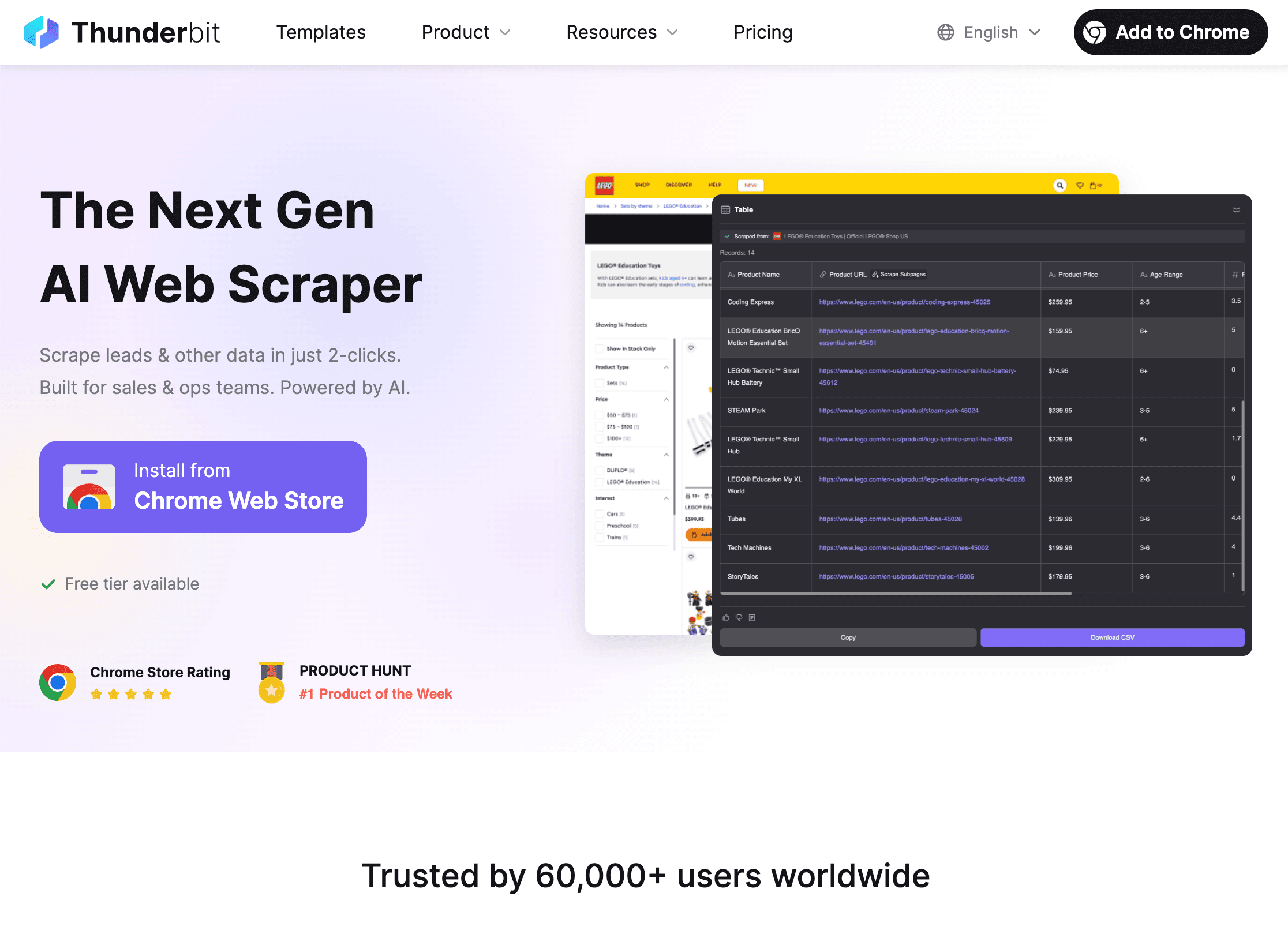

| Thunderbit (No-Code) | Facilissimo (AI) | Veloce (cloud/local) | Non programmatori, siti dinamici, risultati immediati |

La mia regola pratica:

- Per poche pagine statiche, Requests + BeautifulSoup è perfetto.

- Per centinaia o migliaia di pagine, o se vuoi funzioni di crawling integrate, Scrapy è la scelta giusta.

- Se serve un browser vero (infinite scroll, login), Selenium o Playwright.

- Se vuoi i dati subito e senza scrivere codice, è la soluzione ideale.

Creare un Web Spider Python di Base: Passo Passo

Vediamo come costruire un web spider semplice per estrarre i titoli delle notizie da Hacker News. È il mio “hello world” del web scraping.

1. Scarica la Pagina Web

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content2. Analizza l’HTML

1soup = BeautifulSoup(html_content, "html.parser")3. Estrai i Dati

1articles = soup.find_all("tr", class_="athing")

2for article in articles:

3 title_elem = article.find("span", class_="titleline")

4 title = title_elem.get_text()

5 link = title_elem.find("a")["href"]

6 print(title, "->", link)4. Gestisci la Paginazione

Hacker News ha un link “More” in fondo. Ecco come seguirlo:

1import time

2page_url = url

3while page_url:

4 resp = requests.get(page_url)

5 soup = BeautifulSoup(resp.text, 'html.parser')

6 # (estrai gli articoli come sopra)

7 next_link = soup.find("a", class_="morelink")

8 if next_link:

9 page_url = requests.compat.urljoin(resp.url, next_link["href"])

10 time.sleep(1) # Rispetta il server!

11 else:

12 page_url = None5. Gestione Errori e Buone Maniere

- Controlla sempre

response.status_code. - Usa

time.sleep()per non stressare il server. - Imposta un User-Agent personalizzato:

1headers = {"User-Agent": "MyWebSpider/0.1 (+your_email@example.com)"}

2requests.get(url, headers=headers)Questo web spider di base si adatta facilmente a quasi tutti i siti statici. Per progetti più complessi, vediamo come potenziare tutto con Scrapy.

Potenziare il Tuo Web Spider con Scrapy

Quando le esigenze di scraping superano i semplici script, Scrapy è il passo successivo. Ecco come iniziare:

1. Avvia un Progetto Scrapy

1scrapy startproject myspider2. Crea uno Spider

Dentro myspider/spiders/quotes_spider.py:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["http://quotes.toscrape.com/"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get(),

10 'tags': quote.css("div.tags a.tag::text").getall()

11 }

12 next_page = response.css("li.next a::attr(href)").get()

13 if next_page:

14 yield response.follow(next_page, callback=self.parse)3. Avvia lo Spider

1scrapy crawl quotes -o quotes.jsonScrapy si occupa di tutto: crawling, concorrenza, gestione dei link e salvataggio dei dati in JSON (o CSV, XML, ecc.)—con pochissimo codice.

Perché adoro Scrapy:

- Supporto integrato per concorrenza, limiti di velocità e crawling rispettoso

- Gestione automatica di robots.txt

- Esportazione dati e pipeline per pulizia o salvataggio

- Scala da poche pagine a milioni

Come Thunderbit Estende le Capacità dei Web Spider Python

Arriviamo all’elefante nella stanza: i siti dinamici. Per quanto Python sia potente, alcuni siti sono davvero tosti—JavaScript ovunque, sistemi anti-bot, layout che cambiano di continuo. Qui entra in gioco .

Cosa Rende Thunderbit Unico?

- AI Suggerisci Campi: Apri la , clicca su “AI Suggerisci Campi” e l’AI di Thunderbit ti propone subito quali dati estrarre—senza dover ispezionare l’HTML o scrivere selettori.

- Estrazione da Sottopagine: Thunderbit segue i link verso pagine di dettaglio (come prodotti o profili) e unisce quei dati alla tua tabella principale.

- Gestione di Contenuti Dinamici: Thunderbit lavora in un browser vero, quindi può estrarre dati anche da siti pieni di JavaScript, infinite scroll e compilare moduli con AI Autofill.

- No-Code, Linguaggio Naturale: Basta descrivere cosa vuoi (“Estrai tutti i titoli di lavoro e le località da questa pagina”) e Thunderbit fa il resto.

- Esportazione Dati Immediata: Esporta i dati in CSV, Excel, Google Sheets, Airtable o Notion—gratis e senza limiti.

- Estrazione Programmata: Imposta lavori ricorrenti (“ogni giorno alle 9”) e Thunderbit ti consegna dati aggiornati in automatico.

Come Thunderbit Si Integra con Python

Ecco il mio flusso di lavoro preferito:

- Usa Thunderbit per estrarre dati da siti dinamici o complessi—soprattutto quando serve rapidità o non vuoi gestire codice fragile.

- Esporta i dati in CSV o Excel.

- Caricali in Python con pandas per pulizia, analisi o automazione avanzata.

Così hai il meglio di entrambi: Thunderbit si occupa dell’estrazione, Python dell’analisi e automazione.

Quando Usare Thunderbit o un Web Spider Python

- Thunderbit: Perfetto per chi non programma, siti dinamici, lavori veloci o per dare autonomia agli utenti business.

- Python: Ideale per logiche personalizzate, crawling su larga scala o integrazioni profonde con altri sistemi.

- Entrambi: Usa Thunderbit per l’estrazione, Python per analisi e automazione. Io lo chiamo il metodo “pane e marmellata”—buoni da soli, imbattibili insieme.

Per approfondire i flussi di lavoro ibridi, leggi .

Legalità e Regole: Come Rispettare i Siti Web

Il web scraping è potente, ma va usato con responsabilità (e, a volte, con attenzione alle email dei sysadmin!). Ecco come restare dalla parte giusta della legge e dell’etica:

1. Rispetta robots.txt

La maggior parte dei siti pubblica un file robots.txt che indica cosa può essere scansionato. Puoi controllarlo in Python:

1import urllib.robotparser

2rp = urllib.robotparser.RobotFileParser()

3rp.set_url("http://www.example.com/robots.txt")

4rp.read()

5if not rp.can_fetch("*", "http://www.example.com/target-page"):

6 print("Scraping non consentito da robots.txt")Scrapy rispetta robots.txt di default (ROBOTSTXT_OBEY=True).

2. Sii Cortese

- Usa ritardi (

time.sleep()oDOWNLOAD_DELAYdi Scrapy) per non sovraccaricare i server. - Imposta un User-Agent descrittivo con i tuoi contatti.

- Non estrarre dati personali o protetti.

- Se un sito ti blocca o ti chiede di fermarti, rispetta la richiesta.

3. Gestisci Limiti e CAPTCHAs

- Se ricevi errori 429 (“Troppe richieste”), rallenta o usa proxy rotanti.

- Non tentare di aggirare i CAPTCHA—se li incontri, è il momento di fermarsi.

Per approfondire etica e conformità, leggi .

Organizzare e Salvare i Dati con Python

Dopo aver raccolto i dati, è il momento di pulirli, trasformarli e salvarli per l’analisi. Ecco come faccio:

1. Pulizia e Trasformazione con pandas

1import pandas as pd

2df = pd.DataFrame(scraped_data)

3df['price'] = df['price'].str.replace('£', '').astype(float)

4df = df.dropna()2. Esporta in CSV o Excel

1df.to_csv('output.csv', index=False)

2df.to_excel('output.xlsx', index=False)3. Salva in un Database con SQLAlchemy

1from sqlalchemy import create_engine

2engine = create_engine('sqlite:///scraped_data.db')

3df.to_sql(name='products', con=engine, if_exists='replace', index=False)Così puoi costruire una pipeline completa: dal web spider al dashboard.

Automatizzare le Pipeline Dati

Per lavori ricorrenti, automatizza tutto:

- Cron job: Pianifica gli script Python per esecuzioni giornaliere, orarie, ecc.

- Apache Airflow: Per flussi complessi, Airflow può orchestrare scraping, pulizia e reportistica.

- Thunderbit Scheduling: Lascia che Thunderbit gestisca l’estrazione programmata, poi lancia il tuo script Python per elaborare i nuovi dati.

Per saperne di più, leggi .

Risoluzione Problemi e Ottimizzazione del Web Spider Python

Anche i migliori web spider incontrano ostacoli. Ecco la mia checklist per i problemi più comuni:

- Richieste bloccate (403/429): Cambia User-Agent, rallenta o usa proxy. Controlla robots.txt.

- Dati mancanti: Ricontrolla i selettori. L’HTML potrebbe essere cambiato.

- Contenuti dinamici: Prova Selenium o Thunderbit per siti pieni di JS.

- Performance: Usa async (aiohttp) o la concorrenza di Scrapy per velocità. Scrivi i dati man mano per evitare problemi di memoria.

- Debug: Stampa i log, usa gli strumenti per sviluppatori del browser e controlla sempre i risultati.

Per altri consigli, leggi .

Conclusioni & Punti Chiave

Costruire un web spider Python efficiente è un percorso che ripaga in termini di tempo risparmiato e qualità dei dati. Ecco cosa abbiamo visto:

- Python è la scelta migliore per i web spider, grazie a semplicità, librerie e community.

- Prepara l’ambiente con virtualenv e le librerie giuste (Requests, BeautifulSoup, Scrapy, Selenium, pandas, SQLAlchemy).

- Scegli lo strumento adatto: script semplici per lavori piccoli, Scrapy per la scala, Selenium per siti dinamici, Thunderbit per scraping AI/no-code.

- Scrivi web spider puliti e rispettosi delle regole dei siti.

- Salva e processa i dati con pandas e SQLAlchemy, automatizza la pipeline per lavori ricorrenti.

- Combina Python e Thunderbit per la massima flessibilità: lascia all’AI l’estrazione, usa Python per analisi e automazione.

Vuoi portare il tuo scraping al livello successivo? e scopri quanto è semplice estrarre dati anche dai siti più complessi. E se vuoi approfondire, visita il per guide, consigli e casi reali.

Buon scraping—che i tuoi web spider ti portino sempre i dati che cerchi (e non restino mai impigliati in una rete di CAPTCHA).

Domande Frequenti

1. Perché Python è il linguaggio migliore per creare web spider?

La sintassi semplice, l’enorme ecosistema di librerie (Requests, BeautifulSoup, Scrapy) e la community attiva rendono Python ideale per sviluppare, scalare e mantenere web spider. È accessibile ai principianti ma abbastanza potente per progetti professionali su larga scala.

2. Quando conviene usare Thunderbit invece di programmare un web spider Python?

Thunderbit è perfetto per chi non programma, per siti dinamici o pieni di JavaScript, o quando serve ottenere dati rapidamente senza scrivere o mantenere codice. Per progetti molto personalizzati, su larga scala o con integrazioni profonde, Python resta la scelta migliore. Molti team usano entrambi: Thunderbit per l’estrazione, Python per l’analisi.

3. Come posso essere sicuro che il mio web spider sia legale ed etico?

Controlla e rispetta sempre il robots.txt del sito, usa crawling responsabile (ritardi, user-agent) e non estrarre dati personali o protetti. Se un sito ti chiede di fermarti, fallo. Per approfondire, leggi .

4. Qual è il modo migliore per salvare e gestire i dati estratti?

Usa pandas per pulire e trasformare i dati, esporta in CSV/Excel per la condivisione e SQLAlchemy per salvare su database (come SQLite o PostgreSQL) se hai dataset grandi o ricorrenti.

5. Come posso automatizzare la pipeline di web scraping?

Usa cron job o Apache Airflow per pianificare gli script Python. Thunderbit supporta anche l’estrazione programmata, che puoi combinare con Python per una pipeline dati completamente automatizzata.

Vuoi altri consigli pratici? Dai un’occhiata a e iscriviti al per tutorial e approfondimenti.