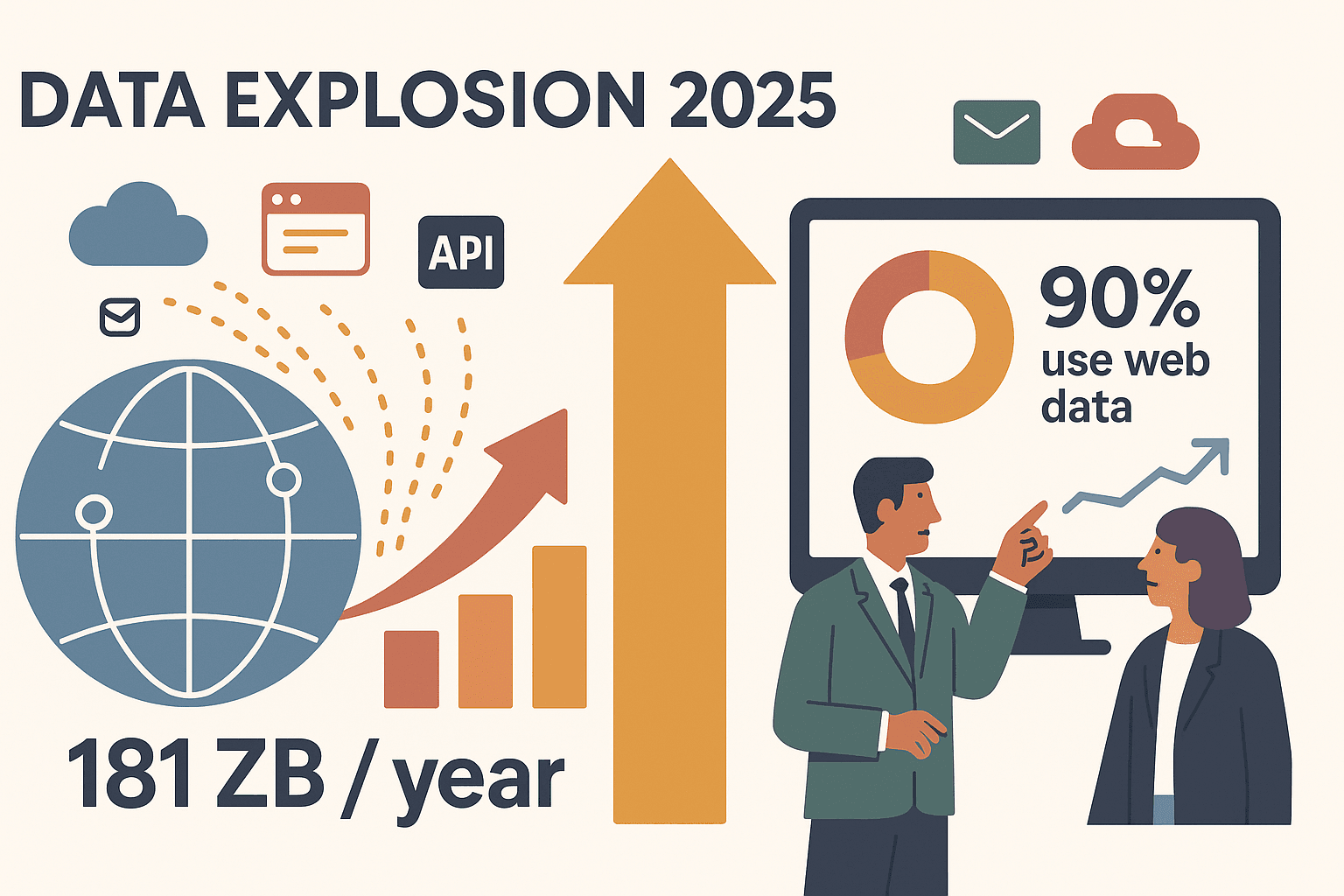

Nel 2025 il web è davvero una miniera d’oro di dati, ma diciamocelo: è anche un vero labirinto. Ogni giorno le aziende si sfidano per trasformare questo caos in informazioni utili, nuovi contatti e fatturato. L’ho visto succedere: team che prima perdevano ore (o addirittura giorni) a copiare e incollare, ora automatizzano tutto, dal monitoraggio dei prezzi alla generazione di lead, grazie alle soluzioni di scraping di nuova generazione. E i numeri parlano chiaro: entro il 2025, la produzione globale di dati supererà i , e quasi il farà affidamento su dati web esterni per guidare la propria strategia.

Ma come si fa a scegliere lo strumento giusto per la tua azienda, che tu sia un founder, un commerciale o una grande impresa con ambizioni da big data? Ho raccolto le 15 migliori soluzioni di web scraping per il 2025, includendo sia strumenti no-code con AI (come ), sia framework per sviluppatori e piattaforme enterprise. Che tu voglia la massima semplicità o una personalizzazione avanzata, questa guida ti aiuterà a trovare la soluzione perfetta.

Perché le aziende hanno bisogno di soluzioni di scraping nel 2025

Andiamo al sodo: il web scraping non è più roba da smanettoni IT. Oggi è fondamentale per qualsiasi azienda che voglia restare competitiva. Ecco perché:

- Ricerche di mercato più veloci: Basta stagisti bloccati a copiare e incollare: le aziende usano gli estrattori per raccogliere info su prodotti, recensioni o notizie in pochi minuti. Le agenzie immobiliari, ad esempio, estraggono annunci e trend di prezzo per guidare gli investimenti ().

- Lead generation e sales intelligence: I team commerciali creano liste di potenziali clienti aggiornate estraendo dati da directory o LinkedIn, risparmiando ore e ottenendo dati più freschi.

- Monitoraggio prezzi e analisi della concorrenza: I team e-commerce tengono d’occhio ogni giorno prezzi e disponibilità dei concorrenti. Con il , restare aggiornati è vitale.

- Automazione dei flussi di lavoro: I team operativi programmano estrattori per report settimanali o per aggiornare dashboard, liberando il per attività più strategiche.

In breve? Le soluzioni di scraping trasformano attività manuali e ripetitive in processi automatici e affidabili, così il tuo team può concentrarsi sull’analisi invece che sulla raccolta dati.

Come abbiamo selezionato le migliori soluzioni di scraping

Con così tante opzioni in giro, mi sono focalizzato su ciò che davvero conta per le aziende nel 2025:

- Facilità d’uso: Un non programmatore può partire subito? Editor visuali, interfacce point-and-click o prompt in linguaggio naturale sono un grande plus.

- Personalizzazione: Quanto controllo hai su progetti complessi? Ci sono scripting, AI o marketplace di soluzioni già pronte?

- Prestazioni e scalabilità: Lo strumento regge siti dinamici, grandi volumi e attività pianificate? È affidabile anche su larga scala?

- Compatibilità con i siti web: Funziona sia su pagine statiche che su siti con scroll infinito o login?

- Prezzo: C’è una versione gratuita? I costi sono sostenibili sia per piccoli team che per grandi aziende?

Questa lista copre tutto: dalle estensioni browser no-code alle piattaforme enterprise e ai framework per sviluppatori. Scopriamole insieme.

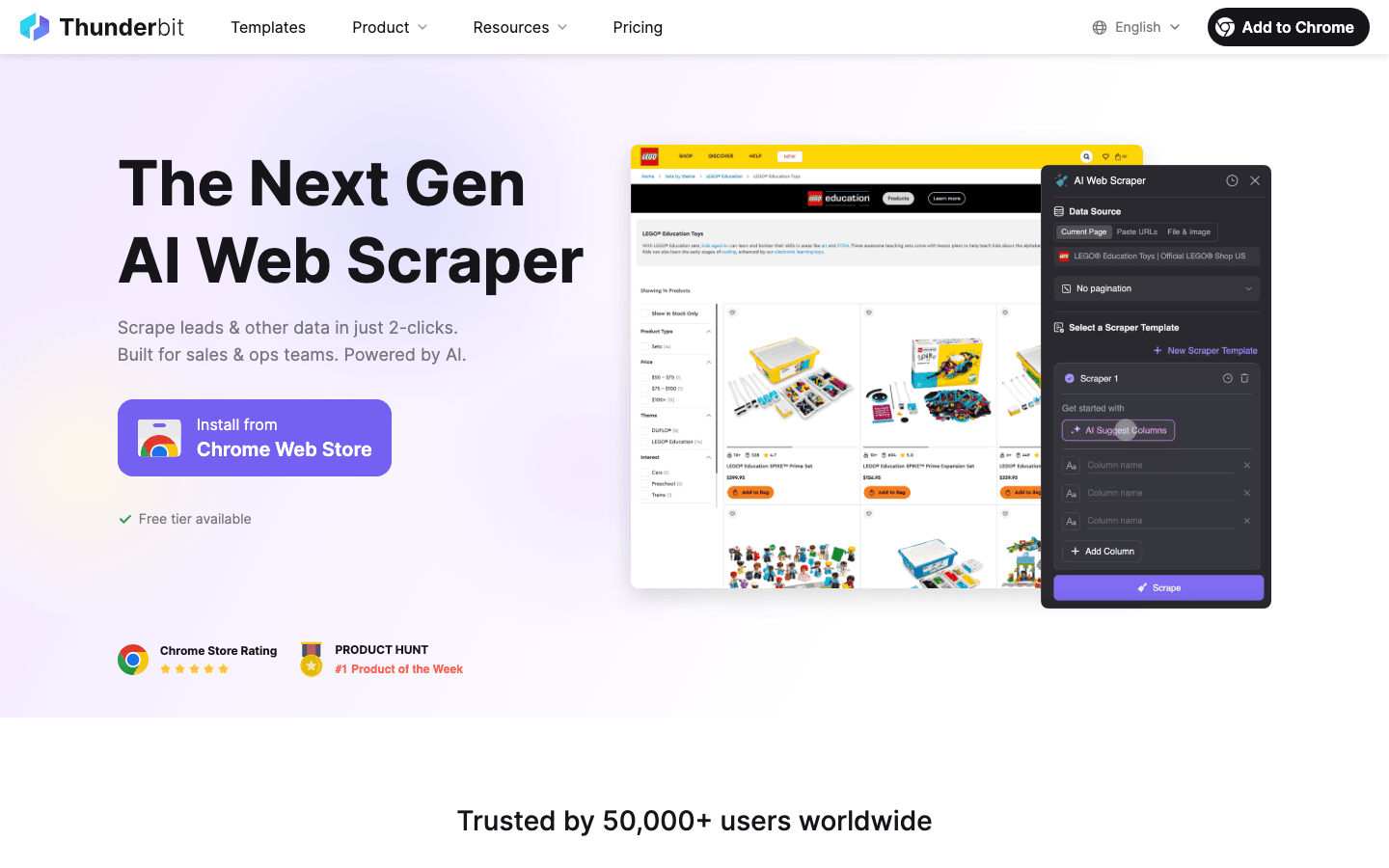

1. Thunderbit

è la mia prima scelta per chi cerca un Estrattore Web AI senza codice. Da co-fondatore sono di parte, ma ho creato Thunderbit proprio perché ero stufo di vedere team sales e marketing impazzire con strumenti complicati. Ecco cosa lo rende speciale:

- Semplicità guidata dall’AI: Basta cliccare su “AI Suggerisci Campi” e Thunderbit analizza la pagina, suggerisce le colonne e configura l’estrattore. Puoi descrivere ciò che vuoi in italiano: niente codice, niente template.

- Flusso in 2 click: Vai sulla pagina, clicca “Estrai” e il gioco è fatto. Thunderbit gestisce sottopagine, paginazione e persino immagini o PDF.

- Esportazione immediata: Invia i dati direttamente su Excel, Google Sheets, Airtable o Notion—tutto gratis.

- Estrazione da sottopagine: Vuoi più dettagli? Thunderbit può visitare ogni sottopagina (come dettagli prodotto o profili LinkedIn) e arricchire la tua tabella in automatico.

- Template preimpostati: Per siti famosi (Amazon, Zillow, Instagram, Shopify) hai template pronti per risultati immediati.

- Prezzi: Gratis fino a 6 pagine (10 con prova). I piani a pagamento partono da 15$/mese per 500 righe, con opzioni per team più grandi.

Ideale per: Team sales, marketing, e-commerce e real estate che vogliono dati rapidi e precisi senza complicazioni tecniche. Thunderbit è particolarmente apprezzato da chi non ha competenze tecniche e vuole risultati in pochi minuti.

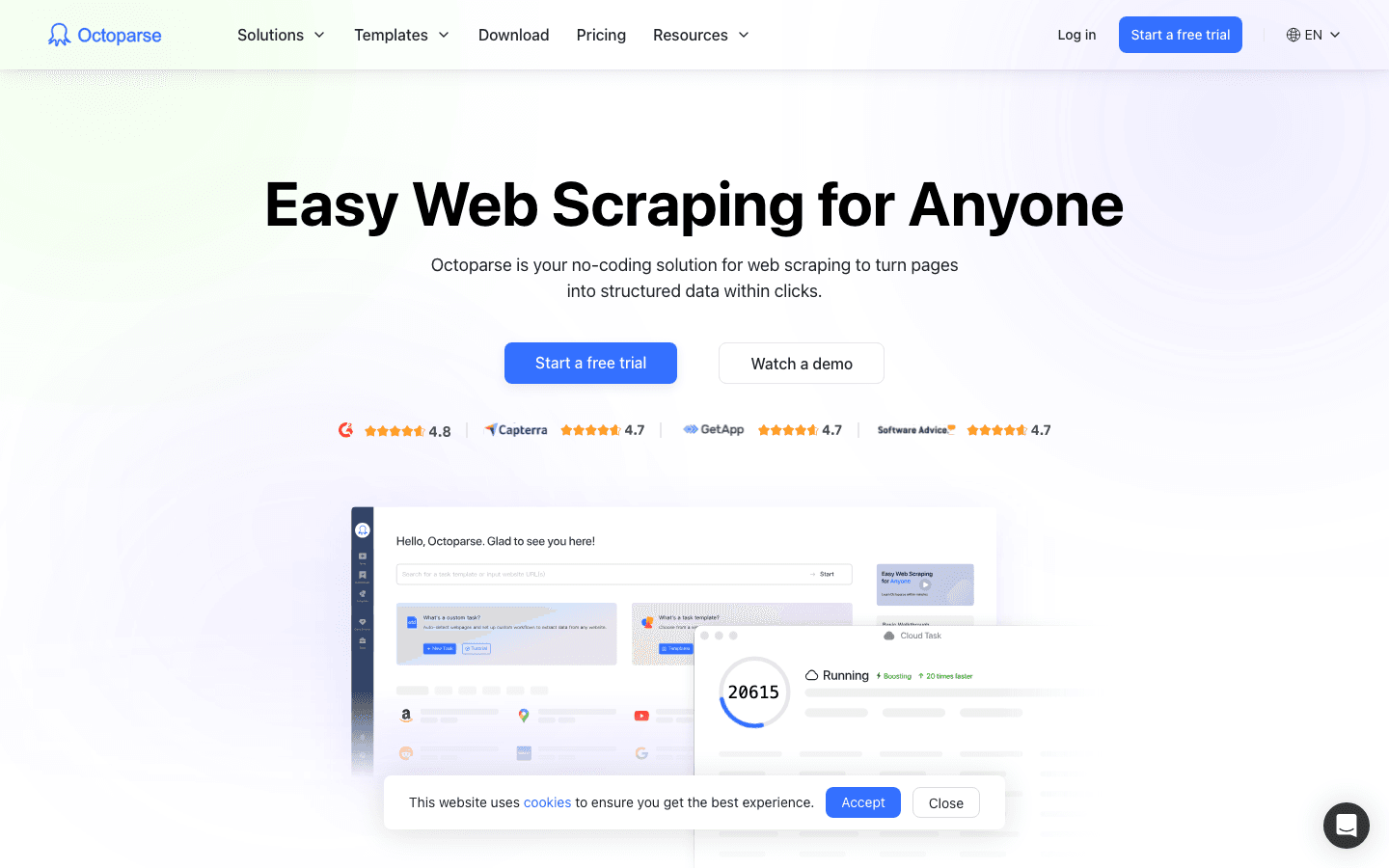

2. Octoparse

è un estrattore web visuale, no-code, con interfaccia point-and-click. È molto apprezzato da chi inizia e dalle piccole imprese grazie a:

- Rilevamento automatico intelligente: L’assistente AI di Octoparse spesso riconosce automaticamente liste, prezzi e paginazione—basta un click per estrarre.

- Cloud scraping e pianificazione: Progetta le attività su Windows, poi esegui tutto nel cloud (senza lasciare il PC acceso). Pianifica estrazioni ricorrenti giornaliere o settimanali.

- Template per siti famosi: Template pronti per Amazon, Google Maps, LinkedIn e altri.

- Opzioni di esportazione: Scarica in Excel, CSV, JSON o invia a database e Google Sheets.

- Prezzi: Versione gratuita fino a 10 task locali; piani a pagamento da circa 89$/mese.

Ideale per: PMI, analisti e marketer che vogliono uno strumento no-code robusto e scalabile nel cloud.

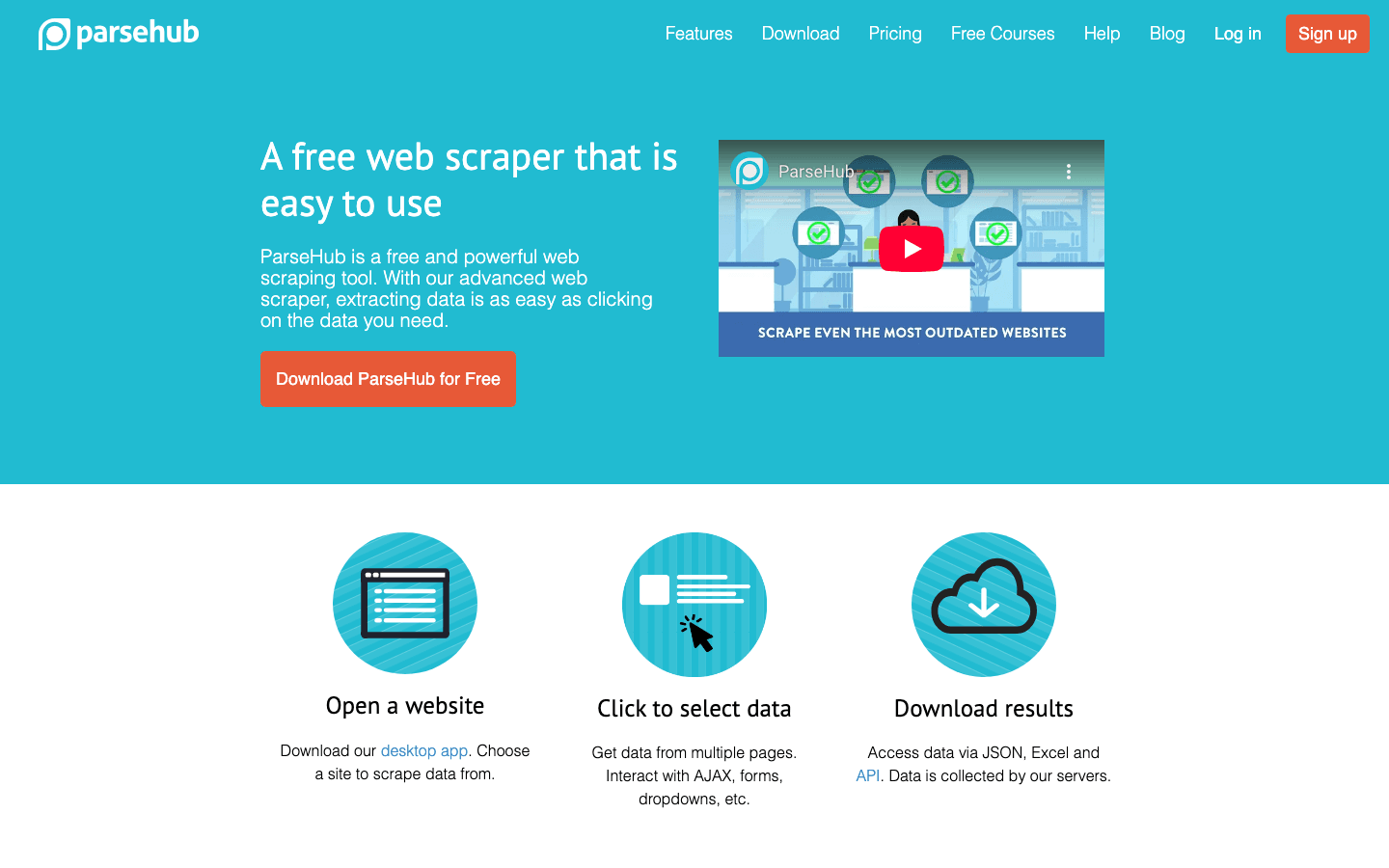

3. ParseHub

è un’app desktop multipiattaforma (Windows, Mac, Linux) che unisce semplicità visuale e potenza low-code:

- Editor visuale: Seleziona gli elementi con un click, imposta flussi di lavoro e gestisci form, menu a tendina e navigazione multi-step.

- Gestione siti dinamici: Funziona bene con pagine ricche di JavaScript, scroll infinito e contenuti AJAX.

- Logica condizionale: Aggiungi ramificazioni e cicli per flussi complessi—senza codice, ma con logiche avanzate.

- Esecuzione cloud e API: Esegui progetti nel cloud, pianifica task e integra tramite API.

- Prezzi: Gratis per 200 pagine per run; piani a pagamento da 189$/mese.

Ideale per: Utenti business con competenze tecniche e analisti che vogliono più flessibilità rispetto agli strumenti base, soprattutto su Mac.

4. Scrapy

è il framework Python open-source di riferimento per gli sviluppatori:

- Controllo totale via codice: Crea spider personalizzati, gestisci qualsiasi sito e integra con qualsiasi workflow.

- Prestazioni elevate: Crawling asincrono per scalare su milioni di pagine.

- Ecosistema ricco: Tantissimi plugin, middleware e supporto dalla community.

- Gratis e open source: Nessun costo di licenza—solo tempo di sviluppo e infrastruttura.

Ideale per: Team di sviluppatori e aziende che necessitano di scraping su larga scala e altamente personalizzato. Se conosci Python, Scrapy è una potenza.

5. Import.io

è una piattaforma enterprise pensata per fornire dati web pronti all’uso:

- UI no-code + servizio gestito: Configurazione point-and-click, ma il team Import.io può costruire e mantenere gli estrattori per te.

- Automazione cloud: Pianifica task ricorrenti, gestisci login e processa i dati nel cloud.

- Integrazione dati: Esporta via API, webhook o direttamente nelle tue app e database.

- Trasformazione dati: Pulisci e prepara i dati con regole simili a Excel prima dell’esportazione.

- Prezzi: Su preventivo, di solito da 299$/mese.

Ideale per: Grandi aziende che vogliono estrazione dati affidabile e gestita senza sviluppare estrattori internamente.

6. Apify

è una piattaforma cloud con un marketplace unico di “actor” (estrattori preimpostati):

- Marketplace di actor: Trova estrattori già pronti per Amazon, Twitter, Google Maps e altro—basta configurare e lanciare.

- Scripting personalizzato: Crea i tuoi actor in JavaScript o Python per la massima flessibilità.

- Scalabilità cloud: Esegui più job in parallelo, usa browser headless e gestisci proxy.

- Integrazione API: Esporta dati in JSON, CSV, Google Sheets o tramite API/webhook.

- Prezzi: Piano gratuito con crediti; piani a pagamento da 39$/mese.

Ideale per: Sviluppatori e team tecnici, o chi non programma ma sfrutta gli actor del marketplace per task comuni.

7. WebHarvy

è un’app desktop Windows pensata per scraping visuale, point-and-click:

- Interfaccia intuitiva: Clicca sugli elementi per acquisire dati—WebHarvy riconosce automaticamente pattern e liste.

- Paginazione e scroll infinito: Gestisce scraping multipagina e pulsanti “carica altro”.

- Compilazione form: Estrai risultati per più termini di ricerca o URL.

- Licenza una tantum: Circa 129$ per utente (include un anno di aggiornamenti).

- Esportazione: CSV, Excel, XML o direttamente su database.

Ideale per: Piccole imprese, marketer e ricercatori che vogliono uno strumento desktop semplice e conveniente.

8. Dexi.io

è una piattaforma cloud per scraping e automazione dei flussi di lavoro, pensata per i team operativi:

- Designer visuale di robot: Crea bot di scraping tramite editor nel browser.

- Pianificazione cloud: Esegui job sui server Dexi, pianifica task ricorrenti e monitora l’avanzamento.

- Elaborazione dati: Pulisci, arricchisci e trasforma i dati in tempo reale.

- Collaborazione di team: Gestione multiutente e accessi basati sui ruoli.

- Prezzi: Personalizzati, di solito qualche centinaio di dollari al mese per le PMI.

Ideale per: Team operativi e di analisi in retail, e-commerce o marketing che necessitano di scraping scalabile e automatizzato.

9. Data Miner

è un’estensione Chrome/Edge per scraping rapido tramite template:

- Oltre 60.000 ricette pronte: Estrazione con un click per Google, LinkedIn, Amazon e altri.

- Ricette personalizzate: Crea le tue selezionando gli elementi—senza codice.

- Basato su browser: Estrai ciò che vedi, anche dietro login.

- Esportazione: CSV, Excel, Google Sheets.

- Prezzi: Gratis per 500 pagine/mese; piani da 19$/mese.

Ideale per: Professionisti che hanno bisogno di dati rapidi e occasionali—come commerciali o marketer che estraggono liste di lead.

10. Mozenda

è una piattaforma cloud di scraping di livello enterprise:

- Visual Agent Builder: App Windows per configurazione point-and-click.

- Esecuzione cloud: Esegui agenti nel cloud, pianifica job e gestisci i dati centralmente.

- Collaborazione di team: Gestione multiutente e permessi basati sui ruoli.

- Supporto avanzato: Formazione, onboarding e assistenza live per clienti enterprise.

- Prezzi: Da circa 99$/mese; prezzi enterprise su richiesta.

Ideale per: Aziende e organizzazioni che necessitano di estrazione dati scalabile e ripetibile con supporto dedicato.

11. OutWit Hub

è un’app desktop (Windows, Mac, Linux) per scraping visuale, adatta anche a chi non programma:

- Riconoscimento automatico dei dati: Estrazione con un click di link, immagini, email e altro.

- Selezione point-and-click: Evidenzia pattern per estrazione strutturata.

- Supporto a più tipi di dati: Estrai testo, immagini, file e altro.

- Prezzi: Versione gratuita con limiti; Premium circa 75€ una tantum.

Ideale per: Giornalisti, ricercatori o piccole imprese che vogliono uno strumento desktop semplice per vari tipi di scraping.

12. Visual Web Ripper

è un estrattore desktop avanzato per utenti esperti su Windows:

- Designer visuale di progetti: Crea template per siti complessi, inclusa paginazione e sottopagine.

- Pianificazione e automazione: Esegui progetti a orari prestabiliti, automatizza l’esportazione su database.

- Trasformazione dati: Pulisci e processa i dati durante l’estrazione.

- Licenza una tantum: Circa 349$ per utente.

Ideale per: Professionisti dei dati e PMI che vogliono scraping potente su Windows senza costi ricorrenti.

13. Content Grabber

è un estrattore desktop/web enterprise per professionisti dei dati e agenzie:

- Studio avanzato: Design visuale più scripting C# per logiche personalizzate.

- Automazione e pianificazione: Gestisci centinaia di agenti, esegui in parallelo e integra con altri sistemi.

- Integrazione: Esporta su database, API o crea estrattori stand-alone per i clienti.

- Prezzi: Licenze Professional/Enterprise nell’ordine delle migliaia di dollari (nessuna versione gratuita).

Ideale per: Agenzie, grandi aziende o SaaS dove il web scraping è mission-critical.

14. 80legs

è un servizio cloud di crawling web pensato per il big data:

- Scalabilità enorme: Scansiona fino a 10 milioni+ di pagine per job.

- Estrazione personalizzata: Definisci cosa estrarre tramite pattern o regex.

- Accesso API: Configura e gestisci i crawl in modo programmato.

- Prezzi: Gratis fino a 10k URL per crawl; piani da 29$/mese.

Ideale per: Data scientist, ingegneri o aziende che devono scansionare grandi porzioni del web per analisi o ricerca.

15. Diffbot

è una piattaforma di estrazione dati basata su AI che trasforma contenuti web non strutturati in dati strutturati:

- Interpretazione automatica delle pagine: Inserisci un URL, ottieni JSON strutturato (articoli, prodotti, discussioni, ecc.)—senza configurazione manuale.

- API per ogni tipo di contenuto: Article API, Product API, Knowledge Graph e altro.

- Crawlbot: Scansiona interi siti e invia i risultati all’AI di Diffbot.

- Prezzi: Piani da circa 299$/mese; prezzi a consumo per grandi volumi.

Ideale per: Aziende e sviluppatori che vogliono dati strutturati e di alta qualità da fonti diverse senza scrivere estrattori.

Tabella comparativa delle soluzioni di scraping

Ecco una panoramica per confrontare rapidamente le opzioni:

| Strumento | Caratteristiche principali | Facilità d’uso | Personalizzazione | Prestazioni & Scala | Compatibilità | Prezzo | Ideale per |

|---|---|---|---|---|---|---|---|

| Thunderbit | AI, 2 click, sottopagine, template | Molto facile | Media | Buona (cloud/local) | Qualsiasi sito browser | Gratis/15$+/mese | Sales, marketing, non tecnici |

| Octoparse | Visuale, cloud, template | Facile | Media | Alta (cloud) | Siti dinamici, AJAX | Gratis/89$+/mese | PMI, analisti, principianti |

| ParseHub | Visuale, low-code, API | Media | Alta | Alta (cloud) | JS complessi, avanzati | Gratis/189$+/mese | Utenti esperti, Mac |

| Scrapy | Python, codice, scalabile | Difficile (dev) | Molto alta | Eccellente | Qualsiasi sito (codice) | Gratis | Sviluppatori, big data |

| Import.io | Gestito, cloud, API, trasformazioni | Media | Media | Alta (enterprise) | Complessi, login | 299$+/mese | Enterprise, servizio gestito |

| Apify | Marketplace, scripting, cloud | Facile/Media | Molto alta | Alta (cloud) | Qualsiasi (JS, headless) | Gratis/39$+/mese | Dev, utenti avanzati |

| WebHarvy | Desktop, point-and-click | Molto facile | Bassa/Media | Media | Statici/dinamici | 129$ una tantum | PMI, marketer, Windows |

| Dexi.io | Cloud, visuale, automazione, team | Media | Alta | Enterprise | Quasi tutti, login | Personalizzato/200$+ | Operazioni, retail, e-commerce |

| Data Miner | Estensione browser, template, esportazione | Molto facile | Bassa | Media | Siti browser | Gratis/19$+/mese | Rapido, occasionale, non tecnici |

| Mozenda | Cloud, visuale, team, supporto | Facile (dopo training) | Media | Alta (cloud) | Dinamici, login | 99$+/mese | Enterprise, ricerca |

| OutWit Hub | Desktop, auto-riconoscimento, multi-dato | Facile | Bassa/Media | Media | Statici | Gratis/75€ una tantum | Giornalisti, ricercatori |

| Visual Web Ripper | Desktop, visuale avanzato, pianificazione | Media | Alta | Alta (locale) | Complessi, form | 349$ una tantum | Data pro, PMI, Windows |

| Content Grabber | Desktop/web, scripting, SDK | Difficile (dev/IT) | Molto alta | Molto alta | Qualsiasi (codice) | $$$ (enterprise) | Agenzie, SaaS, enterprise |

| 80legs | Cloud, scala massiva, API | Media (tecnica) | Media | Eccellente | Web su larga scala | Gratis/29$+/mese | Big data, ricerca, crawling |

| Diffbot | AI, API, Knowledge Graph | Facile (per dev) | Bassa (utente) | Alta (cloud) | Qualsiasi, JS, AI | 299$+/mese | Enterprise, AI, dati strutturati |

Come scegliere la soluzione di scraping giusta per la tua azienda

Ecco una guida rapida per orientarti nella scelta:

-

Competenze tecniche:

- Zero codice? Scegli Thunderbit, Octoparse, WebHarvy, Data Miner o Mozenda.

- Un po’ di codice? ParseHub, Apify o Visual Web Ripper.

- Team di sviluppatori? Scrapy, Content Grabber o 80legs.

-

Volume e frequenza dei dati:

- Task occasionali/piccoli: Data Miner, WebHarvy, OutWit Hub.

- Task regolari/medi: Thunderbit, Octoparse, Dexi.io, Mozenda.

- Grande scala: Scrapy, Apify, 80legs, Diffbot.

-

Complessità del sito:

- Statici/semplici: Qualsiasi strumento.

- Dinamici/JS complessi: Octoparse, ParseHub, Apify, Diffbot, Content Grabber.

-

Integrazione:

- Esportazione su Excel/Sheets? Thunderbit, Octoparse, Data Miner.

- Integrazione API/database? Import.io, Apify, Dexi.io, Content Grabber.

-

Budget:

- Gratis/economico: Thunderbit (free tier), Data Miner, Scrapy, WebHarvy (una tantum).

- Enterprise: Import.io, Mozenda, Dexi.io, Diffbot, Content Grabber.

-

Supporto e manutenzione:

- Preferisci un servizio gestito? Import.io, Mozenda, Dexi.io.

- Fai-da-te con supporto community? Scrapy, Apify.

Prova sempre la versione gratuita o la demo: solo così capirai quale strumento si adatta meglio ai tuoi flussi e alle tue esigenze.

Casi di successo reali e sfide comuni

Monitoraggio prezzi e-commerce:

Un retailer di medie dimensioni ha usato Dexi.io per monitorare i prezzi di 500 prodotti al giorno. Automazione e pianificazione hanno fatto risparmiare 4 ore al giorno e portato a un .

Lead generation commerciale:

Un team B2B ha usato Thunderbit per estrarre dati da directory di settore, riducendo due giorni di lavoro manuale a 10 minuti. In un trimestre hanno raccolto 5.000 lead, alimentando il pipeline ().

Giornalismo e ricerca:

Un giornalista ha usato l’Article API di Diffbot per estrarre 1.200 articoli in una settimana, automatizzando un lavoro che avrebbe richiesto un mese ().

Sfide comuni:

- Anti-bot: Usa strumenti con rotazione proxy (Dexi, Apify) o scraping via browser (Thunderbit) per evitare blocchi.

- Pulizia dati: Usa prompt per i campi (Thunderbit) o trasformazioni integrate (Import.io, Mozenda) per ridurre dati sporchi.

- Cambi layout sito: Scegli strumenti con AI o auto-adattamento (Diffbot, Thunderbit) per gestire cambi di layout.

Conclusione: trova la soluzione di scraping ideale

I dati web sono la chiave per decisioni più intelligenti nel 2025. Che tu debba costruire un pipeline commerciale, monitorare prezzi o alimentare l’analisi, la soluzione giusta ti fa risparmiare tempo, migliora la precisione e apre nuove opportunità.

- Non tecnici: Thunderbit, Octoparse, Data Miner, WebHarvy.

- Team esperti: ParseHub, Apify, Visual Web Ripper.

- Sviluppatori/enterprise: Scrapy, Import.io, Dexi.io, Content Grabber, Diffbot, 80legs.

Quasi tutti offrono prove gratuite: sperimenta, trova ciò che si adatta meglio e non aver paura di combinare più strumenti per progetti diversi. E se vuoi vedere come l’AI sta rivoluzionando lo scraping, .

Buon scraping—che i tuoi dati siano sempre puliti, strutturati e pronti all’uso. Per altre guide pratiche e approfondimenti, visita il .

Domande frequenti

1. Qual è il principale vantaggio di una soluzione di web scraping per le aziende?

Le soluzioni di web scraping automatizzano la raccolta dati dai siti, risparmiando tempo, riducendo errori e offrendo insight in tempo reale a team sales, marketing e operations.

2. Quale soluzione di scraping è più adatta ai non tecnici?

Thunderbit, Octoparse, WebHarvy e Data Miner sono pensati per chi non programma, con interfacce visuali e setup guidato dall’AI.

3. Come gestire siti con misure anti-scraping?

Scegli strumenti con rotazione proxy integrata (Dexi.io, Apify) o scraping via browser (Thunderbit). Per grandi volumi, valuta piattaforme come 80legs o Diffbot.

4. Cosa fare se il sito target cambia layout?

Usa soluzioni con AI o auto-adattamento (Thunderbit, Diffbot), oppure preparati ad aggiornare template o script quando necessario.

5. Il web scraping è legale ed etico per le aziende?

Estrarre dati pubblici è generalmente legale, ma controlla sempre i termini d’uso e la privacy del sito. Evita dati personali o sensibili e rispetta il robots.txt dove possibile.