Nel mondo dei dati gira spesso una battuta: “Se non stai facendo scraping, probabilmente stai ancora copiando e incollando.” Ma oggi il copia-incolla non basta più. Con quasi e che si affidano a strumenti di estrazione dati dal web per le analisi, le api per il web scraping sono diventate una risorsa fondamentale per chi lavora con i dati. Che tu sia nelle vendite, nell’ecommerce o nelle operations, trasformare pagine web caotiche in dati ordinati è ormai una routine quotidiana.

Diciamolo senza giri di parole: fare scraping sul web non è sempre una passeggiata. I siti cambiano aspetto, spuntano CAPTCHAs o i dati vengono nascosti dietro a montagne di JavaScript. Qui entrano in gioco le api per il web scraping: ti permettono di raccogliere dati in modo più furbo, veloce e – diciamolo – senza stress. In questo articolo ti presento le otto migliori api per il web scraping del 2025, mettendo a confronto i punti di forza e aiutandoti a scegliere la soluzione giusta per la tua azienda—che tu sia un marketer che odia il codice o uno sviluppatore che sogna in Python.

Perché le API per il Web Scraping sono Indispensabili per la Raccolta Dati Moderna

Andiamo dritti al sodo: le api per il web scraping sono il segreto delle squadre che lavorano davvero con i dati. Automatizzano tutto il lavoro manuale di estrazione dalle pagine web, facendoti risparmiare ore (o giorni) che altrimenti butteresti via a copiare e incollare. In effetti, rispetto ai metodi tradizionali.

Ma la velocità non è tutto. Le migliori API si occupano di tutte le rogne—si adattano ai cambi di layout, eseguono JavaScript e aggirano i blocchi anti-bot—così tu non devi preoccupartene. Ti restituiscono dati puliti e ordinati (CSV, JSON o direttamente su Google Sheets), pronti per le tue analisi, CRM o dashboard di business intelligence.

Ecco dove le api per il web scraping fanno davvero la differenza per le aziende:

- Lead Generation: Raccogli contatti da centinaia di directory o profili social in una notte.

- Monitoraggio Prezzi: Tieni d’occhio prezzi e disponibilità dei concorrenti ogni giorno, senza fatica.

- Ricerche di Mercato: Aggrega recensioni, notizie o opinioni social su larga scala.

- Analisi della Concorrenza: Monitora offerte di lavoro, lanci di prodotti o aggiornamenti di contenuti—tutto in automatico.

E la cosa migliore? Molte di queste API sono pensate anche per chi non ha competenze tecniche, con interfacce no-code o prompt in linguaggio naturale. Quindi, anche se l’HTML ti fa venire il mal di testa, puoi comunque automatizzare la raccolta dati come un vero pro.

Come Abbiamo Valutato le Migliori API per il Web Scraping

Non tutte le api per il web scraping sono uguali. Alcune sono pensate per sviluppatori, altre per chi lavora in azienda. Alcune gestiscono siti complessi senza problemi, altre si arrendono al primo CAPTCHA. Ecco i cinque criteri chiave che ho usato per valutare ogni API:

- Stabilità dell’Estrazione: È affidabile anche quando i siti cambiano?

- Gestione di Siti Complessi: Sa affrontare pagine piene di JavaScript, scroll infinito o difese anti-bot come i CAPTCHA?

- Facilità d’Uso: L’interfaccia è accessibile anche a chi non programma, o serve una laurea in regex?

- Documentazione e Supporto: Ci sono guide chiare, tutorial e un supporto reattivo in caso di problemi?

- Prezzo e Convenienza: È accessibile per il tuo volume di dati, con prezzi trasparenti e una prova gratuita?

Detto questo, ecco le otto migliori api per il web scraping del 2025.

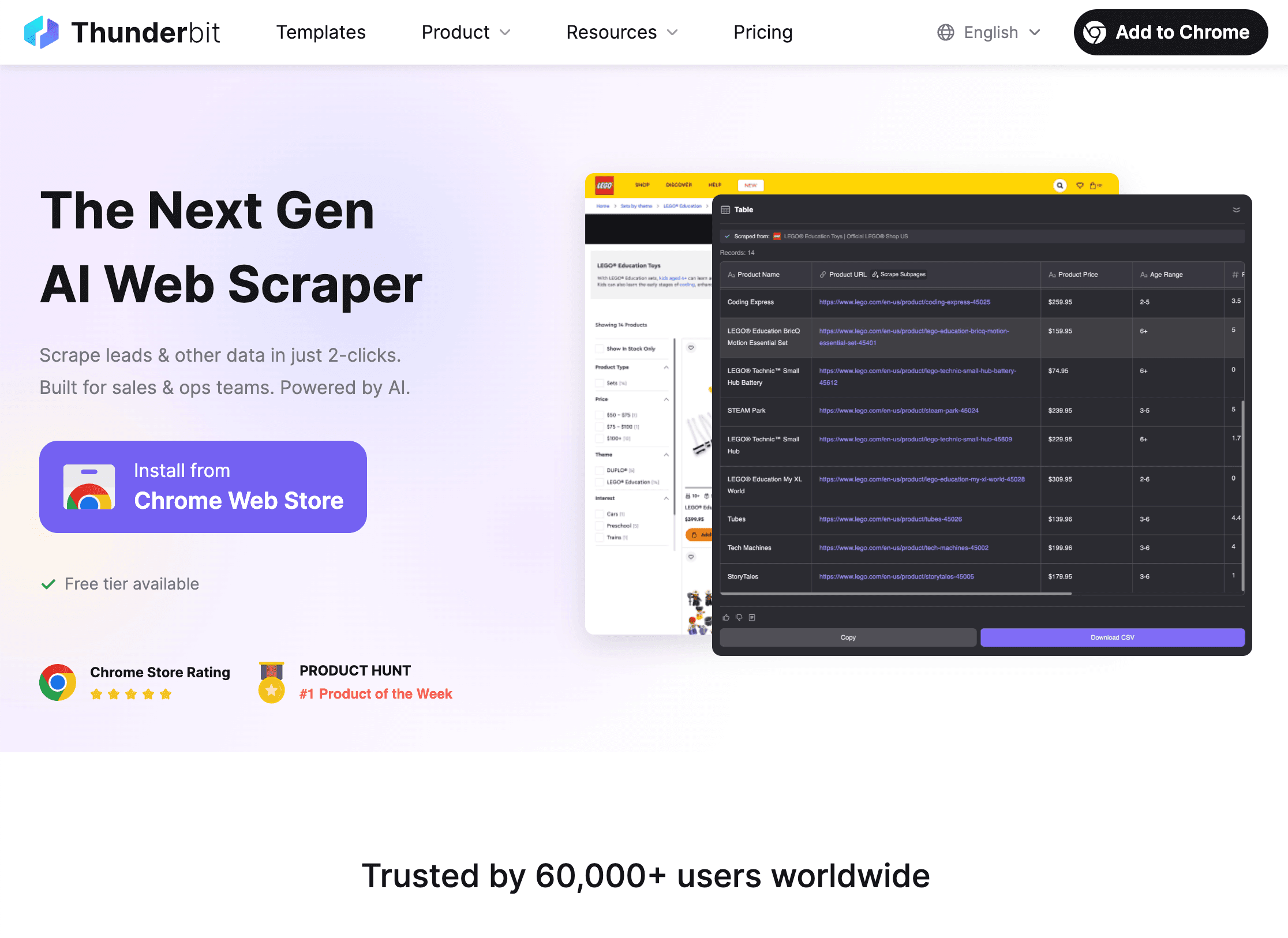

1. Thunderbit

è la mia prima scelta per chi vuole uno scraping web potenziato dall’AI senza complicazioni. Da co-fondatore sono di parte, ma solo perché ho visto quanto tempo fa risparmiare ai team che vogliono solo i dati, senza stress.

Cosa rende Thunderbit speciale? Tutto ruota attorno alla semplicità guidata dall’AI. Descrivi in italiano cosa vuoi (“Estrai tutti i nomi e i prezzi dei prodotti da questa pagina”) e l’AI di Thunderbit fa il resto. Clicca su “AI Suggerisci Campi”, controlla le colonne proposte e avvia lo scraping. Tutto qui. Niente codice, niente selettori, niente preghiere agli dèi dello scraping.

Funzionalità principali:

- Configurazione tramite Linguaggio Naturale: Basta spiegare all’AI cosa vuoi, senza tecnicismi.

- Suggerimento Automatico dei Campi: Thunderbit analizza la pagina e suggerisce le colonne migliori, anche con dati disordinati.

- Scraping di Sottopagine e Paginazione: Hai bisogno di dettagli da pagine prodotto o elenchi su più pagine? Thunderbit segue i link e arricchisce la tabella in automatico.

- Gestione di Dati Strutturati e Non: Puoi estrarre dati da pagine web, PDF o immagini—Thunderbit usa l’OCR per leggere il testo ovunque si trovi.

- Adattamento Automatico: L’AI si adatta ai cambi di layout, così i tuoi estrattori web non si rompono ogni volta che un sito cambia aspetto.

- Esportazione Dati: Invia i dati direttamente su Excel, Google Sheets, Airtable o Notion. L’export è sempre gratuito.

- Prezzi Flessibili: Piano gratuito (6 pagine), prova gratuita (10 pagine), abbonamenti a partire da circa 16,50$/mese (annuale).

Ideale per: Team commerciali che creano liste di contatti, operatori ecommerce che monitorano i prezzi, agenti immobiliari che raccolgono dati sugli immobili, o chiunque voglia uno scraping potente senza scrivere codice.

Per approfondire, visita il o la .

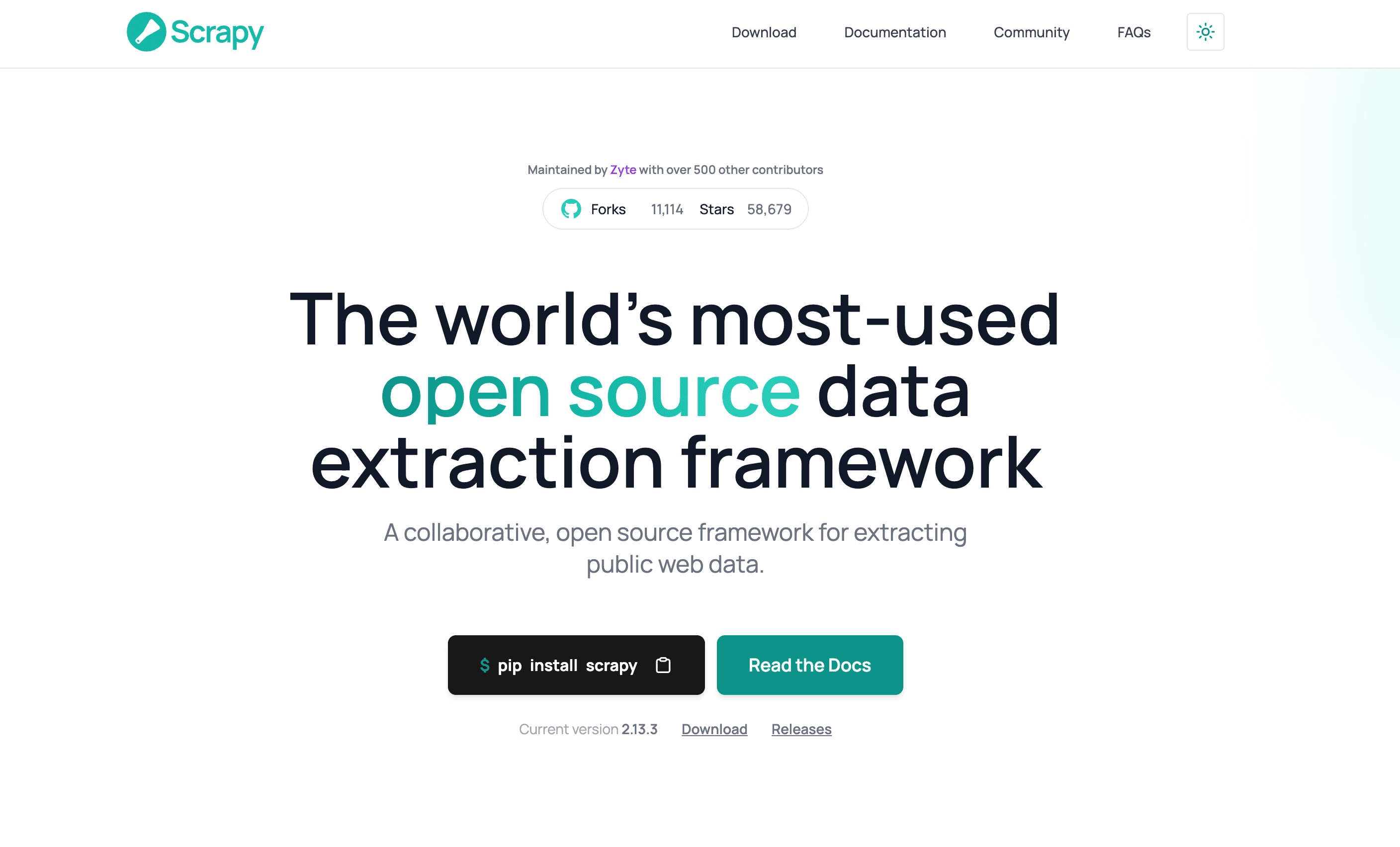

2. Scrapy

è il punto di riferimento open source per gli sviluppatori che vogliono il massimo controllo. Scritto in Python, Scrapy è il coltellino svizzero dei framework per il web scraping: flessibile, veloce e altamente personalizzabile.

Funzionalità principali:

- Personalizzazione Totale: Scrivi i tuoi spider in Python per navigare, estrarre e processare i dati come preferisci.

- Prestazioni Elevate: Motore asincrono che estrae centinaia di pagine al minuto.

- Scalabilità: Si integra con proxy, browser headless e cloud per progetti di grandi dimensioni.

- Ecosistema Ricco: Tantissimi plugin, middleware e una community attiva.

- Gratuito e Open Source: Nessun costo di licenza—solo il tuo tempo e le tue competenze tecniche.

Svantaggi: Scrapy è solo codice—niente interfaccia grafica o no-code. Serve conoscere Python e occuparsi della manutenzione degli spider quando i siti cambiano.

Ideale per: Sviluppatori, data engineer e team che costruiscono progetti di scraping su misura e su larga scala, integrati con altri strumenti Python.

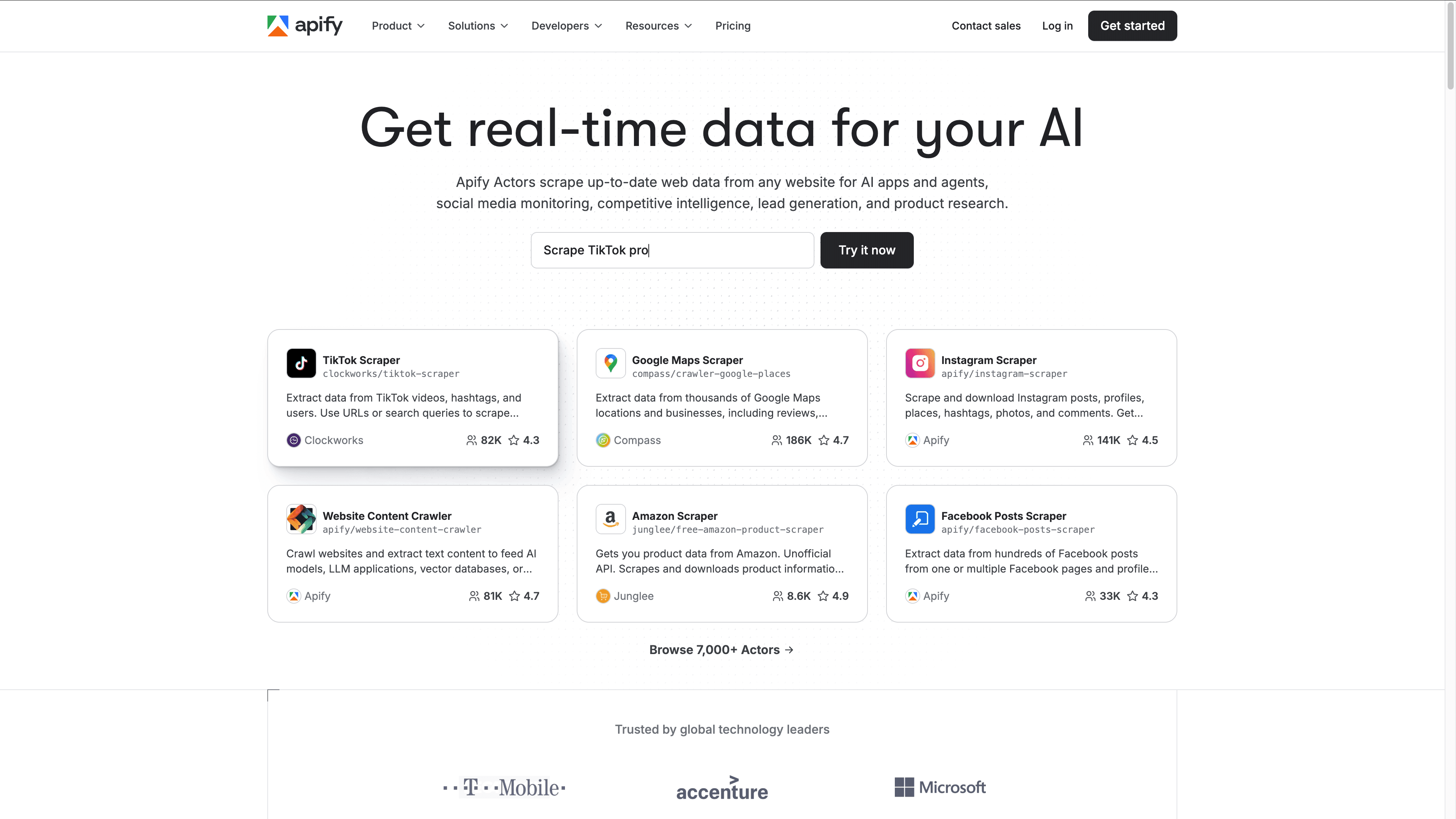

3. Apify

offre il giusto equilibrio tra soluzioni pronte all’uso e personalizzazione avanzata. È una piattaforma cloud per il web scraping, con un marketplace di “Actors” (bot di scraping) già pronti per i siti più popolari e la possibilità di programmare i tuoi in JavaScript o Python.

Funzionalità principali:

- Marketplace con oltre 200 Actors: Scraping su Amazon, Twitter, Google Maps e altro con pochi click.

- Interfaccia Intuitiva: Avvia gli estrattori web dal browser, monitora i progressi e visualizza i risultati nel cloud.

- Script Personalizzati: Crea i tuoi actors per esigenze specifiche, sfruttando l’infrastruttura Apify.

- Automazione e Pianificazione: Pianifica scraping ricorrenti, collega workflow e integra con Google Sheets, Slack o Zapier.

- Prezzi Flessibili: Piano gratuito (crediti limitati), abbonamenti da 49$/mese, prezzi a consumo per grandi volumi.

Ideale per: Team che vogliono combinare template no-code e flessibilità per sviluppatori. Ottimo per startup, agenzie e aziende che vogliono scalare la raccolta dati.

4. Bright Data

(ex Luminati) è il colosso enterprise delle api per il web scraping. Se devi estrarre dati da siti particolarmente protetti e su larga scala, la sua rete di proxy e le tecnologie anti-bot sono imbattibili.

Funzionalità principali:

- Oltre 150 milioni di IP Proxy: Copertura globale, proxy residenziali, datacenter, ISP e mobile.

- Web Unlocker API: Risolve automaticamente i CAPTCHA, aggira le difese anti-bot e simula browser reali.

- API Specializzate: Scraping SERP, e-commerce, crawler personalizzati e altro.

- Affidabilità Enterprise: Successo oltre il 99%, supporto 24/7, funzioni di compliance.

- Consegna Dati: Esportazione in JSON, CSV, Excel o direttamente su cloud storage.

Svantaggi: Prezzi a partire da circa 500$/mese o 1$ ogni 1.000 richieste. Interfaccia pensata per sviluppatori—gli utenti non tecnici potrebbero aver bisogno di supporto.

Ideale per: Grandi aziende, società di ricerche di mercato e chiunque abbia bisogno di raccogliere dati critici, su larga scala o da siti molto protetti.

5. ScrapingBee

è un’API pensata per sviluppatori che devono affrontare siti dinamici e problemi anti-bot. Gestisce browser headless, proxy e CAPTCHA così puoi concentrarti solo sui dati.

Funzionalità principali:

- Rendering con Browser Headless: Estrai contenuti da siti ricchi di JavaScript o app a pagina singola.

- Rotazione Automatica dei Proxy: Evita ban degli IP e accedi a contenuti geo-localizzati.

- Gestione CAPTCHA: Bypassa o risolve automaticamente i CAPTCHA più comuni.

- API Semplice: Facile da integrare con Python, Node.js, PHP e altri linguaggi.

- Prezzi Accessibili: Piani da 49$/mese, prezzi a consumo, crediti di prova gratuiti.

Svantaggi: Nessuna interfaccia grafica—serve integrare l’API. Non sempre gestisce i sistemi anti-bot più avanzati come Bright Data.

Ideale per: Sviluppatori e PMI che devono estrarre dati da siti dinamici o con protezioni moderate, senza costruire infrastrutture da zero.

6. Octoparse

è una piattaforma no-code per il web scraping pensata per utenti business che vogliono potenza senza programmare. L’interfaccia visuale drag-and-drop la rende accessibile anche ai non tecnici, ma offre comunque funzionalità avanzate.

Funzionalità principali:

- UI Punta e Clicca: Crea estrattori web cliccando sugli elementi della pagina—niente codice.

- Gestione Siti Complessi: Supporta JavaScript, scroll infinito, login e workflow multi-step.

- Template Preimpostati: Centinaia di estrattori web già pronti per Amazon, Twitter, LinkedIn e altri.

- Pianificazione Cloud: Esegui job nel cloud, pianifica attività ricorrenti, esporta su Excel, CSV o via API.

- Prezzi: Piano gratuito (task limitati), Standard a 119$/mese, Pro a 249$/mese.

Svantaggi: L’app desktop è solo per Windows; curva di apprendimento per workflow avanzati; può diventare costosa su larga scala.

Ideale per: Analisti, marketer e team operations non tecnici che vogliono scraping avanzato senza sviluppatori.

7. Import.io

è un veterano del settore, oggi focalizzato sull’integrazione dati end-to-end per le aziende. Permette di estrarre, trasformare e consegnare dati web direttamente nei flussi di lavoro aziendali.

Funzionalità principali:

- Estrazione Punta e Clicca: Allena gli estrattori web con esempi—niente codice.

- Gestione Login e Workflow: Automatizza interazioni multi-step e scraping dietro autenticazione.

- Trasformazione Dati: Pulisce, formatta e arricchisce i dati durante l’estrazione.

- Integrazione: API e webhook per collegare direttamente BI, database o Google Sheets.

- Supporto Enterprise: Account manager dedicati, funzioni di compliance, opzioni on-premise.

- Prezzi: Da circa 299$/mese, contratti enterprise personalizzati.

Svantaggi: Prezzi premium, contratti annuali, più adatto a grandi organizzazioni.

Ideale per: Aziende e realtà data-driven che necessitano pipeline dati web affidabili e integrate, con supporto dedicato.

8. Data Miner

è un’estensione browser per Chrome ed Edge che rende semplicissima l’estrazione rapida di dati su piccola scala. Perfetta per quei momenti in cui “mi serve questa tabella in Excel, subito”.

Funzionalità principali:

- Scraping con un Click: Usa oltre 50.000 “ricette” pubbliche per i siti più popolari, o crea le tue con l’interfaccia punta e clicca.

- Basato su Browser: Estrae dati usando la sessione attiva—ottimo per pagine con login.

- Crawling Multi-Pagina: Clicca automaticamente su “pagina successiva” o su una lista di URL.

- Esportazione: Scarica in CSV, Excel o carica su Google Sheets.

- Prezzi: Gratis per 500 pagine/mese, piani a pagamento da 20 a 99$/mese.

Svantaggi: Non adatto a scraping su larga scala o siti molto dinamici; ideale per lavori rapidi e occasionali.

Ideale per: Persone e piccoli team che hanno bisogno di estrarre dati velocemente dal browser—come marketer, commerciali o ricercatori.

Tabella Comparativa delle API per il Web Scraping

Ecco una panoramica per aiutarti a scegliere lo strumento giusto:

| Strumento | Stabilità Estrazione | Gestione Siti Complessi | Facilità d'Uso | Documentazione & Supporto | Prezzi | Ideale per |

|---|---|---|---|---|---|---|

| Thunderbit | Molto alta (AI si adatta) | Buona (AI, browser/cloud) | Eccellente (UI no-code) | Ottima documentazione, supporto reattivo | Piano gratuito, da ~16,5$/mese | Utenti business, AI, no-code |

| Scrapy | Alta (manutenzione manuale) | Dipende (codice custom) | Bassa (solo codice) | Grande community | Gratuito, costi infrastruttura | Sviluppatori, progetti custom e su larga scala |

| Apify | Alta (cloud, actors) | Molto buona (proxy, headless) | Buona (UI + codice) | Buona documentazione, supporto | Piano gratuito, da 49$/mese | Team che vogliono template + scripting personalizzato |

| Bright Data | Estremamente alta (enterprise) | Eccellente (proxy, anti-bot) | Bassa (API, dev) | Supporto 24/7 enterprise | 500$+/mese, 1$/1k richieste | Enterprise, scraping complessi e protetti |

| ScrapingBee | Alta (pagine dinamiche) | Molto buona (JS, proxy, CAPTCHA) | API (dev) | Ottima documentazione, supporto | Da 49$/mese, prezzi a consumo | Dev, PMI, siti dinamici |

| Octoparse | Alta (cloud, template) | Buona (JS, login, scroll) | Eccellente (UI no-code) | Tutorial, supporto 24/7 | Piano gratuito, 119–249$/mese | Team non tecnici, ricerche di mercato, prezzi |

| Import.io | Molto alta (gestito) | Molto buona (login, workflow) | Buona (UI no-code) | Supporto enterprise | Da 299$/mese | Enterprise, pipeline dati integrate |

| Data Miner | Media (basato su browser) | Base (sessione browser) | Eccellente (estensione) | Documentazione, office hours | Gratis, 20–99$/mese | Scraping rapido, su piccola scala, ad hoc |

Come Scegliere la Migliore API per il Web Scraping per la Tua Azienda

Scegliere la giusta api per il web scraping non è solo questione di funzioni avanzate, ma di cosa serve davvero al tuo business. Ecco una guida veloce:

- Per chi non programma o utenti business: Thunderbit, Octoparse o Data Miner sono pensati per velocità e semplicità.

- Per sviluppatori o workflow personalizzati: Scrapy, Apify o ScrapingBee offrono flessibilità e potenza.

- Per progetti enterprise o mission-critical: Bright Data o Import.io garantiscono affidabilità, compliance e supporto su larga scala.

- Per lavori rapidi e occasionali: Data Miner è la soluzione ideale.

Domande da farsi prima di scegliere:

- Con che frequenza farai scraping? (Una tantum o ricorrente)

- Quanto sono complessi i siti target? (Statici, dinamici, con protezioni anti-bot)

- Chi userà lo strumento? (Utenti business o sviluppatori)

- Qual è il tuo budget? (Gratis, pay-as-you-go, enterprise)

- Serve integrazione con BI o CRM?

Ricorda: quasi tutti gli strumenti offrono una prova gratuita. Testa sempre con i tuoi dati reali prima di acquistare.

Conclusione: Sblocca il Valore dei Dati con la Giusta API per il Web Scraping

Le api per il web scraping sono passate da strumenti di nicchia per sviluppatori a pilastri fondamentali per il business. Che tu debba creare liste di lead, monitorare prezzi o alimentare le tue analisi, la giusta API trasforma il caos del web in dati puliti e utilizzabili—senza stress.

Thunderbit si distingue per l’approccio AI e la facilità d’uso, ma ogni strumento in questa lista ha il suo punto di forza. Il vero vantaggio? Automatizzare le attività ripetitive, così tu e il tuo team potete concentrarvi sulle analisi, non sul lavoro manuale.

Vuoi vedere come funziona lo scraping moderno? o esplora il per guide e consigli. Buono scraping—e che i tuoi dati siano sempre freschi, ordinati e a portata di click.

Domande Frequenti

1. Cos’è una api per il web scraping e perché dovrei usarla?

Una api per il web scraping automatizza l’estrazione di dati dai siti, gestendo aspetti tecnici come il parsing HTML, l’esecuzione di JavaScript e le difese anti-bot. È molto più veloce e affidabile del copia-incolla manuale e ti permette di concentrarti sull’uso dei dati, non sulla raccolta.

2. Qual è la migliore api per il web scraping per chi non ha competenze tecniche?

Thunderbit, Octoparse e Data Miner sono ottime per chi non programma. Thunderbit si distingue per l’interfaccia AI in linguaggio naturale, Octoparse offre un builder visuale drag-and-drop, Data Miner è perfetto per estrazioni rapide dal browser.

3. Come gestiscono le api per il web scraping siti dinamici e CAPTCHA?

API come Bright Data, ScrapingBee e Apify usano browser headless, rotazione proxy e risoluzione CAPTCHA per affrontare siti dinamici o protetti. L’AI di Thunderbit si adatta ai cambi di layout e gestisce molti scenari dinamici, soprattutto in modalità browser.

4. Cosa considerare nella scelta di una api per il web scraping?

Valuta le tue competenze tecniche, la complessità dei siti target, il budget e come vuoi usare i dati (es. esportazione su Excel, integrazione con BI). Prova sempre la versione gratuita per verificare se lo strumento si adatta al tuo flusso di lavoro.

5. Lo scraping è legale e sicuro per le aziende?

Lo scraping è legale se fatto responsabilmente: rispetta sempre i termini d’uso dei siti, evita di raccogliere dati personali o sensibili senza consenso e scegli API che supportano la compliance (come Bright Data o Import.io per le aziende). In caso di dubbi, consulta il tuo legale.

Per approfondire su scraping, automazione e strumenti AI per i dati, visita il o iscriviti al nostro .

Scopri di più