Il web nel 2025 sembra davvero il selvaggio West: ormai metà del traffico online non arriva nemmeno da persone in carne e ossa. Esatto, i bot generano quasi , e i sistemi anti-bot sono sempre più sofisticati. Dopo anni passati a sviluppare automazioni e flussi di scraping, ti assicuro che basta un dettaglio fuori posto—come scegliere il user agent sbagliato—per mandare all’aria un intero progetto di raccolta dati. Per chi lavora in sales, ecommerce o operations, essere bloccati da un sito non è solo una seccatura: può voler dire perdere contatti, prezzi aggiornati o addirittura fatturato.

La buona notizia? Non serve essere un mago dell’informatica per superare questi ostacoli. In questa guida ti spiego perché la strategia del user agent è diventata fondamentale per lo scraping, come evitare gli errori più comuni e in che modo rende la gestione dei user agent così semplice che quasi te ne dimentichi. Che tu stia cercando nuovi lead, monitorando prodotti o semplicemente aggiornando i tuoi fogli di calcolo, qui trovi il piano d’azione per restare sempre un passo avanti.

Perché Scegliere il Miglior User Agent per lo Scraping è Così Importante

Partiamo dalle basi: cos’è un user agent? È come la “carta d’identità” del tuo browser. Ogni volta che visiti un sito—sia che tu sia una persona o un bot—il browser invia una stringa User-Agent negli header della richiesta. È una specie di presentazione: “Ciao, sono Chrome su Windows” oppure “Sono Safari su iPhone” (). Ecco un esempio tipico di user agent di Chrome:

1Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36I siti web usano queste informazioni principalmente per due motivi:

- Per mostrare il contenuto giusto (ad esempio layout mobile o desktop).

- Per individuare bot e strumenti di scraping.

Se il tuo user agent è “python-requests/2.28.1” o “Scrapy/2.9.0”, è come presentarsi con un cartello “Ciao, sono un bot!”. I siti tengono delle blacklist di questi identificatori evidenti e ti bloccano in un attimo con un bel “403 Forbidden”. Al contrario, usare un user agent di un browser reale e aggiornato ti aiuta a confonderti tra gli utenti veri.

In poche parole: il tuo user agent è il tuo travestimento. Più è credibile, più facilmente otterrai i dati che ti servono.

Il Ruolo del User Agent nel Successo dello Scraping

Perché la scelta del user agent è così determinante? Perché rappresenta la prima barriera per la maggior parte dei sistemi anti-bot. Ecco cosa può andare storto se sbagli:

- Blocchi immediati (errori 403/429): Se usi il user agent predefinito di una libreria di scraping, verrai bloccato prima ancora di vedere la homepage ().

- Dati vuoti o falsi: Alcuni siti restituiscono pagine bianche o “finte” agli user agent sospetti.

- CAPTCHA o redirect: Un user agent da bot scatena sfide “Sei umano?” o loop di login senza fine.

- Limitazioni e ban: Se usi sempre lo stesso user agent, rischi di essere rallentato o bannato per IP.

Ecco come si comportano diversi user agent:

| User Agent String | Risultato sulla maggior parte dei siti (2025) |

|---|---|

python-requests/2.28.1 | Bloccato subito, identificato come bot |

Scrapy/2.9.0 (+https://scrapy.org) | Bloccato o riceve contenuti finti |

Mozilla/5.0 (Windows NT 10.0; Win64; x64)... | Trattato come utente reale, accesso consentito |

AhrefsBot/7.0 (+http://ahrefs.com/robot/) | Bloccato, crawler noto |

| UA vuoto o casuale | A volte consentito, spesso sospetto |

Morale della favola? Scegli il travestimento giusto. E ricorda: i sistemi anti-bot moderni non si fermano al user agent. Controllano anche che gli altri header (come Accept-Language o Referer) siano coerenti. Se dici di essere Chrome ma non invii gli header giusti, verrai comunque scoperto ().

Qui entra in gioco Thunderbit. Ho parlato con tanti utenti business—commerciali, responsabili ecommerce, agenti immobiliari—che vogliono solo i dati, senza dover studiare HTTP. Per questo abbiamo creato Thunderbit: la gestione dei user agent è invisibile e automatica.

Thunderbit: Gestione Semplificata dei User Agent per Tutti

Con la , non devi nemmeno pensare al user agent. Il nostro motore AI lo seleziona per te, scegliendo la firma di browser più realistica e aggiornata per ogni sito. Che tu usi la (che utilizza davvero il user agent di Chrome) o il cloud scraping (dove l’AI ruota tra diversi user agent di browser reali), ti confonderai sempre tra il traffico normale.

E non si tratta solo di user agent. Thunderbit invia un set completo e coerente di header—Accept-Language, Accept-Encoding, Client Hints e altro—così le tue richieste sembrano e si comportano come quelle di un browser vero. Niente più header incoerenti, niente più segnali da “bot”.

La parte migliore? Non devi configurare nulla. L’AI di Thunderbit si occupa di tutto dietro le quinte, così puoi concentrarti su ciò che conta: ottenere dati affidabili e di qualità.

Perché la Rotazione Dinamica dei User Agent è una Best Practice Indispensabile

Hai trovato il user agent perfetto? Non usarlo sempre! Nel 2025, ripetere lo stesso user agent è un autogol. Gli utenti reali usano browser, versioni e dispositivi diversi. Se il tuo estrattore Web visita un sito 500 volte di fila con lo stesso user agent, è come mandare una sfilata di gemelli identici—nessuno ci casca.

Ecco perché la rotazione dinamica dei user agent è ormai uno standard. L’idea è semplice: alterna user agent realistici e aggiornati per ogni richiesta o sessione. Così il tuo estrattore Web sembra un gruppo variegato di visitatori reali, non uno script automatico ().

La rotazione intelligente di Thunderbit va oltre. Per scraping su più pagine o attività programmate, Thunderbit cambia automaticamente user agent e abbina anche diversi proxy IP. Se un sito inizia a sospettare, Thunderbit si adatta in tempo reale—cambiando user agent, modificando gli header o rallentando le richieste. Tutto avviene in automatico, così il tuo scraping resta invisibile e i dati continuano ad arrivare.

User Agent e Header: L’Importanza della Coerenza

Un consiglio da chi ci è passato: il user agent è solo una parte dell’“impronta digitale” della tua richiesta. I sistemi anti-bot moderni controllano se il user agent è coerente con altri header come Accept-Language, Accept-Encoding e Referer. Se dici di essere Chrome su Windows ma invii Accept-Language in francese da un IP di New York, scatta l’allarme ().

Le migliori pratiche:

- Invia sempre un set completo di header coerenti con il tuo user agent.

- Mantieni Accept-Language e Accept-Encoding in linea con il user agent e, se possibile, con la geolocalizzazione IP.

- Usa gli strumenti di sviluppo del browser per vedere le richieste reali e copia l’intero set di header per il tuo user agent.

Thunderbit si occupa di tutto questo. La nostra AI garantisce che ogni richiesta sia perfettamente coerente—user agent, header e persino fingerprint del browser. Ottieni richieste indistinguibili da quelle umane, senza sforzo.

Errori da Evitare: Cosa NON Fare con i User Agent

Ho visto tanti progetti di scraping naufragare sempre per gli stessi motivi. Ecco gli errori più comuni da evitare:

- Usare user agent predefiniti delle librerie di scraping: Stringhe come

python-requests/2.x,Scrapy/2.9.0oJava/1.8sono segnali di blocco immediato. - Versioni di browser obsolete: Fingere di essere Chrome 85 nel 2025? Sospetto. Usa sempre versioni aggiornate.

- Header incoerenti: Non inviare un user agent Chrome con Accept-Language o Accept-Encoding mancanti o sbagliati.

- User agent di crawler noti: Qualsiasi stringa con “bot”, “crawler”, “spider” o nomi di tool (come AhrefsBot) è un campanello d’allarme.

- User agent vuoti o casuali: A volte passano, ma spesso sono sospetti e poco affidabili.

Checklist rapida per user agent sicuri:

- Usa user agent di browser reali e aggiornati (Chrome, Firefox, Safari).

- Ruota tra diversi user agent.

- Mantieni gli header coerenti con il user agent.

- Aggiorna la lista user agent ogni mese (i browser si aggiornano spesso).

- Evita tutto ciò che “grida” automazione.

Thunderbit in Pratica: Esempi Reali per Sales e Operations

Vediamo come la gestione dei user agent di Thunderbit aiuta davvero i team:

| Caso d’uso | Vecchio metodo: scraping manuale | Con Thunderbit | Risultato |

|---|---|---|---|

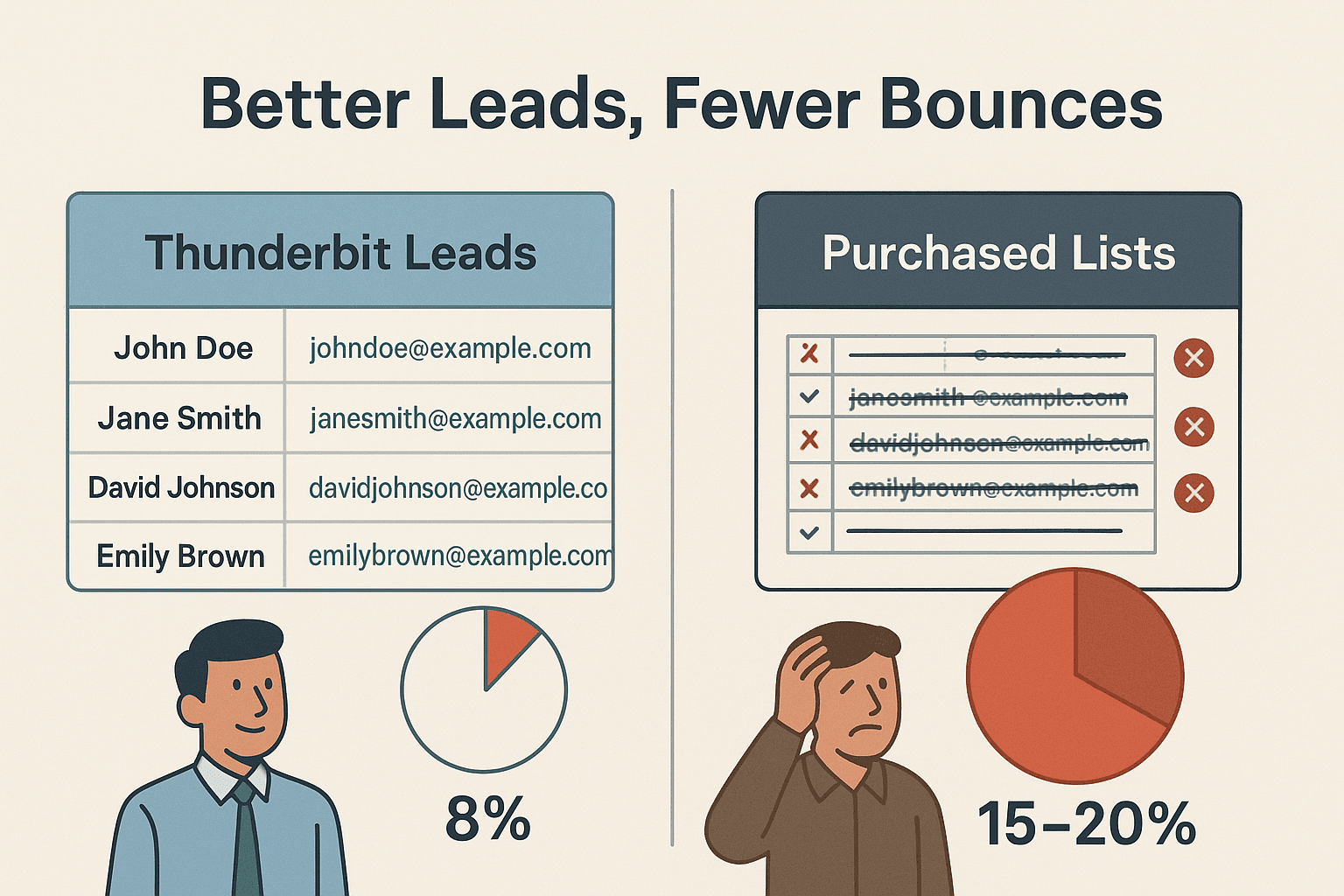

| Lead Generation | Blocchi frequenti, dati mancanti | L’AI sceglie e ruota i migliori user agent, simula la navigazione reale | Più lead, qualità superiore, meno rimbalzi |

| Monitoraggio Ecommerce | Script che si interrompono, ban IP | Cloud scraping con rotazione dinamica di user agent e proxy | Monitoraggio prezzi/stock affidabile |

| Annunci Immobiliari | Modifiche continue, blocchi | L’AI adatta user agent/header e gestisce le sottopagine automaticamente | Liste immobili complete e aggiornate |

Un team commerciale che ha usato Thunderbit per estrarre lead da migliaia di siti ha registrato solo ~8% di email non recapitate—contro il 15–20% delle liste acquistate (). Questo è il vantaggio di uno scraping fresco e simile a quello umano.

Guida Pratica: Come Fare Scraping con il Miglior User Agent su Thunderbit

Ecco quanto è semplice iniziare con Thunderbit—non serve alcuna competenza tecnica:

- Installa la .

- Vai sul sito che ti interessa. Accedi se necessario—Thunderbit funziona anche su pagine protette da login.

- Clicca su “AI Suggerisci Campi”. L’AI di Thunderbit analizza la pagina e suggerisce le colonne migliori da estrarre.

- Rivedi e modifica i campi se vuoi. Puoi rinominare, aggiungere o togliere colonne.

- Clicca su “Estrai”. Thunderbit raccoglie i dati, ruotando user agent e header in automatico.

- Esporta i tuoi dati. Invia tutto su Excel, Google Sheets, Airtable, Notion o scarica in CSV/JSON.

Non serve scegliere o aggiornare user agent—l’AI di Thunderbit si occupa di tutto, adattandosi a ogni sito per garantirti il massimo successo.

Thunderbit vs Gestione Manuale dei User Agent: Il Confronto

Ecco come Thunderbit si confronta con il vecchio approccio manuale:

| Funzione/Attività | Approccio Manuale | Approccio Thunderbit |

|---|---|---|

| Configurazione User Agent | Ricerca e impostazione nel codice | Automatico, scelto dall’AI per ogni sito |

| Aggiornamento User Agent | Manuale, facile da dimenticare | L’AI aggiorna in automatico seguendo i trend dei browser |

| Rotazione User Agent | Devi programmare la logica di rotazione | Rotazione intelligente integrata |

| Coerenza Header | Devi abbinare manualmente gli header al user agent | L’AI garantisce un set di header completo e coerente |

| Gestione Blocchi/CAPTCHA | Cambi manuali, alta manutenzione | L’AI si adatta, riprova e ruota quando serve |

| Competenze Tecniche Richieste | Alte (codice, conoscenza HTTP) | Nessuna—pensato per utenti business |

| Tempo perso in troubleshooting | Spesso, frustrante | Minimo—puoi concentrarti sui dati, non sui problemi di scraping |

Thunderbit è pensato per chiunque voglia uno scraping affidabile e scalabile—senza complicazioni tecniche.

In Sintesi: Come Costruire una Strategia User Agent a Prova di Futuro

Ecco cosa ho imparato (spesso a mie spese) sulla gestione dei user agent nel 2025:

- Mai usare user agent predefiniti o obsoleti. Sono la causa principale dei blocchi.

- Ruota i user agent in modo dinamico. La varietà è fondamentale—non far sembrare il tuo estrattore Web un robot in parata.

- Mantieni header coerenti e realistici. Il tuo user agent vale solo quanto il contesto che lo accompagna.

- Resta aggiornato. Le versioni dei browser cambiano spesso; aggiorna anche la tua lista di user agent.

- Lascia che l’AI faccia il lavoro pesante. Strumenti come Thunderbit integrano le best practice, così puoi concentrarti sui risultati, non sulle richieste.

Se sei stufo di blocchi, script da correggere o vuoi semplicemente fare scraping come un professionista senza stress, . Il nostro Estrattore Web AI è scelto da migliaia di utenti in tutto il mondo e rende i dati web accessibili a tutti—senza mal di testa tecnici.

Per altri consigli, tutorial e approfondimenti sul web scraping, visita il .

Domande Frequenti

1. Cos’è un user agent e perché è importante per il web scraping?

Un user agent è una stringa inviata con ogni richiesta web che identifica browser e sistema operativo. I siti la usano per mostrare il contenuto giusto e individuare i bot. Usare il user agent corretto aiuta il tuo estrattore Web a passare inosservato e a evitare blocchi.

2. Perché non dovrei usare il user agent predefinito della mia libreria di scraping?

User agent come python-requests/2.x sono firme di bot molto note e vengono spesso bloccate subito. Usa sempre user agent realistici e aggiornati.

3. Come gestisce Thunderbit la rotazione dei user agent?

L’AI di Thunderbit ruota automaticamente tra una serie di user agent di browser reali e aggiornati per ogni richiesta o sessione. Così il tuo scraping appare come traffico reale e variegato.

4. Devo impostare manualmente header come Accept-Language o Referer con Thunderbit?

No! L’AI di Thunderbit garantisce che tutti gli header siano coerenti e in linea con il user agent, così le tue richieste sembrano provenire da un browser vero.

5. Cosa succede se un sito blocca comunque le mie richieste?

Thunderbit rileva blocchi o CAPTCHA e si adatta in tempo reale—cambiando user agent, modificando header o riprovando. Ottieni dati affidabili senza dover intervenire manualmente.

Vuoi fare scraping in modo più intelligente? e lascia che la nostra AI gestisca la “guerra dei user agent” al posto tuo. Buon scraping!

Scopri di più