Il web oggi è davvero il più grande campo da gioco per i dati—e diciamocelo, tutti vogliamo costruire il nostro castello di sabbia più alto degli altri. Che tu sia nel commerciale, nell’e-commerce, nella ricerca o semplicemente un nerd dei dati come me, l’estrazione di dati dal web è la chiave segreta per prendere decisioni più furbe e accelerare i processi. Nel 2025, non sono più solo i giganti tech a raccogliere dati: e dice che le decisioni data-driven sono la base del loro successo. Il dettaglio curioso? Python è il motore di questa rivoluzione, grazie al suo ecosistema di librerie e strumenti per l’estrazione dati.

Dopo anni passati tra SaaS e automazione, ho visto con i miei occhi come lo strumento giusto in Python possa trasformare ore di lavoro manuale in pochi minuti. Ma con così tante opzioni—dalle librerie classiche, all’automazione browser, alle piattaforme no-code e persino agli strumenti AI—come si fa a scegliere? In questa guida ti porto le 12 migliori librerie Python per l’estrazione dati dal web, dalle soluzioni più semplici per chi parte da zero fino alle novità AI come . Che tu sia uno sviluppatore, un manager operativo o un utente business che vuole solo i dati (senza sbattimenti), qui trovi la soluzione che fa per te.

Perché scegliere lo strumento Python giusto per l’estrazione dati fa la differenza

Parliamoci chiaro: non tutti i progetti di estrazione dati sono uguali. Scegliere lo strumento giusto può fare la differenza tra un processo liscio e automatizzato e una settimana persa a rincorrere script che non funzionano. Ho visto un’agenzia di recruiting moltiplicare le vendite per 10 in tre mesi automatizzando la raccolta di lead—ogni commerciale ha risparmiato 8 ore a settimana e portato a casa migliaia di nuovi contatti (). Dall’altra parte, ho visto team perdere giorni perché avevano scelto una libreria che non reggeva i contenuti dinamici o veniva bloccata dai sistemi anti-bot.

Ecco perché la scelta è fondamentale:

- Impatto sul business: Lo strumento giusto può automatizzare la generazione di lead, il monitoraggio prezzi, l’analisi della concorrenza e i flussi di lavoro—regalandoti un vero vantaggio in vendite, e-commerce e ricerca ().

- Dati statici vs dinamici: Alcuni siti sono semplici HTML; altri sono vere giungle di JavaScript. Se il tuo strumento non gestisce i contenuti dinamici, rischi di perderti dati preziosi.

- Scalabilità e affidabilità: Devi estrarre pochi dati? Quasi tutto va bene. Devi raccogliere migliaia di pagine ogni giorno? Serve una soluzione pensata per la scalabilità, come Scrapy o una piattaforma cloud.

Dritta da chi ci è passato: —ad esempio Beautiful Soup per le pagine statiche e Selenium per quelle dinamiche. La combinazione giusta è la tua arma segreta.

Come abbiamo scelto le migliori librerie Python per l’estrazione dati

Con così tante librerie e piattaforme in giro, mi sono concentrato su ciò che davvero conta per chi lavora con i dati, sia business che tecnico:

- Facilità d’uso: È accessibile anche a chi non programma? L’API è chiara? Le opzioni visuali/no-code sono un plus.

- Automazione e scalabilità: Gestisce crawl multipagina, pianificazione e grandi volumi di dati? Funziona in cloud o anche in locale?

- Supporto ai contenuti dinamici: Può estrarre dati da siti pieni di JavaScript, infinite scroll o dietro login?

- Integrazione ed esportazione: Quanto è facile portare i dati su Excel, Google Sheets, database o nel tuo workflow?

- Comunità e aggiornamenti: È ancora sviluppata? Ci sono guide e supporto?

- Costo: È gratis, open-source o a pagamento? Che valore offre a team e aziende?

Ho testato questi strumenti, letto recensioni e analizzato casi reali. Ecco la top 12.

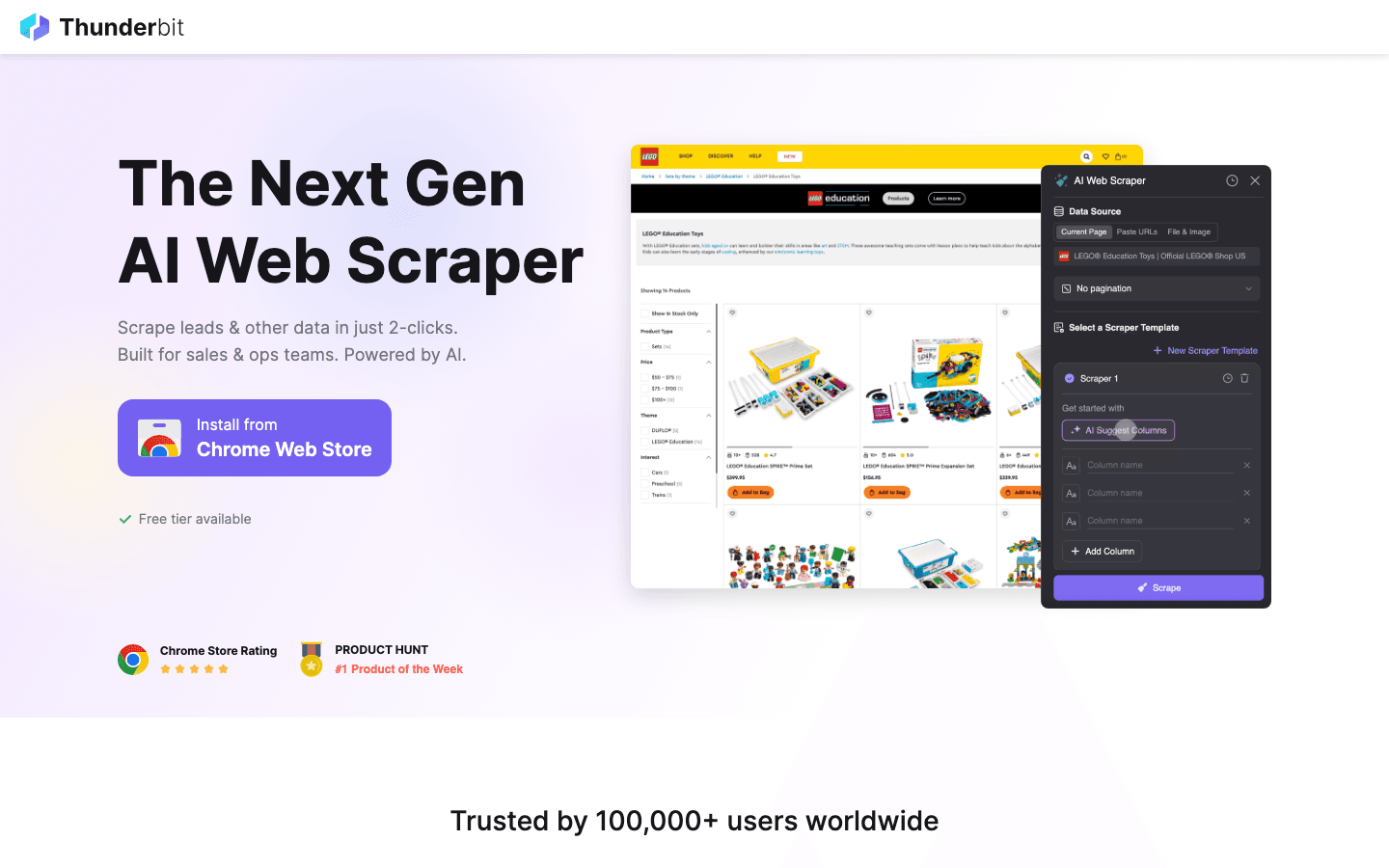

1. Thunderbit

è la mia scelta top per chi vuole estrarre dati dal web senza complicarsi la vita. È un’ che ti permette di raccogliere dati da qualsiasi sito in due click—niente codice, niente template, zero stress.

è la mia scelta top per chi vuole estrarre dati dal web senza complicarsi la vita. È un’ che ti permette di raccogliere dati da qualsiasi sito in due click—niente codice, niente template, zero stress.

Perché lo consiglio: Thunderbit è pensato per chi lavora in business—vendite, operations, e-commerce, immobiliare—e ha bisogno di dati subito ma non vuole mettersi a scrivere script Python. Basta cliccare su “AI Suggerisci Campi”, lasciare che l’AI legga la pagina e premere “Estrai”. Thunderbit gestisce sottopagine, paginazione, contenuti dinamici e compila anche i moduli online. Esporta gratis su Excel, Google Sheets, Airtable o Notion.

Funzionalità principali:

- Suggerimenti AI per i campi: L’AI di Thunderbit legge la pagina e ti suggerisce cosa estrarre—nomi, prezzi, email, ecc.

- Estrazione da sottopagine: Vuoi più dettagli? Thunderbit visita automaticamente sottopagine (tipo pagine prodotto o contatti) e arricchisce la tua tabella.

- Template istantanei: Per siti come Amazon, Zillow o Instagram, scegli un template e parti subito.

- Estrazione in cloud o browser: Raccogli fino a 50 pagine alla volta in cloud, oppure usa il browser per siti che richiedono login.

- Esportazione dati gratuita: Nessun blocco per esportare i tuoi dati.

Ideale per: Team non tecnici, sales ops, e-commerce e chiunque voglia risultati rapidi—senza programmare.

Limiti: Non è una libreria Python vera e propria, quindi se vuoi integrarla direttamente nel tuo codice Python dovrai esportare e poi importare i dati. Ma per il 99% delle esigenze business, è una soluzione insostituibile.

Vuoi vederlo in azione? Dai un’occhiata al o al nostro .

2. Beautiful Soup

è la libreria Python storica per analizzare HTML e XML. È stato il mio primo amore per l’estrazione dati e resta la scelta perfetta per chi inizia.

è la libreria Python storica per analizzare HTML e XML. È stato il mio primo amore per l’estrazione dati e resta la scelta perfetta per chi inizia.

Perché è ottima: Semplice, tollerante agli errori e perfetta per progetti rapidi. Recuperi la pagina con Requests, passi l’HTML a Beautiful Soup e usi la sua API intuitiva per trovare ed estrarre dati. Gestisce anche HTML disordinato senza problemi.

Ideale per: Progetti piccoli/medi, pulizia dati e chi sta imparando l’estrazione web.

Limiti: Non supporta nativamente contenuti dinamici (JavaScript). Per questo serve abbinarla a Selenium o altri strumenti di automazione browser.

3. Scrapy

è il framework Python di riferimento per l’estrazione dati su larga scala. Se devi raccogliere migliaia (o milioni) di pagine, costruire pipeline dati o pianificare job automatici, Scrapy è la scelta giusta.

è il framework Python di riferimento per l’estrazione dati su larga scala. Se devi raccogliere migliaia (o milioni) di pagine, costruire pipeline dati o pianificare job automatici, Scrapy è la scelta giusta.

Perché è potente: Scrapy è asincrono, veloce e pensato per la scalabilità. Definisci “spiders” che navigano i siti, seguono i link, gestiscono la paginazione e processano i dati tramite pipeline. È la base di molti progetti enterprise.

Ideale per: Sviluppatori che costruiscono crawler robusti e scalabili; scraping multi-pagina o multi-sito; pipeline dati in produzione.

Limiti: Curva di apprendimento più ripida rispetto a Beautiful Soup. Non gestisce JavaScript di default—ma puoi integrarlo con Splash o Selenium per siti dinamici.

4. Selenium

è lo strumento di automazione browser che ti permette di controllare Chrome, Firefox e altri browser da Python. È indispensabile per estrarre dati da siti dinamici o ricchi di JavaScript, o per automatizzare interazioni complesse.

è lo strumento di automazione browser che ti permette di controllare Chrome, Firefox e altri browser da Python. È indispensabile per estrarre dati da siti dinamici o ricchi di JavaScript, o per automatizzare interazioni complesse.

Perché è fondamentale: Selenium può simulare azioni umane—click, invio di moduli, scroll—e raccogliere tutto ciò che appare nel browser, proprio come farebbe una persona.

Ideale per: Siti dinamici, scraping dopo login, infinite scroll o quando serve interagire con la pagina.

Limiti: Più lento e pesante rispetto alle librerie HTTP pure. Non ideale per estrarre migliaia di pagine senza hardware adeguato.

5. Requests

è la libreria “HTTP for Humans”. È la base della maggior parte degli script Python per l’estrazione dati—recupera pagine web, invia moduli e gestisce i cookie.

è la libreria “HTTP for Humans”. È la base della maggior parte degli script Python per l’estrazione dati—recupera pagine web, invia moduli e gestisce i cookie.

Perché è indispensabile: API semplice, affidabile e si integra perfettamente con Beautiful Soup o lxml. Ottima per siti statici e API.

Ideale per: Recuperare HTML statico, chiamare API o come base per uno scraper personalizzato.

Limiti: Non gestisce contenuti generati da JavaScript. Per siti dinamici, va abbinata a Selenium o simili.

6. LXML

è il parser HTML/XML ad alte prestazioni per Python. È velocissimo e supporta potenti selettori XPath e CSS.

è il parser HTML/XML ad alte prestazioni per Python. È velocissimo e supporta potenti selettori XPath e CSS.

Perché è apprezzata: Se devi estrarre dati da pagine molto grandi o hai bisogno di query avanzate, lxml è la scelta giusta. Scrapy la utilizza internamente.

Ideale per: Progetti dove le prestazioni sono cruciali, grandi volumi di dati o quando serve XPath per estrazioni complesse.

Limiti: Curva di apprendimento leggermente più alta e installazione a volte complessa.

7. PySpider

è un framework Python per l’estrazione dati con interfaccia web. È simile a Scrapy, ma offre una dashboard per gestire, pianificare e monitorare i job di scraping.

è un framework Python per l’estrazione dati con interfaccia web. È simile a Scrapy, ma offre una dashboard per gestire, pianificare e monitorare i job di scraping.

Perché è particolare: Puoi scrivere spiders in Python, pianificarli e vedere i risultati—tutto dal browser. Ottimo per team che vogliono controllo e automazione.

Ideale per: Team che gestiscono più progetti di scraping, crawl pianificati o chi desidera un’interfaccia visuale.

Limiti: Meno aggiornato rispetto a Scrapy e supporto limitato per siti moderni con JavaScript.

8. MechanicalSoup

è una libreria Python leggera per automatizzare semplici attività browser—come compilare moduli e seguire link—senza la complessità di Selenium.

è una libreria Python leggera per automatizzare semplici attività browser—come compilare moduli e seguire link—senza la complessità di Selenium.

Perché è utile: Combina Requests e Beautiful Soup, rendendo facile il login, l’invio di moduli e l’estrazione delle pagine risultanti.

Ideale per: Automatizzare login, invio di form o semplici workflow web dove non serve JavaScript.

Limiti: Non gestisce siti ricchi di JavaScript o interazioni complesse.

9. Octoparse

è uno strumento no-code per l’estrazione dati, con interfaccia drag-and-drop. Perfetto per utenti business che vogliono raccogliere dati senza scrivere codice.

è uno strumento no-code per l’estrazione dati, con interfaccia drag-and-drop. Perfetto per utenti business che vogliono raccogliere dati senza scrivere codice.

Perché è popolare: Octoparse gestisce paginazione, contenuti dinamici e pianifica estrazioni in cloud. Offre template preimpostati per i siti più comuni ed esporta dati su Excel, CSV o Google Sheets.

Ideale per: Non programmatori, ricerche di mercato, generazione lead e team che vogliono risultati rapidi.

Limiti: Il piano gratuito è limitato; le funzioni avanzate richiedono un abbonamento (da circa 75$/mese).

10. ParseHub

è un altro strumento visuale che permette di costruire workflow complessi cliccando sul sito. Ottimo per estrarre dati da siti dinamici, gestire logiche condizionali e pianificare job in cloud.

è un altro strumento visuale che permette di costruire workflow complessi cliccando sul sito. Ottimo per estrarre dati da siti dinamici, gestire logiche condizionali e pianificare job in cloud.

Perché si distingue: La logica condizionale e i workflow multi-step di ParseHub lo rendono ideale per siti complessi con pop-up, tab o dati nascosti.

Ideale per: Non programmatori che devono estrarre dati da siti dinamici e complessi; raccolta dati pianificata.

Limiti: Il piano gratuito ha limiti; i piani a pagamento possono essere costosi per grandi volumi.

11. Colly

è un framework per l’estrazione dati ad alta velocità—scritto in Go, non in Python, ma merita una menzione per le sue prestazioni. Alcuni team Python usano Colly come microservizio per crawl intensivi, poi processano i dati in Python.

è un framework per l’estrazione dati ad alta velocità—scritto in Go, non in Python, ma merita una menzione per le sue prestazioni. Alcuni team Python usano Colly come microservizio per crawl intensivi, poi processano i dati in Python.

Perché è interessante: Colly può raccogliere migliaia di pagine al secondo con un uso minimo di memoria. Se lavori su scala web, è un’ottima opzione cross-platform.

Ideale per: Team di ingegneri che cercano velocità e concorrenza; integrazione di crawler Go nei workflow Python.

Limiti: Richiede conoscenze di Go; non è una libreria Python diretta.

12. Portia

è uno scraper visuale open-source di Scrapinghub (ora Zyte). Permette di costruire spiders Scrapy cliccando sugli elementi nel browser—senza scrivere codice.

è uno scraper visuale open-source di Scrapinghub (ora Zyte). Permette di costruire spiders Scrapy cliccando sugli elementi nel browser—senza scrivere codice.

Perché è interessante: Portia colma il divario tra chi non programma e la potenza di Scrapy. Puoi definire regole di estrazione in modo visuale, poi eseguire lo spider in Scrapy o su Zyte cloud.

Ideale per: Non programmatori nei team dati, o chi vuole prototipare uno spider Scrapy in modo visuale.

Limiti: Meno aggiornato, fatica con siti molto dinamici o interattivi.

Tabella di confronto: le migliori librerie Python per l’estrazione dati a colpo d’occhio

| Strumento/Libreria | Facilità d’uso | Contenuti dinamici | Automazione & Scala | Ideale per | Prezzo |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | ★★★★☆ | ★★★★☆ | Non programmatori, utenti business, risultati rapidi | Gratis + crediti |

| Beautiful Soup | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | Principianti, pagine statiche, pulizia dati | Gratis |

| Scrapy | ★★★☆☆ | ★★★☆☆ | ★★★★★ | Sviluppatori, crawl su larga scala | Gratis |

| Selenium | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | Siti dinamici, automazione browser | Gratis |

| Requests | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | HTML statico, API, script rapidi | Gratis |

| LXML | ★★★☆☆ | ★☆☆☆☆ | ★★★★☆ | Prestazioni, grandi dataset, XPath | Gratis |

| PySpider | ★★★★☆ | ★★★☆☆ | ★★★★★ | Team, crawl pianificati, interfaccia web | Gratis |

| MechanicalSoup | ★★★★☆ | ★☆☆☆☆ | ★★☆☆☆ | Automazione form, login, workflow semplici | Gratis |

| Octoparse | ★★★★★ | ★★★★☆ | ★★★★☆ | No-code, utenti business, scraping pianificato | Gratis + a pagamento |

| ParseHub | ★★★★★ | ★★★★☆ | ★★★★☆ | No-code, siti complessi/dinamici | Gratis + a pagamento |

| Colly | ★★☆☆☆ | ★☆☆☆☆ | ★★★★★ | Alta velocità, cross-platform, integrazione Go | Gratis |

| Portia | ★★★★☆ | ★★☆☆☆ | ★★★☆☆ | Spiders Scrapy visuali, non programmatori | Gratis |

Come scegliere lo strumento Python giusto per te

Quindi, quale strumento scegliere? Ecco la mia guida lampo:

- Non programmatori o utenti business: Parti da , o . Sono veloci, visuali e non richiedono codice.

- Sviluppatori, progetti su larga scala: Scegli o se ti servono crawler robusti e ripetibili.

- Siti dinamici/ricchi di JavaScript: Usa o uno strumento visuale con automazione browser.

- Estrazione rapida da pagine statiche: + resta il modo più veloce per iniziare.

- Prestazioni o cross-platform: Valuta per microservizi in Go, oppure usalo insieme a Python per il massimo.

- Prototipazione visuale per Scrapy: è un ottimo ponte tra non programmatori e sviluppatori.

Il mio consiglio: Parti dallo strumento più semplice che risponde alle tue esigenze. Se non sei sicuro, prova per un risultato immediato, oppure lancia un progetto Scrapy se punti alla scalabilità.

Ricorda: il miglior strumento è quello che ti fa ottenere i dati che ti servono—in modo affidabile, efficiente e senza farti venire voglia di lanciare il computer dalla finestra.

Domande frequenti

1. Perché Python è così popolare per l’estrazione dati dal web?

Python spopola in questo campo grazie alla sua sintassi semplice, all’enorme ecosistema di librerie e a una community super attiva. ), rendendolo la scelta ideale sia per chi inizia che per i professionisti.

2. Qual è la migliore libreria Python per estrarre dati da siti dinamici (JavaScript)?

Per siti dinamici, è la scelta classica, perché controlla un vero browser. Per soluzioni no-code, anche , e gestiscono pagine ricche di JavaScript.

3. Come scegliere tra Scrapy e Beautiful Soup?

Usa per progetti rapidi e semplici o se stai imparando. Scegli per crawl automatizzati su larga scala, progetti multi-pagina o quando servono pipeline robuste e pianificazione.

4. Posso usare Thunderbit nel mio workflow Python?

Certo che sì. ti permette di esportare i dati in CSV, Excel o Google Sheets, che puoi poi importare nei tuoi script Python per analisi o elaborazioni successive.

5. Qual è il modo più semplice per iniziare con l’estrazione dati se non sono uno sviluppatore?

Prova , o . Questi strumenti ti permettono di estrarre dati in modo visuale—senza scrivere codice. Per altre guide e consigli, visita il .

Buon scraping—che i tuoi dati siano sempre puliti, ordinati e pronti all’uso con un click.

Scopri di più