Gestire un sito web nel 2025 è un po’ come fare una maratona a ostacoli: oggi sistemi i link che non funzionano, domani ti tocca organizzare una migrazione dei contenuti, e intanto ti chiedi come mai Google abbia ancora in giro la tua vecchia pagina “test” del 2019. Ci sono passato anch’io, più volte di quanto vorrei ammettere. Se ti riconosci, probabilmente anche tu hai digitato su Google “miglior website crawler gratuito” nel cuore della notte, sperando di trovare uno strumento che funzioni davvero (e che non ti costringa a diventare un programmatore).

Ma c’è una cosa da sapere: non tutti gli strumenti di website crawler sono uguali e—spoiler—molti fanno confusione tra “web crawler” e “web scraper”, come se fossero la stessa cosa. Non lo sono. In questa guida ti spiego la differenza, perché oggi i crawler online sono più utili che mai, e ti presento i 10 migliori strumenti gratuiti di website crawler per il 2025. E visto che sono co-fondatore di , ti mostrerò anche quando conviene saltare la parte tecnica e affidarsi a una soluzione AI che ti consegna subito i dati che ti servono. Pronto? Partiamo!

Cos’è un Website Crawler? Le Basi da Sapere

Facciamo subito chiarezza: un website crawler non è la stessa cosa di un web scraper. Lo so, spesso i termini vengono usati come sinonimi, ma in realtà fanno lavori diversi. Immagina il crawler come il cartografo del tuo sito: esplora ogni angolo, segue tutti i link e crea una mappa di tutte le pagine. Il suo compito è la scoperta: trovare URL, mappare la struttura del sito e indicizzare i contenuti. È quello che fanno i motori di ricerca come Google con i loro bot, e che gli strumenti SEO usano per analizzare la salute del tuo sito ().

Un web scraper, invece, è come un minatore di dati. Non gli interessa la mappa completa: vuole solo estrarre l’oro, cioè prezzi, nomi di aziende, recensioni, email e così via. Gli scraper estraggono campi specifici dalle pagine che i crawler hanno trovato ().

Un esempio pratico:

- Crawler: È come chi percorre ogni corsia di un supermercato e fa l’inventario di tutti i prodotti.

- Scraper: È chi va dritto allo scaffale del caffè e annota solo i prezzi delle miscele biologiche.

Perché è importante? Perché se vuoi solo trovare tutte le pagine del tuo sito (ad esempio per un audit SEO), ti serve un crawler. Se invece vuoi estrarre tutti i prezzi dei prodotti dal sito di un concorrente, ti serve uno scraper—o meglio ancora, uno strumento che faccia entrambe le cose.

Perché Usare un Web Crawler Online? I Vantaggi per il Tuo Business

Perché dovresti affidarti a un web crawler online nel 2025? Il web continua a espandersi. Oltre il per ottimizzare i propri siti, e alcuni strumenti SEO arrivano a scansionare .

Ecco cosa possono fare i crawler per te:

- Audit SEO: Trovare link rotti, titoli mancanti, contenuti duplicati, pagine orfane e molto altro ().

- Controllo Link & QA: Scovare errori 404 e loop di redirect prima che li trovino i tuoi utenti ().

- Generazione Sitemap: Creare automaticamente sitemap XML per i motori di ricerca e la pianificazione ().

- Inventario dei Contenuti: Elencare tutte le pagine, la loro gerarchia e i metadati.

- Conformità & Accessibilità: Verificare ogni pagina per accessibilità, SEO e requisiti legali ().

- Performance & Sicurezza: Segnalare pagine lente, immagini troppo pesanti o problemi di sicurezza ().

- Dati per AI & Analisi: Fornire dati strutturati ad analytics o strumenti di intelligenza artificiale ().

Ecco una tabella che collega i casi d’uso ai ruoli aziendali:

| Caso d’Uso | Ideale per | Beneficio / Risultato |

|---|---|---|

| SEO & Audit Sito | Marketing, SEO, Piccole Imprese | Individuare problemi tecnici, ottimizzare la struttura, migliorare il ranking |

| Inventario Contenuti & QA | Content Manager, Webmaster | Audit o migrazione dei contenuti, trovare link/immagini rotti |

| Lead Generation (Scraping) | Sales, Business Development | Automatizzare la ricerca di contatti, popolare il CRM con nuovi lead |

| Analisi Competitiva | E-commerce, Product Manager | Monitorare prezzi, nuovi prodotti, cambi di stock dei concorrenti |

| Sitemap & Clonazione Struttura | Sviluppatori, DevOps, Consulenti | Clonare la struttura del sito per redesign o backup |

| Aggregazione Contenuti | Ricercatori, Media, Analisti | Raccogliere dati da più siti per analisi o trend |

| Ricerca di Mercato | Analisti, Team AI | Raccogliere grandi dataset per analisi o training AI |

()

Come Abbiamo Selezionato i Migliori Website Crawler Gratuiti

Ho passato nottate intere (e bevuto litri di caffè) a testare crawler, leggere documentazioni e fare prove pratiche. Ecco i criteri che ho usato:

- Capacità Tecnica: Gestisce siti moderni (JavaScript, login, contenuti dinamici)?

- Facilità d’Uso: È adatto anche a chi non è tecnico, o serve saper usare la riga di comando?

- Limiti del Piano Gratuito: È davvero gratis o solo una demo?

- Accessibilità Online: È uno strumento cloud, un’app desktop o una libreria di codice?

- Funzionalità Uniche: Offre qualcosa di speciale—come estrazione AI, sitemap visuali o crawling su eventi?

Ho testato ogni strumento, letto i feedback degli utenti e confrontato le funzionalità. Se uno strumento mi ha fatto venire voglia di lanciare il portatile dalla finestra, non è entrato in classifica.

Tabella di Confronto Rapido: I 10 Migliori Website Crawler Gratuiti

| Strumento & Tipo | Funzionalità Principali | Miglior Utilizzo | Competenze Tecniche | Dettagli Piano Gratuito |

|---|---|---|---|---|

| BrightData (Cloud/API) | Crawling enterprise, proxy, rendering JS, risoluzione CAPTCHA | Raccolta dati su larga scala | Utile avere competenze tecniche | Prova gratuita: 3 scraper, 100 record ciascuno (circa 300 record totali) |

| Crawlbase (Cloud/API) | API crawling, anti-bot, proxy, rendering JS | Dev che necessitano di crawling backend | Integrazione API | Gratis: ~5.000 chiamate API per 7 giorni, poi 1.000/mese |

| ScraperAPI (Cloud/API) | Rotazione proxy, rendering JS, crawl asincrono, endpoint preconfigurati | Dev, monitoraggio prezzi, dati SEO | Setup minimo | Gratis: 5.000 chiamate API per 7 giorni, poi 1.000/mese |

| Diffbot Crawlbot (Cloud) | Crawl + estrazione AI, knowledge graph, rendering JS | Dati strutturati su larga scala, AI/ML | Integrazione API | Gratis: 10.000 crediti/mese (circa 10k pagine) |

| Screaming Frog (Desktop) | Audit SEO, analisi link/meta, sitemap, estrazione custom | Audit SEO, gestori siti | App desktop, GUI | Gratis: 500 URL per crawl, solo funzioni base |

| SiteOne Crawler (Desktop) | SEO, performance, accessibilità, sicurezza, export offline, Markdown | Dev, QA, migrazione, documentazione | Desktop/CLI, GUI | Gratis & open-source, 1.000 URL nel report GUI (configurabile) |

| Crawljax (Java, OpenSrc) | Crawl su eventi per siti JS, export statico | Dev, QA per web app dinamiche | Java, CLI/config | Gratis & open-source, senza limiti |

| Apache Nutch (Java, OpenSrc) | Distribuito, plugin, integrazione Hadoop, search custom | Motori di ricerca custom, crawl su larga scala | Java, riga di comando | Gratis & open-source, solo costi infrastruttura |

| YaCy (Java, OpenSrc) | Crawl & search peer-to-peer, privacy, indicizzazione web/intranet | Search privato, decentralizzazione | Java, UI browser | Gratis & open-source, senza limiti |

| PowerMapper (Desktop/SaaS) | Sitemap visuali, accessibilità, QA, compatibilità browser | Agenzie, QA, mappatura visuale | GUI, facile | Prova gratuita: 30 giorni, 100 pagine (desktop) o 10 pagine (online) per scansione |

BrightData: Website Crawler Cloud per Grandi Volumi

BrightData è il gigante del web crawling. Offre una piattaforma cloud con una rete di proxy enorme, rendering JavaScript, risoluzione CAPTCHA e un IDE per crawl personalizzati. Se devi raccogliere dati su larga scala—tipo monitorare centinaia di siti e-commerce per i prezzi—l’infrastruttura di BrightData è imbattibile ().

Punti forti:

- Gestisce siti complessi con misure anti-bot

- Scalabile per esigenze enterprise

- Template già pronti per i siti più comuni

Limiti:

- Nessun piano gratuito permanente (solo prova: 3 scraper, 100 record ciascuno)

- Troppo avanzato per semplici audit

- Serve un po’ di pratica se non sei tecnico

Se ti serve scalare il crawling, BrightData è come noleggiare una Formula 1. Ma dopo la prova gratuita, non aspettarti che sia gratis ().

Crawlbase: Web Crawler Gratuito via API per Sviluppatori

Crawlbase (ex ProxyCrawl) è pensato per chi vuole automatizzare tutto via API. Tu mandi una richiesta con l’URL, lui ti restituisce l’HTML gestendo proxy, geolocalizzazione e CAPTCHA in automatico ().

Punti forti:

- Tassi di successo altissimi (oltre il 99%)

- Gestisce siti pieni di JavaScript

- Perfetto per integrare in app o workflow personalizzati

Limiti:

- Richiede integrazione API o SDK

- Piano gratuito: ~5.000 chiamate API per 7 giorni, poi 1.000/mese

Se sei uno sviluppatore e vuoi scalare il crawling (e magari anche scraping) senza gestire proxy, Crawlbase è una scelta solida ().

ScraperAPI: Web Crawling Dinamico Semplificato

ScraperAPI è l’API “pensaci tu”. Tu dai l’URL, lui si occupa di proxy, browser headless, misure anti-bot e ti restituisce l’HTML (o dati strutturati per alcuni siti). È perfetto per pagine dinamiche e offre un piano gratuito generoso ().

Punti forti:

- Facilissimo per sviluppatori (basta una chiamata API)

- Gestisce CAPTCHA, ban IP, JavaScript

- Gratis: 5.000 chiamate API per 7 giorni, poi 1.000/mese

Limiti:

- Nessun report visuale del crawl

- Devi scrivere tu la logica per seguire i link

Se vuoi integrare il crawling nel tuo codice in pochi minuti, ScraperAPI è la soluzione ideale.

Diffbot Crawlbot: Scoperta Automatica della Struttura del Sito

Diffbot Crawlbot porta l’intelligenza artificiale nel crawling. Non si limita a scansionare: classifica le pagine e ne estrae dati strutturati (articoli, prodotti, eventi, ecc.) in formato JSON. È come avere uno stagista robot che capisce davvero cosa legge ().

Punti forti:

- Estrazione AI, non solo crawling

- Gestisce JavaScript e contenuti dinamici

- Gratis: 10.000 crediti/mese (circa 10k pagine)

Limiti:

- Pensato per sviluppatori (integrazione API)

- Non è uno strumento SEO visuale—più adatto a progetti di dati

Se ti servono dati strutturati su larga scala, soprattutto per AI o analytics, Diffbot è una potenza.

Screaming Frog: SEO Crawler Desktop Gratuito

Screaming Frog è il classico crawler desktop per audit SEO. Scansiona fino a 500 URL per volta (versione gratuita) e ti mostra tutto: link rotti, meta tag, contenuti duplicati, sitemap e altro ().

Punti forti:

- Veloce, completo e affidabile nel mondo SEO

- Nessuna programmazione richiesta: basta inserire l’URL e partire

- Gratis fino a 500 URL per scansione

Limiti:

- Solo desktop (niente versione cloud)

- Funzioni avanzate (rendering JS, pianificazione) solo a pagamento

Se fai SEO seriamente, Screaming Frog è indispensabile—ma non aspettarti di scansionare gratis siti da 10.000 pagine.

SiteOne Crawler: Esportazione Statica e Documentazione

SiteOne Crawler è il coltellino svizzero per audit tecnici. Open-source, multipiattaforma, può scansionare, analizzare e persino esportare il sito in Markdown per documentazione o uso offline ().

Punti forti:

- Copre SEO, performance, accessibilità, sicurezza

- Esporta siti per archiviazione o migrazione

- Gratis & open-source, senza limiti d’uso

Limiti:

- Più tecnico rispetto ad altri strumenti GUI

- Report GUI limitato a 1.000 URL di default (configurabile)

Se sei uno sviluppatore, QA o consulente che vuole analisi approfondite (e ami l’open source), SiteOne è una chicca nascosta.

Crawljax: Web Crawler Open Source per Pagine Dinamiche

Crawljax è uno specialista: pensato per scansionare web app moderne ricche di JavaScript simulando interazioni utente (click, form, ecc.). È event-driven e può anche esportare una versione statica di un sito dinamico ().

Punti forti:

- Insuperabile per SPA e siti AJAX

- Open-source ed estendibile

- Nessun limite d’uso

Limiti:

- Richiede Java e un po’ di programmazione/configurazione

- Non adatto a utenti non tecnici

Se devi scansionare un’app React o Angular come farebbe un utente reale, Crawljax è la scelta giusta.

Apache Nutch: Website Crawler Distribuito e Scalabile

Apache Nutch è il decano dei crawler open-source. Progettato per crawl distribuiti su larga scala—ideale per costruire un motore di ricerca o indicizzare milioni di pagine ().

Punti forti:

- Scala fino a miliardi di pagine con Hadoop

- Altamente configurabile ed estendibile

- Gratis & open-source

Limiti:

- Curva di apprendimento ripida (Java, riga di comando, configurazioni)

- Non adatto a siti piccoli o utenti occasionali

Se vuoi scansionare il web su larga scala e non temi la riga di comando, Nutch fa per te.

YaCy: Web Crawler Peer-to-Peer e Motore di Ricerca

YaCy è un crawler e motore di ricerca decentralizzato. Ogni istanza scansiona e indicizza siti, e puoi unirti a una rete peer-to-peer per condividere indici con altri ().

Punti forti:

- Focus sulla privacy, nessun server centrale

- Ottimo per search privati o intranet

- Gratis & open-source

Limiti:

- I risultati dipendono dalla copertura della rete

- Richiede un po’ di setup (Java, UI browser)

Se ti interessa la decentralizzazione o vuoi un motore di ricerca personale, YaCy è un’opzione interessante.

PowerMapper: Generatore di Sitemap Visuali per UX e QA

PowerMapper punta tutto sulla visualizzazione della struttura del sito. Scansiona il sito e genera sitemap interattive, controllando anche accessibilità, compatibilità browser e aspetti SEO di base ().

Punti forti:

- Sitemap visuali perfette per agenzie e designer

- Controlla accessibilità e conformità

- Interfaccia semplice, nessuna competenza tecnica richiesta

Limiti:

- Solo prova gratuita (30 giorni, 100 pagine desktop/10 pagine online per scansione)

- Versione completa a pagamento

Se devi presentare una mappa del sito a un cliente o verificare la conformità, PowerMapper è uno strumento pratico.

Come Scegliere il Website Crawler Gratuito Giusto per Te

Con così tante opzioni, come scegliere? Ecco una guida rapida:

- Per audit SEO: Screaming Frog (siti piccoli), PowerMapper (visuale), SiteOne (analisi approfondite)

- Per web app dinamiche: Crawljax

- Per crawl su larga scala o search custom: Apache Nutch, YaCy

- Per sviluppatori che vogliono API: Crawlbase, ScraperAPI, Diffbot

- Per documentazione o archiviazione: SiteOne Crawler

- Per soluzioni enterprise con prova gratuita: BrightData, Diffbot

Fattori chiave da valutare:

- Scalabilità: Quanto è grande il tuo sito o il progetto di crawling?

- Facilità d’uso: Preferisci un’interfaccia semplice o ti trovi a tuo agio con il codice?

- Esportazione dati: Ti serve CSV, JSON o integrazione con altri strumenti?

- Supporto: Esiste una community o documentazione se resti bloccato?

Quando il Web Crawling incontra il Web Scraping: Perché Thunderbit è la Scelta Furba

La verità è che la maggior parte delle persone non scansiona siti solo per avere una bella mappa. L’obiettivo reale è quasi sempre ottenere dati strutturati—che siano elenchi di prodotti, contatti o inventari di contenuti. Qui entra in gioco .

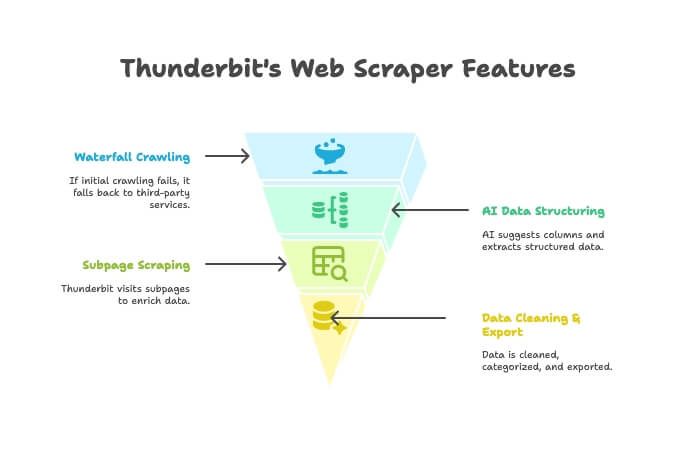

Thunderbit non è solo un crawler o uno scraper: è un’estensione Chrome AI che unisce entrambe le funzioni. Ecco come funziona:

- AI Crawler: Thunderbit esplora il sito come un vero crawler.

- Crawling a Cascata: Se il motore di Thunderbit non riesce a raggiungere una pagina (ad esempio per barriere anti-bot), passa automaticamente a servizi di crawling esterni—senza configurazioni manuali.

- AI per la Strutturazione Dati: Una volta ottenuto l’HTML, l’AI di Thunderbit suggerisce le colonne giuste ed estrae dati strutturati (nomi, prezzi, email, ecc.) senza che tu debba scrivere selettori.

- Scraping delle Sottopagine: Ti servono dettagli da ogni pagina prodotto? Thunderbit visita automaticamente ogni sottopagina e arricchisce la tua tabella.

- Pulizia & Esportazione Dati: Può riassumere, categorizzare, tradurre ed esportare i dati su Excel, Google Sheets, Airtable o Notion con un click.

- Semplicità No-Code: Se sai usare un browser, sai usare Thunderbit. Niente codice, niente proxy, niente stress.

Quando conviene usare Thunderbit invece di un crawler tradizionale?

- Quando vuoi ottenere subito un foglio dati pulito e pronto all’uso, non solo una lista di URL.

- Quando vuoi automatizzare tutto il processo (scansione, estrazione, pulizia, esportazione) in un’unica soluzione.

- Quando vuoi risparmiare tempo e fatica.

Puoi e scoprire perché sempre più aziende la scelgono.

Conclusione: Sfrutta il Potenziale dei Website Crawler Gratuiti nel 2025

I website crawler hanno fatto passi da gigante. Che tu sia marketer, sviluppatore o semplicemente vuoi mantenere il tuo sito in salute, esiste uno strumento gratuito (o almeno in prova) adatto a te. Dai colossi enterprise come BrightData e Diffbot, ai gioielli open-source come SiteOne e Crawljax, fino ai mapper visuali come PowerMapper, le opzioni non sono mai state così varie.

Ma se cerchi un modo più intelligente e integrato per passare da “mi serve questo dato” a “ecco il mio foglio Excel”, prova Thunderbit. È pensato per chi vuole risultati concreti, non solo report.

Pronto a iniziare? Scarica uno strumento, lancia una scansione e scopri cosa ti sei perso. E se vuoi passare dal crawling ai dati pronti in due click, .

Per altre guide pratiche e approfondimenti, visita il .

Domande Frequenti

Qual è la differenza tra un website crawler e un web scraper?

Un crawler scopre e mappa tutte le pagine di un sito (come creare un indice). Uno scraper estrae dati specifici (prezzi, email, recensioni) da quelle pagine. I crawler trovano, gli scraper scavano ().

Qual è il miglior web crawler gratuito per chi non è tecnico?

Per siti piccoli e audit SEO, Screaming Frog è molto intuitivo. Per una mappatura visuale, PowerMapper è ottimo (durante la prova). Se vuoi dati strutturati e un’esperienza no-code direttamente dal browser, Thunderbit è la soluzione più semplice.

Ci sono siti che bloccano i web crawler?

Sì—alcuni siti usano robots.txt o sistemi anti-bot (come CAPTCHA o ban IP) per bloccare i crawler. Strumenti come ScraperAPI, Crawlbase e Thunderbit (con crawling a cascata) spesso riescono ad aggirare questi blocchi, ma è sempre importante rispettare le regole del sito ().

I website crawler gratuiti hanno limiti di pagine o funzionalità?

Quasi tutti sì. Ad esempio, la versione gratuita di Screaming Frog è limitata a 500 URL per scansione; la prova di PowerMapper a 100 pagine. Gli strumenti API hanno spesso limiti mensili di crediti. I tool open-source come SiteOne o Crawljax in genere non hanno limiti fissi, ma dipende dalla potenza del tuo computer.

Usare un web crawler è legale e conforme alla privacy?

In generale, scansionare pagine pubbliche è legale, ma controlla sempre i termini d’uso e il robots.txt del sito. Non scansionare mai dati privati o protetti da password senza autorizzazione e fai attenzione alle leggi sulla privacy se estrai dati personali ().