Ti è mai capitato di trovarti davanti a una valanga di pagine web, fogli Excel o PDF e pensare: "Ci sarà pure un modo più furbo per prendere questi dati"? Tranquillo, non sei l’unico. Dopo anni passati a creare strumenti di automazione e a parlare con team aziendali stanchi di copiare e incollare a mano, posso dirti che nel 2025 la mole di dati non strutturati è davvero fuori controllo—l’80–90% dei nuovi dati aziendali è non strutturato, e solo una piccola fetta delle aziende riesce davvero a sfruttarli (). Raccogliere dati manualmente non è solo una noia mortale: costa caro, è pieno di errori e rallenta tutto il lavoro.

Ed è qui che entrano in scena gli estrattori di dati. Che tu sia nelle vendite, nelle operations, nell’eCommerce o nella ricerca, lo strumento giusto ti fa risparmiare ore (o giorni), aumenta la precisione e lascia il tuo team libero di concentrarsi su ciò che conta davvero. Ma con così tante soluzioni in giro—estensioni AI per Chrome, piattaforme no-code, framework per sviluppatori—come si fa a scegliere quella giusta? Ho passato al setaccio i 12 migliori estrattori di dati per il 2025, mettendo in luce punti forti, limiti e casi d’uso ideali. Vediamoli insieme.

Perché le aziende non possono fare a meno degli estrattori di dati

Parliamoci chiaro: il 94% delle aziende è rallentato da attività ripetitive e che fanno perdere un sacco di tempo come l’inserimento manuale dei dati (). E non è solo una questione di tempo—la raccolta manuale dei dati può arrivare a costare 1.500 dollari al mese per ogni dipendente (). Gli estrattori automatizzano tutto il lavoro ripetitivo, permettendoti di:

- Risparmiare fino al 77% del tempo dedicato alla raccolta dati ().

- Aumentare l’efficienza operativa del 40% ().

- Dimezzare (o più) i tempi di elaborazione ().

- Arrivare fino al 99,9% di accuratezza nell’estrazione dei dati dai documenti ().

Il risultato? Decisioni più veloci, dati più affidabili e team più contenti. Che tu debba estrarre lead, monitorare i prezzi dei concorrenti o alimentare strumenti di BI, un buon estrattore è come avere un assistente digitale che non si stanca mai (e non chiede mai ferie).

Come scegliere l’estrattore di dati giusto: i criteri che contano

Non tutti gli estrattori di dati sono uguali. Ecco cosa guardo quando consiglio uno strumento:

- Facilità d’uso: Anche chi non è tecnico riesce a partire subito? C’è l’AI o una guida passo-passo?

- Personalizzazione e flessibilità: Gestisce siti complessi, login o contenuti dinamici? Si può programmare per esigenze avanzate?

- Tipi di dati supportati: Estrae testo, numeri, immagini, email, numeri di telefono, PDF, ecc.?

- Scalabilità e prestazioni: Può gestire migliaia di pagine? Offre scraping cloud o multi-thread?

- Integrazione e automazione: Esporta direttamente su Excel, Google Sheets, Airtable, Notion o via API?

- Prezzo e valore: C’è una versione gratuita? I piani a pagamento sono accessibili?

- Supporto e community: Ci sono guide, tutorial e assistenza veloce?

Ogni team darà più importanza ad alcuni aspetti rispetto ad altri. Ad esempio, chi lavora nelle vendite vorrà semplicità e esportazione rapida, mentre gli sviluppatori cercheranno personalizzazione e API.

Estrattori di dati per eCommerce e ricerche di mercato

I team di eCommerce e ricerca di mercato vivono di dati freschi—monitoraggio prezzi, analisi recensioni, osservazione dei concorrenti. Qui servono strumenti che gestiscono scraping su larga scala, superano i blocchi anti-bot e permettono estrazioni automatiche.

- : Famoso per l’interfaccia no-code e centinaia di template già pronti per Amazon, eBay e altri. Perfetto per monitorare prezzi e recensioni.

- : Si concentra sull’integrazione dei dati web nei tool di BI, con funzioni di pianificazione e rilevamento cambiamenti. Ideale per chi ha bisogno di flussi dati continui.

- : Livello enterprise, con automazione dei flussi e trasformazione dati. Usato dai grandi retailer per intelligence competitiva e monitoraggio prezzi.

Questi strumenti sono pensati per la scalabilità e sanno come aggirare le difese anti-scraping dei principali siti eCommerce.

Estrattori di dati per team tecnici e flussi personalizzati

Se hai sviluppatori in squadra (o te la cavi con un po’ di codice), ti servono strumenti super flessibili:

- : Il top per lo scraping in Python. Open-source, personalizzabile e perfetto per progetti su larga scala. Ideale per crawler su misura o integrazione in app.

- : Costruttore visuale di flussi che gestisce siti dinamici e complessi. Supporta logica condizionale, JS personalizzato e API.

- : Piattaforma cloud per eseguire script di scraping personalizzati ("Actors") in JavaScript o Python. Ottima per automatizzare flussi, browser headless e scalabilità cloud.

Consiglio questi strumenti quando serve estrarre dati da siti complessi, automatizzare processi multi-step o creare soluzioni che vanno oltre il semplice point-and-click.

Estrattori di dati per integrazione e automazione dei flussi

Alcuni team vogliono più dei semplici dati grezzi—desiderano automatizzare tutta la pipeline, dall’estrazione all’analisi:

- : Come già detto, è fortissimo nell’integrare dati web in dashboard di analytics e BI, con pianificazione e API.

- : Pensato per l’automazione end-to-end, inclusa pulizia, trasformazione e integrazione con CRM, database e altro.

- : Piattaforma enterprise con scripting, gestione errori e integrazioni avanzate. Usata da grandi aziende per aggregazione dati critica.

Se il tuo flusso prevede più passaggi o vuoi che i dati finiscano direttamente nei sistemi aziendali, questi sono gli estrattori da tenere d’occhio.

Tabella comparativa: i 12 migliori estrattori di dati a confronto

Ecco una panoramica per aiutarti a scegliere:

| Nome Strumento | Facilità d’uso | Caso d’uso ideale | Prezzo | Personalizzazione | Tipi di dati supportati |

|---|---|---|---|---|---|

| Thunderbit | ⭐ Facilissimo | Tutti i settori, non tecnici | Gratis & a pagamento | Prompt AI low-code | Testo, Numeri, Date, URL, Email, Telefono, Immagini, PDF |

| Octoparse | 🙂 Medio | eCommerce, ricerche mercato | Gratis & a pagamento | Alta (visuale, regex) | Testo, Numeri, URL, Immagini |

| ParseHub | 🙂 Medio | Siti dinamici, utenti tech | A pagamento | Alta (JS, logica) | Testo, Numeri, URL, Immagini |

| Import.io | 😀 Facile | Integrazione dati, BI | A pagamento (Enterprise) | Media | Testo, Tabelle, Liste |

| Scrapy | 😐 Difficile | Dev custom, larga scala | Gratis (Open-source) | Altissima (codice) | Qualsiasi (definito da dev) |

| Apify | 😐 Difficile | Automazione flussi, dev | Gratis & a pagamento | Altissima (codice) | Qualsiasi contenuto web |

| Dexi.io | 🙂 Medio | Enterprise, workflow | A pagamento (Enterprise) | Alta (visuale, script) | Testo, Immagini, File |

| WebHarvy | 😀 Facile | Piccole aziende, siti statici | Licenza una tantum | Bassa-media | Testo, Numeri, URL, Immagini |

| Data Miner | 😀 Facile | Web-to-sheet veloce, vendite | Gratis & a pagamento | Media (ricette) | Testo, Tabelle, Liste |

| Visual Web Ripper | 🙂 Medio | Statici grandi, logica complessa | Licenza una tantum | Alta (template, API) | Testo, Immagini, File |

| Helium Scraper | 🙂 Medio | Logica custom, dati relazionali | Licenza una tantum | Alta (JS, SQL) | Testo, URL, Immagini, File |

| Content Grabber | 🙂 Medio | Enterprise, automazione | A pagamento (Enterprise) | Altissima (scripting) | Qualsiasi contenuto, export strutturato |

Legenda: 😀 Facile (adatto a tutti), 🙂 Medio (serve un po’ di pratica), 😐 Difficile (serve programmare)

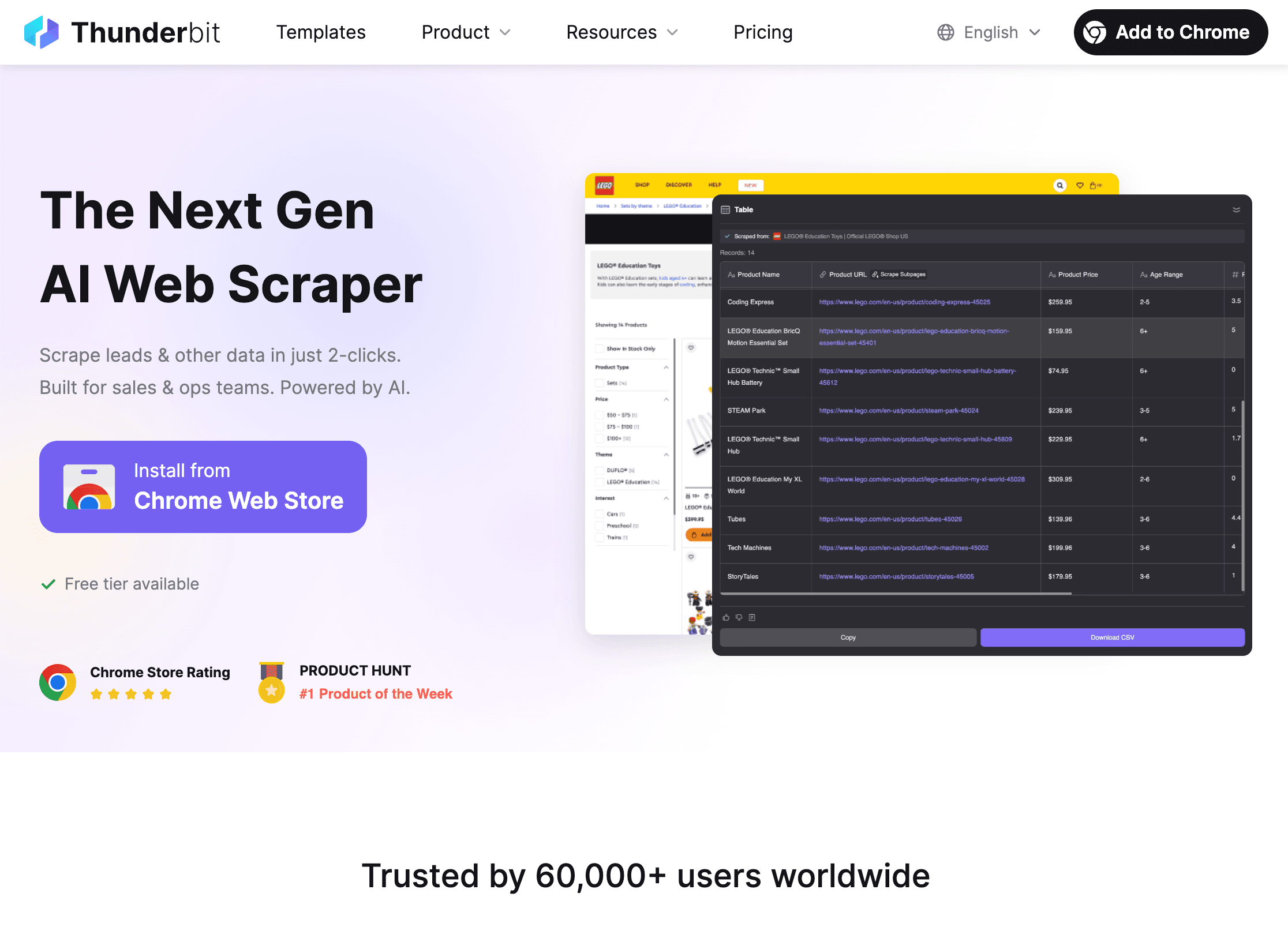

1. Thunderbit

è la mia prima scelta per chi vuole efficienza senza complicazioni, anche senza saper programmare. Come , è pensata per utenti business—vendite, operations, immobiliare, eCommerce—che vogliono solo i dati, senza stress.

è la mia prima scelta per chi vuole efficienza senza complicazioni, anche senza saper programmare. Come , è pensata per utenti business—vendite, operations, immobiliare, eCommerce—che vogliono solo i dati, senza stress.

Funzionalità principali:

- AI Suggerisci Colonne: Un click e l’AI di Thunderbit legge la pagina e ti propone i campi migliori da estrarre—niente configurazioni manuali.

- Estrazione in 2 click: Conferma i campi, premi “Estrai” e hai finito. È così semplice che la userebbe anche mia madre (che mi chiama ancora per il Wi-Fi).

- Estrazione da sottopagine: Vuoi più dettagli? Thunderbit può visitare automaticamente ogni sottopagina (come pagine prodotto o profili) e arricchire la tabella.

- Esportazione gratuita dei dati: Invia i risultati direttamente su Excel, Google Sheets, Airtable o Notion—senza costi extra.

- Estrazione email, telefono e immagini con un click: Perfetto per generare lead o raccogliere contatti da qualsiasi sito.

- Scraping cloud o da browser: Scegli tra scraping cloud veloce per siti pubblici o modalità browser per pagine con login.

- Supporto per 34 lingue: Ideale per team internazionali.

Pro: Facilissimo, senza codice, gestisce dati non strutturati e si adatta automaticamente ai cambiamenti dei siti. Piano gratuito per piccoli lavori, prezzi accessibili per esigenze più grandi.

Contro: Meno personalizzabile rispetto agli strumenti per sviluppatori su siti molto complessi. Prezzi a crediti per volumi elevati.

Ideale per: Team vendite, operations eCommerce, agenti immobiliari e chiunque voglia passare da “Mi serve questo dato” a “Ecco il mio foglio Excel” in meno di cinque minuti. .

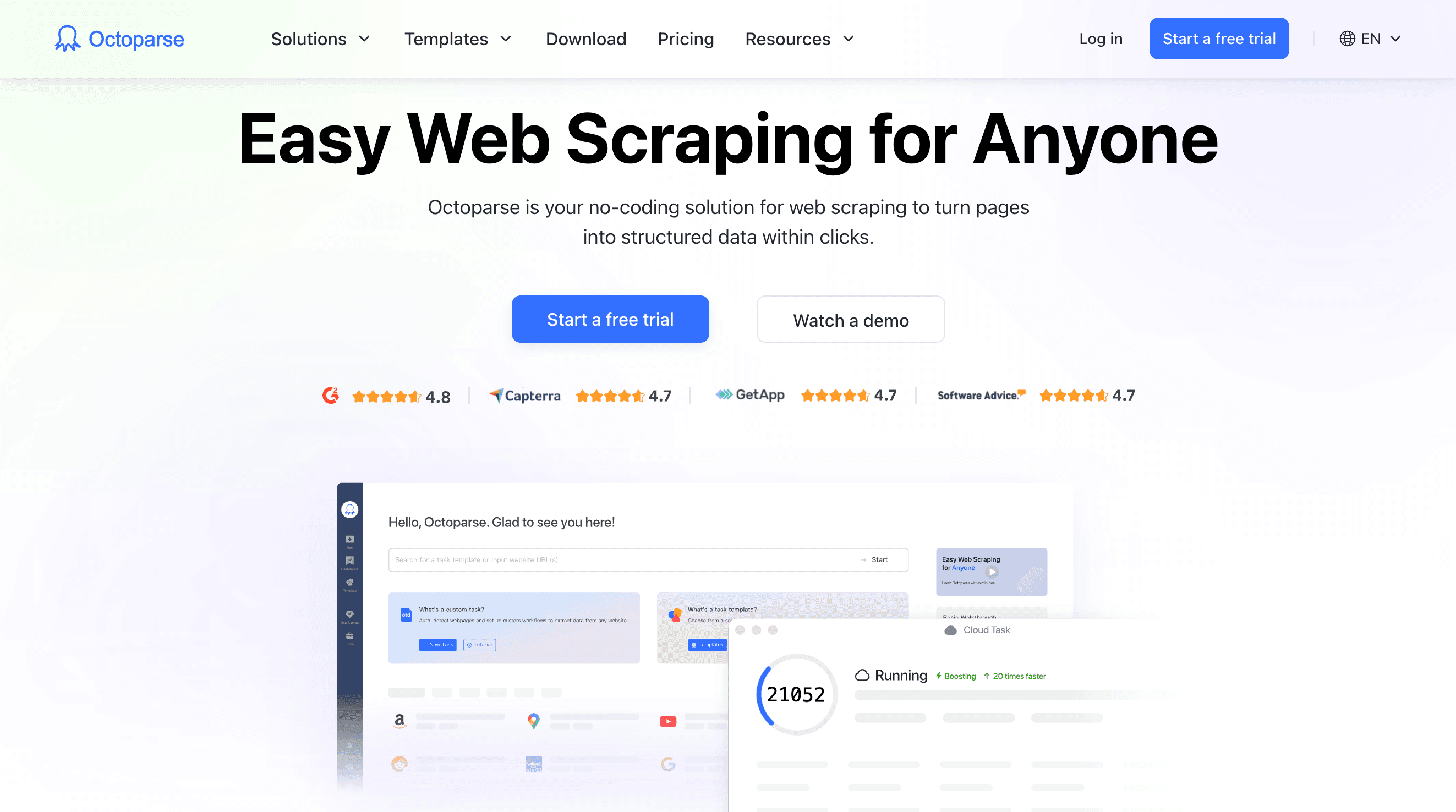

2. Octoparse

è una soluzione potente per team di eCommerce e ricerca di mercato. È un’app desktop no-code (Windows) con builder visuale e centinaia di template già pronti per siti come Amazon, eBay e Zillow.

è una soluzione potente per team di eCommerce e ricerca di mercato. È un’app desktop no-code (Windows) con builder visuale e centinaia di template già pronti per siti come Amazon, eBay e Zillow.

Funzionalità principali:

- Interfaccia point-and-click: Crea “task” di scraping cliccando sugli elementi della pagina.

- Scraping cloud e pianificazione: I piani a pagamento permettono di eseguire lavori nel cloud e pianificare estrazioni regolari.

- Rotazione IP e anti-bot: Gestisce siti che bloccano gli scraper, con proxy e soluzioni captcha integrate.

- Libreria di template: Oltre 500 template pronti per i siti più comuni.

- Scraping multi-livello e paginato: Gestisce navigazione complessa e estrazione da pagine di dettaglio.

Pro: Ottimo per monitoraggio prezzi su larga scala, analisi recensioni e controllo eCommerce. Nella maggior parte dei casi non serve programmare.

Contro: Solo desktop, può diventare costoso per usi intensivi e richiede pratica per flussi avanzati.

Ideale per: Analisti eCommerce, ricercatori di mercato e chi deve monitorare molti prodotti o concorrenti.

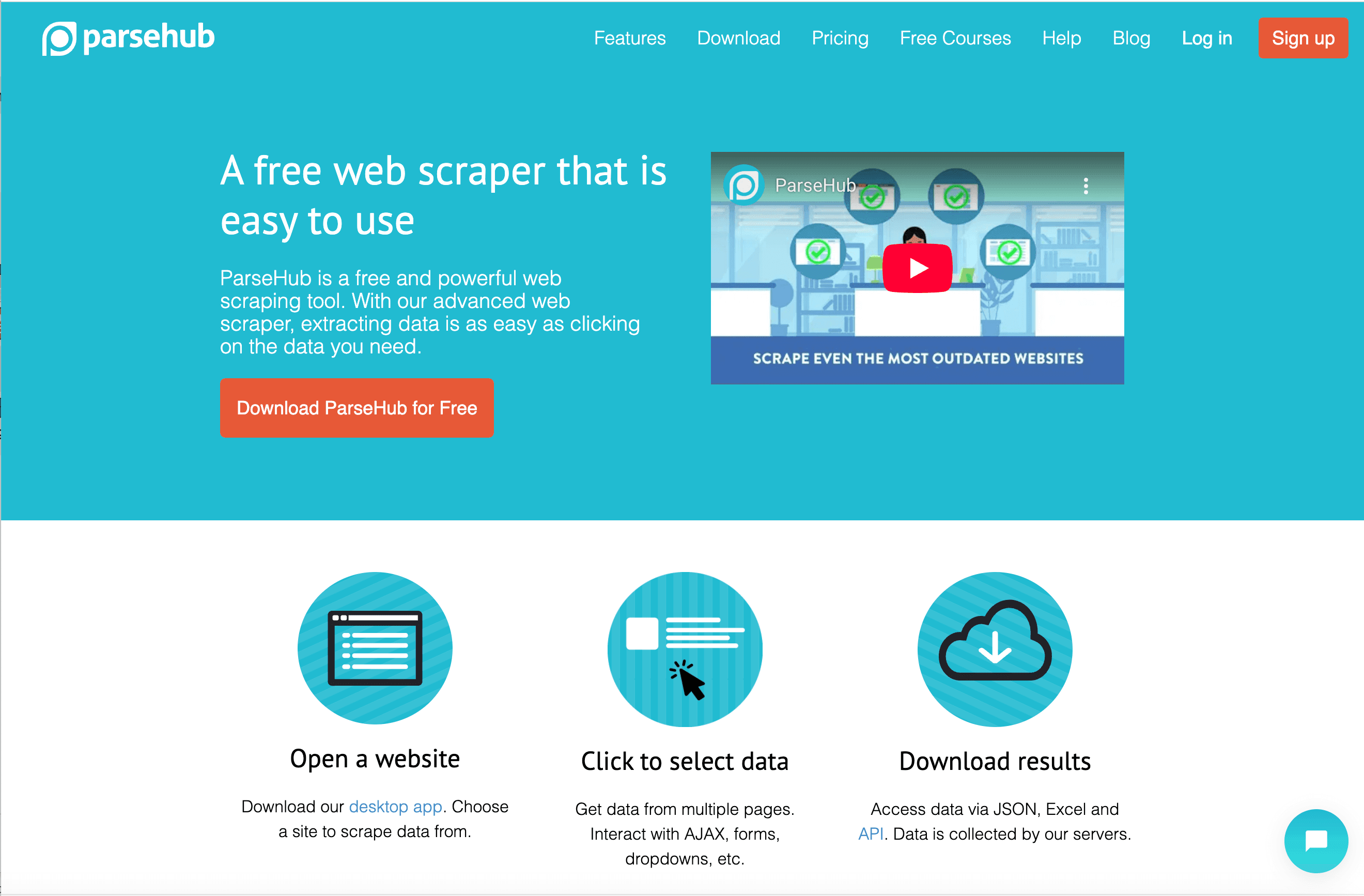

3. ParseHub

è un estrattore visuale flessibile che dà il meglio con siti dinamici e ricchi di JavaScript. È un’app desktop (Windows, Mac, Linux) con builder di workflow che supporta logica condizionale, JS personalizzato e API.

è un estrattore visuale flessibile che dà il meglio con siti dinamici e ricchi di JavaScript. È un’app desktop (Windows, Mac, Linux) con builder di workflow che supporta logica condizionale, JS personalizzato e API.

Funzionalità principali:

- Gestione contenuti dinamici: Funziona con single-page app, AJAX e siti interattivi.

- Workflow e scripting: Crea flussi multi-step, inserisci JS personalizzato e usa regex per perfezionare l’estrazione.

- Esecuzione cloud e locale: Esegui i job sul tuo PC o nel cloud (a pagamento).

- Accesso API: Integra lo scraping nelle tue app o automatizza con webhook.

Pro: Altamente personalizzabile per utenti esperti, gestisce siti complessi e supporta logica avanzata.

Contro: Più lento su grandi volumi, curva di apprendimento media e il cloud costa extra.

Ideale per: Analisti tecnici, sviluppatori o chi deve estrarre dati da siti molto interattivi.

4. Import.io

punta tutto sull’integrazione dei dati web nei flussi di business intelligence. È una piattaforma web con interfaccia point-and-click e forti funzionalità di pianificazione e API.

punta tutto sull’integrazione dei dati web nei flussi di business intelligence. È una piattaforma web con interfaccia point-and-click e forti funzionalità di pianificazione e API.

Funzionalità principali:

- Rilevamento automatico tabelle: Incolla un URL e Import.io cerca di estrarre dati strutturati in automatico.

- Pianificazione e rilevamento cambiamenti: Imposta job ricorrenti e ricevi avvisi quando i dati cambiano.

- Integrazione API: Recupera dati via API o inviali ai tuoi strumenti BI.

- Trasformazione dati: Pulisci e formatta i dati direttamente sulla piattaforma.

Pro: Facile da usare, ottimo per analisti business e forte integrazione con strumenti di analytics.

Contro: Prezzi enterprise, limitato su siti molto interattivi e meno controllo per utenti avanzati.

Ideale per: Team di ricerca di mercato, analisti e operations che necessitano di flussi dati continui.

5. Scrapy

è il framework open-source Python preferito dagli sviluppatori. Se vuoi controllo totale, scalabilità e la possibilità di creare crawler su misura, Scrapy è la scelta giusta.

è il framework open-source Python preferito dagli sviluppatori. Se vuoi controllo totale, scalabilità e la possibilità di creare crawler su misura, Scrapy è la scelta giusta.

Funzionalità principali:

- Crawling asincrono: Veloce, efficiente e pensato per progetti su larga scala.

- Controllo completo via codice: Scrivi spider in Python, personalizza ogni passaggio e integra con qualsiasi sistema.

- Middleware e plugin: Ruota proxy, gestisci login e amplia le funzioni con plugin della community.

- Output strutturato: Esporta in JSON, CSV, database o formati personalizzati.

Pro: Gratuito, flessibile e supportato da una vasta community.

Contro: Richiede conoscenze Python, nessuna interfaccia grafica e la manutenzione è a carico tuo.

Ideale per: Sviluppatori, data engineer e chi integra lo scraping nelle proprie app o pipeline dati.

6. Apify

è una piattaforma cloud per eseguire e condividere script di scraping ("Actors") in JavaScript o Python. È pensata per automazione, concatenamento di workflow e scalabilità cloud.

è una piattaforma cloud per eseguire e condividere script di scraping ("Actors") in JavaScript o Python. È pensata per automazione, concatenamento di workflow e scalabilità cloud.

Funzionalità principali:

- Actors & SDK: Scrivi script personalizzati o usa attori già pronti dall’Apify Store.

- Automazione browser headless: Estrai dati da siti dinamici, gestisci login e automatizza task web.

- Concatenamento workflow: Attiva un attore dopo l’altro, automatizza flussi multi-step.

- API e integrazioni: Collega con Zapier, Make, Google Drive, AWS e altro.

Pro: Potente per sviluppatori, scalabile e ottimo per automatizzare flussi complessi.

Contro: Serve programmare per task custom, prezzi a consumo e curva di apprendimento.

Ideale per: Startup, team di sviluppo e chi ha bisogno di scraping cloud automatizzato su larga scala.

7. Dexi.io

(ex CloudScrape) è una piattaforma enterprise per automatizzare raccolta e integrazione dati. Permette di costruire workflow completi, dall’estrazione alla trasformazione e consegna dei dati.

(ex CloudScrape) è una piattaforma enterprise per automatizzare raccolta e integrazione dati. Permette di costruire workflow completi, dall’estrazione alla trasformazione e consegna dei dati.

Funzionalità principali:

- Designer visuale di robot: Crea workflow multi-step con logica point-and-click.

- Esecuzione cloud e pianificazione: Esegui robot nel cloud, pianifica job regolari e gestisci grandi volumi.

- Elaborazione e integrazione dati: Pulisci, trasforma ed esporta dati verso CRM, database o API.

- Funzionalità enterprise: Gestione utenti, compliance e opzioni on-premise.

Pro: Scalabile, potente per workflow complessi e ottime capacità di integrazione.

Contro: Prezzi enterprise, non adatto ai principianti e richiede formazione per usi avanzati.

Ideale per: Grandi aziende, team di retail intelligence e chi automatizza pipeline dati multi-step.

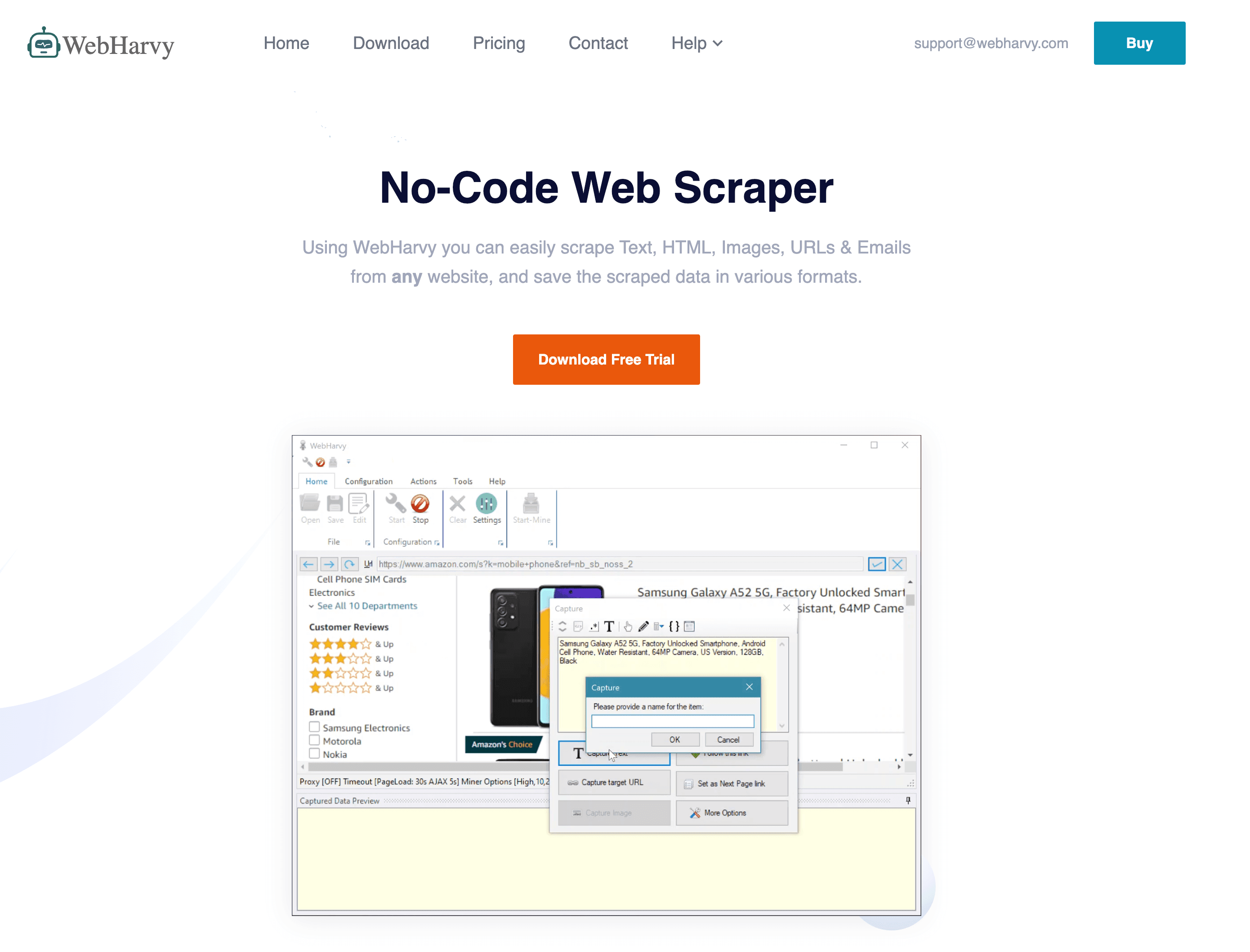

8. WebHarvy

è un estrattore desktop per Windows noto per la semplicità point-and-click e la licenza una tantum.

è un estrattore desktop per Windows noto per la semplicità point-and-click e la licenza una tantum.

Funzionalità principali:

- Selezione visuale: Clicca sugli elementi nel browser integrato per definire i campi.

- Rilevamento automatico pattern: Trova liste e tabelle in automatico.

- Download immagini e file: Estrae immagini e documenti oltre al testo.

- Pianificazione: Automatizza le esecuzioni tramite Windows Task Scheduler.

Pro: Costo una tantum accessibile, facile per siti semplici e funziona offline.

Contro: Fatica con siti ricchi di JavaScript o anti-bot, solo per Windows e personalizzazione limitata.

Ideale per: Piccole aziende, ricercatori e chi cerca uno scraper economico e senza complicazioni per siti statici.

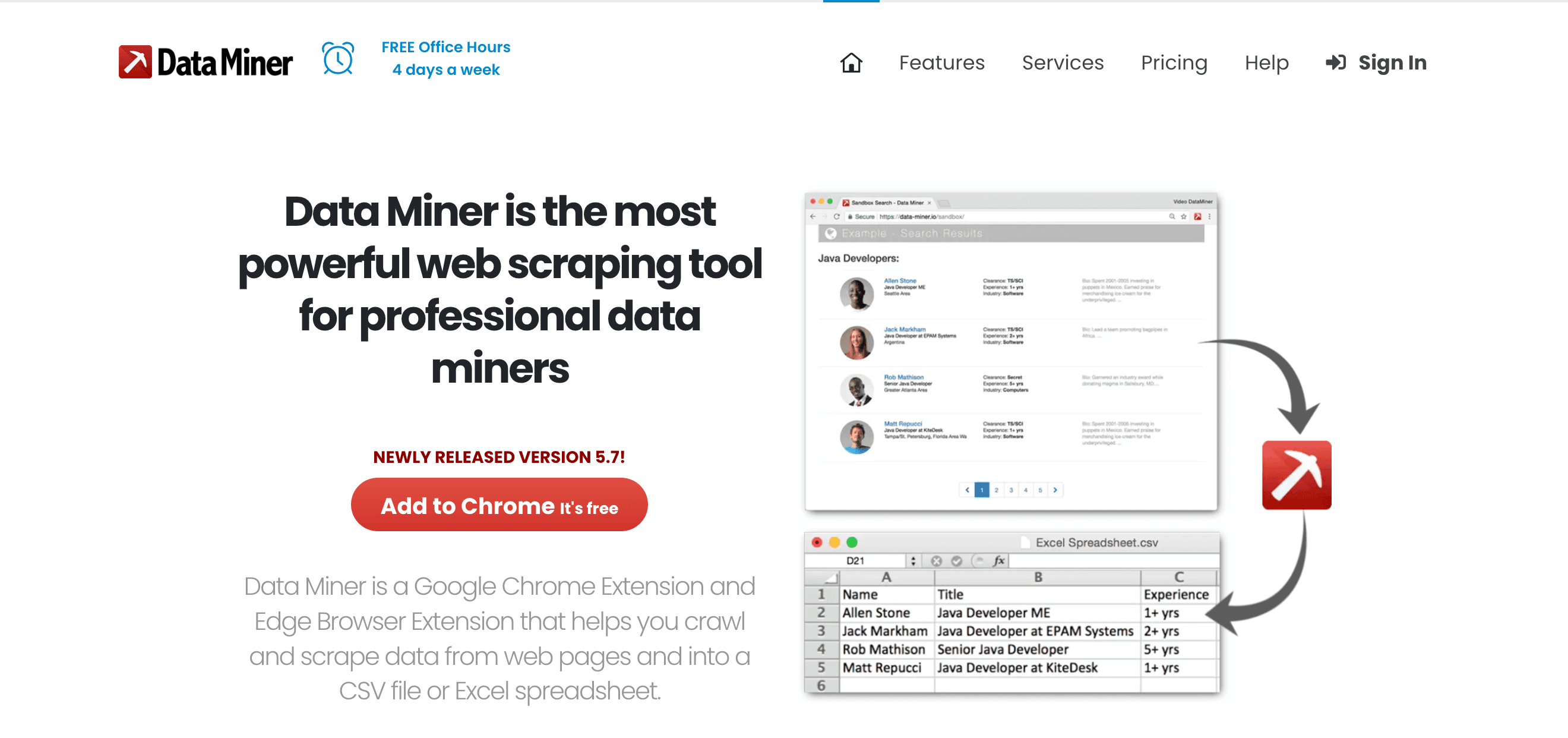

9. Data Miner

è un’estensione Chrome/Edge perfetta per estrazioni rapide e basate su template—ideale per team vendite e operations.

è un’estensione Chrome/Edge perfetta per estrazioni rapide e basate su template—ideale per team vendite e operations.

Funzionalità principali:

- Oltre 60.000 ricette pubbliche: Estrazione con un click per i siti più popolari.

- Builder di ricette point-and-click: Crea regole di estrazione personalizzate.

- Estrazione tabelle istantanea: Cattura tabelle HTML o liste in pochi secondi.

- Esportazione diretta: Invia i dati su Google Sheets, Excel o CSV.

Pro: Veloce, basato su browser, senza codice e ottimo per siti con login.

Contro: Limitato dalla velocità del browser, limiti di pagine nei piani free/premium e non adatto a grandi volumi.

Ideale per: Generazione lead, ricerche rapide e chi vuole un “Esporta in Excel” per il web.

10. Visual Web Ripper

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

è una soluzione desktop completa per estrazione dati su larga scala, con focus su progetti basati su template e automazione.

(https://strapi.thunderbit.com/uploads/helium_1d0161c406.png)

è una soluzione desktop completa per estrazione dati su larga scala, con focus su progetti basati su template e automazione.

Funzionalità principali:

- Sistema di template e progetti: Progetta crawl multi-livello con template.

- Opzioni avanzate: Regex, XPath e strumenti di debug per siti complessi.

- Esportazione su database: Output diretto su SQL, Excel, XML e altro.

- Automazione: Pianifica job e esegui estrazioni multi-thread.

Pro: Potente per siti statici complessi, licenza una tantum e supporta logica avanzata.

Contro: Interfaccia datata, solo per Windows e meno supporto per siti dinamici moderni.

Ideale per: Consulenti, agenzie e utenti esperti che gestiscono progetti di scraping strutturati e su larga scala.

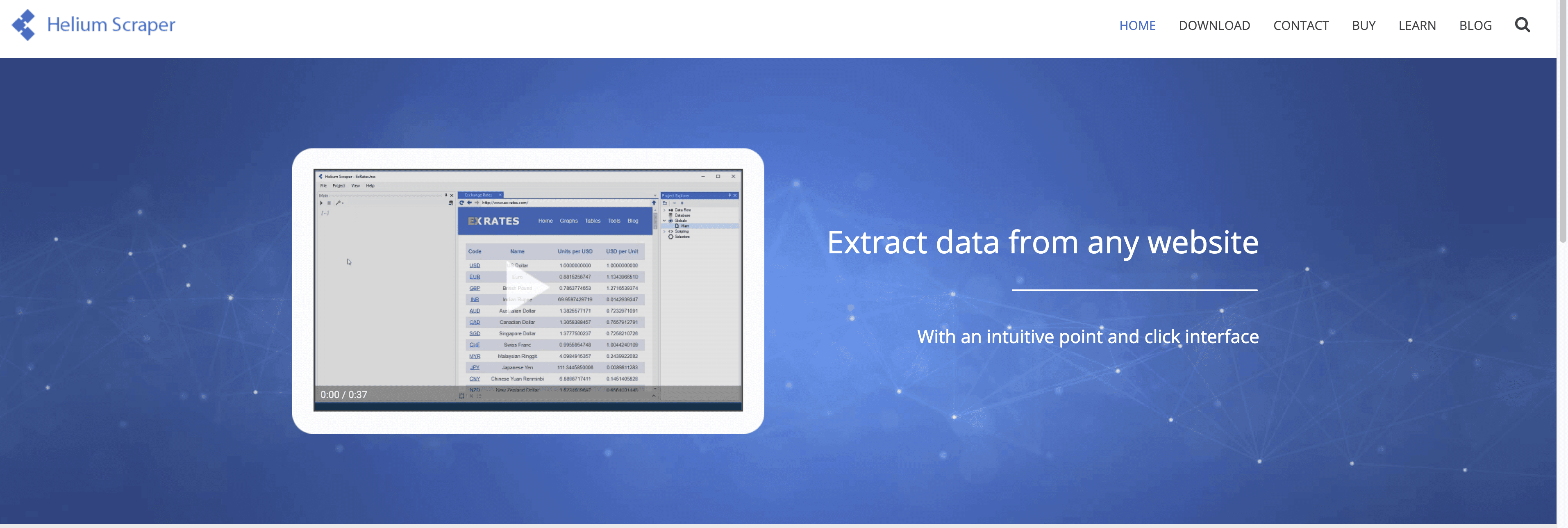

11. Helium Scraper

è un’app Windows che unisce semplicità drag-and-drop a una profonda personalizzazione.

è un’app Windows che unisce semplicità drag-and-drop a una profonda personalizzazione.

Funzionalità principali:

- Modello Kinds & Actions: Definisci pattern visivamente, poi imposta azioni di estrazione.

- Dati multi-livello e relazionali: Output di relazioni padre-figlio, esegui query SQL sui dati estratti.

- Scripting personalizzato: Inserisci JavaScript o SQL per logica avanzata.

- Multi-threading: Estrai più pagine in parallelo per velocità.

Pro: Flessibile, supporta strutture dati complesse e prezzo una tantum conveniente.

Contro: Curva di apprendimento per il concetto di “Kinds”, solo Windows e supporto meno diffuso.

Ideale per: Analisti e appassionati tech che vogliono più potenza dei tool base ma non sono pronti a programmare da zero.

12. Content Grabber

è una piattaforma enterprise per estrazione e integrazione dati su larga scala e in modo automatizzato.

è una piattaforma enterprise per estrazione e integrazione dati su larga scala e in modo automatizzato.

Funzionalità principali:

- Editor visuale agenti: Crea agenti di scraping con point-and-click, poi personalizza in C# o VB.NET.

- Pianificazione e monitoraggio enterprise: Controllo centralizzato, gestione errori e notifiche.

- Deployment on-premise: Mantieni i dati in azienda per la compliance.

- API e integrazione: Esporta su database, API e code di messaggi.

Pro: Estremamente potente, scalabile e pensato per workflow mission-critical.

Contro: Costoso, complesso e adatto a chi ha risorse IT dedicate.

Ideale per: Grandi aziende, fornitori di dati e chi considera l’estrazione dati web un processo core.

Quale estrattore di dati fa per te? Casi d’uso e consigli

- Lead generation per vendite: (AI, esportazione facile), (browser, ricette rapide).

- Monitoraggio eCommerce: (template, pianificazione), (enterprise, integrazione).

- Personalizzazione tecnica: (Python, open-source), (cloud, automazione workflow), (visuale, siti dinamici).

- Integrazione e automazione dati: (workflow BI), (enterprise, on-premise).

- Task rapidi e su piccola scala: (point-and-click, costo una tantum), (drag-and-drop, logica custom).

Consiglio pratico: Quasi tutti gli strumenti offrono prove gratuite—testane un paio sul tuo caso reale prima di scegliere.

Conclusione: Scegli l’estrattore di dati giusto e lavora meglio

I tempi della raccolta dati manuale sono finiti. Con lo strumento giusto puoi automatizzare ore di lavoro ripetitivo, aumentare la precisione e prendere decisioni migliori—che tu sia un founder, un team di vendita o un manager di una grande azienda. La chiave è scegliere lo strumento in base alle tue esigenze, competenze tecniche e budget.

Se vuoi la via più rapida da “Mi serve questo dato” a “È nel mio foglio di calcolo”, è un ottimo punto di partenza. Ma qualunque sia la tua necessità, in questa lista c’è la soluzione per lavorare in modo più smart.

Pronto a rivoluzionare la gestione dei tuoi dati? Prova alcuni di questi estrattori e scopri quanto tempo (e stress) puoi risparmiare.

Domande frequenti

1. Cos’è un estrattore di dati e perché dovrei usarlo?

Un estrattore di dati è uno strumento che automatizza la raccolta di informazioni strutturate da siti web, documenti o database. Ti fa risparmiare tempo, riduce gli errori e ti permette di concentrarti sull’analisi invece che sul copia-incolla manuale.

2. Qual è il miglior estrattore di dati per chi non è tecnico?

si distingue per la configurazione AI in 2 click e i prompt in linguaggio naturale. È pensato per utenti business che vogliono risultati senza codice o configurazioni complesse.

3. Gli estrattori di dati funzionano anche su siti dinamici o ricchi di JavaScript?

Sì—strumenti come , e (con supporto browser headless) sono ottimi per estrarre dati da siti dinamici e interattivi.

4. Come scegliere tra un estrattore gratuito e uno a pagamento?

Gli strumenti gratuiti sono perfetti per lavori occasionali e di piccola entità. Per attività continue, su larga scala o mission-critical, i piani a pagamento offrono più funzioni, limiti più alti e supporto migliore. Parti sempre da una prova gratuita per valutare la soluzione.

5. È legale usare estrattori di dati?

In generale, estrarre dati pubblicamente accessibili è legale, ma controlla sempre i termini d’uso del sito e rispetta le normative sulla privacy. Per dati sensibili o personali, assicurati di essere conforme a regolamenti come il GDPR.

Vuoi altri consigli su web scraping, automazione e produttività? Dai un’occhiata al per approfondimenti, tutorial e novità sull’estrazione dati con l’AI.

Scopri di più