Il web oggi non è più solo un posto dove passare il tempo: ormai è diventato il più grande magazzino di dati che esista, e chiunque – dai commerciali agli analisti di mercato – cerca di sfruttarne ogni angolo. Ma diciamocelo: raccogliere dati online a mano è snervante quasi quanto montare un mobile IKEA senza istruzioni (e con il doppio delle viti che avanzano). Con le aziende sempre più affamate di informazioni aggiornate, prezzi della concorrenza e nuovi lead, la corsa a strumenti affidabili e veloci per l’estrazione dati non è mai stata così accesa. Basti pensare che ormai per prendere decisioni, e il mercato globale dell’estrazione dati è destinato a .

Se sei stufo di copiare e incollare, ti perdi nuove occasioni o vuoi solo vedere cosa può fare l’automazione per te, sei nel posto giusto. Dopo anni passati a sviluppare e testare strumenti di estrazione dati (e sì, guidando il team di ), so bene quanto il tool giusto possa trasformare ore di lavoro manuale in pochi clic. Che tu sia un utente senza competenze tecniche che vuole risultati subito o uno sviluppatore che cerca il massimo controllo, questa classifica dei 10 migliori strumenti di data crawling ti aiuterà a trovare la soluzione perfetta.

Perché Scegliere lo Strumento di Data Crawling Giusto è Fondamentale

La differenza tra un buon estrattore dati e uno mediocre non è solo una questione di comodità: può davvero cambiare le sorti del tuo business. Automatizzare l’estrazione dati dal web significa non solo risparmiare tempo (un utente su G2 ha dichiarato di ), ma anche ridurre gli errori, cogliere nuove opportunità e assicurarsi che il team lavori sempre con dati freschi e affidabili. Cercare dati a mano è lento, soggetto a errori e spesso, quando hai finito, sono già vecchi. Con lo strumento giusto, puoi monitorare la concorrenza, tracciare i prezzi o creare liste di lead in pochi minuti, non giorni.

Un esempio concreto: un rivenditore di prodotti di bellezza ha usato il web scraping per monitorare scorte e prezzi dei concorrenti, . Un risultato impossibile solo con fogli Excel e lavoro manuale.

Come Abbiamo Valutato i Migliori Strumenti di Data Crawling

Con così tante opzioni in giro, scegliere il tool giusto può sembrare come fare speed-date a una fiera tech. Ecco i criteri che ho usato per selezionare i migliori:

- Facilità d’uso: Si può partire anche senza saper programmare? C’è un’interfaccia visuale o AI che aiuta chi non mastica codice?

- Automazione: Gestisce paginazione, sottopagine, contenuti dinamici e pianificazione? Può lavorare in cloud per grandi volumi?

- Prezzo e Scalabilità: C’è un piano gratuito o una soluzione economica? I costi crescono in modo sostenibile se aumentano i dati?

- Funzionalità e Integrazione: Si può esportare su Excel, Google Sheets o via API? Ci sono template, pianificazione o funzioni di pulizia dati integrate?

- A chi è rivolto: Il tool è pensato per utenti business, sviluppatori o team enterprise?

Alla fine trovi anche una tabella comparativa per confrontare le soluzioni a colpo d’occhio.

E ora, scopriamo i 10 migliori strumenti di data crawling per un’estrazione dati efficiente nel 2025.

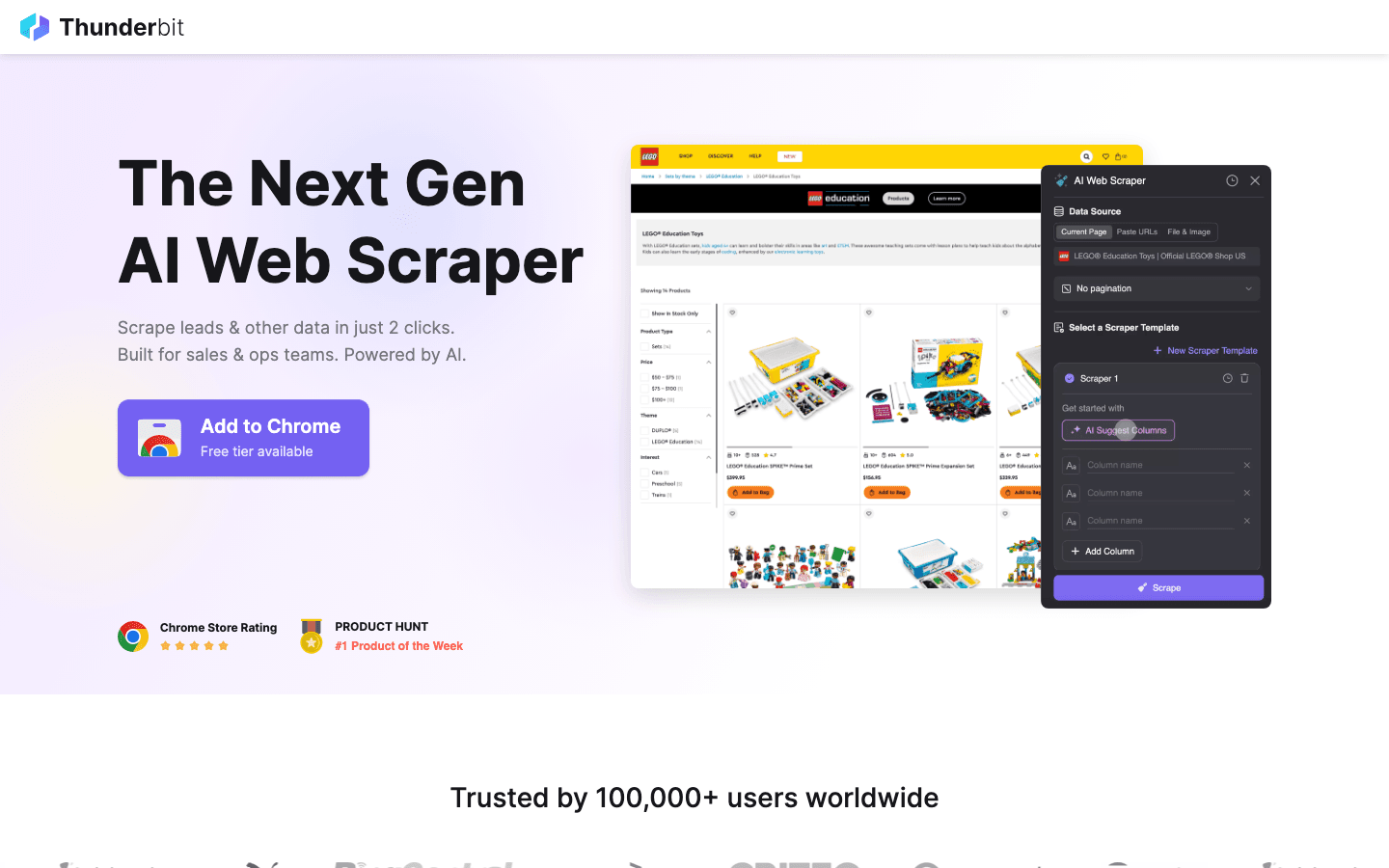

1. Thunderbit

è la mia prima scelta per chi vuole estrarre dati dal web con la stessa facilità con cui ordina una pizza. Come estensione Chrome potenziata dall’AI, Thunderbit punta tutto sulla raccolta dati in 2 clic: premi “AI Suggerisci Campi” e lascia che l’intelligenza artificiale individui le informazioni rilevanti, poi clicca su “Estrai” per ottenere i dati. Niente codice, niente selettori complicati: solo risultati immediati.

è la mia prima scelta per chi vuole estrarre dati dal web con la stessa facilità con cui ordina una pizza. Come estensione Chrome potenziata dall’AI, Thunderbit punta tutto sulla raccolta dati in 2 clic: premi “AI Suggerisci Campi” e lascia che l’intelligenza artificiale individui le informazioni rilevanti, poi clicca su “Estrai” per ottenere i dati. Niente codice, niente selettori complicati: solo risultati immediati.

Perché Thunderbit è così apprezzato da team di vendita, marketing ed ecommerce? È pensato per i flussi di lavoro reali:

- AI Suggerisci Campi: L’AI analizza la pagina e suggerisce le colonne migliori da estrarre: nomi, prezzi, email e altro.

- Estrazione Sottopagine: Vuoi più dettagli? Thunderbit visita automaticamente ogni sottopagina (come dettagli prodotto o profili LinkedIn) e arricchisce la tua tabella.

- Esportazione Istantanea: Invia i dati direttamente su Excel, Google Sheets, Airtable o Notion. Tutte le esportazioni sono gratuite.

- Template Pronti all’Uso: Per siti popolari (Amazon, Zillow, Instagram), usa template istantanei per risultati ancora più rapidi.

- Esportazione Dati Gratuita: Nessun blocco per scaricare i tuoi dati.

- Estrazione Programmata: Pianifica estrazioni ricorrenti in linguaggio naturale (“ogni lunedì alle 9”)—ideale per monitorare prezzi o aggiornare lead settimanali.

Thunderbit utilizza un sistema a crediti (1 credito = 1 riga), con un fino a 6 pagine (o 10 con bonus prova). I piani a pagamento partono da 15$/mese per 500 crediti, rendendolo accessibile a team di ogni dimensione.

Vuoi vedere Thunderbit in azione? Dai un’occhiata al nostro o al . È lo strumento che avrei voluto quando ero sommerso dall’inserimento manuale dei dati.

2. Octoparse

è un punto di riferimento per chi cerca potenza e flessibilità, soprattutto in ambito enterprise. Offre un’interfaccia desktop visuale (Windows e Mac) che permette di costruire flussi di estrazione dati con il semplice punta-e-clicca, senza scrivere codice. Ma non lasciarti ingannare dall’aspetto user-friendly: Octoparse gestisce login, scroll infinito, proxy rotanti e persino la risoluzione dei CAPTCHA.

è un punto di riferimento per chi cerca potenza e flessibilità, soprattutto in ambito enterprise. Offre un’interfaccia desktop visuale (Windows e Mac) che permette di costruire flussi di estrazione dati con il semplice punta-e-clicca, senza scrivere codice. Ma non lasciarti ingannare dall’aspetto user-friendly: Octoparse gestisce login, scroll infinito, proxy rotanti e persino la risoluzione dei CAPTCHA.

- Oltre 500 Template Preimpostati: Parti subito con template per Amazon, Twitter, LinkedIn e altri.

- Estrazione in Cloud: Esegui i job sui server Octoparse, pianifica attività e scala per grandi progetti.

- Accesso API: Integra i dati estratti direttamente nelle tue app o database.

- Automazione Avanzata: Gestisce contenuti dinamici, paginazione e flussi multi-step.

C’è un fino a 10 task, ma per la maggior parte delle aziende conviene il piano Standard (~83$/mese) o Professional (~299$/mese). La curva di apprendimento è un po’ più ripida rispetto a Thunderbit, ma se devi estrarre migliaia di pagine in modo affidabile, Octoparse è una scelta eccellente.

3. Scrapy

è lo standard per gli sviluppatori che vogliono il massimo controllo sui propri progetti di data crawling. È un framework open-source in Python che permette di programmare spider personalizzati per qualsiasi sito. Se puoi immaginarlo, puoi costruirlo con Scrapy.

è lo standard per gli sviluppatori che vogliono il massimo controllo sui propri progetti di data crawling. È un framework open-source in Python che permette di programmare spider personalizzati per qualsiasi sito. Se puoi immaginarlo, puoi costruirlo con Scrapy.

- Massima Personalizzazione: Scrivi codice Python per definire esattamente come navigare e analizzare ogni sito.

- Asincrono e Veloce: Gestisce migliaia di pagine in parallelo per progetti su larga scala.

- Estendibile: Aggiungi middleware per proxy, browser headless o logiche personalizzate.

- Community Solida: Tantissimi tutorial, plugin e supporto per casi complessi.

Scrapy è gratuito e open-source, ma richiede competenze di programmazione. Se hai un team tecnico o vuoi una pipeline su misura, è difficile trovare di meglio. Per chi non programma, però, la curva di apprendimento è impegnativa.

4. ParseHub

è uno strumento visuale e no-code perfetto per chi non programma ma deve affrontare siti complessi. L’interfaccia punta-e-clicca permette di selezionare elementi, definire azioni e costruire flussi di scraping, anche su siti dinamici o con navigazione articolata.

è uno strumento visuale e no-code perfetto per chi non programma ma deve affrontare siti complessi. L’interfaccia punta-e-clicca permette di selezionare elementi, definire azioni e costruire flussi di scraping, anche su siti dinamici o con navigazione articolata.

- Costruttore Visuale di Flussi: Seleziona i dati, imposta la paginazione e gestisci pop-up o menu a tendina.

- Gestione Contenuti Dinamici: Funziona anche su siti ricchi di JavaScript e pagine interattive.

- Esecuzione in Cloud e Pianificazione: Avvia scraping in cloud e programma job ricorrenti.

- Esportazione su CSV, Excel o via API: Integrazione semplice con i tuoi strumenti preferiti.

ParseHub offre un piano gratuito (5 progetti), con piani a pagamento da . Costa un po’ più di alcuni concorrenti, ma l’approccio visuale lo rende accessibile ad analisti, marketer e ricercatori che cercano qualcosa in più di una semplice estensione Chrome.

5. Apify

è sia una piattaforma che un marketplace per il data crawling. Offre una vasta libreria di “Actors” (estrattori pronti all’uso) per i siti più popolari, oltre alla possibilità di creare e gestire crawler personalizzati in cloud.

è sia una piattaforma che un marketplace per il data crawling. Offre una vasta libreria di “Actors” (estrattori pronti all’uso) per i siti più popolari, oltre alla possibilità di creare e gestire crawler personalizzati in cloud.

- Oltre 5.000 Actors Pronti: Estrai subito dati da Google Maps, Amazon, Twitter e altri.

- Script Personalizzati: Gli sviluppatori possono usare JavaScript o Python per crawler avanzati.

- Scalabilità in Cloud: Esegui job in parallelo, pianifica task e gestisci i dati in cloud.

- API e Integrazione: Collega i risultati alle tue app, workflow o pipeline dati.

Apify offre un , con piani a pagamento da 29$/mese (paghi solo per il tempo di calcolo). Serve un po’ di pratica, ma se vuoi sia soluzioni pronte che personalizzazione totale, Apify è una scelta potente.

6. Data Miner

è un’estensione Chrome pensata per estrazioni rapide e basate su template. Ideale per chi vuole estrarre dati da tabelle o elenchi senza configurazioni complicate.

è un’estensione Chrome pensata per estrazioni rapide e basate su template. Ideale per chi vuole estrarre dati da tabelle o elenchi senza configurazioni complicate.

- Ampia Libreria di Template: Oltre mille ricette per siti comuni (LinkedIn, Yelp, ecc.).

- Estrazione Punta-e-Clicca: Scegli un template, visualizza l’anteprima e scarica subito i dati.

- Funziona nel Browser: Utilizza la sessione attiva, perfetto anche per siti con login.

- Esportazione su CSV o Excel: Porta i dati in un foglio di calcolo in pochi secondi.

Il copre 500 pagine/mese, con piani a pagamento da 20$/mese. Ideale per estrazioni rapide e occasionali o piccoli dataset—non aspettarti però automazioni complesse o grandi volumi.

7. Import.io

è una piattaforma enterprise pensata per aziende che necessitano di integrazione dati web continua e affidabile. Non è solo un crawler: offre un servizio gestito che consegna dati puliti e strutturati direttamente nei tuoi sistemi aziendali.

è una piattaforma enterprise pensata per aziende che necessitano di integrazione dati web continua e affidabile. Non è solo un crawler: offre un servizio gestito che consegna dati puliti e strutturati direttamente nei tuoi sistemi aziendali.

- Estrazione No-Code: Configurazione visuale per definire quali dati estrarre.

- Feed Dati in Tempo Reale: Trasmetti i dati a dashboard, strumenti di analisi o database.

- Conformità e Affidabilità: Gestisce rotazione IP, anti-bot e conformità legale.

- Servizi Gestiti: Il team Import.io può configurare e mantenere i tuoi scraper.

Il prezzo è , con 14 giorni di prova gratuita per la piattaforma SaaS. Se la tua azienda dipende da dati web sempre aggiornati (retail, finanza, ricerche di mercato), Import.io merita attenzione.

8. WebHarvy

è uno scraper desktop per utenti Windows che cercano una soluzione punta-e-clicca senza abbonamento. Molto apprezzato da piccole imprese e privati che preferiscono un acquisto una tantum.

è uno scraper desktop per utenti Windows che cercano una soluzione punta-e-clicca senza abbonamento. Molto apprezzato da piccole imprese e privati che preferiscono un acquisto una tantum.

- Rilevamento Visuale dei Pattern: Clicca sugli elementi e WebHarvy riconosce automaticamente i dati ripetuti.

- Gestione Testi, Immagini e Altro: Estrae tutti i tipi di dati comuni, incluse email e URL.

- Paginazione e Pianificazione: Naviga siti multipagina e programma estrazioni.

- Esportazione su Excel, CSV, XML, JSON o SQL: Output flessibile per ogni esigenza.

La licenza singola costa , una soluzione conveniente per uso regolare—ma è disponibile solo per Windows.

9. Mozenda

è una piattaforma cloud per data crawling pensata per le aziende che hanno bisogno di dati aggiornati e processi automatizzati. Combina un designer desktop (Windows) con potenti funzioni di esecuzione e automazione in cloud.

è una piattaforma cloud per data crawling pensata per le aziende che hanno bisogno di dati aggiornati e processi automatizzati. Combina un designer desktop (Windows) con potenti funzioni di esecuzione e automazione in cloud.

- Costruttore Visuale di Agenti: Progetta routine di estrazione con un’interfaccia punta-e-clicca.

- Scalabilità Cloud: Esegui più agenti in parallelo, pianifica job e gestisci i dati centralmente.

- Console di Gestione Dati: Unisci, filtra e pulisci i dataset dopo l’estrazione.

- Supporto Enterprise: Account manager dedicati e servizi gestiti per grandi team.

I piani partono da , con livelli superiori per più utenti e potenza di calcolo. Mozenda è ideale per aziende che necessitano di dati web affidabili e ripetibili nelle operazioni quotidiane.

10. BeautifulSoup

è la libreria Python classica per il parsing di HTML e XML. Non è un crawler completo, ma è amatissima dagli sviluppatori per progetti di scraping su piccola scala e personalizzati.

è la libreria Python classica per il parsing di HTML e XML. Non è un crawler completo, ma è amatissima dagli sviluppatori per progetti di scraping su piccola scala e personalizzati.

- Parsing HTML Semplice: Estrai facilmente dati da pagine web statiche.

- Compatibile con Python Requests: Usala insieme ad altre librerie per il download e crawling.

- Flessibile e Leggera: Perfetta per script rapidi o progetti didattici.

- Grande Community: Tantissimi tutorial e risposte su Stack Overflow.

BeautifulSoup è , ma dovrai scrivere codice e gestire la logica di crawling. Ideale per sviluppatori o chi vuole imparare i fondamenti dello scraping.

Tabella Comparativa: Data Crawling Tools a Colpo d’Occhio

| Strumento | Facilità d’uso | Livello di automazione | Prezzo | Opzioni di esportazione | Ideale per |

|---|---|---|---|---|---|

| Thunderbit | Molto facile, no-code | Alto (AI, sottopagine) | Prova gratuita, da 15$/mese | Excel, Sheets, Airtable, Notion, CSV | Vendite, marketing, ecommerce, utenti non tecnici |

| Octoparse | Media, UI visuale | Molto alto, cloud | Gratis, 83–299$/mese | CSV, Excel, JSON, API | Aziende, team dati, siti dinamici |

| Scrapy | Bassa (richiede Python) | Alta (personalizzabile) | Gratis, open-source | Qualsiasi (via codice) | Sviluppatori, progetti custom su larga scala |

| ParseHub | Alta, visuale | Alta (siti dinamici) | Gratis, da 189$/mese | CSV, Excel, JSON, API | Non programmatori, strutture web complesse |

| Apify | Media, flessibile | Molto alto, cloud | Gratis, 29–999$/mese | CSV, JSON, API, cloud storage | Dev, aziende, actors pronti o personalizzati |

| Data Miner | Molto facile, browser | Basso (manuale) | Gratis, 20–99$/mese | CSV, Excel | Estrazioni rapide, piccoli dataset |

| Import.io | Media, gestito | Molto alto, enterprise | Personalizzato, su volume | CSV, JSON, API, integrazione diretta | Aziende, integrazione dati continua |

| WebHarvy | Alta, desktop | Media (pianificazione) | 129$ una tantum | Excel, CSV, XML, JSON, SQL | PMI, utenti Windows, scraping regolare |

| Mozenda | Media, visuale | Molto alto, cloud | 250–450+$/mese | CSV, Excel, JSON, cloud, DB | Operazioni aziendali su larga scala |

| BeautifulSoup | Bassa (richiede Python) | Basso (codice manuale) | Gratis, open-source | Qualsiasi (via codice) | Sviluppatori, studenti, script custom piccoli |

Come Scegliere lo Strumento di Data Crawling Giusto per il Tuo Team

La scelta del miglior strumento di data crawling non dipende dalla “potenza assoluta”, ma da ciò che si adatta meglio alle competenze, alle esigenze e al budget del tuo team. Ecco qualche consiglio pratico:

- Utenti non tecnici o business: Parti da Thunderbit, ParseHub o Data Miner per risultati immediati e configurazione semplice.

- Aziende o grandi volumi: Valuta Octoparse, Mozenda o Import.io per automazione, pianificazione e supporto.

- Sviluppatori o progetti custom: Scrapy, Apify o BeautifulSoup offrono controllo e flessibilità totali.

- Budget limitato o lavori occasionali: WebHarvy (Windows) o Data Miner (browser) sono soluzioni economiche e semplici.

Prova sempre i tuoi strumenti preferiti con una demo gratuita sui siti che ti interessano: ciò che funziona su un sito potrebbe non funzionare su un altro. E non dimenticare l’integrazione: se ti serve esportare su Sheets, Notion o database, verifica che il tool lo supporti nativamente.

Conclusione: Sblocca il Valore del Tuo Business con i Migliori Strumenti di Data Crawling

I dati web sono il nuovo petrolio, ma solo se hai gli strumenti giusti per estrarli e trasformarli. Con i moderni strumenti di data crawling, puoi convertire ore di ricerca manuale in pochi minuti di insight automatizzati—alimentando vendite più intelligenti, marketing più efficace e operazioni più agili. Che tu stia costruendo liste di lead, monitorando la concorrenza o semplicemente stanco di copiare e incollare, in questa lista c’è lo strumento che può semplificarti la vita.

Valuta le esigenze del tuo team, prova alcuni di questi strumenti e scopri quanto puoi ottenere lasciando che sia l’automazione a fare il lavoro pesante. E se vuoi vedere come funziona davvero l’estrazione AI in 2 clic, . Buon scraping—e che i tuoi dati siano sempre freschi, strutturati e pronti all’uso.

Domande Frequenti

1. Cos’è uno strumento di data crawling e perché dovrei usarlo?

Un data crawling tool automatizza l’estrazione di informazioni dai siti web. Ti fa risparmiare tempo, riduce gli errori e aiuta i team a raccogliere dati aggiornati per vendite, marketing, ricerca e operazioni—molto più efficacemente rispetto al copia-incolla manuale.

2. Qual è il miglior strumento di data crawling per chi non sa programmare?

Thunderbit, ParseHub e Data Miner sono le scelte migliori per chi non ha competenze tecniche. Thunderbit si distingue per il flusso AI in 2 clic, mentre ParseHub offre un approccio visuale per siti più complessi.

3. Come variano i modelli di prezzo tra i vari strumenti di data crawling?

I prezzi sono molto diversi: alcuni strumenti (come Thunderbit e Data Miner) offrono piani gratuiti e abbonamenti accessibili, mentre le piattaforme enterprise (come Import.io e Mozenda) propongono tariffe personalizzate o basate sul volume. Verifica sempre che il costo sia proporzionato alle tue esigenze.

4. Posso usare questi strumenti per estrazioni dati programmate e ricorrenti?

Sì—strumenti come Thunderbit, Octoparse, Apify, Mozenda e Import.io supportano estrazioni pianificate o ricorrenti, ideali per monitoraggio prezzi, generazione lead o ricerche di mercato continuative.

5. Cosa devo valutare prima di scegliere uno strumento di data crawling?

Considera le competenze tecniche del tuo team, la complessità dei siti da estrarre, il volume di dati, le necessità di integrazione e il budget. Prova alcuni strumenti con casi reali prima di scegliere un piano a pagamento.

Per approfondimenti e guide pratiche, visita il .

Scopri di più