Web sekarang ini sudah bukan sekadar dunia maya buat main-main—tapi jadi lumbung data terbesar yang pernah ada, dan semua orang, mulai dari tim sales sampai analis pasar, berlomba-lomba memanfaatkannya. Tapi, jujur aja deh: ngumpulin data web manual itu rasanya kayak ngerakit lemari IKEA tanpa buku petunjuk (dan ujung-ujungnya baut sisa dua kali lipat). Seiring bisnis makin butuh data pasar real-time, pemantauan harga kompetitor, sampai cari prospek baru, kebutuhan akan alat crawling data yang efisien dan bisa diandalkan makin mendesak. Faktanya, hampir buat ambil keputusan, dan pasar web scraping global diprediksi bakal .

Kalau kamu udah capek copy-paste, sering kehilangan prospek baru, atau penasaran seberapa jauh otomatisasi bisa bantu kerjaan, kamu lagi baca artikel yang pas. Saya sendiri udah bertahun-tahun ngebangun dan nyobain berbagai alat ekstraksi web (dan ya, pernah mimpin tim di ), jadi saya tahu banget gimana alat yang tepat bisa bikin kerjaan membosankan berjam-jam jadi cuma dua klik doang. Mau kamu pengguna non-teknis yang pengen hasil instan atau developer yang butuh kontrol penuh, daftar 10 alat crawling data terbaik ini bakal bantu kamu nemuin solusi yang cocok.

Kenapa Pilih Alat Crawling Data yang Pas Itu Penting

Ngomong apa adanya: beda alat crawling data yang bagus sama yang biasa aja itu bukan cuma soal gampang dipakai—tapi bisa langsung ngaruh ke pertumbuhan bisnis. Dengan otomatisasi ekstraksi web, kamu bukan cuma hemat waktu (ada reviewer G2 yang bilang ), tapi juga minim salah, buka peluang baru, dan pastiin tim kamu selalu kerja pakai data paling update dan akurat. Riset manual itu lambat, rawan salah, dan seringnya udah basi pas selesai. Dengan alat yang tepat, kamu bisa pantau kompetitor, lacak harga, atau bikin daftar prospek dalam hitungan menit—bukan hari.

Contohnya: ada retailer kecantikan yang pakai web scraping buat pantau stok dan harga pesaing, . Hasil kayak gini jelas nggak bisa dicapai cuma pakai spreadsheet dan kerja manual.

Cara Kami Menilai Alat Crawling Data Terbaik

Pilihan alat crawling data sekarang banyak banget, rasanya kayak speed-dating di acara teknologi. Ini kriteria yang saya pakai buat milih yang terbaik:

- Gampang Dipakai: Bisa langsung jalan tanpa harus jago Python? Ada tampilan visual atau bantuan AI buat yang nggak bisa ngoding?

- Otomatisasi: Bisa handle pagination, subpage, konten dinamis, dan penjadwalan? Bisa jalan di cloud buat proyek besar?

- Harga & Skalabilitas: Ada paket gratis atau harga awal yang ramah? Gimana biaya kalau kebutuhan data makin banyak?

- Fitur & Integrasi: Bisa ekspor ke Excel, Google Sheets, atau lewat API? Ada template, penjadwalan, atau fitur bersihin data bawaan?

- Cocok Buat Siapa: Siapa target utamanya—pengguna bisnis, developer, atau tim enterprise?

Saya juga kasih tabel perbandingan di akhir supaya kamu gampang bandingin tiap alat.

Sekarang, yuk kita bahas 10 alat crawling data terbaik buat ekstraksi web yang efisien di tahun 2025.

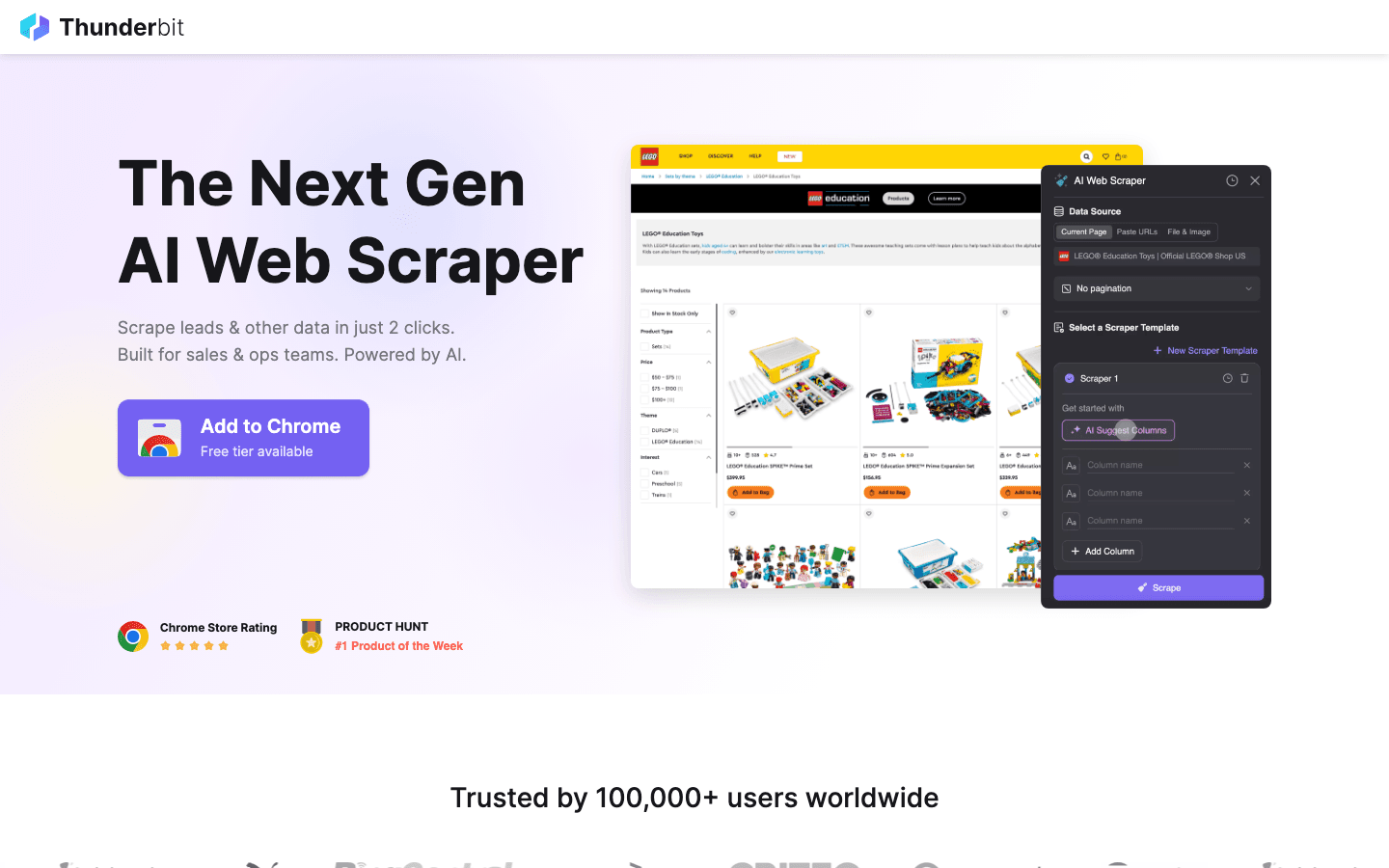

1. Thunderbit

jadi rekomendasi nomor satu saya buat siapa aja yang pengen crawling data semudah order makanan online. Sebagai ekstensi Chrome berbasis AI, Thunderbit kasih fitur scraping 2-klik: tinggal tekan “AI Suggest Fields” biar AI deteksi data di halaman, lalu klik “Scrape” buat ambil datanya. Nggak perlu ngoding, nggak ribet sama selector—hasil langsung keluar.

jadi rekomendasi nomor satu saya buat siapa aja yang pengen crawling data semudah order makanan online. Sebagai ekstensi Chrome berbasis AI, Thunderbit kasih fitur scraping 2-klik: tinggal tekan “AI Suggest Fields” biar AI deteksi data di halaman, lalu klik “Scrape” buat ambil datanya. Nggak perlu ngoding, nggak ribet sama selector—hasil langsung keluar.

Kenapa Thunderbit jadi andalan tim sales, marketing, dan ecommerce? Karena memang didesain buat kebutuhan bisnis nyata:

- AI Suggest Fields: AI baca halaman dan rekomendasiin kolom terbaik buat diekstrak—nama, harga, email, dan lainnya.

- Scraping Subpage: Butuh detail lebih? Thunderbit bisa otomatis kunjungi subpage (kayak detail produk atau profil LinkedIn) dan lengkapi tabel kamu.

- Ekspor Instan: Kirim data langsung ke Excel, Google Sheets, Airtable, atau Notion. Semua ekspor gratis.

- Template Satu Klik: Buat situs populer (Amazon, Zillow, Instagram), tinggal pakai template biar makin cepat.

- Ekspor Data Gratis: Nggak ada biaya tambahan buat ekspor data.

- Scraping Terjadwal: Atur kerjaan berulang pakai bahasa sehari-hari (“setiap Senin jam 9 pagi”)—pas banget buat pantau harga atau update prospek mingguan.

Thunderbit pakai sistem kredit (1 kredit = 1 baris), dengan sampai 6 halaman (atau 10 kalau pakai trial boost). Paket berbayar mulai $15/bulan buat 500 kredit, cocok buat tim kecil sampai besar.

Mau lihat Thunderbit langsung? Cek atau kami. Ini alat yang dulu saya harap udah ada waktu masih tenggelam di kerjaan entri data manual.

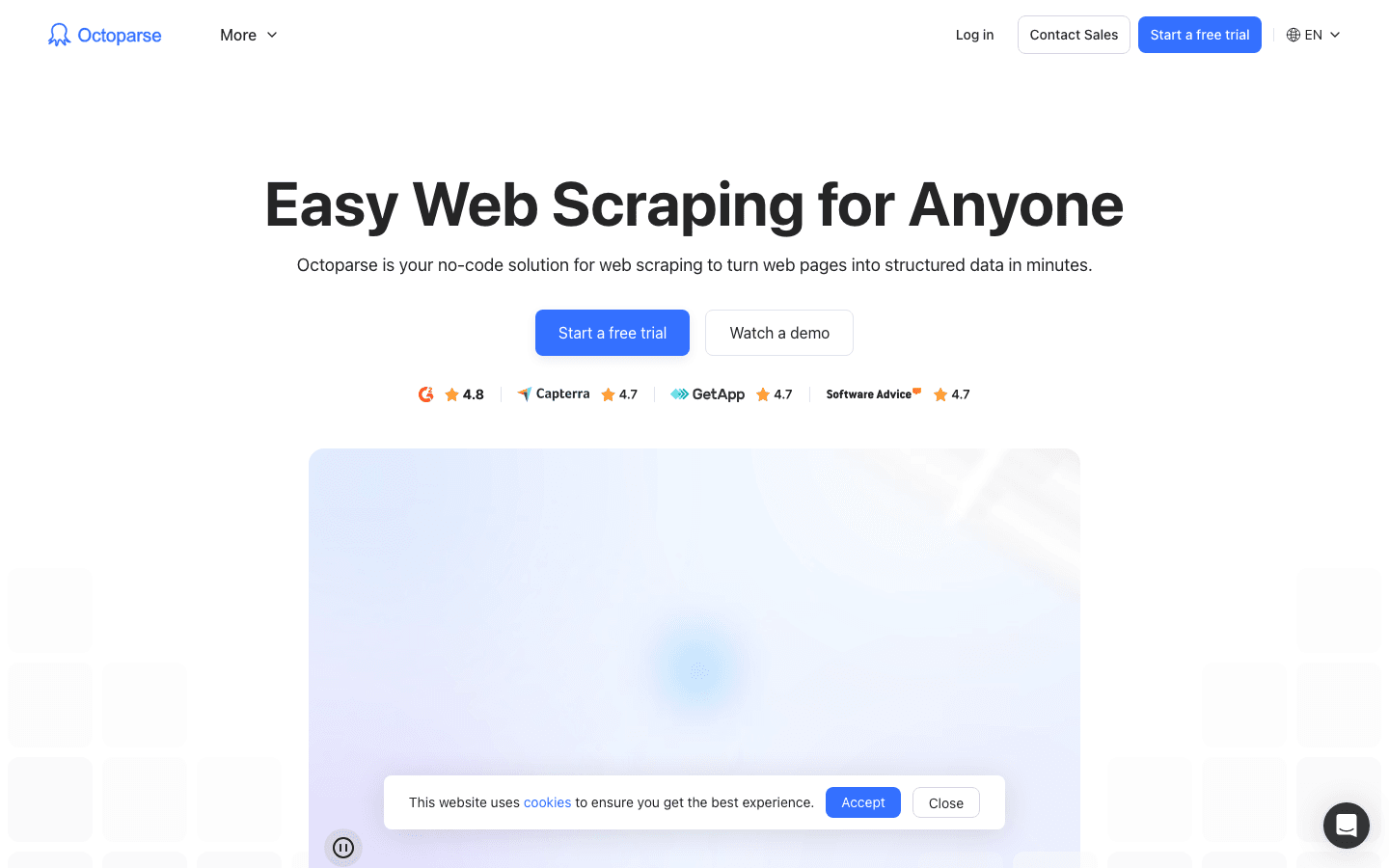

2. Octoparse

adalah pemain besar di dunia crawling data, terutama buat pengguna enterprise yang butuh tenaga ekstra. Menawarkan antarmuka desktop visual (Windows dan Mac) yang bikin kamu bisa bikin workflow ekstraksi cukup klik-klik—tanpa coding. Tapi jangan salah, Octoparse bisa handle login, infinite scroll, proxy rotasi, bahkan CAPTCHA.

adalah pemain besar di dunia crawling data, terutama buat pengguna enterprise yang butuh tenaga ekstra. Menawarkan antarmuka desktop visual (Windows dan Mac) yang bikin kamu bisa bikin workflow ekstraksi cukup klik-klik—tanpa coding. Tapi jangan salah, Octoparse bisa handle login, infinite scroll, proxy rotasi, bahkan CAPTCHA.

- 500+ Template Siap Pakai: Mulai cepat dengan template buat Amazon, Twitter, LinkedIn, dan lainnya.

- Scraping Berbasis Cloud: Jalankan kerjaan di server Octoparse, jadwalkan tugas, dan skalakan buat proyek besar.

- Akses API: Integrasi data hasil scraping langsung ke aplikasi atau database bisnis kamu.

- Otomatisasi Lanjutan: Bisa handle konten dinamis, pagination, dan workflow multi-langkah.

Ada buat sampai 10 tugas, tapi kebanyakan bisnis bakal pilih paket Standard (~$83/bulan) atau Professional (~$299/bulan). Kurva belajarnya memang sedikit lebih tinggi dari Thunderbit, tapi kalau kamu butuh scraping ribuan halaman dengan andal, Octoparse layak dicoba.

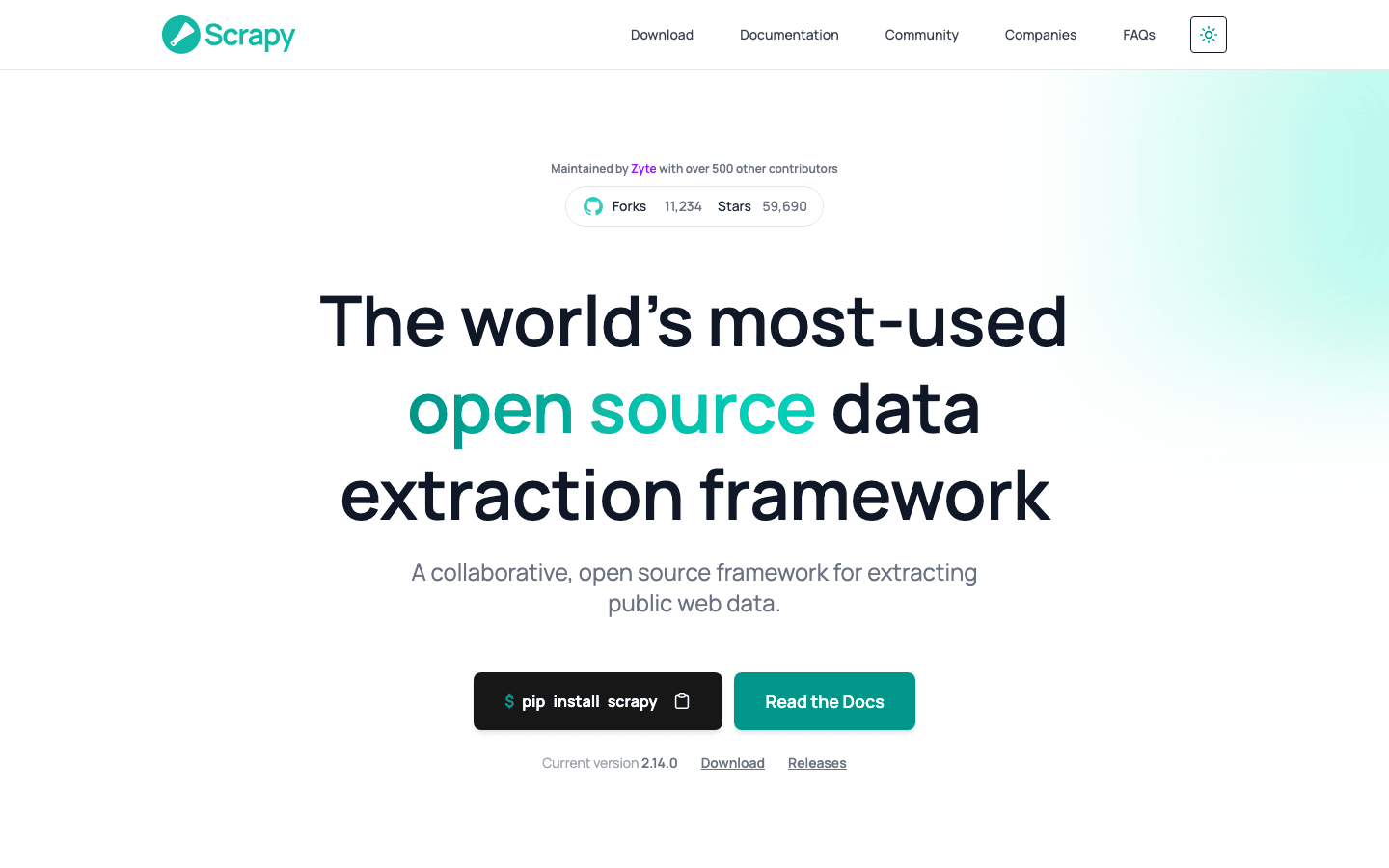

3. Scrapy

adalah standar emas buat developer yang pengen kontrol penuh atas proyek crawling data mereka. Framework Python open-source ini bikin kamu bisa bikin spider (crawler) kustom buat situs apa aja. Kalau kamu bisa bayangin, kamu bisa bikin dengan Scrapy.

adalah standar emas buat developer yang pengen kontrol penuh atas proyek crawling data mereka. Framework Python open-source ini bikin kamu bisa bikin spider (crawler) kustom buat situs apa aja. Kalau kamu bisa bayangin, kamu bisa bikin dengan Scrapy.

- Kontrol Penuh: Tulis kode Python buat atur cara crawling dan parsing situs apa aja.

- Asinkron & Ngebut: Bisa handle ribuan halaman secara paralel buat proyek skala besar.

- Mudah Dikembangkan: Tambahin middleware buat proxy, headless browser, atau logika khusus.

- Komunitas Kuat: Banyak tutorial, plugin, dan dukungan buat skenario scraping yang rumit.

Scrapy gratis dan open-source, tapi memang butuh skill ngoding. Kalau kamu punya tim teknis atau pengen pipeline kustom, Scrapy sangat mumpuni. Tapi buat non-programmer, ini cukup menantang.

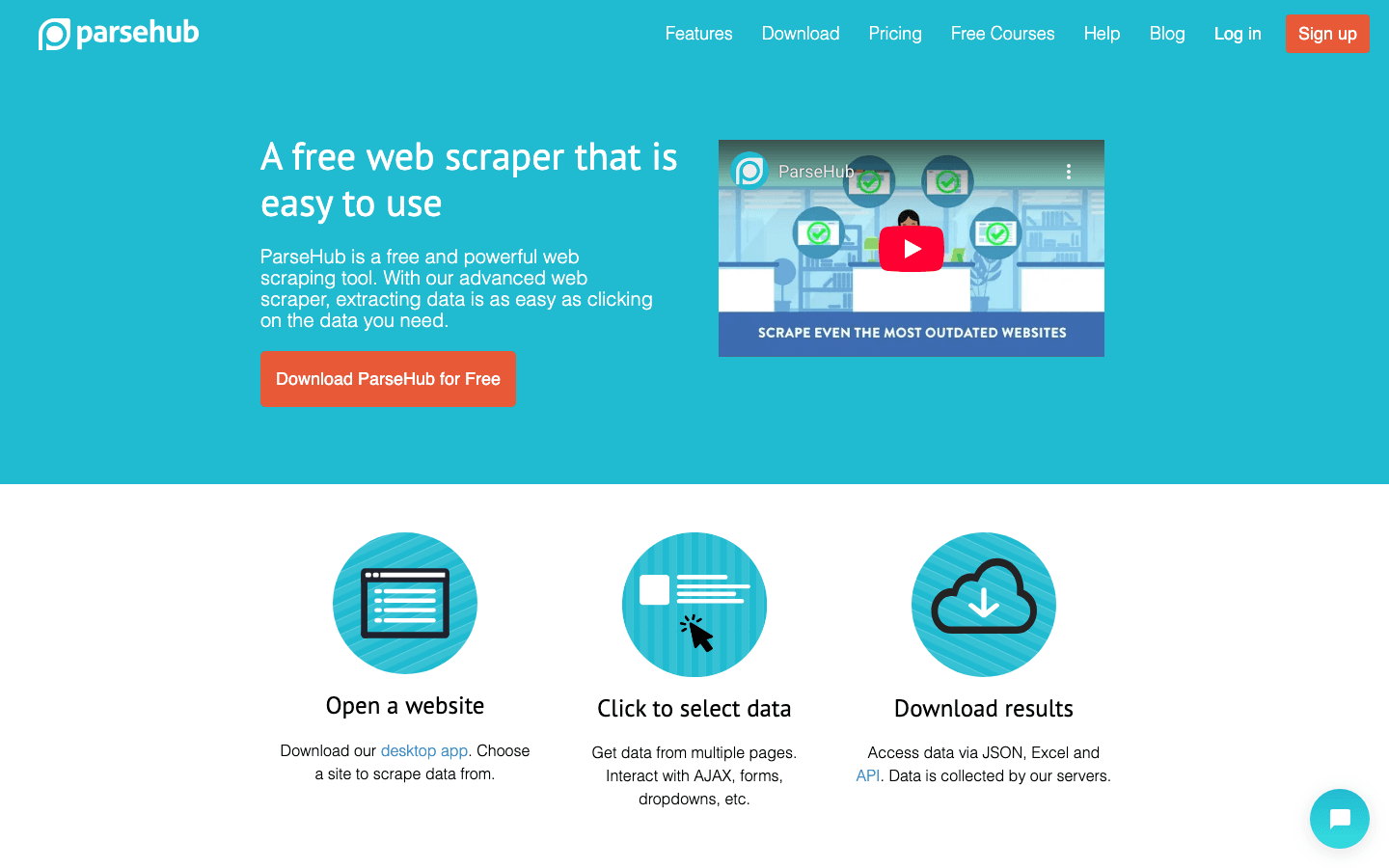

4. ParseHub

adalah alat web scraping visual tanpa kode yang cocok buat non-programmer yang harus hadapi situs rumit. Antarmuka point-and-click-nya bikin kamu gampang pilih elemen, atur aksi, dan bikin workflow scraping—bahkan buat situs dengan konten dinamis atau navigasi ribet.

adalah alat web scraping visual tanpa kode yang cocok buat non-programmer yang harus hadapi situs rumit. Antarmuka point-and-click-nya bikin kamu gampang pilih elemen, atur aksi, dan bikin workflow scraping—bahkan buat situs dengan konten dinamis atau navigasi ribet.

- Builder Workflow Visual: Klik buat pilih data, atur pagination, dan handle pop-up atau dropdown.

- Dukung Konten Dinamis: Jalan di situs berbasis JavaScript dan halaman interaktif.

- Cloud & Penjadwalan: Jalankan scraping di cloud dan jadwalkan kerjaan berulang.

- Ekspor ke CSV, Excel, atau API: Integrasi gampang ke alat favorit kamu.

ParseHub punya paket gratis (5 proyek), dengan paket berbayar mulai . Memang lebih mahal dari beberapa pesaing, tapi pendekatan visualnya ramah banget buat analis, marketer, dan peneliti yang butuh lebih dari sekadar ekstensi Chrome.

5. Apify

adalah platform sekaligus marketplace buat crawling web. Menyediakan perpustakaan besar "Actors" (scraper siap pakai) buat situs populer, plus kemampuan bikin crawler kustom di cloud.

adalah platform sekaligus marketplace buat crawling web. Menyediakan perpustakaan besar "Actors" (scraper siap pakai) buat situs populer, plus kemampuan bikin crawler kustom di cloud.

- 5.000+ Actors Siap Pakai: Scrape Google Maps, Amazon, Twitter, dan lainnya langsung.

- Skrip Kustom: Developer bisa pakai JavaScript atau Python buat crawler lanjutan.

- Cloud Scaling: Jalankan kerjaan paralel, jadwalkan tugas, dan kelola data di cloud.

- API & Integrasi: Hubungkan hasil ke aplikasi, workflow, atau pipeline data kamu.

Apify punya yang fleksibel, dengan paket berbayar mulai $29/bulan (bayar sesuai pemakaian waktu komputasi). Ada sedikit kurva belajar, tapi kalau kamu mau kombinasi plug-and-play dan kustomisasi penuh, Apify sangat bertenaga.

6. Data Miner

adalah ekstensi Chrome buat crawling data berbasis template secara cepat. Cocok buat pengguna bisnis yang mau ambil data dari tabel atau daftar tanpa setup ribet.

adalah ekstensi Chrome buat crawling data berbasis template secara cepat. Cocok buat pengguna bisnis yang mau ambil data dari tabel atau daftar tanpa setup ribet.

- Perpustakaan Template Besar: Lebih dari seribu resep buat situs umum (LinkedIn, Yelp, dll).

- Ekstraksi Point-and-Click: Pilih template, pratinjau data, dan ekspor langsung.

- Berbasis Browser: Jalan bareng sesi kamu sekarang—cocok buat scraping di balik login.

- Ekspor ke CSV atau Excel: Data langsung masuk spreadsheet dalam hitungan detik.

mencakup 500 halaman/bulan, dengan paket berbayar mulai $20/bulan. Paling pas buat tugas kecil atau kebutuhan data cepat—tapi kurang cocok buat proyek besar atau otomatisasi rumit.

7. Import.io

adalah platform kelas enterprise buat organisasi yang butuh integrasi data web yang berkelanjutan dan andal. Lebih dari sekadar crawler—ini layanan terkelola yang ngasih data bersih dan terstruktur langsung ke sistem bisnis kamu.

adalah platform kelas enterprise buat organisasi yang butuh integrasi data web yang berkelanjutan dan andal. Lebih dari sekadar crawler—ini layanan terkelola yang ngasih data bersih dan terstruktur langsung ke sistem bisnis kamu.

- Ekstraksi Tanpa Kode: Setup visual buat tentuin data yang mau diambil.

- Feed Data Real-Time: Alirkan data ke dashboard, alat analitik, atau database.

- Kepatuhan & Keandalan: Handle rotasi IP, anti-bot, dan kepatuhan hukum.

- Layanan Terkelola: Tim Import.io bisa setup dan rawat scraper kamu.

Harga , dengan uji coba gratis 14 hari buat platform SaaS. Kalau bisnis kamu sangat bergantung pada data web terbaru (misal retail, keuangan, riset pasar), Import.io layak dicoba.

8. WebHarvy

adalah scraper desktop buat pengguna Windows yang mau solusi point-and-click tanpa langganan. Populer banget di kalangan bisnis kecil dan individu yang lebih suka beli sekali untuk selamanya.

adalah scraper desktop buat pengguna Windows yang mau solusi point-and-click tanpa langganan. Populer banget di kalangan bisnis kecil dan individu yang lebih suka beli sekali untuk selamanya.

- Deteksi Pola Visual: Klik elemen data, WebHarvy otomatis deteksi pola berulang.

- Ekstrak Teks, Gambar, dan Lainnya: Support semua tipe data umum, termasuk email dan URL.

- Pagination & Penjadwalan: Navigasi situs multi-halaman dan atur scraping terjadwal.

- Ekspor ke Excel, CSV, XML, JSON, atau SQL: Output fleksibel buat workflow apa aja.

Lisensi satu pengguna , sangat hemat buat penggunaan rutin—tapi khusus Windows.

9. Mozenda

adalah platform crawling data berbasis cloud yang didesain buat operasi bisnis dan kebutuhan data berkelanjutan. Gabungin desktop designer (Windows) dengan eksekusi cloud dan otomatisasi yang kuat.

adalah platform crawling data berbasis cloud yang didesain buat operasi bisnis dan kebutuhan data berkelanjutan. Gabungin desktop designer (Windows) dengan eksekusi cloud dan otomatisasi yang kuat.

- Visual Agent Builder: Rancang rutinitas ekstraksi dengan antarmuka point-and-click.

- Cloud Scaling: Jalankan banyak agent paralel, jadwalkan kerjaan, dan kelola data terpusat.

- Konsol Manajemen Data: Gabung, filter, dan bersihin dataset setelah ekstraksi.

- Dukungan Enterprise: Account manager khusus dan layanan terkelola buat tim besar.

Paket mulai , dengan tier lebih tinggi buat pengguna dan kapasitas lebih besar. Mozenda cocok banget buat perusahaan yang butuh data web andal dan berulang sebagai bagian dari operasional harian.

10. BeautifulSoup

adalah library Python klasik buat parsing HTML dan XML. Bukan crawler penuh, tapi jadi favorit developer buat proyek scraping kecil dan kustom.

adalah library Python klasik buat parsing HTML dan XML. Bukan crawler penuh, tapi jadi favorit developer buat proyek scraping kecil dan kustom.

- Parsing HTML Sederhana: Gampang ekstrak data dari halaman web statis.

- Bisa Digabung dengan Python Requests: Kombinasiin dengan library lain buat fetching dan crawling.

- Fleksibel & Ringan: Cocok buat skrip cepat atau proyek belajar.

- Komunitas Besar: Banyak tutorial dan jawaban di Stack Overflow.

BeautifulSoup , tapi kamu harus nulis kode dan atur logika crawling sendiri. Paling cocok buat developer atau yang lagi belajar dasar-dasar web scraping.

Tabel Perbandingan: Alat Crawling Data Sekilas

| Alat | Kemudahan Penggunaan | Level Otomatisasi | Harga | Opsi Ekspor | Cocok Untuk |

|---|---|---|---|---|---|

| Thunderbit | Sangat mudah, no-code | Tinggi (AI, subpage) | Uji coba gratis, mulai $15/bln | Excel, Sheets, Airtable, Notion, CSV | Sales, marketing, ecommerce, non-teknis |

| Octoparse | Sedang, UI visual | Sangat tinggi, cloud | Gratis, $83–$299/bln | CSV, Excel, JSON, API | Enterprise, tim data, situs dinamis |

| Scrapy | Rendah (butuh Python) | Tinggi (kustomisasi) | Gratis, open-source | Apa saja (lewat kode) | Developer, proyek kustom skala besar |

| ParseHub | Tinggi, visual | Tinggi (situs dinamis) | Gratis, mulai $189/bln | CSV, Excel, JSON, API | Non-teknis, struktur web kompleks |

| Apify | Sedang, fleksibel | Sangat tinggi, cloud | Gratis, $29–$999/bln | CSV, JSON, API, cloud storage | Developer, bisnis, actor siap pakai/kustom |

| Data Miner | Sangat mudah, browser | Rendah (manual) | Gratis, $20–$99/bln | CSV, Excel | Ekstraksi cepat, dataset kecil |

| Import.io | Sedang, terkelola | Sangat tinggi, enterprise | Custom, berbasis volume | CSV, JSON, API, integrasi langsung | Enterprise, integrasi data berkelanjutan |

| WebHarvy | Tinggi, desktop | Sedang (penjadwalan) | $129 sekali bayar | Excel, CSV, XML, JSON, SQL | UKM, pengguna Windows, scraping rutin |

| Mozenda | Sedang, visual | Sangat tinggi, cloud | $250–$450+/bln | CSV, Excel, JSON, cloud, DB | Operasi bisnis besar, berulang |

| BeautifulSoup | Rendah (butuh Python) | Rendah (manual coding) | Gratis, open-source | Apa saja (lewat kode) | Developer, pembelajar, skrip kustom kecil |

Cara Pilih Alat Crawling Data yang Pas Buat Tim Kamu

Milih alat crawling data terbaik itu bukan soal cari yang "paling canggih"—tapi yang paling cocok sama skill, kebutuhan, dan budget tim kamu. Ini saran singkat dari saya:

- Non-teknis atau pengguna bisnis: Mulai dari Thunderbit, ParseHub, atau Data Miner buat hasil instan dan setup gampang.

- Kebutuhan enterprise atau skala besar: Coba Octoparse, Mozenda, atau Import.io buat otomatisasi, penjadwalan, dan support.

- Developer atau proyek kustom: Scrapy, Apify, atau BeautifulSoup kasih kontrol dan fleksibilitas penuh.

- Hemat budget atau tugas satu kali: WebHarvy (Windows) atau Data Miner (browser) murah dan simpel.

Selalu coba beberapa alat teratas dengan uji coba gratis di situs target kamu—karena yang berhasil di satu situs belum tentu di situs lain. Jangan lupa juga soal integrasi: kalau kamu butuh data langsung masuk ke Sheets, Notion, atau database, pastikan alatnya support.

Kesimpulan: Maksimalkan Nilai Bisnis dengan Alat Crawling Data Terbaik

Data web itu ibarat minyak baru, tapi cuma berguna kalau kamu punya "mesin" yang tepat buat ekstrak dan olah. Dengan alat crawling data modern, kamu bisa ubah jam-jam riset manual jadi insight otomatis dalam hitungan menit—bikin penjualan makin cerdas, pemasaran makin tajam, dan operasional makin gesit. Mau kamu lagi bikin daftar prospek, pantau kompetitor, atau sekadar capek copy-paste, ada alat di daftar ini yang bisa bikin hidup kamu lebih mudah.

Jadi, evaluasi kebutuhan tim kamu, coba beberapa alat di atas, dan rasakan sendiri seberapa banyak yang bisa dicapai kalau otomatisasi ambil alih kerjaan berat. Dan kalau mau lihat seperti apa scraping AI 2-klik, . Selamat mencoba—semoga data kamu selalu segar, rapi, dan siap dipakai.

FAQ

1. Apa itu alat crawling data dan kenapa saya butuh?

Alat crawling data otomatisasi proses ekstraksi info dari situs web. Ini hemat waktu, minim salah, dan bantu tim ngumpulin data terbaru buat sales, marketing, riset, dan operasional—jauh lebih efisien daripada copy-paste manual.

2. Alat crawling data mana yang paling cocok buat non-teknis?

Thunderbit, ParseHub, dan Data Miner adalah pilihan utama buat non-programmer. Thunderbit unggul dengan workflow AI 2-klik, sedangkan ParseHub menawarkan pendekatan visual buat situs yang lebih rumit.

3. Gimana perbedaan model harga antar alat crawling data?

Harga bervariasi: beberapa alat (kayak Thunderbit dan Data Miner) punya paket gratis dan langganan terjangkau, sementara platform enterprise (kayak Import.io dan Mozenda) pakai harga custom atau berbasis volume. Pastikan biaya alat sesuai kebutuhan data kamu.

4. Bisa nggak alat-alat ini dipakai buat ekstraksi data terjadwal dan berkelanjutan?

Bisa—alat kayak Thunderbit, Octoparse, Apify, Mozenda, dan Import.io support crawling terjadwal atau berulang, cocok banget buat pantau harga, cari prospek, atau riset pasar rutin.

5. Apa yang harus dipertimbangkan sebelum pilih alat crawling data?

Pertimbangkan skill teknis tim, kerumitan situs yang mau di-crawl, volume data, kebutuhan integrasi, dan budget. Coba beberapa alat dengan tugas nyata sebelum berlangganan.

Buat panduan dan tips lebih lanjut, mampir ke .

Pelajari Lebih Lanjut