Internettet er ikke længere bare et digitalt frirum – det er blevet verdens største skattekiste af data, og alle fra salgsteams til markedsanalytikere kæmper om at få fingrene i de bedste indsigter. Men lad os være ærlige: At samle webdata manuelt er omtrent lige så sjovt som at samle IKEA-møbler uden manual (og med dobbelt så mange løse skruer tilbage bagefter). Efterhånden som virksomheder bliver mere afhængige af friske markedsdata, konkurrentovervågning og leadgenerering, er behovet for smarte og pålidelige data crawling-værktøjer større end nogensinde. Faktisk er næsten , og det globale marked for web scraping forventes at .

Er du træt af at kopiere og indsætte, mister du leads, eller er du bare nysgerrig på, hvad automatisering kan gøre for dig? Så er du landet det helt rigtige sted. Jeg har brugt flere år på at udvikle og teste webudtræksværktøjer (og ja, jeg står i spidsen for teamet hos ), så jeg ved, hvor stor forskel det rigtige værktøj kan gøre – fra timevis af manuelt arbejde til et par klik. Uanset om du ikke kan kode og vil have hurtige resultater, eller du er udvikler med brug for fuld kontrol, så vil denne top 10-liste over de bedste data crawling-værktøjer hjælpe dig med at finde det perfekte match.

Hvorfor det er vigtigt at vælge det rette data crawling-værktøj

Lad os være ærlige: Forskellen på et godt og et halvdårligt data crawling-værktøj handler ikke kun om bekvemmelighed – det kan faktisk have direkte betydning for, hvor hurtigt din virksomhed vokser. Når du automatiserer webudtræk, sparer du ikke bare tid (en G2-anmelder har ), du minimerer også fejl, åbner nye muligheder og sikrer, at dit team altid arbejder med de nyeste og mest præcise data. Manuelle undersøgelser er langsomme, fejlbehæftede og ofte forældede, før du er færdig. Med det rette værktøj kan du overvåge konkurrenter, følge priser eller bygge leadlister på få minutter – ikke dage.

Et eksempel: En skønhedsforhandler brugte web scraping til at overvåge konkurrenters lager og priser, hvilket . Det er resultater, du ikke får med regneark og manuelt tastearbejde.

Sådan har vi vurderet de bedste data crawling-værktøjer

Med så mange muligheder kan det føles som speed-dating på en tech-messe at vælge det rigtige data crawling-værktøj. Her er de kriterier, jeg har brugt til at udvælge de bedste:

- Brugervenlighed: Kan du komme i gang uden at være Python-haj? Er der visuel grænseflade eller AI-hjælp til ikke-kodere?

- Automatisering: Kan værktøjet klare sideskift, undersider, dynamisk indhold og planlægning? Kan det køre i skyen til større opgaver?

- Pris og skalerbarhed: Er der en gratis version eller en fair startpakke? Hvordan udvikler prisen sig, når dine databehov vokser?

- Funktioner og integration: Kan du eksportere til Excel, Google Sheets eller via API? Er der skabeloner, planlægning eller indbygget datarensning?

- Målgruppe: Hvem er værktøjet egentlig lavet til – forretningsbrugere, udviklere eller enterprise-teams?

Jeg har også lavet en sammenligningstabel til sidst, så du hurtigt kan se forskellene.

Lad os hoppe direkte til de 10 bedste data crawling-værktøjer til effektiv webudtræk i 2025.

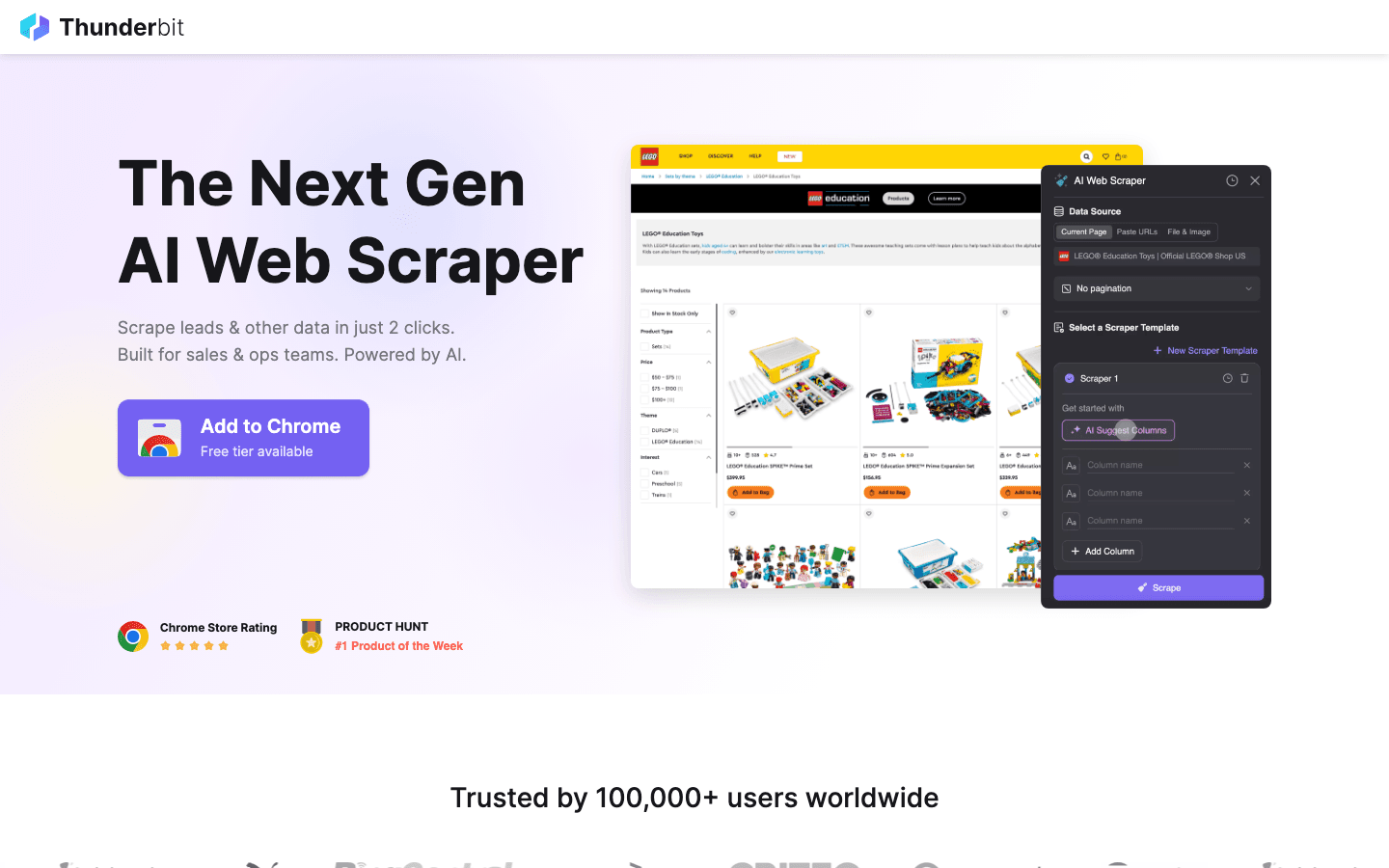

1. Thunderbit

er mit go-to valg for alle, der vil gøre data crawling lige så let som at bestille mad online. Som en AI-drevet Chrome-udvidelse handler Thunderbit om 2-klik scraping: Klik på “AI Foreslå Felter”, lad AI’en finde de relevante data på siden, og tryk derefter på “Scrape” for at hente informationen. Ingen kodning, ingen bøvl – bare lynhurtige resultater.

er mit go-to valg for alle, der vil gøre data crawling lige så let som at bestille mad online. Som en AI-drevet Chrome-udvidelse handler Thunderbit om 2-klik scraping: Klik på “AI Foreslå Felter”, lad AI’en finde de relevante data på siden, og tryk derefter på “Scrape” for at hente informationen. Ingen kodning, ingen bøvl – bare lynhurtige resultater.

Hvorfor elsker salgs-, marketing- og e-handelsteams Thunderbit? Det er bygget til rigtige forretningsbehov:

- AI Foreslå Felter: AI’en læser siden og foreslår de bedste kolonner at udtrække – navne, priser, e-mails osv.

- Underside-scraping: Har du brug for flere detaljer? Thunderbit kan automatisk besøge undersider (fx produktsider eller LinkedIn-profiler) og berige din tabel.

- Øjeblikkelig eksport: Send data direkte til Excel, Google Sheets, Airtable eller Notion. Alle eksporter er gratis.

- Én-klik skabeloner: Brug færdige skabeloner til populære sider (Amazon, Zillow, Instagram) for endnu hurtigere resultater.

- Gratis dataeksport: Der er ingen betalingsmur for at hente dine data.

- Planlagte scraping-jobs: Opsæt gentagne opgaver på almindeligt dansk (“hver mandag kl. 9”) – perfekt til prisovervågning eller ugentlige leads.

Thunderbit bruger et kreditsystem (1 kredit = 1 række), med en til op til 6 sider (eller 10 med prøveboost). Betalte planer starter ved 15 USD/måned for 500 kreditter, så det er til at betale for teams i alle størrelser.

Vil du se Thunderbit i aktion? Tjek vores eller . Det er det værktøj, jeg selv ville ønske, jeg havde haft, da jeg druknede i manuelt dataarbejde.

2. Octoparse

er en sværvægter inden for data crawling, især for virksomheder med store behov. Det tilbyder en visuel desktop-grænseflade (Windows og Mac), hvor du kan bygge udtræksflows med klik – ingen kodning nødvendig. Men lad dig ikke narre af det brugervenlige design: Octoparse klarer logins, uendelig scroll, roterende proxies og endda CAPTCHA-løsning.

er en sværvægter inden for data crawling, især for virksomheder med store behov. Det tilbyder en visuel desktop-grænseflade (Windows og Mac), hvor du kan bygge udtræksflows med klik – ingen kodning nødvendig. Men lad dig ikke narre af det brugervenlige design: Octoparse klarer logins, uendelig scroll, roterende proxies og endda CAPTCHA-løsning.

- 500+ færdige skabeloner: Kom hurtigt i gang med skabeloner til Amazon, Twitter, LinkedIn m.fl.

- Cloud-baseret scraping: Kør opgaver på Octoparse’s servere, planlæg jobs og skalér til store projekter.

- API-adgang: Integrér data direkte i dine forretningssystemer eller databaser.

- Avanceret automatisering: Håndterer dynamisk indhold, sideskift og komplekse flows.

Der er en til op til 10 opgaver, men de fleste virksomheder vil vælge Standard (~83 USD/måned) eller Professional (~299 USD/måned). Læringskurven er lidt stejlere end Thunderbit, men skal du scrape tusindvis af sider, er Octoparse et stærkt valg.

3. Scrapy

er guldstandarden for udviklere, der vil have fuld kontrol over deres data crawling-projekter. Det er et open source Python-framework, hvor du kan kode skræddersyede “spiders” (crawlere) til enhver hjemmeside. Hvis du kan forestille dig det, kan du bygge det med Scrapy.

er guldstandarden for udviklere, der vil have fuld kontrol over deres data crawling-projekter. Det er et open source Python-framework, hvor du kan kode skræddersyede “spiders” (crawlere) til enhver hjemmeside. Hvis du kan forestille dig det, kan du bygge det med Scrapy.

- Fuld programmerbarhed: Skriv Python-kode for at definere præcis, hvordan du crawler og udtrækker data.

- Asynkront og hurtigt: Håndterer tusindvis af sider parallelt til store projekter.

- Udvidelsesmuligheder: Tilføj middleware til proxies, headless browsere eller speciallogik.

- Stærkt community: Masser af tutorials, plugins og hjælp til komplekse scraping-scenarier.

Scrapy er gratis og open source, men kræver programmeringskompetencer. Har du et teknisk team eller vil bygge en skræddersyet pipeline, er Scrapy svært at slå. For ikke-kodere er det dog en stejl læringskurve.

4. ParseHub

er et visuelt, kodefrit web scraping-værktøj, der er ideelt til ikke-kodere, der skal håndtere komplekse hjemmesider. Med point-and-click kan du vælge elementer, definere handlinger og bygge scraping-flows – selv til sider med dynamisk indhold eller svær navigation.

er et visuelt, kodefrit web scraping-værktøj, der er ideelt til ikke-kodere, der skal håndtere komplekse hjemmesider. Med point-and-click kan du vælge elementer, definere handlinger og bygge scraping-flows – selv til sider med dynamisk indhold eller svær navigation.

- Visuel workflow-builder: Klik for at vælge data, opsæt sideskift og håndter pop-ups eller dropdowns.

- Håndterer dynamisk indhold: Fungerer på JavaScript-tunge og interaktive sider.

- Cloud-kørsel og planlægning: Kør scraping i skyen og planlæg gentagne jobs.

- Eksport til CSV, Excel eller via API: Nem integration med dine foretrukne værktøjer.

ParseHub har en gratis plan (5 projekter), og betalte planer starter ved . Det er lidt dyrere end nogle konkurrenter, men den visuelle tilgang gør det tilgængeligt for analytikere, marketingfolk og forskere, der har brug for mere end en simpel Chrome-udvidelse.

5. Apify

er både en platform og en markedsplads for web crawling. Her finder du et stort bibliotek af færdige “Actors” (skrabere) til populære sider, og du kan også bygge og køre dine egne crawlere i skyen.

er både en platform og en markedsplads for web crawling. Her finder du et stort bibliotek af færdige “Actors” (skrabere) til populære sider, og du kan også bygge og køre dine egne crawlere i skyen.

- 5.000+ færdige Actors: Udtræk data fra Google Maps, Amazon, Twitter m.fl. med det samme.

- Skræddersyet scripting: Udviklere kan bruge JavaScript eller Python til avancerede crawlere.

- Cloud-skalerbarhed: Kør jobs parallelt, planlæg opgaver og håndter data i skyen.

- API & integration: Få resultater direkte ind i dine apps, workflows eller datarør.

Apify har en fleksibel , og betalte planer starter ved 29 USD/måned (pay-as-you-go for forbrug). Der er lidt læringskurve, men ønsker du både plug-and-play og fuld tilpasning, er Apify et stærkt valg.

6. Data Miner

er en Chrome-udvidelse til hurtig, skabelonbaseret data crawling. Perfekt til forretningsbrugere, der vil hente data fra tabeller eller lister uden opsætning.

er en Chrome-udvidelse til hurtig, skabelonbaseret data crawling. Perfekt til forretningsbrugere, der vil hente data fra tabeller eller lister uden opsætning.

- Stort skabelonbibliotek: Over tusind opskrifter til kendte sider (LinkedIn, Yelp osv.).

- Point-and-click udtræk: Vælg en skabelon, forhåndsvis data og eksporter straks.

- Browser-baseret: Fungerer med din nuværende session – også bag logins.

- Eksport til CSV eller Excel: Få data i regneark på få sekunder.

dækker 500 sider/måned, og betalte planer starter ved 20 USD/måned. Bedst til små, hurtige opgaver – forvent ikke at håndtere store jobs eller avanceret automatisering.

7. Import.io

er en enterprise-platform for organisationer, der har brug for kontinuerlig, pålidelig webdata-integration. Det er mere end en crawler – det er en managed service, der leverer renset, struktureret data direkte til dine forretningssystemer.

er en enterprise-platform for organisationer, der har brug for kontinuerlig, pålidelig webdata-integration. Det er mere end en crawler – det er en managed service, der leverer renset, struktureret data direkte til dine forretningssystemer.

- Kodefri udtræk: Visuel opsætning af, hvilke data der skal hentes.

- Realtime datafeeds: Stream data til dashboards, analyseværktøjer eller databaser.

- Compliance & pålidelighed: Håndterer IP-rotation, anti-bot og lovgivning.

- Managed services: Import.io’s team kan opsætte og vedligeholde dine skrabere.

Prisen er , med 14 dages gratis prøve på SaaS-platformen. Hvis din virksomhed er afhængig af altid opdaterede webdata (fx detail, finans eller markedsanalyse), er Import.io værd at overveje.

8. WebHarvy

er et desktop-værktøj til Windows-brugere, der ønsker en point-and-click-løsning uden abonnement. Særligt populært blandt små virksomheder og enkeltpersoner, der foretrækker et engangskøb.

er et desktop-værktøj til Windows-brugere, der ønsker en point-and-click-løsning uden abonnement. Særligt populært blandt små virksomheder og enkeltpersoner, der foretrækker et engangskøb.

- Visuel mønstergenkendelse: Klik på dataelementer, og WebHarvy finder automatisk gentagende mønstre.

- Håndterer tekst, billeder m.m.: Udtrækker alle gængse datatyper, inkl. e-mails og URL’er.

- Sideskift & planlægning: Naviger på tværs af sider og opsæt planlagte scraping-jobs.

- Eksport til Excel, CSV, XML, JSON eller SQL: Fleksibel output til enhver arbejdsgang.

En enkeltbrugerlicens koster , hvilket gør det til et prisvenligt valg for regelmæssig brug – bemærk dog, at det kun er til Windows.

9. Mozenda

er en cloud-baseret data crawling-platform til virksomheder med løbende data-behov. Den kombinerer en desktop-designer (Windows) med kraftfuld cloud-udførelse og automatisering.

er en cloud-baseret data crawling-platform til virksomheder med løbende data-behov. Den kombinerer en desktop-designer (Windows) med kraftfuld cloud-udførelse og automatisering.

- Visuel agent-builder: Design udtræksrutiner med point-and-click.

- Cloud-skalerbarhed: Kør flere agenter parallelt, planlæg jobs og håndter data centralt.

- Data management-konsol: Kombinér, filtrér og rens datasæt efter udtræk.

- Enterprise-support: Dedikerede account managers og managed services til store teams.

Planer starter ved , med højere niveauer for flere brugere og mere kapacitet. Mozenda er ideel for virksomheder, der har brug for pålidelig, gentagen webdata som en del af den daglige drift.

10. BeautifulSoup

er det klassiske Python-bibliotek til at parse HTML og XML. Det er ikke en fuld crawler, men elsket af udviklere til mindre, skræddersyede scraping-projekter.

er det klassiske Python-bibliotek til at parse HTML og XML. Det er ikke en fuld crawler, men elsket af udviklere til mindre, skræddersyede scraping-projekter.

- Simpel HTML-parsing: Udtræk nemt data fra statiske websider.

- Fungerer med Python Requests: Kombinér med andre biblioteker til crawling og datahentning.

- Fleksibelt og letvægts: Perfekt til hurtige scripts eller læringsprojekter.

- Stort community: Masser af guides og svar på Stack Overflow.

BeautifulSoup er , men du skal selv kode og styre crawling-logikken. Bedst til udviklere eller dem, der vil lære grundprincipperne i web scraping.

Sammenligningstabel: Data crawling-værktøjer i overblik

| Værktøj | Brugervenlighed | Automatiseringsniveau | Pris | Eksportmuligheder | Bedst til |

|---|---|---|---|---|---|

| Thunderbit | Meget nem, kodefri | Høj (AI, undersider) | Gratis prøve, fra $15/md | Excel, Sheets, Airtable, Notion, CSV | Salg, marketing, e-handel, ikke-kodere |

| Octoparse | Middel, visuel UI | Meget høj, cloud | Gratis, $83–$299/md | CSV, Excel, JSON, API | Virksomheder, datateams, dynamiske sider |

| Scrapy | Lav (kræver Python) | Høj (tilpasningsbar) | Gratis, open source | Alle (via kode) | Udviklere, store skræddersyede projekter |

| ParseHub | Høj, visuel | Høj (dynamiske sider) | Gratis, fra $189/md | CSV, Excel, JSON, API | Ikke-kodere, komplekse webstrukturer |

| Apify | Middel, fleksibel | Meget høj, cloud | Gratis, $29–$999/md | CSV, JSON, API, cloud storage | Udviklere, virksomheder, færdige/tilpassede aktører |

| Data Miner | Meget nem, browser | Lav (manuel) | Gratis, $20–$99/md | CSV, Excel | Hurtige, enkeltstående udtræk, små datasæt |

| Import.io | Middel, managed | Meget høj, enterprise | Tilpasset, volumenbaseret | CSV, JSON, API, direkte integration | Virksomheder, kontinuerlig dataintegration |

| WebHarvy | Høj, desktop | Middel (planlægning) | $129 engangsbeløb | Excel, CSV, XML, JSON, SQL | SMV’er, Windows-brugere, regelmæssig scraping |

| Mozenda | Middel, visuel | Meget høj, cloud | $250–$450+/md | CSV, Excel, JSON, cloud, DB | Løbende, store forretningsoperationer |

| BeautifulSoup | Lav (kræver Python) | Lav (manuel kode) | Gratis, open source | Alle (via kode) | Udviklere, læring, små skræddersyede scripts |

Sådan vælger du det rette data crawling-værktøj til dit team

Det handler ikke om at finde det “vildeste” værktøj, men om at vælge det, der passer til dit teams kompetencer, behov og budget. Her er mine hurtige anbefalinger:

- Ikke-kodere eller forretningsbrugere: Start med Thunderbit, ParseHub eller Data Miner for hurtige resultater og nem opsætning.

- Enterprise eller store behov: Kig på Octoparse, Mozenda eller Import.io for automatisering, planlægning og support.

- Udviklere eller skræddersyede projekter: Scrapy, Apify eller BeautifulSoup giver fuld kontrol og fleksibilitet.

- Prisbevidste eller enkeltstående opgaver: WebHarvy (Windows) eller Data Miner (browser) er billige og nemme.

Test altid dine favoritter med en gratis prøve på de sider, du faktisk skal bruge – det, der virker ét sted, virker ikke nødvendigvis et andet. Og husk integration: Hvis du skal bruge data i Sheets, Notion eller en database, så tjek at værktøjet understøtter det.

Konklusion: Få forretningsværdi med de bedste data crawling-værktøjer

Webdata er den nye olie – men kun hvis du har det rigtige udstyr til at hente og forædle det. Med moderne data crawling-værktøjer kan du forvandle timevis af manuelt research til få minutters automatiseret indsigt – og styrke både salg, marketing og drift. Uanset om du bygger leadlister, overvåger konkurrenter eller bare er træt af at kopiere og indsætte, er der et værktøj på denne liste, der kan gøre din hverdag meget lettere.

Så kig på dit teams behov, prøv et par af værktøjerne, og oplev, hvor meget mere du kan nå, når automatisering tager slæbet. Og vil du se, hvor nemt AI-drevet, 2-klik scraping kan være, så . God fornøjelse med scraping – og må dine data altid være friske, strukturerede og klar til brug.

Ofte stillede spørgsmål

1. Hvad er et data crawling-værktøj, og hvorfor har jeg brug for det?

Et data crawling-værktøj automatiserer indsamlingen af information fra hjemmesider. Det sparer tid, minimerer fejl og hjælper teams med at få opdaterede data til salg, marketing, research og drift – langt mere effektivt end manuel kopi/indsæt.

2. Hvilket data crawling-værktøj er bedst for ikke-tekniske brugere?

Thunderbit, ParseHub og Data Miner er blandt de bedste valg for ikke-kodere. Thunderbit skiller sig ud med sin AI-drevne 2-klik-arbejdsgang, mens ParseHub tilbyder en visuel tilgang til mere komplekse sider.

3. Hvordan varierer prisstrukturen mellem data crawling-værktøjer?

Priserne varierer meget: Nogle værktøjer (som Thunderbit og Data Miner) har gratis versioner og billige månedspakker, mens enterprise-platforme (som Import.io og Mozenda) bruger tilpassede eller volumenbaserede priser. Tjek altid, om prisen matcher dine databehov.

4. Kan jeg bruge disse værktøjer til løbende, planlagt dataudtræk?

Ja – værktøjer som Thunderbit, Octoparse, Apify, Mozenda og Import.io understøtter planlagte eller gentagne scraping-jobs, hvilket gør dem ideelle til løbende prisovervågning, leadgenerering eller markedsanalyse.

5. Hvad skal jeg overveje, før jeg vælger et data crawling-værktøj?

Tænk over dit teams tekniske niveau, hvor komplekse de sider er, du skal scrape, datamængde, integrationsbehov og budget. Prøv gerne flere værktøjer på dine reelle opgaver, før du vælger en betalt løsning.

Vil du have flere guides og praktiske tips? Besøg .

Læs mere