سأكون واضحًا: ما كنت أتوقع يومًا إن “كشط الويب” يصير موضوع يتكرر في سوالف الاستراحة داخل فرق المبيعات والعمليات. بس هذا اللي صار فعلًا في 2025؛ فجأة الكل—من وكلاء العقار إلى مديري المتاجر الإلكترونية—صاروا يحكون عن استراتيجيات استخراج البيانات كأنهم يتبادلون وصفات الشواء. قضّيت سنوات أبني وأستخدم أدوات أتمتة SaaS، والفرق صار واضح: بيانات الويب ما عادت حكرًا على فريق الـ IT. اليوم هي شريان البزنس الحديث، تشغّل كل شيء من توليد العملاء المحتملين إلى مراقبة الأسعار. وإذا ما كنت تستخدم أداة كشط الويب أو الأفضل منها AI Web Scraper، فغالبًا أنت لسه عايش في زمن النسخ واللصق الحجري.

لكن مع الانفجار الكبير في عدد أدوات كشط الويب، اختيار Web Scraper مناسب ممكن يحسّسك كأنك واقف قدّام رف حبوب إفطار مزدحم—مربك، وإذا اخترت غلط ممكن تندم شهور. عشان كذا خلّنا نفصّل أفضل برامج كشط الويب لعام 2025، من حلول AI بدون كود إلى أطر قوية للمطورين. سواء كنت مندوب مبيعات، أو تدير متجر إلكتروني، أو تبغى بس تخلّص من الشغل الممل بالأتمتة—بتلقى هنا اللي يناسبك.

لماذا تحتاج الشركات إلى Web Scraper في 2025

خلّنا نبدأ بـ “ليش”. ليش الناس فجأة صاروا مهووسين بكشط الويب واستخراج البيانات؟ الأرقام تتكلم: . هذا مو ارتفاع مؤقت—هذه موجة كبيرة. واللي يدفعها مو قطاع التقنية لحاله. فرق المبيعات والتسويق والعمليات دخلت بقوة، بفضل جيل جديد من أدوات الكشط منخفضة الكود وبدون كود اللي خلّت استخراج البيانات في متناول غير التقنيين ().

حالات الاستخدام في الأعمال

- توليد العملاء المحتملين: فرق المبيعات تقدر اليوم تكشط الأدلة العامة ووسائل التواصل ومواقع الشركات عشان تبني قوائم فرص “مفصّلة” بدقة—بدل ما تشتري قوائم قديمة أو تتصل عشوائيًا بدون بيانات.

- أبحاث السوق ومراقبة الأسعار: فرق التجارة الإلكترونية والريتيل تستخدم أدوات كشط الويب لتتبع أسعار المنافسين، ومراقبة المخزون، ومقارنة تشكيلة المنتجات. مثال واضح: John Lewis تنسب لكشط الويب فضل بسبب تسعير أذكى.

- أتمتة سير العمل: فرق العمليات تؤتمت جمع البيانات المتكرر، وتوفّر ساعات كانت تضيع في سباق النسخ واللصق اليدوي.

- ذكاء العقارات: الوكلاء والمستثمرون يجمعون إعلانات العقار، ويستخرجون بيانات تواصل المالكين، ويتابعون اتجاهات السوق—كلها دفعة وحدة.

والأهم: ، وكمان بيانات إعلانات الوظائف المستخدمة في ذكاء السوق نمت بنسبة 50%. في عالم السرعة والدقة فيه كل شيء، صارت أدوات كشط الويب سلاح سري للفرق اللي تبغى تسبق المنافسين.

التحول نحو AI Web Scrapers

أدوات الكشط التقليدية كانت قوية، بس كانت تحتاج “دكتوراه” في إعداد المحددات (selector configuration) وكمية صبر مو طبيعية. اليوم، AI Web Scrapers مثل قلبت الطاولة—وصارت تخلي استخراج البيانات المنظمة ممكن لأي شخص خلال كم نقرة. النتيجة؟ تمكين فرق أكثر، اختفاء الاختناقات، وتحول البيانات لميزة تنافسية فعلية.

كيف تختار Web Scraper أو AI Web Scraper المناسب

طيب كيف تختار الأداة الأنسب لفريقك؟ هذه قائمة التحقق اللي أعتمد عليها لما أقيم أدوات كشط الويب (وصدقني شفت كل شيء—من “سهل لدرجة جدتي تستخدمه” إلى “معقد لدرجة أحتاج شاشة ثانية بس عشان أقرأ التوثيق”).

معايير أساسية

- سهولة الاستخدام: هل غير التقني يقدر يبدأ بدون أسبوع تدريب؟

- دقة استخراج البيانات: هل يطلع اللي تحتاجه بشكل ثابت حتى لو تغيّر الموقع؟

- المنصات المدعومة: إضافة متصفح؟ خدمة سحابية؟ ولا مكتبة برمجية؟

- خيارات التكامل: تقدر تصدّر مباشرة إلى Google Sheets أو Excel أو Airtable أو Notion أو CRM؟

- التسعير: فيه خطة مجانية؟ وهل التسعير حسب الصفوف أو التشغيل أو اشتراك شهري؟

- الأتمتة والجدولة: تقدر “تضبطه وتنساه” ولا لازم تراقب كل عملية كشط؟

- ميزات الذكاء الاصطناعي: هل يستخدم AI لتسهيل الإعداد، واقتراح الحقول، أو التعامل مع المواقع المعقدة؟

وهذا جدول مقارنة سريع كبداية (وبعدين بنفصّل كل أداة لحالها):

| الأداة | يتطلب برمجة | ميزات AI | الجدولة | خيارات التصدير | أبرز نقاط القوة |

|---|---|---|---|---|---|

| Thunderbit | لا | نعم | نعم | Sheets, Excel, Airtable, Notion | أسهل إعداد، اكتشاف الحقول بالذكاء الاصطناعي |

| Web Scraper | لا | لا | محدود | CSV, JSON, Sheets (cloud) | إعداد بصري، مرونة عالية |

| BeautifulSoup | نعم | لا | لا | مخصص (CSV, JSON, DB) | بسيط، ممتاز لتحليل الصفحات |

| Scrapy | نعم | لا | نعم | CSV, JSON, XML, API | قابل للتوسع، زحف قوي |

| Playwright | نعم | لا | لا | مخصص | يتعامل مع مواقع تعتمد على JavaScript |

| Apify | لا/نعم | بعض | نعم | CSV, JSON, Sheets, API | توسع سحابي، Actors جاهزة |

Thunderbit: أسهل AI Web Scraper لمستخدمي الأعمال

إضافة Chrome تقدّم كشط ويب مدعوم بالذكاء الاصطناعي للجميع—خصوصًا فرق المبيعات والتجارة الإلكترونية والعقارات اللي تحتاج بيانات بسرعة وما تبغى تنتظر فريق الـ IT.

ميزات بارزة

![]()

- AI Suggest Fields: اضغط “AI Suggest Fields” وThunderbit بيقرأ الصفحة ويقترح الأعمدة المناسبة للاستخراج، وحتى يكتب Prompts مخصصة لكل حقل. خلاص ودّع التخمين.

- كشط الصفحات الفرعية: تحتاج أكثر من صفحة القائمة؟ Thunderbit يقدر يزور كل صفحة فرعية ويغني جدولك تلقائيًا.

- قوالب Instant Data Scraper: للمواقع الشائعة (Amazon وZillow وInstagram وShopify وغيرها)، تختار قالب وتبدأ فورًا. بدون ما تستهلك رصيد AI.

- Scheduled Scraper: اكتب جدولك بلغة بسيطة (“كل يوم اثنين الساعة 9 صباحًا”) وThunderbit يشغّل عمليات الكشط تلقائيًا.

- مستخرجات البريد والهاتف والصور وAI Autofill: أدوات بنقرة واحدة لاستخراج بيانات التواصل أو الصور من أي صفحة، وAI يعبّي النماذج أو يؤتمت سير العمل على الويب.

- الكشط عبر السحابة أو المتصفح: اختر السحابة (أسرع، حتى 50 صفحة دفعة واحدة) أو المتصفح (للمواقع اللي تحتاج تسجيل دخولك).

وإيه، فيه تخلّيك تكشط حتى 6 صفحات، أو 10 مع التجربة. لمعظم مستخدمي الأعمال هذا يكفي عشان تشوف الفكرة (مو سحر… بس قريب).

إذا تبغى تشوف Thunderbit وهو يشتغل، مرّ على أو اقرأ مقالاتنا المتعمقة عن ، و، أو .

Web Scraper: استخراج بيانات مرن عبر المتصفح

Web Scraper (من ) إضافة Chrome كلاسيكية لها سنين. كثير يحبونها “محللي البيانات المواطنين” اللي ما يبغون برمجة، بس ما عندهم مشكلة مع شوية تجارب وضبط. الأداة تشتغل عبر بناء “خرائط مواقع” (sitemaps)—مخططات بصرية تقول للأداة كيف تتنقل وإيش تستخرج.

- واجهة نقر وتحديد: بدون كود، لكن لازم تتعلم كيف تختار العناصر وتبني مسارات التنقل.

- يدعم الصفحات الفرعية والترقيم: ممتاز للمواقع متعددة المستويات، بس أنت اللي تضبط كل خطوة يدويًا.

- خيارات التصدير: CSV وJSON بشكل افتراضي؛ ومع الخطة السحابية تقدر ترسل البيانات إلى Google Sheets أو Dropbox.

- الجدولة: موجودة فقط في الخطة السحابية المدفوعة.

- دعم المجتمع: توثيق ومنتديات كثيرة، لكن الدعم الفوري محدود.

أكبر ميزة؟ المرونة. أكبر عيب؟ منحنى التعلم. مثل ما قال أحد المراجعين: “فقط الفئة المتمرسة تقنيًا ستتمكن من إيجاد طريقها داخل هذه الأداة” (). إذا عندك نفس طويل وتحب التجربة، تقدر تكشط تقريبًا أي موقع. أما إذا ما تحب أسلوب المحاولة والخطأ، غالبًا بتفضّل خيار أبسط.

لمقارنة مفصلة، شوف .

BeautifulSoup: مكتبة Python لاستخراج بيانات مخصص

الحين ندخل منطقة المطورين. مكتبة Python محبوبة لتحليل HTML وXML. إذا أنت مرتاح مع Python، تقدر تكتب سكربتات تطلع اللي تحتاجه بالضبط وبالطريقة اللي تناسبك.

- لا توجد واجهة: كل شيء بالكود.

- مرنة وخفيفة: ممتازة لمشاريع صغيرة إلى متوسطة أو للدمج داخل تدفقات عمل Python أكبر.

- دعم جزئي للترقيم: أنت تكتب الحلقات والمنطق لتتبع الروابط أو التعامل مع الصفحات.

- لا توجد جدولة مدمجة: استخدم cron أو أي مجدول مهام للأتمتة.

- مخرجات مخصصة: أنت تقرر هل تحفظ البيانات في CSV أو JSON أو قاعدة بيانات أو غيره.

BeautifulSoup ممتازة لكشط سريع ومحدد، أو كجزء من خط بيانات أكبر. مو مصممة لزحف ضخم متعدد الصفحات (هذا ملعب Scrapy)، لكنها بداية قوية لأي شخص يحب Python.

Scrapy: إطار قوي لاستخراج البيانات على نطاق واسع

إذا كانت BeautifulSoup مثل سكين جيب متعددة الاستخدامات، فإن مثل عدة كهربائية كاملة. Scrapy إطار Python مصمم للزحف واستخراج البيانات على نطاق كبير.

- موجه للمطورين: إعداد عبر سطر الأوامر، وفئات Python، وبنية مشروع مرتبة.

- زحف عميق: يتتبع الروابط تلقائيًا، ويتعامل مع الترقيم، ويحترم robots.txt.

- أداء عالٍ: طلبات غير متزامنة، ضبط تلقائي للسرعة، تخزين مؤقت، وإعادة محاولات.

- مسارات معالجة قابلة للتخصيص: إخراج إلى CSV أو JSON أو XML أو دفع البيانات إلى APIs وقواعد البيانات.

- الجدولة: استخدم Scrapy Cloud أو ادمجه مع cron للتشغيل التلقائي.

- قابل للتوسعة: Middleware لتدوير البروكسي، وتغيير user-agent، وحتى دمج متصفح بدون واجهة للمواقع الثقيلة بـ JavaScript.

المقابل؟ التعقيد. منحنى تعلم Scrapy حاد، لكن إذا تحتاج تكشط آلاف (أو ملايين) الصفحات بشكل موثوق، صعب تلاقي منافس بنفس القوة.

Playwright: أتمتة حديثة لكشط الويب

بعض المواقع ما تبغى تنكشط. تخبّي البيانات وراء JavaScript، أو تطلب تسجيل دخول، أو تجبرك تنقر داخل متاهة أزرار. هنا يجي دور (شوف )، وهي مكتبة أتمتة متصفح حديثة (متاحة لـ Python وJavaScript وغيرها) تخليك تتحكم بمتصفح حقيقي—بالضبط مثل الإنسان.

- يتعامل مع المحتوى الديناميكي: مثالي لمواقع React وAngular وغيرها من المواقع الثقيلة بـ JS.

- يحاكي أفعال المستخدم: نقر، تعبئة نماذج، تمرير، وانتظار تحميل العناصر.

- لا توجد جدولة مدمجة: تشغّل السكربتات يدويًا أو عبر مجدولات خارجية.

- مخرجات مخصصة: أنت تحدد وين تروح البيانات.

- يستهلك موارد: كل نسخة متصفح تستهلك ذاكرة كبيرة—أفضل للمهام متوسطة الحجم.

Playwright هو “صانع مفاتيح” كشط الويب. إذا المواقع قفلت الأبواب بحركات معقدة، غالبًا يقدر يفتحها. لكنه مو مناسب لغير التقنيين، وهو أبطأ من أدوات تعتمد على الشبكة مثل Scrapy.

Apify: Web Scraper سحابي لاستخراج بيانات قابل للتوسع

منصة متكاملة لكشط الويب. تعطيك خيارات بدون كود وخيارات بالكود، وهذا يخليها مناسبة للفرق اللي تبغى تتوسع بدون ما تدير البنية التحتية بنفسها.

- Actors جاهزة: آلاف أدوات كشط جاهزة لمواقع مثل Google Maps وLinkedIn وZillow وغيرها. تحط المعايير وتبدأ.

- كواشط مخصصة: المطورون يقدرون يبنون وينشرون Actors مخصصة باستخدام JavaScript أو Python.

- جدولة وتوسع سحابي: تشغيل عدة عمليات بالتوازي، جدولة المهام، وترك Apify يشيل الشغل الثقيل.

- تكاملات: تصدير إلى CSV وJSON وExcel وGoogle Sheets أو الوصول عبر API. ويدعم Webhooks وأدوات أتمتة مثل n8n أو Make.

- تكاملات AI: بعض الـ Actors تستخدم AI لاستخراج أذكى وتصنيف البيانات.

- منحنى تعلم: الواجهة والمفاهيم (Actors وdatasets وproxies) ممكن تخوّف المبتدئين، لكن التوثيق قوي.

Apify ممتازة للمؤسسات اللي فيها مستويات تقنية مختلفة، أو للي يبغى يشغّل كشط واسع بدون وجع رأس الخوادم أو البروكسيات. بس تذكّر: القوة الكبيرة معها شوية تعقيد (وتسعير حسب الاستخدام).

مقارنة جنبًا إلى جنب: أي Web Scraper أو AI Web Scraper يناسب احتياجك؟

هذه مقارنة أوسع تساعدك تختار الأنسب:

| الأداة | مناسبة لبدون كود | الصفحات الفرعية/الترقيم | الجدولة | قابلية التوسع | الأفضل لـ |

|---|---|---|---|---|---|

| Thunderbit | ⭐⭐⭐⭐⭐ | تلقائي (AI) | مدمجة | متوسطة | المبيعات، العمليات، العقارات |

| Web Scraper | ⭐⭐ | إعداد يدوي | سحابي فقط | متوسطة | محللو البيانات، المستخدمون الصبورون |

| BeautifulSoup | ⭐ | يدوي (كود) | لا | منخفضة | مطورو Python، مشاريع صغيرة |

| Scrapy | ⭐ | تلقائي (كود) | نعم | عالية | مطورون، زحف واسع النطاق |

| Playwright | ⭐ | يدوي (كود) | لا | متوسطة | مطورون، مواقع JS ديناميكية |

| Apify | ⭐⭐⭐ | حسب الـ Actor | مدمجة | عالية | فرق، مشاريع قابلة للتوسع |

- Thunderbit: الأفضل لغير التقنيين اللي يبغون بيانات بسرعة، بإعداد بسيط وأتمتة مدعومة بالذكاء الاصطناعي.

- Web Scraper: مناسب للي ما عنده مشكلة يتعلم تفاصيله؛ مرن لكنه مو “شغّل وانطلق” بالكامل.

- BeautifulSoup/Scrapy/Playwright: للمطورين اللي يبغون تحكم كامل ومرتاحين مع الكود.

- Apify: ممتاز للفرق اللي تبغى توسع سحابي وحلول جاهزة وتقبل شوية تعقيد.

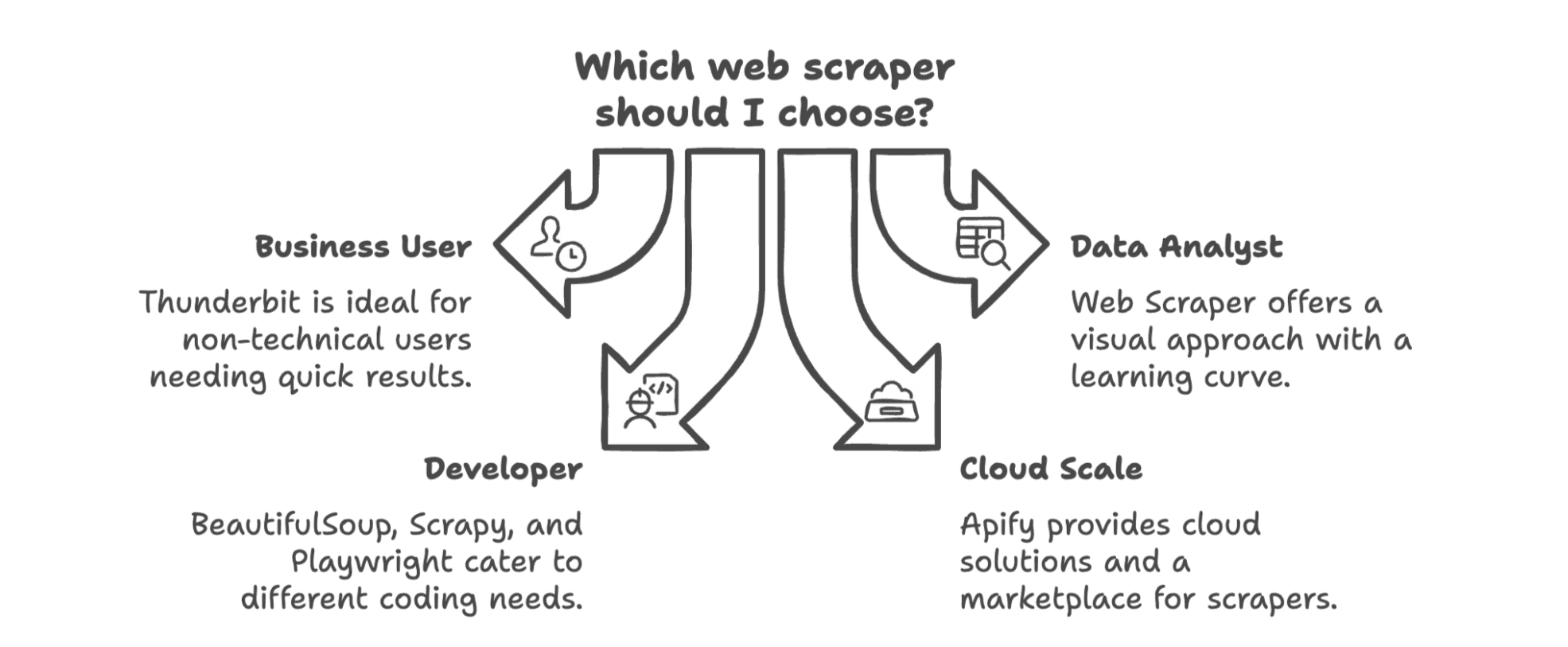

اختيار أفضل Web Scraper لعملك في 2025

وش الزبدة؟ أفضل Web Scraper لك يعتمد على فريقك، ومستواك التقني، واحتياجات بياناتك.

- إذا كنت مستخدم أعمال (مبيعات/تسويق/عمليات) وتبغى تبعد عن الكود، فـ غالبًا هو خيارك الأفضل. معمول لك أنت، مو للمهندسين، وبيخليك تبدأ الكشط خلال دقائق بدل ساعات.

- إذا كنت محلل بيانات أو ما تمانع منحنى تعلم، نهج Web Scraper البصري قوي، بس جهّز نفسك لشوية تجربة وخطأ.

- إذا كنت مطورًا، BeautifulSoup وScrapy من الكلاسيكيات—اختر BS4 للسكربتات السريعة، وScrapy للزحف الكبير، وPlaywright للمواقع الديناميكية.

- إذا كنت تحتاج توسعًا سحابيًا أو تبغى سوق كواشط جاهزة، Apify خيار قوي، خصوصًا للفرق ذات المهارات المختلطة.

ولا تنسى: الاتجاه العام رايح لحلول بدون كود مدعومة بالذكاء الاصطناعي تتكامل مباشرة مع سير عملك. أيام “اكشط، نزّل، استورد، نظّف، كرر” قاعدة تختفي بسرعة. اليوم تقدر تنتقل من الويب إلى جدول بيانات (أو CRM أو Notion) خلال كم نقرة.

إذا تبغى تشوف قد إيش كشط الويب ممكن يكون سهل، جرّب . أو إذا تبغى تغوص أكثر في نصائح كشط الويب، زر لمقالات عميقة ودروس عملية—ومزحة سيئة بين فترة وفترة.

إلى أن نخلي 2025 السنة اللي توقف فيها أخيرًا عن النسخ واللصق—وتخلي الذكاء الاصطناعي يشيل الشغل الثقيل.

الأسئلة الشائعة

س1: هل أحتاج مهارات برمجة لاستخدام Web Scraper في 2025؟ ج: ما عاد ضروري. أدوات مدعومة بالذكاء الاصطناعي مثل Thunderbit تخلّي غير التقنيين يستخرجون البيانات خلال كم نقرة—بدون برمجة أو إعداد. أما المطورون فعادة يفضّلون أدوات مثل Scrapy أو Playwright لما يحتاجون منطق مخصص.

س2: ما أنواع البيانات التي يمكن لـ AI Web Scrapers استخراجها؟ ج: نصوص، أرقام، روابط، بريد إلكتروني، أرقام هواتف، صور—وحتى بيانات منظمة من ملفات PDF أو مواقع ديناميكية. وبعض الأدوات تتيح كمان جدولة البيانات أو ترجمتها أو تصنيفها أثناء الاستخراج.

س3: هل كشط الويب قانوني للاستخدام التجاري؟ ج: نعم—إذا كنت تكشط بيانات متاحة للعامة لاستخدام تجاري مشروع (مثل البحث أو توليد العملاء المحتملين) فعادة يكون مسموح. بس تجنب كشط المحتوى المحمي أو المقيد بدون إذن.

س4: ما أكبر فائدة من استخدام الذكاء الاصطناعي في كشط الويب؟ ج: السرعة وسهولة الوصول. AI يتولى اكتشاف الحقول، والتعامل مع الترقيم، وحتى أتمتة سير العمل—عشان تقضي وقت أقل في الإعداد ووقت أكثر في الاستفادة من البيانات.

اقرأ المزيد