Internet už dávno není jen digitální hřiště – dnes je to největší sklad dat na světě, kam se snaží dostat každý, od obchodních týmů až po tržní analytiky. Ale ruku na srdce: ručně sbírat data z webu je asi tak zábavné, jako skládat nábytek z IKEA bez návodu (a ještě s dvojnásobkem šroubků navíc). Jak firmy čím dál víc spoléhají na aktuální tržní informace, sledování konkurence a generování leadů, roste i poptávka po efektivních a spolehlivých nástrojích na získávání dat. Není divu, že při rozhodování a globální trh s web scrapingem má .

Pokud už tě nebaví nekonečné kopírování a vkládání, máš pocit, že ti utíkají nové příležitosti, nebo chceš zjistit, co všechno zvládne automatizace, jsi tady správně. Strávil jsem roky vývojem a testováním nástrojů na extrakci dat (a vedl tým v ), takže vím, jak správný nástroj dokáže proměnit hodiny rutinní práce v záležitost na dvě kliknutí. Ať už jsi laik, co chce rychlé výsledky, nebo vývojář, který chce mít vše pod kontrolou, tenhle žebříček 10 nejlepších nástrojů na získávání dat ti pomůže najít ten pravý.

Proč je výběr správného nástroje na získávání dat klíčový

Upřímně: rozdíl mezi dobrým a průměrným nástrojem na získávání dat není jen o pohodlí – může přímo ovlivnit růst tvého byznysu. Automatizací webové extrakce nejen šetříš čas (jeden uživatel G2 uvádí, že ), ale taky snižuješ chybovost, objevuješ nové příležitosti a zajišťuješ, že tvůj tým pracuje s nejčerstvějšími a nejpřesnějšími daty. Ruční rešerše jsou pomalé, náchylné k chybám a často zastaralé ještě dřív, než je dokončíš. Se správným nástrojem můžeš sledovat konkurenci, monitorovat ceny nebo sestavovat seznamy leadů během pár minut – ne dnů.

Příklad z praxe: prodejce kosmetiky využil web scraping ke sledování skladových zásob a cen konkurence, . Takový výsledek s tabulkami a ruční prací prostě nedosáhneš.

Jak jsme vybírali nejlepší nástroje na získávání dat

Vybrat správný nástroj je jako rychlorande na technologické konferenci. Tady jsou kritéria, podle kterých jsem oddělil špičku od zbytku:

- Jednoduchost použití: Zvládneš začít bez znalosti Pythonu? Je k dispozici vizuální rozhraní nebo AI asistence pro laiky?

- Možnosti automatizace: Umí nástroj stránkování, podstránky, dynamický obsah a plánování? Lze spouštět ve cloudu pro velké úlohy?

- Cena a škálovatelnost: Existuje bezplatná verze nebo dostupný základní tarif? Jak roste cena s objemem dat?

- Funkce a integrace: Lze exportovat do Excelu, Google Sheets nebo přes API? Jsou k dispozici šablony, plánování nebo čištění dat?

- Pro koho je určen: Je nástroj vhodný spíš pro firmy, vývojáře nebo velké týmy?

Na konci najdeš srovnávací tabulku, kde uvidíš, jak si jednotlivé nástroje vedou.

Pojďme se podívat na 10 nejlepších nástrojů pro efektivní získávání dat z webu v roce 2025.

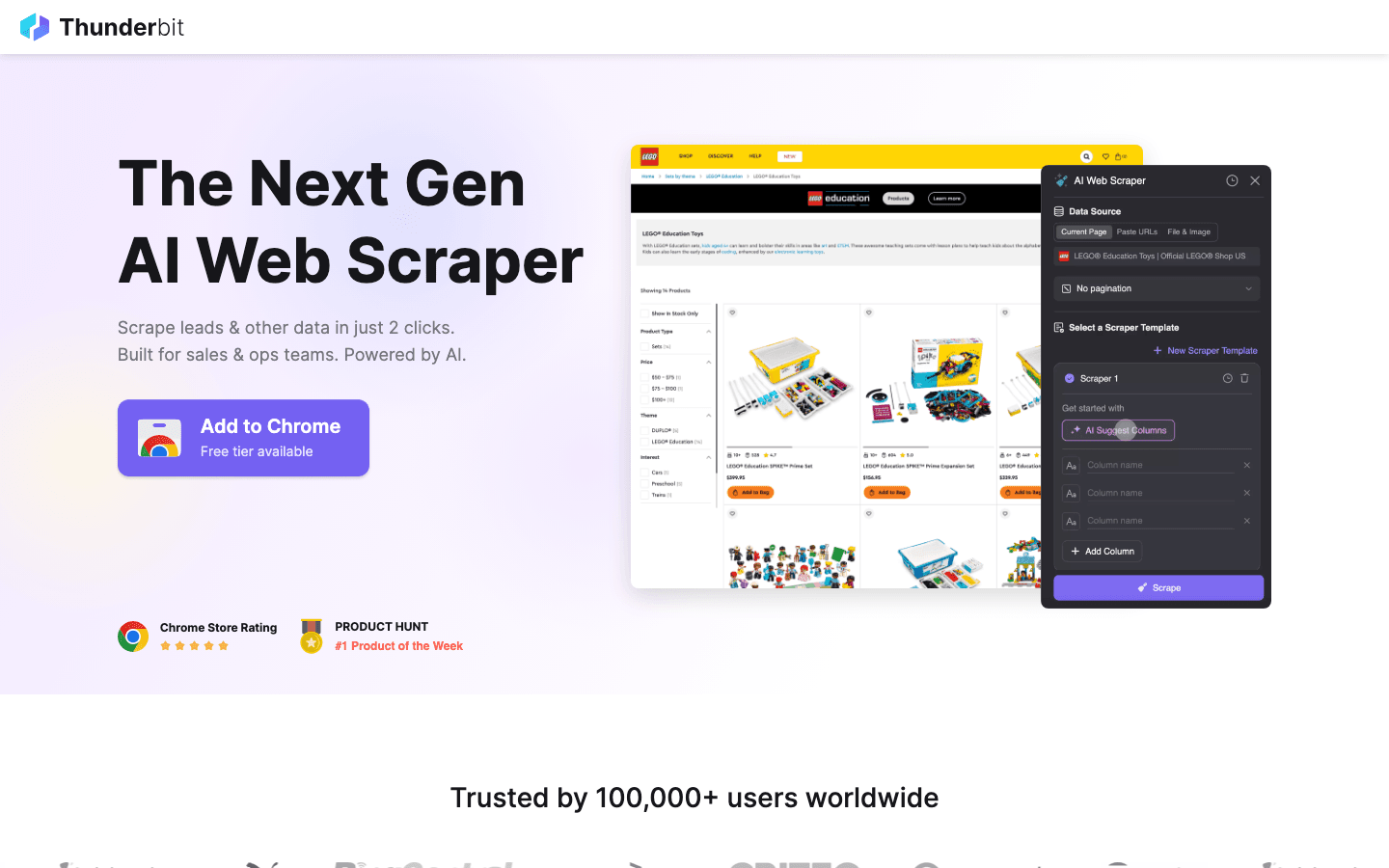

1. Thunderbit

doporučuju každému, kdo chce získávat data z webu stejně snadno, jako si objednat jídlo domů. Jde o AI poháněné rozšíření pro Chrome, které umožňuje získat data na dvě kliknutí: stačí zvolit „AI Navrhnout sloupce“ a AI sama rozpozná, co je na stránce důležité, pak klikneš na „Scrape“ a data jsou tvoje. Žádné programování, žádné nastavování selektorů – jen okamžité výsledky.

doporučuju každému, kdo chce získávat data z webu stejně snadno, jako si objednat jídlo domů. Jde o AI poháněné rozšíření pro Chrome, které umožňuje získat data na dvě kliknutí: stačí zvolit „AI Navrhnout sloupce“ a AI sama rozpozná, co je na stránce důležité, pak klikneš na „Scrape“ a data jsou tvoje. Žádné programování, žádné nastavování selektorů – jen okamžité výsledky.

Proč je Thunderbit oblíbený mezi obchodníky, marketéry a e-shopy? Je navržený pro reálné firemní procesy:

- AI Navrhnout sloupce: Umělá inteligence přečte stránku a doporučí nejlepší sloupce k extrakci – jména, ceny, e-maily a další.

- Scraping podstránek: Potřebuješ detailnější informace? Thunderbit automaticky navštíví každou podstránku (například detail produktu nebo LinkedIn profil) a doplní data do tabulky.

- Okamžitý export: Data můžeš ihned poslat do Excelu, Google Sheets, Airtable nebo Notion. Export je vždy zdarma.

- Šablony na jedno kliknutí: Pro populární weby (Amazon, Zillow, Instagram) jsou připravené šablony pro ještě rychlejší výsledky.

- Bezplatný export dat: Za export dat neplatíš žádné poplatky.

- Plánované získávání dat: Nastav si opakované úlohy v běžné češtině („každé pondělí v 9:00“) – ideální pro sledování cen nebo pravidelnou aktualizaci leadů.

Thunderbit funguje na principu kreditů (1 kredit = 1 řádek), přičemž umožňuje zpracovat až 6 stránek (nebo 10 s trial bonusem). Placené tarify začínají na 15 USD/měsíc za 500 kreditů, což je dostupné i pro menší týmy.

Chceš vidět Thunderbit v akci? Mrkni na náš nebo . Je to nástroj, který bych si přál mít v době, kdy jsem sám zápasil s ručním zadáváním dat.

2. Octoparse

je těžká váha mezi nástroji na získávání dat, hlavně pro firmy, které potřebují opravdu robustní řešení. Nabízí vizuální desktopové rozhraní (Windows i Mac), kde si můžeš workflow naklikat – bez programování. Pod kapotou zvládá přihlašování, nekonečné scrollování, rotaci proxy i řešení CAPTCHA.

je těžká váha mezi nástroji na získávání dat, hlavně pro firmy, které potřebují opravdu robustní řešení. Nabízí vizuální desktopové rozhraní (Windows i Mac), kde si můžeš workflow naklikat – bez programování. Pod kapotou zvládá přihlašování, nekonečné scrollování, rotaci proxy i řešení CAPTCHA.

- 500+ předpřipravených šablon: Rychlý start pro Amazon, Twitter, LinkedIn a další.

- Cloudové získávání dat: Spouštění úloh na serverech Octoparse, plánování a škálování pro velké projekty.

- API přístup: Integrace získaných dat přímo do tvých aplikací nebo databází.

- Pokročilá automatizace: Zvládá dynamický obsah, stránkování i vícekrokové workflow.

K dispozici je pro 10 úloh, většina firem ale sáhne po Standard (~83 USD/měsíc) nebo Professional (~299 USD/měsíc). Učení je trochu náročnější než u Thunderbit, ale pokud potřebuješ spolehlivě zpracovat tisíce stránek, Octoparse je skvělá volba.

3. Scrapy

je zlatý standard pro vývojáře, kteří chtějí mít nad svými projekty plnou kontrolu. Jde o open-source Python framework, kde si můžeš naprogramovat vlastní „pavouky“ (crawlers) pro libovolný web. Co si vymyslíš, to s ním postavíš.

je zlatý standard pro vývojáře, kteří chtějí mít nad svými projekty plnou kontrolu. Jde o open-source Python framework, kde si můžeš naprogramovat vlastní „pavouky“ (crawlers) pro libovolný web. Co si vymyslíš, to s ním postavíš.

- Plná programovatelnost: V Pythonu si přesně určíš, jak a co se má z webu získat.

- Asynchronní a rychlý: Zvládá paralelně tisíce stránek pro velké projekty.

- Rozšiřitelnost: Možnost přidat proxy, headless browsery nebo vlastní logiku.

- Silná komunita: Spousta návodů, pluginů a podpory pro složité scénáře.

Scrapy je zcela zdarma a open-source, ale vyžaduje programátorské dovednosti. Pokud máš technický tým nebo chceš vlastní pipeline, těžko najdeš lepší řešení. Pro laiky je to ale poměrně náročné.

4. ParseHub

je vizuální, bezkódový nástroj na získávání dat, ideální pro laiky, kteří potřebují zvládnout i složitější weby. Pomocí klikání vybíráš prvky, nastavuješ akce a sestavuješ workflow – i pro stránky s dynamickým obsahem nebo složitou navigací.

je vizuální, bezkódový nástroj na získávání dat, ideální pro laiky, kteří potřebují zvládnout i složitější weby. Pomocí klikání vybíráš prvky, nastavuješ akce a sestavuješ workflow – i pro stránky s dynamickým obsahem nebo složitou navigací.

- Vizuální builder workflow: Kliknutím vybíráš data, nastavuješ stránkování, zvládneš pop-upy i rozbalovací menu.

- Zvládá dynamický obsah: Funguje i na stránkách s JavaScriptem a interaktivními prvky.

- Cloudové spouštění a plánování: Úlohy běží ve cloudu a lze je plánovat.

- Export do CSV, Excelu nebo přes API: Snadná integrace s tvými nástroji.

ParseHub nabízí bezplatný tarif (5 projektů), placené tarify začínají na . Je dražší než někteří konkurenti, ale vizuální přístup je skvělý pro analytiky, marketéry a výzkumníky, kteří potřebují víc než jen základní rozšíření do prohlížeče.

5. Apify

je platforma i tržiště pro web scraping. Nabízí obrovskou knihovnu předpřipravených „herců“ (scraperů) pro populární weby a možnost vytvářet a spouštět vlastní crawly v cloudu.

je platforma i tržiště pro web scraping. Nabízí obrovskou knihovnu předpřipravených „herců“ (scraperů) pro populární weby a možnost vytvářet a spouštět vlastní crawly v cloudu.

- 5 000+ hotových herců: Okamžitě získáš data z Google Maps, Amazonu, Twitteru a dalších.

- Vlastní skriptování: Vývojáři mohou použít JavaScript nebo Python pro pokročilé crawly.

- Cloudové škálování: Paralelní spouštění úloh, plánování a správa dat v cloudu.

- API a integrace: Výsledky lze napojit do aplikací, workflow nebo datových pipeline.

Apify má flexibilní , placené tarify začínají na 29 USD/měsíc (platíš za výpočetní čas). Učení je trochu náročnější, ale pokud chceš kombinovat hotová řešení s vlastními úpravami, Apify je velmi silný nástroj.

6. Data Miner

je rozšíření pro Chrome určené pro rychlé získávání dat pomocí šablon. Ideální pro uživatele, kteří chtějí rychle vytáhnout data z tabulek nebo seznamů bez složitého nastavování.

je rozšíření pro Chrome určené pro rychlé získávání dat pomocí šablon. Ideální pro uživatele, kteří chtějí rychle vytáhnout data z tabulek nebo seznamů bez složitého nastavování.

- Obrovská knihovna šablon: Více než tisíc receptů pro běžné weby (LinkedIn, Yelp atd.).

- Bodové a klikací získávání dat: Vybereš šablonu, zkontroluješ data a ihned exportuješ.

- Funguje v prohlížeči: Pracuje s tvojí aktuální relací – vhodné i pro stránky za přihlášením.

- Export do CSV nebo Excelu: Data máš v tabulce během pár vteřin.

pokrývá 500 stránek/měsíc, placené tarify od 20 USD/měsíc. Nejlepší je pro menší, jednorázové úlohy nebo když potřebuješ data hned – na velké projekty nebo složitou automatizaci ale nestačí.

7. Import.io

je platforma pro firmy, které potřebují kontinuální a spolehlivou integraci webových dat. Není to jen crawler – jde o službu, která dodává čistá, strukturovaná data přímo do tvých systémů.

je platforma pro firmy, které potřebují kontinuální a spolehlivou integraci webových dat. Není to jen crawler – jde o službu, která dodává čistá, strukturovaná data přímo do tvých systémů.

- Bez kódování: Vizuální nastavení, co a jak chceš získat.

- Reálné datové toky: Streamování dat do dashboardů, analytických nástrojů nebo databází.

- Soulad a spolehlivost: Řeší rotaci IP, ochranu proti botům i právní otázky.

- Spravované služby: Tým Import.io ti může nastavit a udržovat scrapers.

Ceny jsou , SaaS platforma nabízí 14denní zkušební verzi. Pokud tvoje firma potřebuje neustále čerstvá data (například v retailu, financích nebo výzkumu trhu), Import.io stojí za zvážení.

8. WebHarvy

je desktopový scraper pro Windows, ideální pro uživatele, kteří chtějí klikací řešení bez předplatného. Oblíbený je hlavně u menších firem a jednotlivců, kteří preferují jednorázovou platbu.

je desktopový scraper pro Windows, ideální pro uživatele, kteří chtějí klikací řešení bez předplatného. Oblíbený je hlavně u menších firem a jednotlivců, kteří preferují jednorázovou platbu.

- Vizuální rozpoznávání vzorů: Klikneš na prvek a WebHarvy automaticky najde opakující se data.

- Získává text, obrázky a další: Extrahuje všechny běžné typy dat včetně e-mailů a URL.

- Stránkování a plánování: Prochází vícestránkové weby a umožňuje plánovat úlohy.

- Export do Excelu, CSV, XML, JSON nebo SQL: Flexibilní výstup pro jakýkoli workflow.

Jedna licence stojí , což je výhodné pro pravidelné použití – jen pozor, funguje pouze na Windows.

9. Mozenda

je cloudová platforma na získávání dat, navržená pro firemní provoz a pravidelné potřeby. Kombinuje desktopový návrhář (Windows) s výkonným cloudovým zpracováním a automatizací.

je cloudová platforma na získávání dat, navržená pro firemní provoz a pravidelné potřeby. Kombinuje desktopový návrhář (Windows) s výkonným cloudovým zpracováním a automatizací.

- Vizuální návrhář agentů: Sestavíš extrakční rutiny klikáním.

- Cloudové škálování: Paralelní běh více agentů, plánování úloh a centrální správa dat.

- Konzole pro správu dat: Kombinace, filtrování a čištění dat po extrakci.

- Podpora pro firmy: Dedikovaní account manageři a spravované služby pro velké týmy.

Tarify začínají na , vyšší úrovně pro více uživatelů a výkonu. Mozenda je ideální pro firmy, které potřebují spolehlivá a opakovaná webová data jako součást každodenního provozu.

10. BeautifulSoup

je klasická Python knihovna pro parsování HTML a XML. Není to plnohodnotný crawler, ale vývojáři ji milují pro menší, vlastní projekty.

je klasická Python knihovna pro parsování HTML a XML. Není to plnohodnotný crawler, ale vývojáři ji milují pro menší, vlastní projekty.

- Jednoduché parsování HTML: Snadno vytáhneš data ze statických stránek.

- Spolupráce s Python Requests: Lze kombinovat s dalšími knihovnami pro stahování a crawling.

- Flexibilní a lehká: Ideální pro rychlé skripty nebo výuku.

- Obrovská komunita: Spousta návodů a odpovědí na Stack Overflow.

BeautifulSoup je , ale musíš si vše naprogramovat sám. Nejlepší je pro vývojáře nebo studenty, kteří chtějí pochopit základy web scrapingu.

Srovnávací tabulka: Nástroje na získávání dat v kostce

| Nástroj | Snadnost použití | Úroveň automatizace | Cena | Možnosti exportu | Ideální pro |

|---|---|---|---|---|---|

| Thunderbit | Velmi snadné, bez kódu | Vysoká (AI, podstránky) | Zkušební verze zdarma, od 15 $/měsíc | Excel, Sheets, Airtable, Notion, CSV | Obchod, marketing, e-shopy, laiky |

| Octoparse | Střední, vizuální UI | Velmi vysoká, cloud | Zdarma, 83–299 $/měsíc | CSV, Excel, JSON, API | Firmy, datové týmy, dynamické weby |

| Scrapy | Nízká (vyžaduje Python) | Vysoká (vlastní úpravy) | Zdarma, open-source | Libovolné (přes kód) | Vývojáře, velké vlastní projekty |

| ParseHub | Vysoká, vizuální | Vysoká (dynamické weby) | Zdarma, od 189 $/měsíc | CSV, Excel, JSON, API | Laiky, složité webové struktury |

| Apify | Střední, flexibilní | Velmi vysoká, cloud | Zdarma, 29–999 $/měsíc | CSV, JSON, API, cloudové úložiště | Vývojáře, firmy, hotové i vlastní scrapers |

| Data Miner | Velmi snadné, v prohlížeči | Nízká (ručně) | Zdarma, 20–99 $/měsíc | CSV, Excel | Rychlé, jednorázové extrakce, malé datasety |

| Import.io | Střední, spravované | Velmi vysoká, enterprise | Individuální, podle objemu | CSV, JSON, API, přímá integrace | Firmy, kontinuální integrace dat |

| WebHarvy | Vysoká, desktop | Střední (plánování) | 129 $ jednorázově | Excel, CSV, XML, JSON, SQL | Malé firmy, Windows uživatele, pravidelné scraping |

| Mozenda | Střední, vizuální | Velmi vysoká, cloud | 250–450+ $/měsíc | CSV, Excel, JSON, cloud, DB | Pravidelný, velkoobjemový firemní provoz |

| BeautifulSoup | Nízká (vyžaduje Python) | Nízká (ruční kódování) | Zdarma, open-source | Libovolné (přes kód) | Vývojáře, studenty, malé vlastní skripty |

Jak vybrat správný nástroj na získávání dat pro tvůj tým

Nejde o to najít „nejvýkonnější“ nástroj, ale ten, který nejlépe sedne tvým dovednostem, potřebám a rozpočtu. Moje rychlé tipy:

- Laici a firemní uživatelé: Začni s Thunderbit, ParseHub nebo Data Miner pro rychlé výsledky a snadné nastavení.

- Firmy a velké projekty: Zvaž Octoparse, Mozenda nebo Import.io pro automatizaci, plánování a podporu.

- Vývojáři a vlastní řešení: Scrapy, Apify nebo BeautifulSoup nabízejí plnou kontrolu a flexibilitu.

- Šetříš rozpočet nebo potřebuješ jednorázově: WebHarvy (Windows) nebo Data Miner (prohlížeč) jsou jednoduché a cenově dostupné.

Vždy si vyzkoušej své favority na reálných stránkách v rámci bezplatné zkušební verze – co funguje na jednom webu, nemusí fungovat jinde. A nezapomeň na integraci: pokud potřebuješ data v Sheets, Notion nebo databázi, ověř si, že to tvůj nástroj zvládne.

Závěr: Jak vytěžit z webových dat maximum díky správným nástrojům

Webová data jsou novou ropou – ale jen pokud máš správné nástroje na jejich těžbu a zpracování. Moderní nástroje na získávání dat ti umožní proměnit hodiny ruční práce v minuty automatizovaných poznatků – ať už jde o obchod, marketing nebo agilní provoz. Ať už stavíš seznamy leadů, sleduješ konkurenci, nebo už tě nebaví kopírovat a vkládat, v tomhle seznamu najdeš nástroj, který ti práci výrazně usnadní.

Zamysli se nad potřebami svého týmu, vyzkoušej několik z těchto nástrojů a uvidíš, kolik toho zvládneš, když necháš automatizaci pracovat za sebe. A pokud chceš vidět, jak vypadá AI poháněný scraping na dvě kliknutí, . Přejeme úspěšné získávání dat – ať jsou tvoje data vždy čerstvá, strukturovaná a připravená k použití.

Nejčastější dotazy

1. Co je nástroj na získávání dat a proč ho potřebuji?

Nástroj na získávání dat automatizuje extrakci informací z webových stránek. Šetří čas, snižuje chybovost a pomáhá týmům získávat aktuální data pro obchod, marketing, výzkum i provoz – mnohem efektivněji než ruční kopírování.

2. Který nástroj je nejlepší pro laiky?

Thunderbit, ParseHub a Data Miner patří mezi nejlepší volby pro uživatele bez technických znalostí. Thunderbit vyniká workflow na dvě kliknutí s AI, ParseHub nabízí vizuální přístup pro složitější weby.

3. Jak se liší cenové modely jednotlivých nástrojů?

Ceny se liší: některé nástroje (Thunderbit, Data Miner) mají bezplatné tarify a dostupné měsíční plány, zatímco firemní platformy (Import.io, Mozenda) používají individuální nebo objemové ceny. Vždy si ověř, zda cena odpovídá tvým potřebám.

4. Lze tyto nástroje použít pro pravidelné, plánované získávání dat?

Ano – nástroje jako Thunderbit, Octoparse, Apify, Mozenda a Import.io podporují plánované nebo opakované úlohy, což je ideální pro sledování cen, generování leadů nebo průzkum trhu.

5. Na co myslet před výběrem nástroje na získávání dat?

Zvaž technické dovednosti týmu, složitost cílových webů, objem dat, potřeby integrace a rozpočet. Vyzkoušej několik nástrojů na reálných úlohách před zakoupením placeného tarifu.

Další tipy a návody najdeš na .

Další čtení